基于RGB-D超像素分割的聚焦堆栈数据拼接融合的方法及系统

基于rgb

‑

d超像素分割的聚焦堆栈数据拼接融合的方法及系统

技术领域

1.本发明涉及计算机视觉与数字图像处理技术领域,特别是关于一种基于rgb

‑

d超像素分割的聚焦堆栈数据的拼接融合的方法及系统。

背景技术:

2.单视角成像系统获取的聚焦堆栈数据是窄视角的,大视场成像需要对多视角获取的多组数据进行拼接融合。

3.每一组聚焦堆栈数据是聚焦在不同深度层的2d图像序列,在聚焦堆栈数据拼接时找到多组数据间对应深度层的图像是难点之一;常用的2d图像拼接技术是基于单应性变换矩阵实现图像的坐标变换,单应性变换矩阵能够准确描述平面之间的变换关系,由于真实场景并不是一个平面,无法得到准确统一的单应性变换矩阵,这样拼接会产生较严重的重影和错位;当待拼接数据之间重叠区域较小时,难以获得足够的信息进行数据的拼接;当多组数据需要拼接时,若逐一相继进行拼接,每一次计算误差会累积。

技术实现要素:

4.本发明的目的在于提供一种基于超像素分割的聚焦堆栈rgb

‑

d数据的拼接融合的方法来克服或至少减轻现有技术的上述缺陷中的至少一个。

5.为实现上述目的,本发明提供一种基于rgb

‑

d超像素分割的聚焦堆栈数据的拼接融合的方法,该方法包括:

6.步骤1,由聚焦堆栈数据计算生成全聚焦图与深度图,即准确配准的rgb

‑

d数据;

7.步骤2,将低分辨率的2d大视场图像上采样至与rgb

‑

d数据尺度一致;

8.步骤3,对rgb

‑

d数据进行超像素分割;

9.步骤4,提取并匹配全聚焦图与大视场2d图像之间的特征点,计算同一深度层超像素的准确单应性变换矩阵;

10.步骤5,逐深度层进行超像素变换实现全聚焦图和深度图的拼接融合,得到大视场的rgb

‑

d数据;

11.步骤6,由大视场的rgb

‑

d数据生成大视场的聚焦堆栈数据。

12.进一步地,步骤3包括全聚焦图和深度图的超像素分割,其具体包括:

13.步骤31,将全聚焦图像从rgb颜色空间转换到cie

‑

lab颜色空间,则每一个像素对应三通道颜色信息(l,a,b),2d坐标信息(x,y),并将深度图中对应位置的深度值定义为该像素的深度值d;

14.步骤32,将全聚焦图中两个像素p

i

,p

j

之间的颜色距离dis1定义为式(1),全聚焦图中两个像素p

i

,p

j

之间的平面坐标距离dis2定义为式(2),全聚焦图中两个像素p

i

,p

j

之间的深度距离dis3定义为式(3):

[0015][0016][0017][0018]

步骤33,通过对dis1、dis2和dis3加权求和,如式(4)所示,来定义全聚焦图中两个像素p

i

,p

j

之间的距离dis(p

i

,p

j

):

[0019]

dis(p

i

,p

j

)=dis1(p

i

,p

j

)+αdis2(p

i

,p

j

)+βdis3(p

i

,p

j

)

ꢀꢀꢀꢀꢀꢀꢀ

(4)其中,α、β为权重参数,需要根据不同场景进行调整选择;

[0020]

步骤34,由该距离dis(p

i

,p

j

)对全聚焦图中的像素聚类,每一类形成一个超像素,完成全聚焦图的超像素分割;

[0021]

步骤35,对于全聚焦图的任意一个超像素中的像素,将深度图中与之对应的像素划分为一个超像素,完成对深度图的超像素分割。

[0022]

进一步地,步骤4具体包括:

[0023]

步骤41,对全聚焦图和上采样后与之尺度一致的大视场2d图像提取特征点进行匹配,并剔除离群点后,得到每个超像素中能够与大视场2d图像准确匹配的特征点对;

[0024]

步骤42,将每个超像素近似为一个平面,其内部能够与大视场2d图像中准确匹配的特征点对的齐次坐标[x1,y1,1]

t

、[x2,y2,1]

t

之间的坐标变换由3

×

3的单应性变换矩阵h描述为式(5):

[0025][0026]

步骤43,由每个深度层上超像素内不少于4组特征点对建立线性回归方程组,利用最小二乘法计算求解该深度层上超像素所对应的单应性变换矩阵h。

[0027]

进一步地,步骤5具体包括:

[0028]

步骤51,全聚焦图的拼接与融合;

[0029]

步骤511,利用步骤3中计算的每个深度层的单应性矩阵,将全聚焦图中全部超像素向大视场2d图像进行坐标变换,并保留全聚焦图信息,进行拼接;

[0030]

步骤512,利用多频段方法对拼接的图像进行融合;

[0031]

步骤52,深度图的拼接与融合;

[0032]

步骤521,对深度图的超像素用与全聚焦图相同的单应性变换矩阵进行坐标变换,进行拼接;

[0033]

步骤522,利用加权平均的方式对拼接的深度图进行融合;

[0034]

其中,步骤511具体包括:

[0035]

步骤5111,对全聚焦图直接用单应性矩阵进行坐标变换后,原本每个像素的坐标值由整数变为非整数,在变换后的坐标系中,每个整数坐标的像素值通过其周围非整数坐标处的像素值以距离为权重进行插值计算得到;

[0036]

步骤5112,遍历全部像素,找到像素值为0的位置,以空洞位置为起点,沿上下左右四个方向向外在一定范围内检测,直到检测出四个非空洞的像素,对这四个位置的像素值以距离为权重插值得到空洞位置的像素值,将空洞部分补全。

[0037]

进一步地,步骤6具体包括:

[0038]

步骤61,估计每个深度层在成像系统中不同聚焦面上的点扩散函数;

[0039]

步骤62,根据大视场全聚焦图、深度图和点扩散函数生成聚焦在不同聚焦面上的图像序列,即大视场聚焦堆栈数据,其具体包括:

[0040]

步骤621,将大视场全聚焦图中的像素按照其深度图中的深度值进行分层,形成若干深度层;

[0041]

步骤622,对于每一个聚焦面,逐深度层将全聚焦图与步骤61估计得到的点扩散函数进行卷积;

[0042]

步骤623,对于每一个聚焦面,将卷积后的图像叠加得到场景聚焦在该聚焦面上的图像,形成大视场聚焦堆栈数据。

[0043]

本发明还包括一种基于rgb

‑

d超像素分割的聚焦堆栈数据的拼接融合的系统,该系统包括:

[0044]

数据预处理装置,其用于将聚焦堆栈数据计算生成rgb

‑

d数据,并将低分辨率的2d大视场图像上采样至与rgb

‑

d数据尺度一致;

[0045]

超像素分割装置,其用于对rgb

‑

d数据进行超像素分割;

[0046]

单应性变换矩阵计算装置,其用于提取并匹配全聚焦图与大视场2d图像之间的特征点,计算同一深度层超像素的准确单应性变换矩阵;

[0047]

拼接融合装置,其用于逐深度层进行超像素变换实现全聚焦图和深度图的拼接融合

[0048]

大视场聚焦堆栈数据生成装置,其用于由大视场全聚焦图和深度图计算生成大视场聚焦堆栈数据。

[0049]

进一步地,像素分割装置具体包括:

[0050]

转换单元,其用于将全聚焦图像从rgb颜色空间转换到cie

‑

lab颜色空间,则每一个像素对应三通道颜色信息(l,a,b),2d坐标信息(x,y),并将深度图中对应位置的深度值定义为该像素的深度值d;

[0051]

全聚焦图像素距离定义子单元,其用于将全聚焦图中两个像素p

i

,p

j

之间的颜色距离dis1定义为式(1),全聚焦图中两个像素p

i

,p

j

之间的平面坐标距离dis2定义为式(2),全聚焦图中两个像素p

i

,p

j

之间的深度距离dis3定义为式(3):

[0052][0053][0054][0055]

并通过对dis1、dis2和dis3加权求和,如式(4)所示,来定义全聚焦图中两个像素

p

i

,p

j

之间的距离dis(p

i

,p

j

):

[0056]

dis(p

i

,p

j

)=dis1(p

i

,p

j

)+αdis2(p

i

,p

j

)+βdis3(p

i

,p

j

)

ꢀꢀꢀꢀꢀꢀꢀ

(4)其中,α、β为权重参数,需要根据不同场景进行调整选择;

[0057]

全聚焦图分割单元,其用于通过该距离dis(p

i

,p

j

)对全聚焦图中的像素聚类,每一类形成一个超像素,完成全聚焦图的超像素分割。

[0058]

深度图分割单元,其用于对于全聚焦图的任意一个超像素中的像素,将深度图中与之对应的像素划分为一个超像素,完成对深度图的超像素分割。

[0059]

进一步地,单应性变换矩阵计算装置具体包括:

[0060]

特征点提取与匹配单元,其用于对全聚焦图和上采样后与之尺度一致的大视场2d图像提取特征点进行匹配,并剔除离群点后,得到每个超像素中能够与大视场2d图像准确匹配的特征点对;

[0061]

单应性变换矩阵h计算单元,其用于将每个超像素近似为一个平面,其内部能够与大视场2d图像中准确匹配的特征点对的齐次坐标[x1,y1,1]

t

、[x2,y2,1]

t

之间的坐标变换由3

×

3的单应性变换矩阵h描述为式(5),并根据每个深度层上超像素内不少于4组特征点对建立线性回归方程组,由最小二乘法计算求解该深度层上超像素所对应的单应性变换矩阵h:

[0062][0063]

进一步地,拼接融合装置具体包括:

[0064]

全聚焦图和深度图的拼接与融合单元,其包括;

[0065]

全聚焦图拼接子单元,其用于利用计算单元计算的每个深度层的单应性矩阵,将全聚焦图中全部超像素向大视场2d图像进行坐标变换,并保留全聚焦图信息,进行拼接;

[0066]

全聚焦图融合子单元,其用于利用多频段方法对拼接的全聚焦图进行融合;

[0067]

深度图拼接子单元,其用于对深度图的超像素用与全聚焦图相同的单应性变换矩阵进行坐标变换,进行拼接;

[0068]

深度图融合子单元,其用于利用加权平均的方式对拼接的深度图进行融合;

[0069]

其中,全聚焦图拼接子单元具体包括:

[0070]

对全聚焦图直接用单应性矩阵进行坐标变换后,原本每个像素的坐标值由整数变为非整数,在变换后的坐标系中,每个整数坐标的像素值通过其周围非整数坐标处的像素值以距离为权重进行插值计算得到;

[0071]

遍历全部像素,找到空洞位置,以空洞位置为起点,沿上下左右四个方向向外在一定范围内检测,直到检测出四个非空洞的像素,对这四个位置的像素值以距离为权重插值得到空洞位置的像素值,将空洞部分补全。

[0072]

进一步地,大视场聚焦堆栈数据生成装置具体包括:

[0073]

点扩散函数估计单元,其用于对于场景的每个深度层,估计成像系统在不同聚焦面上的点扩散函数;

[0074]

大视场聚焦堆栈数据生成单元,根据大视场全聚焦图、深度图和点扩散函数生成聚焦在不同聚焦面上的图像序列,即大视场聚焦堆栈数据;

[0075]

其中,大视场聚焦堆栈数据生成单元具体包括:

[0076]

将大视场全聚焦图根据其深度图中的深度值,逐层卷积相应的点扩散函数,计算每个深度层在相应聚焦面上生成的图像;

[0077]

将每个聚焦面上不同深度层卷积生成的图像进行叠加,生成大视场场景在该聚焦面上的图像,在所有聚焦面上所成大视场图像的序列即为大视场聚焦堆栈数据。

[0078]

本发明由于采取以上技术方案,其具有以下优点:

[0079]

1.由聚焦堆栈生成的全聚焦图与深度图是准确配准的rgb

‑

d数据,避免了直接拼接聚焦堆栈数据时,难以找到对应聚焦深度的图像序列;

[0080]

2.结合深度信息进行超像素分割,可以将每个超像素近似为空间中的一个平面;

[0081]

3.将超像素按照深度层归类,同一类的超像素在同一平面,属于一个平面的特征点一起计算,可以得到更准确的单应性变换矩阵;

[0082]

4.以2d大视场图像为参考,当待拼接数据之间重叠区域较小时,依然能够得到较好的拼接结果;

[0083]

5.以大视场2d图像为参考,在多组数据拼接时可以降低相继拼接的累积误差。

附图说明

[0084]

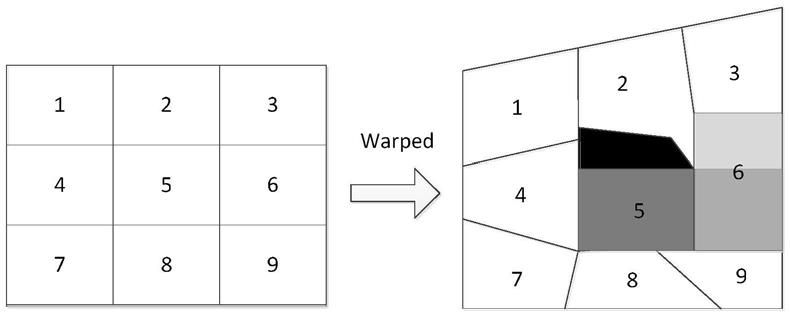

图1为本发明实施例提供的超像素变换前后示意图。

[0085]

图2为本发明实施例提供的以距离为权重由非整数坐标像素插值计算整数坐标像素示意图。

[0086]

图3为本发明实施例提供的处理变换后超像素间空洞示意图。

具体实施方式

[0087]

下面结合附图和实施例对本发明进行详细的描述。

[0088]

本发明实施例提出一种以2d大视场图像为参考,基于超像素分割的聚焦堆栈rgd

‑

d数据拼接方法,该方法包括:

[0089]

步骤1,由聚焦堆栈数据计算生成全聚焦图与深度图,即准确配准的rgb

‑

d数据;

[0090]

由于聚焦堆栈数据是场景聚焦在不同聚焦面上形成的图像序列,根据物点在图像序列中聚焦测度的变化可以计算得到其聚焦位置和深度信息,从而生成全聚焦图和深度图,即准确配准的rgb

‑

d数据。

[0091]

步骤2,将低分辨率的2d大视场图像上采样至与rgb

‑

d数据尺度一致。

[0092]

由聚焦堆栈数据根据聚焦测度可以计算生成全聚焦图和深度图,即准确配准的rgb

‑

d数据。提取全聚焦图与2d大视场图像中的特征点(比如sift特征点)并进行匹配,通过特征点之间的平均坐标距离计算全聚焦图和大视场2d图像的放大比,并根据放大比将2d大视场图像上采样至与rgb

‑

d数据尺度一致,即场景中任意物体在全聚焦图或深度图中所占像素个数与其在2d大视场图中所占像素个数相同。

[0093]

步骤3,对rgb

‑

d数据进行超像素分割,其具体包括:

[0094]

步骤31,将全聚焦图像从rgb颜色空间转换到cie

‑

lab颜色空间,则每一个像素对应三通道颜色信息(l,a,b),2d坐标信息(x,y)。由聚焦堆栈数据生成的全聚焦图和深度图是配准好的,即每个像点在两幅图中对应像素的2d坐标信息相同,因此可以将深度图中每

个像素的深度值作为全聚焦图中相同坐标的像素的深度信息d。

[0095]

于是,全聚焦图中每一个像素p

i

对应一个6维特征向量[l

i

,a

i

,b

i

,x

i

,y

i

,d

i

],其中的参数分别描述了该像素的颜色、平面坐标位置,深度的信息。

[0096]

步骤32,将全聚焦图中两个像素p

i

,p

j

之间的颜色距离dis1定义为式(1),全聚焦图中两个像素p

i

,p

j

之间的平面坐标距离dis2定义为式(2),全聚焦图中两个像素p

i

,p

j

之间的深度距离dis3定义为式(3):

[0097][0098][0099][0100]

步骤33,通过对dis1、dis2和dis3加权求和,如式(4)所示,来定义两个像素之间的距离dis(p

i

,p

j

):

[0101]

dis(p

i

,p

j

)=dis1(p

i

,p

j

)+αdis2(p

i

,p

j

)+βdis3(p

i

,p

j

)

ꢀꢀꢀꢀꢀꢀ

(4)

[0102]

其中,α表示控制像素平面空间距离的权重,α取值越大分割出的超像素形状越接近矩形,当场景中物体形状不规则时,应取较小的α值,使得分割得到的超像素能够更好地保持物体边界处的形状。β表示控制像素深度距离的权重,β取值越大时一个超像素内部像素的深度值越接近,也就越趋于一个平面,当场景中存在颜色相近深度差异较大的相邻物体时需要适当增大β的取值,尽可能使一个超像素内部不会跨多个深度层。根据不同场景的特点调整两个参数的取值,使得分割出的超像素能够较好的保持物体边界的形状并且每个超像素内部深度较一致可以近似看作一个平面。

[0103]

步骤34,利用k

‑

means算法由该距离dis(p

i

,p

j

)对全聚焦图中的像素聚类,每一类形成一个超像素,从而实现全聚焦图的超像素分割。

[0104]

步骤35,对于全聚焦图的任意一个超像素中的像素,将深度图中与之对应的像素划分为一个超像素,完成对深度图的超像素分割。

[0105]

通过步骤31至步骤35完成rgb

‑

d数据的超像素分割。

[0106]

步骤4,提取并匹配全聚焦图与大视场2d图像之间的特征点,计算同一深度层超像素的准确单应性变换矩阵。步骤4具体包括:

[0107]

步骤41,对全聚焦图和上采样后与之尺度一致的大视场2d图像提取sift特征点并进行匹配,利用ransac剔除离群点后,得到每个超像素中能够与大视场2d图像准确匹配的特征点对。

[0108]

步骤42,将每个超像素可以近似看作一个平面,其内部能够与大视场2d图像中准确匹配的特征点对的齐次坐标[x1,y1,1]

t

、[x2,y2,1]

t

之间的坐标变换可以由3

×

3的单应性变换矩阵h描述为式(5):

[0109]

[0110]

一对特征点的坐标能写出关于h的2个线性方程,超过4组特征点对即可建立线性回归方程组由最小二乘法计算求解h,且使用的匹配特征点对数目越多,计算得到的h越准确。根据深度信息将超像素归类,同一深度层的超像素对应的物点在空间中可以近似看作同一个平面上的点,对应的单应性变换矩阵应该是相同的。将同一深度层的多个超像素中包含的准确匹配特征点对一起建立同一个线性回归方程组,用来计算该深度层的单应性变换矩阵h。

[0111]

步骤5,逐深度层进行超像素变换实现全聚焦图和深度图的拼接融合。步骤5具体包括:

[0112]

步骤51,全聚焦图的拼接与融合。

[0113]

步骤511,利用步骤3中计算的每个深度层的单应性矩阵,将全聚焦图中全部超像素向大视场2d图像进行坐标变换,并保留全聚焦图信息,进行拼接。

[0114]

直接变换后,不同超像素之间可能出现重叠或空洞的情况,如图1所示,超像素5和6之间存在重叠区域,超像素2和5之间出现空洞。为了解决这两种情况进行如下处理:

[0115]

步骤5111,对全聚焦图直接用单应性矩阵进行坐标变换后,原本每个像素的坐标值由整数变为非整数,在变换后的坐标系中,每个整数坐标的像素值通过其周围非整数坐标处的像素值以距离为权重进行插值计算得到。

[0116]

如图2所示,o1,o2,o3,o4是变换后坐标系中的四个整数坐标位置,a

‑

i为全聚焦图中像素直接坐标变换后的非整数坐标位置,则o1处的像素值通过其周围非整数坐标a,b,c,d,e的像素值以其与o1的距离为权重进行插值得到,o2处的像素值通过其周围非整数坐标b,d,g,h的像素值以其与o2距离为权重进行插值得到的,以此类推,可以得到o3,o4处的像素值。这样插值的方式可以有效处理直接变换后超像素之间的重叠问题。

[0117]

步骤5112,遍历全部像素,找到像素值为0的位置,即空洞位置,以空洞位置为起点,沿上下左右四个方向向外在一定范围内检测,直到检测出四个非空洞的像素,即像素值不为0,对这四个位置的像素值以距离为权重插值得到空洞位置的像素值,将空洞部分补全。

[0118]

如图3所示,找到像素值为0的点o后向四个方向检测出四个像素值非0的像素u,d,l,r,将这四个像素的像素值按照与o的距离为权重进行插值得到o的像素值。

[0119]

步骤512,完成拼接后,由于不同视角拍摄的数据在光照上可能出现不统一,利用多频段方法对拼接的图像进行融合,使整体亮度统一。

[0120]

步骤52,深度图的拼接与融合。

[0121]

由于全聚焦图和深度图是聚焦堆栈计算生成的配准好的rgb

‑

d数据,对深度图的超像素采用与全聚焦图相同的单应性变换矩阵进行坐标变换。由于深度图中表达的是场景的几何信息,不存在光照的影响,不需要再通过多频段的方法进行融合,直接加权平均处理重叠和空洞的情况即可。

[0122]

步骤6,由大视场的rgb

‑

d数据生成大视场的聚焦堆栈数据。步骤6具体包括:

[0123]

步骤61,估计每个深度层在成像系统中不同聚焦面上的点扩散函数。其中,成像系统通过模拟得到,其具体包括:首先,设置孔径形状大小,然后,可以利用理想点扩散函数的公式,得到不同深度到不同聚焦面的点扩散函数。

[0124]

步骤62,根据大视场全聚焦图、深度图和点扩散函数生成聚焦在不同聚焦面上的

图像序列,即大视场聚焦堆栈数据。

[0125]

步骤621,将大视场全聚焦图中的像素按照其深度图中的深度值进行分层,即直接根据深度图将相同深度值的像素分为一层。

[0126]

步骤622,对于每一个聚焦面,逐深度层将全聚焦图与步骤61估计得到的点扩散函数进行卷积。

[0127]

步骤623,对于每一个聚焦面,将卷积后的图像叠加得到场景聚焦在该聚焦面上的图像,形成大视场聚焦堆栈数据。

[0128]

本发明实施例还提供一种基于超像素分割的聚焦堆栈rgb

‑

d数据的拼接融合的系统,该系统包括数据预处理装置、超像素分割装置、单应性变换矩阵计算装置和拼接融合装置、大视场聚焦堆栈数据生成装置,其中:

[0129]

数据预处理装置用于将聚焦堆栈数据计算生成rgb

‑

d数据,并将低分辨率的2d大视场图像上采样至与rgb

‑

d数据尺度一致。由聚焦堆栈数据根据聚焦测度可以计算生成全聚焦图和深度图,即准确配准的rgb

‑

d数据。提取全聚焦图与2d大视场图像中的特征点(比如sift特征点)并进行匹配,通过特征点之间的平均坐标距离计算全聚焦图和大视场2d图像的放大比,并根据放大比将2d大视场图像上采样至与rgb

‑

d数据尺度一致,即场景中任意物体在全聚焦图或深度图中所占像素个数与其在2d大视场图中所占像素个数相同。

[0130]

超像素分割装置用于对rgb

‑

d数据进行超像素分割。

[0131]

超像素分割装置具体包括:

[0132]

转换单元,其用于将全聚焦图像从rgb颜色空间转换到cie

‑

lab颜色空间,则每一个像素对应三通道颜色信息(l,a,b),2d坐标信息(x,y),并将深度图中对应位置的深度值定义为该像素的深度值d;

[0133]

全聚焦图像像素距离定义子单元,其用于将全聚焦图中两个像素p

i

,p

j

之间的颜色距离dis1定义为式(1),全聚焦图中两个像素p1,p2之间的平面坐标距离dis2定义为式(2),全聚焦图中两个像素p1,p2之间的深度距离dis3定义为式(3):

[0134][0135][0136][0137]

通过对dis1、dis2和dis3加权求和,如式(4)所示,来定义全聚焦图中两个像素p

i

,p

j

之间的距离dis(p

i

,p

j

):

[0138]

dis(p

i

,p

j

)=dis1(p

i

,p

j

)+αdis2(p

i

,p

j

)+βdis3(p

i

,p

j

)

ꢀꢀꢀꢀꢀꢀ

(4)其中,α、β为权重参数,需要根据不同场景进行调整选择;

[0139]

全聚焦图像像素聚类单元,其用于通过该距离dis(p

i

,p

j

)对全聚焦图中的像素聚类,每一类形成一个超像素,完成全聚焦图的超像素分割。

[0140]

深度图分割单元,其用于根据全聚焦图的超像素分割对深度图进行完全相同的分割。

[0141]

单应性变换矩阵计算装置用于提取并匹配全聚焦图与大视场2d图像之间的特征点,计算同一深度层超像素的准确单应性变换矩阵。

[0142]

单应性变换矩阵计算装置具体包括:

[0143]

特征点匹配单元,其用于对全聚焦图和上采样后与之尺度一致的大视场2d图像提取特征点并进行匹配,并剔除离群点后,得到每个超像素中能够与大视场2d图像准确匹配的特征点对;

[0144]

单应性变换矩阵h计算单元,其用于将每个超像素近似为一个平面,其内部能够与大视场2d图像中准确匹配的特征点对的齐次坐标[x1,y1,1]

t

、[x2,y2,1]

t

之间的坐标变换由3

×

3的单应性变换矩阵h描述为式(5),并根据同一深度层上超像素内不少于4组特征点对即可建立线性回归方程组由最小二乘法计算求解该深度层超像素所对应的单应性变换矩阵h:

[0145][0146]

拼接融合装置用于逐深度层进行超像素变换实现全聚焦图和深度图的拼接融合。

[0147]

拼接融合装置具体包括:

[0148]

全聚焦图和深度图的拼接与融合单元,其包括;

[0149]

全聚焦图拼接子单元,其用于利用计算单元计算的每个深度层的单应性矩阵,将全聚焦图中全部超像素向大视场2d图像进行坐标变换,并保留全聚焦图信息,进行拼接;

[0150]

全聚焦图融合子单元,其用于利用多频段方法对拼接的全聚焦图进行融合。

[0151]

深度图拼接子单元,其用于对深度图的超像素用与全聚焦图相同的单应性变换矩阵进行坐标变换,进行拼接;

[0152]

深度图融合子单元,其用于利用加权平均的方式对拼接的深度图进行融合。

[0153]

其中,全聚焦图拼接子单元具体包括:

[0154]

对全聚焦图直接用单应性矩阵进行坐标变换后,原本每个像素的坐标值由整数变为非整数,在变换后的坐标系中,每个整数坐标的像素值通过其周围非整数坐标处的像素值以距离为权重进行插值计算得到;

[0155]

遍历全部像素,找到空洞位置,以空洞位置为起点,沿上下左右四个方向向外在一定范围内检测,直到检测出四个非空洞的像素,对这四个位置的像素值以距离为权重插值得到空洞位置的像素值,将空洞部分补全。

[0156]

本发明实施例结合深度信息对rgb

‑

d数据进行超像素分割;将超像素按照深度进行分层,以2d大视场图像作为全局参考,进行全聚焦图与大视场2d图像的sift特征点提取与匹配,将每组rgb

‑

d数据一层超像素计算得到准确的单应性变换矩阵,向大视场2d图像拼接,可以实现多组不同视角下的聚焦堆栈rgb

‑

d数据准确的拼接融合。

[0157]

大视场聚焦堆栈数据生成装置用于由大视场全聚焦图和深度图生成出场景在成像系统中得到的大视场聚焦堆栈数据。

[0158]

大视场聚焦堆栈数据生成装置具体包括:

[0159]

点扩散函数估计单元,其用于对于场景的每个深度层,估计成像系统在不同聚焦面上的点扩散函数;

[0160]

大视场聚焦堆栈数据生成单元,根据大视场全聚焦图、深度图和点扩散函数生成聚焦在不同聚焦面上的图像序列,即大视场聚焦堆栈数据。

[0161]

其中,大视场聚焦堆栈数据生成单元具体包括:

[0162]

将大视场全聚焦图根据其深度图中的深度值,逐层卷积相应的点扩散函数,计算每个深度层在相应聚焦面上生成的图像;

[0163]

将每个聚焦面上不同深度层卷积生成的图像进行叠加,生成大视场场景在该聚焦面上的图像,在所有聚焦面上所成大视场图像的序列即为大视场聚焦堆栈数据。

[0164]

最后需要指出的是:以上实施例仅用以说明本发明的技术方案,而非对其限制。本领域的普通技术人员应当理解:可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1