基于深度学习的实时布匹缺陷检测方法及系统

1.本发明涉及布匹缺陷检测技术领域,尤其涉及一种基于深度学习的实时布匹缺陷检测方法及系统。

背景技术:

2.在布匹生产中,布匹的质量是重中之重,不仅和人们的生活息息相关,还直接影响到产业发展,攸关企业生命。目前在纺织服装生产企业主要通过专业的布匹检验人员站在验布设备前,通过肉眼发现布面疵点再进行疵点的标记或者记录。但依靠人工验布存在很多问题——缺陷检出率低、招工难且人员成本高,并且验布员注意力无法持续维持,验布速度较慢,若验布时间过长,验布工会产生疲劳,检测效率就会大打折扣,很不稳定。因此利用计算机来帮助人类进行缺陷检测已经是大势所趋,人们将布匹图拍下来输入到计算机中,让计算机根据一些图像处理算法来进行缺陷检测,然而,传统图像处理一般都需要针对不同的场景来手工设计特征,因此鲁棒性不够,往往换一种场景,效果就会变差,检测速度也不理想,并且布匹缺陷种类往往较多,很难进行手工设计缺陷特征。

3.依靠深度学习进行缺陷检测能取得较好的检测效果,但其需要大量的数据样本作为基础,如果数据量不够,往往效果不是很理想,而在实际生产中,带缺陷的数据样本往往较少,无法给深度模型带来很好效果。

技术实现要素:

4.本发明实施例所要解决的技术问题在于,提供一种基于深度学习的实时布匹缺陷检测方法及系统,以实现在保证检测精度的同时尽可能提高检测速度,提高自动布匹缺陷检测机器的工作效率以解放人力,提升纺织业的智能化程度。

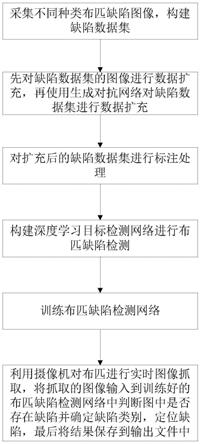

5.为了解决上述技术问题,本发明实施例提出了一种基于深度学习的实时布匹缺陷检测方法,包括:

6.步骤1:采集不同种类布匹缺陷图像,构建缺陷数据集;

7.步骤2:先对缺陷数据集的图像进行数据扩充,再使用生成对抗网络对缺陷数据集进行数据扩充;

8.步骤3:对扩充后的缺陷数据集进行标注处理;

9.步骤4:构建深度学习目标检测网络进行布匹缺陷检测;

10.步骤5:训练布匹缺陷检测网络;

11.步骤6:利用摄像机对布匹进行实时图像抓取,将抓取的图像输入到训练好的布匹缺陷检测网络中判断图中是否存在缺陷并确定缺陷类别,定位缺陷,最后将结果保存到输出文件中。

12.进一步地,步骤1中,布匹缺陷种类分为正常、黑点、划痕、孔、油渍、毛斑、破边、缺经、缺纬、吊弓中的一种或多种,并将采集的图像的比例切割成512*512大小进行分类。

13.进一步地,步骤2中,生成对抗网络由一个生成器g和一个判别器d构成,生成器g接

收一个正常的布匹图像z,然后生成带有指定缺陷的图像g(z),再经过判别器d判断图像是否属于原始数据集,得到d(g(z)),生成对抗网络的优化公式为:

[0014][0015]

其中,x表示真实布匹缺陷图像,z表示输入生成器g的正常布匹图像,g(z)表示生成器g生成的缺陷图像,d(x)表示判别器d判断真实缺陷图像是否真实的概率,该值越接近1越好,d(g(z))表示判别器d判断生成器g生成的图像是否真实的概率,p

data

表示真实数据的分布,p

z

表示生成器输入图像的分布,表示期望,表示判别器d判别样本是否是从p

data

(x)中取出来的期望,表示生成器g生成图像能够骗过判别器的期望。

[0016]

进一步地,步骤4中,采用yolov3检测网络架构,并采用leaky relu作为激活函数,其表达式为:

[0017][0018]

其中x

i

表示输入,y

i

表示输出,a

i

是(1,+∞)区间内的固定参数。

[0019]

进一步地,在yolov3中,整体loss分为位置坐标损失lbox、置信度损失lobj以及类别损失lcls三部分,公式如下所示:

[0020][0021][0022]

lloss=lbox+lobj+lcls;

[0023]

其中,λ

coord

表示定位误差的权值;x

i

,y

i

,w

i

,h

i

表示预测的目标框的位置信息,分别表示框的左上角处的横坐标,纵坐标以及框的宽度和高度;s2表示网格数有s*s个,具体为13*13,26*26,52*52,b表示每个网格产生b个候选框anchor box,表示第i个网格的第j个anchor box负责预测这个目标的概率,如果负责,则否则该值为0,表示第i个网格的第j个anchor box不负责预测该目标的概率,与正好相反;p

i

(c)表示属于类别c的概率;c

i

表示类别标签置信度,表示预测的类别置信度。

[0024]

相应地,本发明实施例还提供了一种基于深度学习的实时布匹缺陷检测系统,包括:

[0025]

采集模块:采集不同种类布匹缺陷图像,构建缺陷数据集;

[0026]

扩充模块:先对缺陷数据集的图像进行数据扩充,再使用生成对抗网络对缺陷数据集进行数据扩充;

[0027]

标注模块:对扩充后的缺陷数据集进行标注处理;

[0028]

构建模块:构建深度学习目标检测网络进行布匹缺陷检测;

[0029]

训练模块:训练布匹缺陷检测网络;

[0030]

检测模块:利用摄像机对布匹进行实时图像抓取,将抓取的图像输入到训练好的布匹缺陷检测网络中判断图中是否存在缺陷并确定缺陷类别,定位缺陷,最后将结果保存到输出文件中。

[0031]

进一步地,采集模块中,布匹缺陷种类分为正常、黑点、划痕、孔、油渍、毛斑、破边、缺经、缺纬、吊弓中的一种或多种,并将采集的图像的比例切割成512*512大小进行分类。

[0032]

进一步地,扩充模块中,生成对抗网络由一个生成器g和一个判别器d构成,生成器g接收一个正常的布匹图像z,然后生成带有指定缺陷的图像g(z),再经过判别器d判断图像是否属于原始数据集,得到d(g(z)),生成对抗网络的优化公式为:

[0033][0034]

其中,x表示真实布匹缺陷图像,z表示输入生成器g的正常布匹图像,g(z)表示生成器g生成的缺陷图像,d(x)表示判别器d判断真实缺陷图像是否真实的概率,该值越接近1越好,d(g(z))表示判别器d判断生成器g生成的图像是否真实的概率,p

data

表示真实数据的分布,p

z

表示生成器输入图像的分布,表示期望,表示判别器d判别样本是否是从p

data

(x)中取出来的期望,表示生成器g生成图像能够骗过判别器的期望。

[0035]

进一步地,构建模块中,采用yolov3检测网络架构,并采用leaky relu作为激活函数,其表达式为:

[0036][0037]

其中x

i

表示输入,y

i

表示输出,a

i

是(1,+∞)区间内的固定参数。

[0038]

进一步地,在yolov3中,整体loss分为位置坐标损失lbox、置信度损失lobj以及类别损失lcls三部分,公式如下所示:

[0039][0040]

[0041][0042]

lloss=lbox+lobj+lcls;

[0043]

其中,λ

coord

表示定位误差的权值;x

i

,y

i

,w

i

,h

i

表示预测的目标框的位置信息,分别表示框的左上角处的横坐标,纵坐标以及框的宽度和高度;s2表示网格数有s*s个,具体为13*13,26*26,52*52,b表示每个网格产生b个候选框anchor box,表示第i个网格的第j个anchor box负责预测这个目标的概率,如果负责,则否则该值为0,表示第i个网格的第j个anchor box不负责预测该目标的概率,与正好相反;p

i

(c)表示属于类别c的概率;c

i

表示类别标签置信度,表示预测的类别置信度。

[0044]

本发明的有益效果为:

[0045]

本发明使用深度学习的技术,针对缺陷样本过少的问题,使用生成对抗网络得到大量近似真实缺陷的图像数据,以达到数据扩充的目的,从而提升模型性能,并且选择检测速度和检测精度均较高的深度学习目标检测网络来进行缺陷检测,能够有效实现布匹缺陷实时检测的目的,与传统图像处理技术相比,能够省去人工设计特征,提高缺陷检测系统鲁棒性,且大幅提升检测性能,并且能够解放人力,进一步提高纺织业智能化程度。

附图说明

[0046]

图1是本发明实施例的基于深度学习的实时布匹缺陷检测方法的流程图。

[0047]

图2是本发明实施例基于生成对抗网络进行数据集扩充的原理图。

[0048]

图3是本发明实施例基于深度学习目标检测算法的原理图。

具体实施方式

[0049]

需要说明的是,在不冲突的情况下,本申请中的实施例及实施例中的特征可以相互结合,下面结合附图和具体实施例对本发明作进一步详细说明。

[0050]

本发明实施例的基于深度学习的实时布匹缺陷检测方法首先利用生成对抗网络来生成需要的缺陷数据,然后再利用深度学习目标检测网络进行训练,训练得到最优模型之后将其保存,在测试时将模型文件加载进网络,此时输入一张布匹图像,本发明实施例的基于深度学习的实时布匹缺陷检测系统就能自动通过模型推断出结果。

[0051]

请参照图1~图3,本发明实施例的基于深度学习的实时布匹缺陷检测方法,包括:

[0052]

步骤1:建立布匹图像数据采集环境,采集不同种类布匹缺陷图像,构建缺陷数据集;

[0053]

步骤2:先对缺陷数据集的图像进行常规数据扩充,即对图像进行平移、旋转等操作,获得一定数量的新数据,再使用生成对抗网络对缺陷数据集进行数据扩充;

[0054]

步骤3:对扩充后的缺陷数据集进行标注处理;

[0055]

步骤4:构建深度学习目标检测网络进行布匹缺陷检测;

[0056]

步骤5:训练布匹缺陷检测网络;

[0057]

步骤6:利用工业摄像机对布匹进行实时图像抓取,将抓取的图像输入到训练好的布匹缺陷检测网络中判断图中是否存在缺陷并确定缺陷类别,定位缺陷,最后将结果保存到输出文件中。

[0058]

在步骤1中,建立布匹图像数据采集环境,采集不同种类布匹缺陷的数据集。在本实施方式中,通过构建自动抓拍图像系统来建立布匹图像数据采集环境,所构建的自动抓拍图像系统包括硬件模块有:布匹传送带、工业高速摄像机、一台计算机,将摄像机置于定点传送带的上方,传送带以匀速传送布匹,高速摄像机快速抓取布匹图像,并将其输出保存在计算机中。其中,摄像机抓取的图像为完整高清图像且图像高度和宽度应为512的倍数。缺陷类别包括正常、黑点、划痕、孔、油渍、毛斑、破边、缺经、缺纬、吊弓及其他。

[0059]

在步骤2中,首先进行常规数据扩充,如平移、旋转、对称、缩放、裁剪、填充、左右翻转、颜色变换等操作,然后利用生成对抗网络对缺陷数据集进行数据扩充。第一步的数据扩充是为了之后训练生成对抗网络时有较多真实数据,以取得更好效果。然后使用生成对抗网络进行进一步的数据扩充,生成对抗网络由生成器g和判别器d组成,生成器g采用u

‑

net的网络架构,输入为512*512*3的图像,分别表示图像的高度、宽度和通道数,网络的左半部分可以看作是编码器,将图像的特征进行提取,右半部分则是解码器,将图像还原成512*512*3大小且带有缺陷的图像,以达到缺陷图像生成的目的。判别器d采用多层resnet的网络结构,输入一张512*512*3的图像,输出一个0~1之间的数值,该数值表示输入图像是否真实的概率。经过对抗训练之后,生成对抗网络会达到一种平衡状态,此时生成器g生成的缺陷图像近似真实缺陷图像,d(g(z))≈0.5,从而达到了缺陷数据扩充的目的,优化公式为:

[0060][0061]

其中,x表示真实布匹缺陷图像,z表示输入生成器g的正常布匹图像,g(z)表示生成器g生成的缺陷图像。d(x)表示判别器d判断真实缺陷图像是否真实的概率,该值越接近1越好,d(g(z))表示判别器d判断生成器g生成的图像是否真实的概率,p

data

表示真实数据的分布,p

z

表示生成器输入图像的分布,表示期望,表示判别器d判别样本是不是从p

data

(x)中取出来的期望,表示生成器g生成图像能够骗过判别器的期望,对该公式而言,min

g

max

d

v(d,g),即对于判别器d来说要尽量使公式最大化,即判断能力强,而对生成器g来说要尽量是公式小,即使得生成的数据接近真实样本。具体如图2所示。

[0062]

在步骤3中,对扩充后的缺陷数据集进行标注处理。标签文件按照voc格式建立,标签类别则为缺陷种类,包括正常、黑点、划痕、孔、油渍、毛斑、破边、缺经、缺纬、吊弓及其他。

[0063]

在步骤4中,构建深度学习目标检测网络进行布匹缺陷检测。具体为使用yolov3进行目标检测,该网络的backbone为darknet

‑

53,是由一些3*3的卷积层、1*1的卷积层和一些残差块构成。yolov3有三个不同特征尺度的输出,分别是13*13*m,26*26*m,52*52*m,其中m表示每个格子有多少个值,比如使用voc数据集训练,目标检测种类为20,yolov3中每个cell有3个box,每个box有(x,y,w,h,confidence)5个基本参数,分别表示目标的坐标和置信度,所以此时m=3*(5+20)=75。yolov3在类别预测的代价函数上用逻辑回归层来对每个类别做二分类,主要用到sigmoid函数,该函数将输出约束在0~1的范围中,若该值大于

0.5,这表示属于该类,因此一个框就可预测多个类别,其具体公式如下:

[0064][0065]

其中,z表示输入,σ(z)表示输出。

[0066]

yolov3中使用leaky relu作为激活函数,其表达式为:

[0067][0068]

其中x

i

表示输入,y

i

表示输出,a

i

是(1,+∞)区间内的固定参数。

[0069]

使用batch normalization作为正则化。

[0070]

在yolov3中,整体loss分为位置坐标loss、置信度loss以及类别loss三部分。

[0071][0072][0073][0074]

lloss=lbox+lobj+lcls;

[0075]

其中,λ

coord

表示定位误差的权值;x

i

,y

i

,w

i

,h

i

表示预测的目标框的位置信息,分别表示框的左上角处的横坐标,纵坐标以及框的宽度和高度;s2表示网格数有s*s个,具体为13*13,26*26,52*52,b表示每个网格产生b个候选框anchor box,表示第i个网格的第j个anchor box负责预测这个目标的概率,如果负责,则否则该值为0,表示第i个网格的第j个anchor box不负责预测该目标的概率,与正好相反;p

i

(c)表示属于类别c的概率;c

i

表示类别标签置信度,表示预测的类别置信度,包括包含目标的可能性以及边界框的准确度(与真实框的iou)。其具体网络架构请参考图3。

[0076]

在步骤5中,训练布匹缺陷检测网络。将步骤3中得到的数据集按照7:3的比例划分训练集和测试集,通过反向传播约束步骤4中的总loss,使其尽可能小,在训练集和测试集上分别评估训练模型优劣,最后不断调整训练参数得到最优模型。

[0077]

在步骤6中,将步骤s5中得到的最优模型参数文件加载进模型中,利用工业摄像机对布匹在传送带上进行实时图像抓取,将抓取的图像输入到训练好的布匹缺陷检测网络中,使用性能较好的gpu如2080ti来进行运算,能够达到实时检测的效果,从而能够实时判断图中是否存在缺陷并确定缺陷类别,定位缺陷,最后将结果保存到输出文件中。

[0078]

本发明实施例的基于深度学习的实时布匹缺陷检测系统包括:

[0079]

采集模块:采集不同种类布匹缺陷图像,构建缺陷数据集;

[0080]

扩充模块:先对缺陷数据集的图像进行数据扩充,再使用生成对抗网络对缺陷数据集进行数据扩充;

[0081]

标注模块:对扩充后的缺陷数据集进行标注处理(标签文件按照voc格式建立,标签类别则为缺陷种类,包括正常、黑点、划痕、孔、油渍、毛斑、破边、缺经、缺纬、吊弓及其他);

[0082]

构建模块:构建深度学习目标检测网络进行布匹缺陷检测;

[0083]

训练模块:训练布匹缺陷检测网络;

[0084]

检测模块:利用摄像机对布匹进行实时图像抓取,将抓取的图像输入到训练好的布匹缺陷检测网络中判断图中是否存在缺陷并确定缺陷类别,定位缺陷,最后将结果保存到输出文件中。

[0085]

作为一种实施方式,采集模块中,布匹缺陷种类分为正常、黑点、划痕、孔、油渍、毛斑、破边、缺经、缺纬、吊弓中的一种或多种,并将采集的图像的比例切割成512*512大小进行分类。

[0086]

作为一种实施方式,扩充模块中,生成对抗网络由一个生成器g和一个判别器d构成,生成器g接收一个正常的布匹图像z,然后生成带有指定缺陷的图像g(z),再经过判别器d判断图像是否属于原始数据集,得到d(g(z))。生成器g采用u

‑

net的网络架构,输入为512*512*3的图像,分别表示图像的高度、宽度和通道数,网络的左半部分可以看作是编码器,将图像的特征进行提取,右半部分则是解码器,将图像还原成512*512*3大小且带有缺陷的图像,以达到缺陷图像生成的目的。判别器d采用多层resnet的网络结构,输入一张512*512*3的图像,输出一个0~1之间的数值,该数值表示输入图像是否真实的概率。经过对抗训练之后,生成对抗网络会达到一种平衡状态,此时生成器g生成的缺陷图像近似真实缺陷图像,d(g(z))≈0.5,从而达到了缺陷数据扩充的目的,生成对抗网络的优化公式为:

[0087][0088]

其中,x表示真实布匹缺陷图像,z表示输入生成器g的正常布匹图像,g(z)表示生成器g生成的缺陷图像,d(x)表示判别器d判断真实缺陷图像是否真实的概率,该值越接近1越好,d(g(z))表示判别器d判断生成器g生成的图像是否真实的概率,p

data

表示真实数据的分布,p

z

表示生成器输入图像的分布,表示期望,表示判别器d判别样本是否是从p

data

(x)中取出来的期望,表示生成器g生成图像能够骗过判别器的期望。对该公式而言,min

g

max

d

v(d,g),即对于判别器d来说要尽量使公式最大化,即判断能力强,而对生成器g来说要尽量是公式小,即使得生成的数据接近真实样本,具体如图2所示。

[0089]

作为一种实施方式,构建模块中,采用yolov3检测网络架构,并采用leaky relu作为激活函数,其表达式为:

[0090][0091]

其中x

i

表示输入,y

i

表示输出,a

i

是(1,+∞)区间内的固定参数。

[0092]

作为一种实施方式,在yolov3中,整体loss分为位置坐标损失lbox、置信度损失lobj以及类别损失lcls三部分,公式如下所示:

[0093][0094][0095][0096]

lloss=lbox+lobj+lcls;

[0097]

其中,λ

coord

表示定位误差的权值;x

i

,y

i

,w

i

,h

i

表示预测的目标框的位置信息,分别表示框的左上角处的横坐标,纵坐标以及框的宽度和高度;s2表示网格数有s*s个,具体为13*13,26*26,52*52,b表示每个网格产生b个候选框anchor box,表示第i个网格的第j个anchor box负责预测这个目标的概率,如果负责,则否则该值为0,表示第i个网格的第j个anchor box不负责预测该目标的概率,与正好相反;p

i

(c)表示属于类别c的概率;c

i

表示类别标签置信度,表示预测的类别置信度。

[0098]

尽管已经示出和描述了本发明的实施例,对于本领域的普通技术人员而言,可以理解在不脱离本发明的原理和精神的情况下可以对这些实施例进行多种变化、修改、替换和变型,本发明的范围由所附权利要求及其等同范围限定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1