一种基于差分对比学习的深度图合成方法

1.本发明属于计算机视觉和计算机图形学领域,尤其涉及一种基于差分对比学习的真实深度图像合成方法。

背景技术:

2.随着图形学技术的发展和市场需求,已经有大量的开源三维模型数据集,其中就包括室外大场景的和室内场景的。利用三维模型数据集,人们可以通过渲染等方式,轻松得到一些可以应用于视觉任务的数据集,比如利用三维模型自带的类别标签,生成用于语义分割的数据集。而对于真实扫描的三维数据,首先需要通过算法重建出三维场景,这个过程往往会不够鲁棒;其次,对于物品类别这样的标签,则需要人为进行标记。在这样的背景下,很多方法开始探索如何将三维模型数据集有效应用到视觉任务上;但是由于渲染数据集与真实数据集之间存在着不可以避免的差别,在渲染数据集上表现好的方法无法直接应用到真实数据集上。因此,人们需要探索渲染数据集和真实数据集之间域的转换。

3.利用不配对数据集进行彩色图像域转换的各项工作已经在数字艺术领域取得了广泛的应用,然而对深度图像的转换目前还没有很有效的方法。在彩色图像上取得成功的方法,因为没有考虑到深度图像的几何结构,直接应用在深度图像上就会造成严重的几何形变。

4.对比学习的概念已经在自监督的表达学习各类方法中展现了它的能力,由于渲染数据集和真实数据集不存在匹配的数据,对比学习的方法在此情况下可以发挥优势。

技术实现要素:

5.本发明提供了一种具有高几何保持度的深度图合成方法,该方法可以让渲染得到的无噪声深度图具有真实扫描结果的特征,同时能够很好地保持原本几何结构。同时在利用渲染数据集进行真实扫描数据集上的深度图增强,语义分割和法向贴图估计的任务中,本发明得到的合成深度图均取得了最好的结果。

6.本发明是通过以下技术方案来实现的:

7.一种基于差分对比学习的真实深度图合成方法,通过一深度卷积神经网络g作为数据集映射的载体,将渲染合成的深度图和其对应的彩色图,映射合成为具有真实扫描深度图特征的合成深度图;其中,所述训练好的深度卷积神经网络g通过如下步骤训练获得:

8.步骤一:选取渲染得到的合成数据集d

s

={(d

s

,i

s

)}和一个真实扫描的数据集d

r

={(d

r

,i

r

)},其中,d和i分别表示为配对的深度图和彩色图。

9.步骤二:将步骤一获取的两个数据集输入至深度卷积神经网络g,并构建一判别器对深度卷积神经网络g进行训练,训练包括:

10.利用判别器对从合成数据集映射合成的合成深度图与真实扫描的数据集中的深度图d

r

进行判别,采用生成式对抗神经网络的方法以减小两个数据分布间的差异为目标进行训练;

11.利用深度卷积神经网络g中的编码器部分分别提取合成数据集的深度图d

s

和其对应的合成深度图的特征,并分别按位置两两相减计算差分,采用对比学习以减小合成数据集的深度图d

s

与其对应的合成深度图特征之间同样位置差分的相互差异为目标进行训练。

12.以减小深度卷积神经网络g对真实扫描的数据集中的深度图d

r

产生的无效映射为目标进行训练。

13.其中,渲染得到的合成数据集为通过渲染开源三维模型数据集获得,真实扫描的数据集为通过扫描仪等设备采集获得。

14.本发明利用训练好的深度卷积神经网络g,就可以将渲染的深度图像转化为具有真实扫描特征的深度图像,从而可以替代真实扫描深度图应用于深度图增强,语义分割和法相贴图等预测任务中。

15.进一步地,所述深度卷积神经网络g的网络结构采用resnet,unet等。

16.进一步地,利用判别器对从合成数据集映射合成的合成深度图与真实扫描的数据集中的深度图d

r

进行判别,以减小两个数据分布间的差异为目标进行训练,采用的目标函数具体为:

[0017][0018]

其中,表示判别器的输出;

[0019]

进一步地,利用深度卷积神经网络g中的编码器部分分别提取合成数据集的深度图d

s

和其对应的合成深度图的特征,并分别按位置两两相减计算差分,以减小合成数据集的深度图d

s

与其对应的合成深度图特征之间同样位置差分的相互差异为目标进行训练,具体为:

[0020]

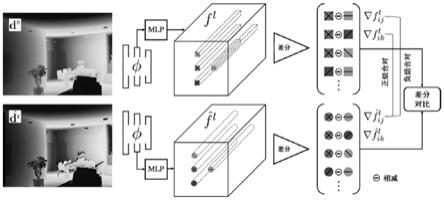

(a)利用深度卷积神经网络g编码器部分分别对合成数据集的深度图d

s

和其对应的合成深度图进行特征提取,并分别均匀抽取其中的n层的特征图。

[0021]

(b)对抽取出的每层特征图随机抽取区域块并两两相减计算差分,得到合成数据集的深度图d

s

和合成深度图对应的两个差分集合。

[0022]

(c)从步骤(b)中得到的两个差分集合中选择正组合对和负组合对,以最大化正组合对和负组合对之间的差异为目标进行训练。

[0023]

进一步地,所述步骤(c)中,正组合对和负组合对具体为:

[0024]

正组合对:

[0025]

负组合对:

[0026]

j≠k

[0027]

其中,表示从合成深度图中提取的第l层特征图的区域块,表示从合成数据集的深度图d

s

中提取的第l层特征图的区域块,i,j,k表示特征图的不同空间位置。

[0028]

以最大化正组合对和负组合对之间的差异为目标进行训练,采用的目标函数具体为:

[0029][0030]

其中,τ表示权重,e为能量函数。

[0031]

进一步地,以减小深度卷积神经网络g对真实扫描的数据集中的深度图d

r

产生的无效映射为目标进行训练,采用的目标函数具体为:

[0032][0033]

其中,φ()表示深度卷积神经网络g编码器部分的输出,ψ()表示深度卷积神经网络g解码器部分的输出,||||1表示正则化函数。

[0034]

本发明的突出贡献是:

[0035]

本发明提供了一种具有高几何保持度的深度图合成方法;与先前运用在深度图合成上会造成几何形变的彩色图像合成方法不同,本发明可以让渲染得到的无噪声深度图具有真实扫描结果的特征,同时能够很好地保持原本几何结构。本发明在神经网络的训练过程中是端到端的,无须分步骤进行。同时,本发明方法可以利用各种设备的采集数据作为训练数据,合成符合不同需求的深度图,训练无需做任何改动。在合成出具有真实扫描结果特征的深度图之后,本发明可以将该数据应用到真实扫描深度图增强,语义分割和法相贴图的预测任务中;且均取得了目前最好的效果。

附图说明

[0036]

图1是本发明提出的差分对比学习的示意图。

[0037]

图2是本发明合成深度图的效果图。

具体实施方式

[0038]

下面结合具体实施例和附图对本发明作进一步说明。

[0039]

获取真实扫描数据集为d

r

={(d

r

,i

r

)},并通过渲染开源的三维模型数据集获得合成数据集为d

s

={(d

s

,i

s

)},其中,d∈r

h

×

w

为一幅深度图,i∈r

h

×

w

×3为其对应的彩色图像,h

×

w表示图的像素大小。这两个数据集都包含对应的对齐好的深度图像和彩色图像,但是数据集d

s

和d

r

之间没有对应关系。本发明的目标是实现这两个数据集之间的映射,具体来说是从合成数据集d

s

到d

r

的单向特征转换映射。

[0040]

本发明用于完成特征转换映射的是一个深度卷积神经网络g,由编码器子网络φ和解码器子网络ψ串联构成。则由合成数据集d

s

合成出来的结果为合成深度图合成出来的结果为合成深度图首先,为了能够让合成深度图具有真实扫描深度图d

r

的特征,本发明采用了生成式对抗的策略来训练深度卷积神经网络g,即应用一个判别器神经网络来最小化生成结果和真实数据之间的域的差别。采用的目标函数为:

[0041][0042]

e表示能量函数,由于该目标目的是减小两个数据域之间的距离,并不能够保证输入和输出之间的一致性,更不能保证输出能够保持输入的几何结构。本发明引入了新的差分对比学习的策略。

[0043]

本发明中的差分对比学习策略,通过选取生成结果合成深度图和输入的渲染深度图d

s

中的块计算差分并进行对比,限制其变化来实现。首先,第一步本发明利用生成器网络即深度卷积神经网络g中的编码器子网络φ来分别提取和d

s

的特征图,选取其中的n层特征图,记录为其中l表示特征图中的第l层。接着,记是特征图f

l

中在位置i的一像素块;从特征图f

l

和中,本方法随机选取多对块作为正组合对和负组合对,同时正负组合对需要满足以下关系:

[0044]

正组合对:

[0045]

负组合对:

[0046]

j≠k

[0047]

其中,i,j,k表示特征图的不同空间位置。本发明中通过减小合成深度图和输入的渲染深度图d

s

中区域块差分的差异来获得两者上几何的一致性。在这个步骤中,本发明利用随机选择出来的正负组合对计算出和d

s

的差分信息误差,以最小化该误差为训练网络的目标:

[0048][0049]

其中,τ表示权重;对于所有随机选择出来的正负对,总的目标函数为:

[0050][0051]

此外,由于全局的偏移无法用以上阐述的局部块差分一致性来控制,本发明利用减小深度卷积神经网络g对真实扫描深度图d

r

产生的无效映射为训练网络的目标:

[0052][0053]

其中,||||1表示正则化函数。

[0054]

综上,对于训练特征映射神经网络g,本发明的总目标函数为:

[0055]

l=l

adv

+αl

dc

+βl

idt

[0056]

其中,α,β为权重。

[0057]

本实施例中深度卷积神经网络g采用通用的resnet网络结构,判别器神经网络d采用多层卷积神经网络构成,并设定α=1.5,β=1.0,最终训练出的深度卷积神经网络g在实验中达到了很好的效果。最终可以合成出如图2所示的效果;和左边的输入相比,本发明合成出来的深度图像没有产生几何形变,具有真实扫描深度图特征,可直接应用于语义分割和法相贴图的预测任务中。

[0058]

显然,上述实施例仅仅是为清楚地说明所作的举例,而并非对实施方式的限定。对于所属领域的普通技术人员来说,在上述说明的基础上还可以做出其他不同形式的变化或变动。这里无需也无法把所有的实施方式予以穷举。而由此所引申出的显而易见的变化或变动仍处于本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1