一种基于单目摄像头和激光雷达的测距方法与流程

1.本发明涉及智能驾驶技术领域,具体涉及一种基于单目摄像头和激光雷达的测距方法。

背景技术:

2.智能驾驶汽车是一种利用车载传感器,通过智能算法实现辅助驾驶甚至无人驾驶的汽车。车载传感器包括摄像头、毫米波雷达、超声波雷达、激光雷达、红外传感器等,各传感器之间独立收集周围环境信息,应用算法提取有用信息,将提取出来的有用信息进行融合,精准辅助汽车做出决策和控制,从而达到智能驾驶的目的。智能驾驶的关键技术包括感知、融合、决策、控制等,而测距是感知模块极其重要的一个环节,它能将障碍物的距离信息传给汽车决策和控制层,决策和控制层根据距离信息指导汽车做出避让、加速、减速、停止等一系列操作。智能驾驶发展至今,各种测距技术层出不穷,现有的技术包括基于激光雷达的测距和基于摄像头的测距,由于激光雷达的稀疏性和易受干扰性,以及摄像头测距的不准确性,两种测距方案各有弊端。例如,中国专利授权公告号:cn102353352a,公开了一种单摄像头测距系统及其测距方法,它包括摄像头,摄像头将场景成像信息转为图像数据并传输至控制器;摄像头安装在摄像头底座上,摄像头底座与直线轨道配合连接,摄像头底座上设置有一圆轴;拨动连杆一端设置有长方形槽,长方形槽套设在摄像头底座的圆轴上;拨动连杆的另一端固定在舵机的转动轴上;舵机实现平移摄像头的位置;控制器完成对摄像头图像数据信息的采集和存储,控制舵机带动拨动连杆在直线轨道内移动,实现带动摄像头移动;控制器与一通信接口进行信息交互,通信接口完成电平转换,控制器通过通信接口连接外部通信电路。虽然本发明通过单个可移动式摄像头就能实现原来两个摄像头所达到的测距效果,但测距精度不高,结果不可靠。

技术实现要素:

3.本发明主要是为了解决单独采用激光雷达或摄像头测距精度不高的问题,提供了一种基于单目摄像头和激光雷达的测距方法,充分结合单目摄像头和激光雷达的优点,融合目标检测模型和深度补全模型的输出结果,实现对象级测距,结果可靠,精度高。

4.为了实现上述目的,本发明采用以下技术方案:

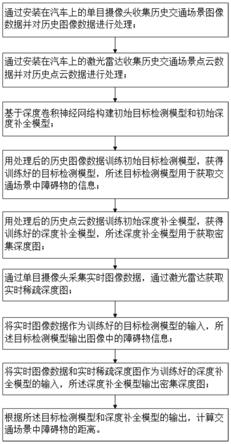

5.一种基于单目摄像头和激光雷达的测距方法,包括以下步骤:步骤s1)通过安装在汽车上的单目摄像头收集历史交通场景图像数据并对历史图像数据进行处理;步骤s2)通过安装在汽车上的激光雷达收集历史交通场景点云数据并对历史点云数据进行处理;步骤s3)基于深度卷积神经网络构建初始目标检测模型和初始深度补全模型;步骤s4)用处理后的历史图像数据训练初始目标检测模型,获得训练好的目标检测模型,所述目标检测模型用于获取交通场景中障碍物的信息;步骤s5)用处理后的历史点云数据训练初始深度补全模型,获得训练好的深度补全模型,所述深度补全模型用于获取密集深度图;步骤s6)通过单目摄像头采集实时图像数据,通过激光雷达获取实时稀疏深度图;步骤s7)将实时图像数

据作为训练好的目标检测模型的输入,所述目标检测模型输出图像中的障碍物信息;步骤s8)将实时图像数据和实时稀疏深度图作为训练好的深度补全模型的输入,所述深度补全模型输出密集深度图;步骤s9)根据所述目标检测模型和深度补全模型的输出,计算交通场景中障碍物的距离。智能驾驶的关键技术包括感知、融合、决策、控制等,而测距是感知模块极其重要的一个环节,它能将障碍物的距离信息传给汽车决策和控制层,决策和控制层根据距离信息指导汽车做出避让、加速、减速、停止等一系列操作。本发明结合单目摄像头和激光雷达实现对象级测距,其中,单目摄像头通过视觉测距可以弥补激光雷达的稀疏性和易受干扰性,而激光雷达可以弥补摄像头测距的不准确性,两者相辅相成实现高精度测距。具体包括以下步骤:首先在汽车上安装单目摄像头和激光雷达,用于收集历史交通场景图像数据和历史交通场景点云数据,分别对历史图像数据和历史点云数据进行处理获得图像训练集和点云训练集;然后基于端到端的深度卷积神经网络构建初始目标检测模型和初始深度补全模型,分别用图像训练集和点云训练集训练初始目标检测模型和初始深度补全模型,获得训练好的目标检测模型和深度补全模型;接着将单目摄像头实时采集的图像数据作为训练好的目标检测模型的输入,使目标检测模型输出图像中障碍物的信息,包括障碍物的类别、位置、大小;将激光雷达实时采集的点云数据进行处理获得实时稀疏深度图,然后将单目摄像头实时采集的图像数据和实时稀疏深度图作为训练好的深度补全模型的输入,使深度补全模型输出密集深度图;最后根据目标检测模型和深度补全模型的输出结果,计算交通场景中障碍物的距离,实现对象级测距,结果可靠,精度高,有助于推动智能驾驶汽车行业的发展。

6.作为优选,所述步骤s9中计算障碍物的距离具体包括以下步骤:步骤s91)根据目标检测模型的输出,首先判断交通场景中是否存在障碍物;若是,执行步骤s92;若否,返回执行步骤s6;步骤s92)判断标定的障碍物矩形框中是否有前框、侧框或整框,根据应用顺序确定应用的矩形框,所述应用顺序为前框、侧框、整框;步骤s93)将应用的矩形框投影到深度补全模型输出的密集深度图中,得到矩形框内障碍物所有像素点的深度值;步骤s94)生成矩形框分辨率大小的掩码矩阵,扫描矩形框,通过依次比较当前像素点与八邻域值的大小,划分出n个连通域;步骤s95)统计每个连通域的像素点个数,生成直方图a[n],所述直方图a[n]的组数为连通域的个数,所述直方图a[n]每组的频数为对应连通域的像素点个数;步骤s96)遍历直方图,计算频数最大的组a[b]对应的连通域中所有像素点的平均深度值,所述平均深度值为障碍物的距离。本发明融合目标检测模型和深度补全模型的输出结果,计算交通场景中障碍物的距离,实现对象级测距。具体包括以下过程:首先根据目标检测模型的输出,判断图像中是否有障碍物,如果没有障碍物,单目摄像头重新采集;如果有障碍物,判断障碍物是否存在前框、侧框或整框,如果存在前框,则应用前框测距;如果不存在前框存在侧框,则应用侧框测距;如果不存在前框、侧框,存在整框,则应用整框测距,即标定的矩形框应用顺序为前框、侧框、整框;将应用的矩形框投影到深度补全模型输出的密集深度图中,得到矩形框内障碍物所有像素点的深度值;然后生成矩形框分辨率大小的掩码矩阵,扫描矩形框,通过依次比较当前像素点与八邻域值的大小,将矩形框划分为n个连通域;然后统计每个连通域中像素点的个数,生成组数为连通域个数,每组频数为对应连通域的像素点个数的直方图a[n];最后遍历直方图a[n],计算频数最大的组a[b]对应的连通域中所有像素点的深度值的平均值,所述平均值即为待测障碍物的距离。

[0007]

作为优选,步骤s96中计算障碍物距离的公式为:其中,d表示障碍物的距离,m表示a[b]的频数,d

i

表示第i个像素点的深度值。本发明融合目标检测模型和深度补全模型的输出,实现对象级测距,其中,目标检测模型用于获取障碍物信息,所述深度补全模型用于获取密集深度图,根据获取的障碍物信息和密集深度图,计算直方图a[n]中频数最大的组a[b]对应的连通域中所有像素点的深度值的平均值,此平均值即为交通场景中待测障碍物的距离。

[0008]

作为优选,所述目标检测模型的生成过程具体包括以下步骤:步骤a1)在汽车上安装单目摄像头,收集历史交通场景图像数据;步骤a2)对收集的历史图像数据进行清洗,去除无效数据;步骤a3)利用数据标定工具对历史图像中的障碍物进行标定获得图像训练集;步骤a4)基于端到端的深度卷积神经网络,设计初始目标检测模型的基础网络结构,采用yolo v4作为初始目标检测模型的基础网络,将所有的常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;步骤a5)将清洗后的历史图像数据作为初始目标检测模型的输入,用图像训练集作为监督信号训练初始目标检测模型,采用随机梯度下降法进行优化获得训练好的目标检测模型。本发明通过目标检测模型获得交通场景中障碍物的信息,其中,生成目标检测模型的具体过程包括:首先通过设置在汽车上的单目摄像头收集历史交通场景图像数据,将历史交通场景图像数据进行清洗、标定,得到用于训练的图像训练集;基于端到端的深度卷积神经网络构建初始目标检测模型,采用yolo v4作为初始目标检测模型的基础网络,并将所有常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;最后,将清洗后的历史图像数据作为初始目标检测模型的输入,用图像训练集作为监督信号训练初始目标检测模型,采用随机梯度下降法进行优化获得训练好的目标检测模型。之所以将所有常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式,是因为本发明提出的基于单目摄像头和激光雷达的测距方案将运行在车规级的芯片上,就目前而言,芯片运算力有限,测距所属的感知模块必须综合考虑算法性能和速度。pointwise和depthwise的组合卷积模块相比于同深度同宽度的常规卷积,大大降低了目标检测模型的计算量,提升了目标检测模型的运算速度,而目标检测模型的性能没有受到太大的牺牲,适合用在车规级芯片上。而yolo v4网络既保证了速度,也保证了检测的精度,它将彩色图像作为初始目标检测模型的输入,标定的图像训练集作为监督信号,这种端到端的设计十分便于训练与优化。

[0009]

作为优选,所述深度补全模型的生成过程具体包括以下步骤:步骤b1)在汽车上安装激光雷达,收集历史交通场景点云数据;步骤b2)将收集的历史点云数据与步骤a2中清洗后的历史图像数据在时间域和空间域进行对齐,获得点云训练集;步骤b3)将对齐后的历史点云数据的深度值投影至像素坐标系获得与图像对应的历史稀疏深度图;步骤b4)基于端到端的深度卷积神经网络,设计初始深度补全模型的基础网络结构,所述基础网络结构为基于全卷积的psp net结构,将所有的常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;步骤b6)将清洗后的历史图像数据和历史稀疏深度图作为初始深度补全模型的输入,用点云训练集作为监督信号训练初始深度补全模型,采用随机梯度下降法进

行优化获得训练好的深度补全模型。本发明通过深度补全模型获得密集深度图,其中,生成深度补全模型的具体过程包括:首先通过设置在汽车上的激光雷达收集历史交通场景点云数据,将历史交通场景点云数据与清洗后的历史图像数据在时间域和空间域进行对齐,得到用于训练的点云训练集,并将对齐后的历史点云数据的深度值投影至像素坐标系获得历史稀疏深度图;基于端到端的深度卷积神经网络构建初始深度补全模型,采用基于全卷积的psp net结构作为初始深度补全模型的基础网络结构,并将所有常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;最后,将清洗后的历史图像数据和在历史稀疏深度图作为初始深度补全模型的输入,用点云训练集作为监督信号训练初始深度补全模型,采用随机梯度下降法进行优化获得训练好的深度补全模型,同时,采用focalloss损失函数对深度补全模型梯度进行更新。将所有常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式,其目的同样是为了降低深度补全模型的计算量,使其适用于车规级芯片。深度补全不仅需要高层语义信息,也需要精细的位置信息,psp模块融合了不同尺寸的特征信息,保证了高层语义信息和精细的位置信息结合,有助于生成准确的密集深度图。

[0010]

作为优选,对单目摄像头和激光雷达进行标定,得到单目摄像头和激光雷达的内、外参数。本发明在生成深度补全模型的过程中,需要基于单目摄像头、激光雷达的内、外参数,将历史点云数据与步骤a2中清洗后的历史图像数据在时间域和空间域进行对齐。

[0011]

作为优选,所述交通场景包括不同道路、不同天气、不同光照的交通场景。汽车上路收集历史交通场景图像数据和历史交通场景点云数据时,需要收集各种交通场景的数据,交通场景应包括不同的道路、不同的天气、不同的光照等,尽可能覆盖全面,同时,每种状态的交通场景数据的数量应保持相对均衡,有助于生成可靠有效的目标检测模型和深度补全模型,提高测距精度。

[0012]

作为优选,步骤a2中对收集的历史图像数据进行清洗是指过滤掉模糊的或被遮挡的无效图像数据。清洗收集的历史图像数据是指过滤掉外观模糊数据和被严重遮挡的数据,包括逆光、摄像头遮挡、严重模糊等无效数据。后续历史点云数据需要与清洗后的历史图像数据在时间域和空间域进行对齐,即一张图像被清洗掉,对应的激光点云数据也被丢弃。

[0013]

作为优选,所述标定是指将图像数据需要测距的对象标定出来,标定方式为伪3d标定,标定得到的矩形框包括前框、侧框和整框。同时,本发明提出的目标检测模型输出的矩形框为伪3d形式,矩形框的属性除了障碍物类别,还有子类别,子类别包括前框、侧框和整框,三个矩形框完整描述了车辆的伪3d信息。测距任务因其特殊性,测量的距离为其它行驶车辆离当前车辆的最近距离,即前框的距离;当车辆没有前框时,即车辆相对于当前车辆为横向行车,测量的是侧面离当前车辆的距离,即侧框的距离。一个3d车辆的标定矩形框包括其前框(相向而行的车的前框即车尾,对向而行的车的前框即车头)、侧框(侧面根据实际情况标定,视图中不存在车辆侧面则不标定侧框)、整框(整个车辆的最小外接矩形框),其它对象的标定方式与车辆的标定方式一样。

[0014]

因此,本发明的优点是:(1)充分结合单目摄像头和激光雷达的优点,融合目标检测模型和深度补全模型的输出结果,实现对象级测距,结果可靠,精度高;

(2)单目摄像头通过视觉测距可以弥补激光雷达的稀疏性和易受干扰性,而激光雷达可以弥补摄像头测距的不准确性,两者相辅相成实现高精度测距,有助于推动智能驾驶行业的发展;(3)将所有常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式,可以降低目标检测模型和深度补全模型的计算量,适用于车规级芯片。

附图说明

[0015]

图1是本发明实施例的流程图。

[0016]

图2是本发明实施例中生成目标检测模型的流程图。

[0017]

图3是本发明实施例中生成深度补全模型的流程图。

[0018]

图4是本发明实施例中划分连通域的结构示意图。

[0019]

图5是本发明实施例中标定障碍物矩形框的结构示意图。

具体实施方式

[0020]

下面结合附图与具体实施方式对本发明做进一步的描述。

[0021]

如图1所示,一种基于单目摄像头和激光雷达的测距方法,包括以下步骤:步骤s1)通过安装在汽车上的单目摄像头收集历史交通场景图像数据并对历史图像数据进行处理;步骤s2)通过安装在汽车上的激光雷达收集历史交通场景点云数据并对历史点云数据进行处理;步骤s3)基于深度卷积神经网络构建初始目标检测模型和初始深度补全模型;步骤s4)用处理后的历史图像数据训练初始目标检测模型,获得训练好的目标检测模型,目标检测模型用于获取交通场景中障碍物的信息;步骤s5)用处理后的历史点云数据训练初始深度补全模型,获得训练好的深度补全模型,深度补全模型用于获取密集深度图;步骤s6)通过单目摄像头采集实时图像数据,通过激光雷达获取实时稀疏深度图;步骤s7)将实时图像数据作为训练好的目标检测模型的输入,目标检测模型输出图像中的障碍物信息;步骤s8)将实时图像数据和实时稀疏深度图作为训练好的深度补全模型的输入,深度补全模型输出密集深度图;步骤s9)根据目标检测模型和深度补全模型的输出,计算交通场景中障碍物的距离。智能驾驶的关键技术包括感知、融合、决策、控制等,而测距是感知模块极其重要的一个环节,它能将障碍物的距离信息传给汽车决策和控制层,决策和控制层根据距离信息指导汽车做出避让、加速、减速、停止等一系列操作。本发明结合单目摄像头和激光雷达实现对象级测距,其中,单目摄像头通过视觉测距可以弥补激光雷达的稀疏性和易受干扰性,而激光雷达可以弥补摄像头测距的不准确性,两者相辅相成实现高精度测距。具体包括以下步骤:首先在汽车上安装单目摄像头和激光雷达,用于收集历史交通场景图像数据和历史交通场景点云数据,分别对历史图像数据和历史点云数据进行处理获得图像训练集和点云训练集;然后基于端到端的深度卷积神经网络构建初始目标检测模型和初始深度补全模型,分别用图像训练集和点云训练集训练初始目标检测模型和初始深度补全模型,获得训练好的目标检测模型和深度补全模型;接着将单目摄像头实时采集的图像数据作为训练好的目标检测模型的输入,使目标检测模型输出图像中障碍物的信息,包括障碍物的类别、位置、大小;将激光雷达实时采集的点云数据进行处理得到实时稀疏深度图,然后将单目摄像头实时采集的图像数据和实时稀疏深度图作为训练好的深度补全模型的输入,使深度补全

模型输出密集深度图;最后根据目标检测模型和深度补全模型的输出结果,计算交通场景中障碍物的距离,实现对象级测距。

[0022]

步骤s9中计算障碍物的距离具体包括以下步骤:步骤s91)根据目标检测模型的输出,首先判断交通场景中是否存在障碍物;若是,执行步骤s92;若否,返回执行步骤s6;步骤s92)判断标定的障碍物矩形框中是否有前框、侧框或整框,根据应用顺序确定应用的矩形框,应用顺序为前框、侧框、整框;步骤s93)将应用的矩形框投影到深度补全模型输出的密集深度图中,得到矩形框内障碍物所有像素点的深度值;步骤s94)生成矩形框分辨率大小的掩码矩阵,扫描矩形框,通过依次比较当前像素点与八邻域值的大小,划分出n个连通域;步骤s95)统计每个连通域的像素点个数,生成直方图a[n],直方图a[n]的组数为连通域的个数,直方图a[n]每组的频数为对应连通域的像素点个数;步骤s96)遍历直方图,计算频数最大的组a[b]对应的连通域中所有像素点的平均深度值,平均深度值为障碍物的距离。本发明融合目标检测模型和深度补全模型的输出结果,计算交通场景中障碍物的距离,实现对象级测距。具体包括以下过程:首先根据目标检测模型的输出,判断图像中是否有障碍物,如果没有障碍物,单目摄像头重新采集;如果有障碍物,判断障碍物是否存在前框、侧框或整框,如果存在前框,则应用前框测距;如果不存在前框存在侧框,则应用侧框测距;如果不存在前框、侧框,存在整框,则应用整框测距,即标定的矩形框应用顺序为前框、侧框、整框;将应用的矩形框投影到深度补全模型输出的密集深度图中,得到矩形框内障碍物所有像素点的深度值;然后生成矩形框分辨率大小的掩码矩阵,扫描矩形框,通过依次比较当前像素点与八邻域值的大小,将矩形框划分为n个连通域;然后统计每个连通域中像素点的个数,生成组数为连通域个数,每组频数为对应连通域的像素点个数的直方图a[n];最后遍历直方图a[n],计算频数最大的组a[b]对应的连通域中所有像素点的深度值的平均值,平均值即为待测障碍物的距离。如图4(a)所示,扫描矩形框,依次比较当前像素点与八邻域值的深度值大小,划分出4个连通域,如图4(b)所示,4个连通域对应的掩码值依次为0、1、2、3,图4(b)为图4(a)对应的掩码图;然后统计每个连通域中像素点的个数,如图4(b)所示,掩码值0、1、2、3对应的连通域的像素点个数分别为11、17、3、5,生成直方图a[4],直方图a[4]的组数为4,每组的频数依次为11、17、3、5,遍历直方图a[4],可知a[1]最大,为17;最后计算掩码值1对应的连通域中17个像素点的平均深度值,此平均深度值即为待测障碍物的距离。

[0023]

步骤s96中计算障碍物距离的公式为:其中,d表示障碍物的距离,m表示a[b]的频数,d

i

表示第i个像素点的深度值。本发明融合目标检测模型和深度补全模型的输出,实现对象级测距,其中,目标检测模型用于获取障碍物信息,深度补全模型用于获取密集深度图,根据获取的障碍物信息和密集深度图,计算直方图a[n]中频数最大的组a[b]对应的连通域中所有像素点的深度值的平均值,此平均值即为交通场景中待测障碍物的距离。

[0024]

如图2所示,目标检测模型的生成过程具体包括以下步骤:步骤a1)在汽车上安装单目摄像头,收集历史交通场景图像数据;步骤a2)对收集的历史图像数据进行清洗,去除无效数据;步骤a3)利用数据标定工具对历史图像中的障碍物进行标定获得图像训练集;步

骤a4)基于端到端的深度卷积神经网络,设计初始目标检测模型的基础网络结构,采用yolo v4作为初始目标检测模型的基础网络,将所有的常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;步骤a5)将清洗后的历史图像数据作为初始目标检测模型的输入,用图像训练集作为监督信号训练初始目标检测模型,采用随机梯度下降法进行优化获得训练好的目标检测模型。本发明通过目标检测模型获得交通场景中障碍物的信息,其中,生成目标检测模型的具体过程包括:首先通过设置在汽车上的单目摄像头收集历史交通场景图像数据,将历史交通场景图像数据进行清洗、标定,得到用于训练的图像训练集;基于端到端的深度卷积神经网络构建初始目标检测模型,采用yolo v4作为初始目标检测模型的基础网络,并将所有常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;最后,将清洗后的历史图像数据作为初始目标检测模型的输入,用图像训练集作为监督信号训练初始目标检测模型,采用随机梯度下降法进行优化获得训练好的目标检测模型。

[0025]

如图3所示,深度补全模型的生成过程具体包括以下步骤:步骤b1)在汽车上安装激光雷达,收集历史交通场景点云数据;步骤b2)将收集的历史点云数据与步骤a2中清洗后的历史图像数据在时间域和空间域进行对齐,获得点云训练集;步骤b3)将对齐后的历史点云数据的深度值投影至像素坐标系获得与图像对应的历史稀疏深度图;步骤b5)基于端到端的深度卷积神经网络,设计初始深度补全模型的基础网络结构,基础网络结构为基于全卷积的psp net结构,将所有的常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;步骤b6)将清洗后的历史图像数据和历史稀疏深度图作为初始深度补全模型的输入,用点云训练集作为监督信号训练初始深度补全模型,采用随机梯度下降法进行优化获得训练好的深度补全模型。本发明通过深度补全模型获得密集深度图,其中,生成深度补全模型的具体过程包括:首先通过设置在汽车上的激光雷达收集历史交通场景点云数据,将历史交通场景点云数据在时间域和空间域进行对齐,得到用于训练的点云训练集,并将对齐后的历史点云数据的深度值投影至像素坐标系获得与图像对应的历史稀疏深度图;基于端到端的深度卷积神经网络构建初始深度补全模型,采用基于全卷积的psp net结构作为初始深度补全模型的基础网络结构,并将所有常规卷积替换成mobilenet的pointwise和depthwise的组合卷积形式;最后,将清洗后的历史图像数据和历史稀疏深度图作为初始深度补全模型的输入,用点云训练集作为监督信号训练初始深度补全模型,采用随机梯度下降法进行优化获得训练好的深度补全模型,同时,采用focalloss损失函数对深度补全模型梯度进行更新。

[0026]

对单目摄像头和激光雷达进行标定,得到单目摄像头和激光雷达的内、外参数。本发明在生成深度补全模型的过程中,需要基于单目摄像头、激光雷达的内、外参数,将历史点云数据与步骤a2中清洗后的历史图像数据在时间域和空间域进行对齐。

[0027]

交通场景包括不同道路、不同天气、不同光照的交通场景。汽车上路收集历史交通场景图像数据和历史交通场景点云数据时,需要收集各种交通场景的数据,交通场景应包括不同的道路、不同的天气、不同的光照等,尽可能覆盖全面,同时,每种状态的交通场景数据的数量应保持相对均衡。

[0028]

步骤a2中对收集的历史图像数据进行清洗是指过滤掉模糊的或被遮挡的无效图像数据。清洗收集的历史图像数据是指过滤掉外观模糊数据和被严重遮挡的数据,包括逆光、摄像头遮挡、严重模糊等无效数据。后续历史点云数据需要与清洗后的历史图像数据在

时间域和空间域进行对齐,即一张图像被清洗掉,对应的激光点云数据也被丢弃。

[0029]

标定是指将图像数据需要测距的对象标定出来,标定方式为伪3d标定,标定得到的矩形框包括前框、侧框和整框。同时,本发明提出的目标检测模型输出的矩形框为伪3d形式,矩形框的属性除了障碍物类别,还有子类别,子类别包括前框、侧框和整框,三个矩形框完整描述了车辆的伪3d信息。测距任务因其特殊性,测量的距离为其它行驶车辆离当前车辆的最近距离,即前框的距离;当车辆没有前框时,即车辆相对于当前车辆为横向行车,测量的是侧面离当前车辆的距离,即侧框的距离。一个3d车辆的标定矩形框包括其前框(相向而行的车的前框即车尾,对向而行的车的前框即车头)、侧框(侧面根据实际情况标定,视图中不存在车辆侧面则不标定侧框)、整框(整个车辆的最小外接矩形框),其它对象的标定方式与车辆的标定方式一样。如图5所示,abdc为该目标车辆的前框,cdfe为该目标车辆的侧框,abge为该目标车辆的整框,目标检测模型只需回归出7个点(abcdefg)的坐标,即可完整描述该目标车辆的伪3d信息。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1