害虫识别方法及装置、学习数据生成方法及装置与流程

1.本技术实施例涉及图像识别技术领域,尤其涉及一种害虫识别方法及装置、学习数据生成方法及装置。

背景技术:

2.随着智能农业的发展,对作物害虫进行自动化调查的需求越来越迫切。在农业生产中,通常采用诱虫板对农场、温室大棚或田间的害虫进行吸引和粘附。通过对粘附有害虫的诱虫板的图像进行图像识别,能够获取该区域中的害虫的相关信息。

3.另一方面,在智能交通、智慧医疗等领域中,可以利用神经网络模型对待处理图像中的目标进行检测。其中,该神经网络模型是利用学习数据进行训练后得到的模型。

4.应该注意,上面对技术背景的介绍只是为了方便对本技术的技术方案进行清楚、完整的说明,并方便本领域技术人员的理解而阐述,不能仅仅因为这些方案在本技术的背景技术部分进行了阐述而认为上述技术方案为本领域技术人员所公知。

技术实现要素:

5.发明人发现:神经网络模型通常对待处理图像的尺寸有相应的限制,例如,神经网络模型只能处理规定尺寸的图像,或者,不同的神经网络能够处理的图像的尺寸不同。通常要将待处理图像缩放至神经网络模型能够处理的尺寸,再利用神经网络模型对缩放后的图像进行识别。

6.但是,如果利用神经网络模型对粘附有害虫的诱虫板的图像进行图像识别,由于害虫尺寸较小,在对图像进行缩放处理的情况下,这会导致微小害虫的图像信息的损失,因此,容易引起目标的漏检或误检。

7.此外,待处理图像通常包括诱虫板图像区域和非诱虫板图像区域。如果不对该诱虫板图像区域和非诱虫板图像区域进行区分,容易造成目标的误检。

8.针对上述技术问题的至少之一,本技术实施例提供一种害虫识别方法及装置、学习数据生成方法及装置。通过将待处理图像数据划分为诱虫板图像区域和背景图像区域、利用滑动窗口对划分后的待处理图像进行采样、利用神经网络对采样得到的图像进行识别,能够避免对目标的漏检和误检,提高了害虫识别的准确率。

9.根据本技术实施例的一个方面,提供一种害虫识别方法,其中,所述方法包括:

10.将待处理图像数据划分为与诱虫板对应的诱虫板图像区域和背景图像区域,并将所述背景图像区域内的像素设置为第一值,得到第一图像数据;

11.对所述第一图像数据进行滑动窗口采样,得到多个第二图像数据;以及

12.利用神经网络模型对所述多个第二图像数据进行识别,确定每个第二图像数据中的害虫的位置信息和/或类型信息。

13.根据本技术实施例的另一个方面,提供一种害虫识别装置,其中,所述装置包括:

14.第一图像处理部,其将待处理图像数据划分为与诱虫板对应的诱虫板图像区域和

背景图像区域,并将所述背景图像区域内的像素设置为第一值,得到第一图像数据;

15.第二图像处理部,其对所述第一图像数据进行滑动窗口采样,得到多个第二图像数据;以及

16.识别部,其利用神经网络模型对所述多个第二图像数据进行识别,确定每个第二图像数据中的害虫的位置信息和/或类型信息。

17.根据本技术实施例的另一个方面,提供一种学习数据生成方法,其中,所述方法包括:

18.对获取的诱虫板图像进行预处理得到背景图像;

19.对获取的害虫图像进行预处理得到前景图像;以及

20.对所述背景图像与所述前景图像进行合成以生成学习数据,

21.其中,所述学习数据包括:由所述背景图像与所述前景图像合成得到的合成图像、所述前景图像在所述背景图像中的方位信息、所述前景图像的尺寸信息以及所述前景图像对应的害虫的类型信息。

22.根据本技术实施例的另一个方面,提供一种学习数据生成装置,其中,所述装置包括:

23.第一处理部,其对获取的诱虫板图像进行预处理得到背景图像;

24.第二处理部,其对获取的获取害虫图像,对所述害虫图像进行预处理得到前景图像;以及

25.第三处理部,其对所述背景图像与所述前景图像进行合成以生成学习数据,

26.其中,所述学习数据包括:由所述背景图像与所述前景图像合成得到的合成图像、所述前景图像在所述背景图像中的方位信息、所述前景图像的尺寸信息以及所述前景图像对应的害虫的类型信息。

27.本技术实施例的有益效果之一在于:通过将待处理图像数据划分为诱虫板图像区域和背景图像区域、利用滑动窗口对划分后的待处理图像进行采样、利用神经网络对采样得到的图像进行识别,能够避免对目标的漏检和误检,提高了害虫识别的准确率。

28.参照后文的说明和附图,详细公开了本技术实施例的特定实施方式,指明了本技术实施例的原理可以被采用的方式。应该理解,本技术的实施方式在范围上并不因而受到限制。在所附权利要求的精神和条款的范围内,本技术的实施方式包括许多改变、修改和等同。

附图说明

29.所包括的附图用来提供对本技术实施例的进一步的理解,其构成了说明书的一部分,用于例示本技术的实施方式,并与文字描述一起来阐释本技术的原理。显而易见地,下面描述中的附图仅仅是本技术的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的实施方式。在附图中:

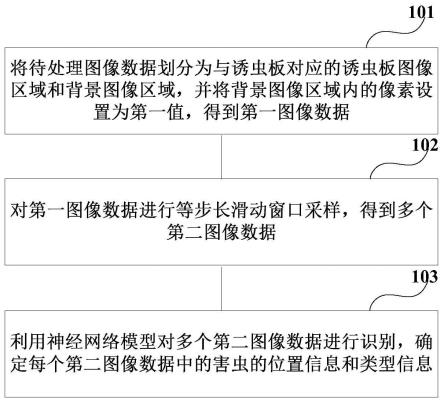

30.图1是本技术实施例的害虫识别方法的一示意图;

31.图2是本技术实施例的害虫识别方法的另一示意图;

32.图3是本技术实施例的待处理图像的一示意图;

33.图4是本技术实施例的第一图像的一示意图;

34.图5是本技术实施例的步骤101的一示意图;

35.图6是本技术实施例的步骤102的一示意图;

36.图7是本技术实施例滑动窗口采样操作的一示意图;

37.图8是本技术实施例的识别结果的一示意图;

38.图9是本技术实施例的图像合并的一示意图;

39.图10是本技术实施例的学习数据生成方法的一示意图;

40.图11是本技术实施例的学习数据生成操作的一示意图;

41.图12是本技术实施例的的步骤201的一示意图;

42.图13是本技术实施例的生成背景图像的一示意图;

43.图14是本技术实施例的步骤202的一示意图;

44.图15是本技术实施例的生成前景图像的一示意图;

45.图16是本技术实施例的步骤203的一示意图;

46.图17是本技术实施例的生成合成图像的一示意图;

47.图18是本技术实施例的害虫识别装置的一示意图;

48.图19是本技术实施例的学习数据生成方法的一示意图;

49.图20是本技术实施例的学习数据生成装置的一示意图;

50.图21是本技术实施例的神经网络模型的训练方法的一示意图;

51.图22是本技术实施例的神经网络模型的训练装置的一示意图;

52.图23是本技术实施例的电子设备的示意图。

具体实施方式

53.参照附图,通过下面的说明书,本技术实施例的前述以及其它特征将变得明显。在说明书和附图中,具体公开了本技术的特定实施方式,其表明了其中可以采用本技术实施例的原则的部分实施方式,应了解的是,本技术不限于所描述的实施方式,相反,本技术实施例包括落入所附权利要求的范围内的全部修改、变型以及等同物。

54.在本技术实施例中,术语“第一”、“第二”等用于对不同元素从称谓上进行区分,但并不表示这些元素的空间排列或时间顺序等,这些元素不应被这些术语所限制。术语“和/或”包括相关联列出的术语的一种或多个中的任何一个和所有组合。术语“包含”、“包括”、“具有”等是指所陈述的特征、元素、元件或组件的存在,但并不排除存在或添加一个或多个其他特征、元素、元件或组件。

55.在本技术实施例中,单数形式“一”、“该”等包括复数形式,应广义地理解为“一种”或“一类”而并不是限定为“一个”的含义;此外术语“所述”应理解为既包括单数形式也包括复数形式,除非上下文另外明确指出。此外术语“根据”应理解为“至少部分根据

……”

,术语“基于”应理解为“至少部分基于

……”

,除非上下文另外明确指出。

56.针对一种实施方式描述和/或示出的特征可以以相同或类似的方式在一个或更多个其它实施方式中使用,与其它实施方式中的特征相组合,或替代其它实施方式中的特征。术语“包括/包含”在本文使用时指特征、整件、步骤或组件的存在,但并不排除一个或更多个其它特征、整件、步骤或组件的存在或附加。

57.第一方面的实施例

58.本技术实施例提供一种害虫识别方法。图1是本技术实施例的害虫识别方法的一示意图,如图1所示,该方法包括:

59.101,将待处理图像数据划分为与诱虫板对应的诱虫板图像区域和背景图像区域,并将背景图像区域内的像素设置为第一值,得到第一图像数据;

60.102,对第一图像数据进行滑动窗口采样,得到多个第二图像数据;以及

61.103,利用神经网络模型对多个第二图像数据进行识别,确定每个第二图像数据中的害虫的位置信息和/或类型信息。

62.根据本技术实施例,通过将待处理图像数据划分为诱虫板图像区域和背景图像区域、利用滑动窗口对划分后的待处理图像进行采样、利用神经网络对采样得到的图像进行识别,能够对粘附有害虫的诱虫板的图像进行图像识别,并且不会导致微小害虫的图像信息的损失,从而能够避免对目标的漏检和误检,提高了害虫识别的准确率。

63.值得注意的是,以上附图1仅示意性地对本技术实施例进行了说明,但本技术不限于此。例如可以适当地调整各个操作之间的执行顺序,此外还可以增加其他的一些操作或者减少其中的某些操作。本领域的技术人员可以根据上述内容进行适当地变型,而不仅限于上述附图1的记载。

64.在一些实施例中,位置信息可以是表示害虫在第二图像数据中的位置的信息;类型信息可以是表示害虫的类型的信息,例如,害虫的类型可以为白粉虱、蓟马等等,类型信息可以为害虫的类型的索引号,例如,索引号0表示白粉虱,索引号1表示蓟马,索引号2表示其他害虫,等等。

65.图2是本技术实施例的害虫识别方法的另一示意图,如图2所示,该方法还包括:

66.201,接收利用电子设备拍摄并发送的待处理图像数据。

67.在一些实施例中,待处理图像可以是粘附有害虫的诱虫板的图像,例如,可以是利用电子设备(客户端)拍摄的在实际场景(例如,农场、大棚、田地等)中的诱虫板的图像。

68.在一些实施例中,客户端可以通过相机设备采集待处理图像;客户端将采集的图像数据,通过文件方式发送给服务器端,并请求算法服务;服务器接收到客户端的图像数据,对其进行ai算法处理;服务器向客户端(移动客户端、web等)发送检测结果。

69.此外,客户端还可以通过应用程序、微信小程序等采集或发送待处理图像数据。客户端也可以通过应用程序、微信小程序等在待处理图像数据中附加包含待处理图像数据的相关信息的二维码,该相关信息可以包括采集地点、采集时间等。服务器还可以根据虫害的检测结果进行可视化的分析,例如,生成虫害计数信息图表、虫害种类分布图表、虫害分布热力图等。

70.如图2所示,该方法还可以包括:

71.202,将待处理图像数据划分为与诱虫板对应的诱虫板图像区域和背景图像区域,并将背景图像区域内的像素设置为第一值,得到第一图像数据;

72.203,对第一图像数据进行滑动窗口采样,得到多个第二图像数据;以及

73.204,利用神经网络模型对多个第二图像数据进行识别,确定每个第二图像数据中的害虫的位置信息和/或类型信息。

74.其中,步骤202-204与步骤101-103相同,此处不再赘述。

75.图3是本技术实施例的待处理图像的一示意图。如图3所示,该待处理图像数据a可

以划分为与诱虫板对应的诱虫板图像区域a1和背景图像区域a2。图4是本技术实施例的第一图像的一示意图。通过将待处理图像a中的背景图像区域a2的像素值设置为第一值,从而生成第一图像数据b。

76.如图3和图4所示,第一图像数据b中的诱虫板图像区域b1的像素值可以与待处理图像数据a中的诱虫板图像区域a1的像素值相同;第一图像数据b中的背景图像区域b2的像素可以是将待处理图像数据a中背景图像区域a2中的像素的值设置为第一值而得到的。

77.例如,如图4所示,可以将背景图像区域a2中的像素置零。但是,本技术不限于此,该第一值也可以是其他值,只要能够与诱虫板图像区域b1中的像素进行区分即可。

78.在本实施例中,由于在生成待处理图像时,在不同的拍摄条件(例如,不同设备和/或不同距离和/或不同角度等)下,图像的成像范围会出现差异,因此,通过区分待处理图像数据中的诱虫板图像数据和背景图像数据,能够排除背景图像数据的干扰,能够避免对害虫的误检。

79.在一些实施例中,由于诱虫板通常是单一颜色的,例如,黄色,因此,可以利用色彩对待处理图像数据中的诱虫板图像数据和背景图像数据进行区分而生成第一图像。

80.图5是本技术实施例的步骤101或步骤202的一示意图。如图5所示,步骤101或202可以通过如下方式实现:

81.1011,将待处理图像转化为hsv空间;

82.1012,根据预设颜色进行二值化处理;

83.1013,寻找面积最大的图像连通域并去除其他连通域;

84.1014,在最大连通域外部进行浸水填充处理;以及

85.1015,将最大连通域外部的像素置零,作为背景区域,从而得到第一图像数据。

86.其中,步骤1011的具体转化方式、步骤1013的寻找图像连通区域的方式以及步骤1014的浸水填充处理的方式均可参照相关技术。

87.在步骤1012中,可以将黄色区域标记为1,将其他颜色的区域标记为0。但是,本技术不限于此,只要是两个能够相互区分的值即可。

88.在一些实施例中,在步骤102或203中,可以对第一图像数据进行等步长滑动窗口采样,由此,能够得到尺寸相同的多个第二图像数据。由于在生成待处理图像时,在不同的拍摄条件(例如,不同设备和/或不同距离和/或不同角度等)下,图像的成像特点会出现差异,通过将第一图像数据转换为多个尺寸相同的第二图像数据,因此,即便图像的成像特点不同,也不需要对图像进行缩放处理,能够不损失图像中的信息,避免对微小害虫的漏检和误检。

89.在一些实施例中,可以根据神经网络模型的参数确定在滑动窗口采样中使用的窗口的尺度。由此,神经网络模型能够直接对第二图像进行处理,避免由于缩放图像造成信息损失。

90.图6是本技术实施例的步骤102或203的一示意图,图7是本技术实施例滑动窗口采样操作的一示意图。如图6所示,步骤102或203可以通过如下方式实现:

91.1021,在第一图像数据中设置滑动窗口;

92.例如,如图7所示,可以在第一图像数据b中的任意位置开始设置滑动窗c1。

93.1022,裁剪滑动窗口对应的图像数据作为第二图像数据。

94.例如,如图7所示,可以对第一图像数据b中的滑动窗c1对应的像素所构成的子图像进行裁剪,将该裁剪出的图像作为第二图像数据d。

95.其中,步骤1021的设置滑动窗口的方式以及步骤1022中裁剪图像的方式可以参照相关技术。在步骤1021中,如图7所示,可以将第一图像数据b中的背景图像数据去除,例如,将诱虫板图像数据裁剪出来,仅在该诱虫板图像数据中进行采样。但是,本技术不限于此,也可以不进行上述裁剪操作。

96.此外,如图7所示,在裁剪得到第二图像数据d之后,可以将滑动窗c1移动到滑动窗c2的位置,并进行与步骤1021和步骤1022类似的操作,直到对第一图像数据的全部范围都进行了采样。

97.在一些实施例中,还可以对第一图像数据和/或第二图像数据进行图像处理,例如,去噪处理、对比度增强处理等。由此,能够更有利于后续对第二图像数据进行识别。

98.在一些实施例中,在步骤103或204中,可以利用神经网络模型对第二图像数据中的害虫(识别对象)进行逐个定位(生成位置信息)、大小估算(生成大小信息)以及类别推理(生成类别信息)。其中,利用神经网络模型对第二图像数据中的害虫进行识别的方式可以参照相关技术。

99.在一些实施例中,如图2所示,害虫识别方法还可以包括:

100.205,在第二图像数据中示出位置信息和/或类型信息。

101.图8是本技术实施例的识别结果的一示意图。如图8所示,可以在第二图像数据d中示出位置信息和类型信息。例如,将识别出的害虫利用矩形框圈出,并在矩形框上标注对应害虫的类型信息。但是,本技术不限于此,也可以采用其他的方式示出位置信息和类型信息。

102.此外,神经网络模型还可以输出反映害虫的尺寸的信息以及反映识别结果的可靠性的信息等。例如,神经网络模型还可以输出如下形式的信息:[识别对象索引号,矩形框中心列坐标/第二图像宽度,矩形框中心行坐标/第二图像高度,矩形框宽度/第二图像宽度,矩形框高度/第二图像高度,类别索引号,置信度水平]。

[0103]

其中,矩形框中心列坐标/第二图像宽度和矩形框中心行坐标/第二图像高度为位置信息,矩形框宽度/第二图像宽度和矩形框高度/第二图像高度为大小信息,类别索引号为类别信息,置信度水平反映矩形框内的目标该类别的害虫的可靠性的高低。

[0104]

在一些实施例中,如图2所示,害虫识别方法还可以包括:

[0105]

206,根据第二图像数据在第一图像数据中的定位信息,对示出位置信息和/或类型信息的第二图像数据进行合并。例如,可以根据第二图像数据、第一图像数据的宽度、高度以及第二图像数据在第一图像数据下的坐标等信息,来进行合并操作。

[0106]

图9是本技术实施例的图像合并的一示意图。例如,如图9所示,可以根据第二图像数据d在第一图像数据b中的定位信息,生成在第一图像数据b的坐标系下的第二图像数据d的坐标,根据该坐标将多个第二图像数据d进行合并。但是,本技术不限于此,也可以根据其他方式对第二图像数据进行合并。

[0107]

其中,第二图像数据在第一图像数据中的定位信息可以是在步骤102或203中生成的表示第二图像数据在第一图像数据中的位置的信息,即,在步骤102或203中,在对第一图像数据进行裁剪生成第二图像数据时,还可以生成第二图像数据在第一图像数据中的定位

信息。

[0108]

通过将附加有位置信息和/或类型信息的第二图像数据进行坐标系统合,能够得到附加有位置信息和/或类型信息的第一图像数据。从而能够更加直观地示出诱虫板上粘附的害虫的位置和类型,有利于用户方便地获取害虫的相关信息。

[0109]

在一些实施例中,神经网络模型可以是利用学习数据进行训练得到的神经网络模型。图10是本技术实施例的学习数据生成方法的一示意图,图11是本技术实施例的学习数据生成操作的一示意图。如图10所示,学习数据可以通过如下方式生成:

[0110]

1001,对获取的诱虫板图像进行预处理得到背景图像,背景图像例如是图11中示出的虚线框区域对应的图像;

[0111]

1002,对获取的害虫图像进行预处理得到前景图像,前景图像例如是图11中示出的害虫1图像和害虫2图像;以及

[0112]

1003,对背景图像与前景图像进行合成以生成学习数据。

[0113]

其中,如图11所示,学习数据例如可以包括:由背景图像与前景图像合成得到的合成图像、前景图像在背景图像中的方位信息、前景图像的尺寸信息以及前景图像对应的害虫的类型信息;但本技术不限于此。

[0114]

在现有技术中,通常以如下方式生成学习数据,例如,利用人工对图像中的害虫信息进行标注。由于需要人工对图像中的害虫逐个标注位置信息和类型信息,因此,存在由于人为误判而引起目标误检的问题,并且,通过人工进行信息标注,开发成本较高。在本技术实施例中,通过将背景图像和前景图像进行合成而生成学习数据,由此,不需要人工标注害虫信息,从而避免了由于人为误判而导致的目标误检,并且能够减少开发成本。

[0115]

在一些实施例中,诱虫板图像可以是未粘附有害虫的诱虫板的图像。例如,诱虫板图像可以是通过电子设备拍摄的在实际场景(例如,农场、田地等)中的干净的诱虫板图像。背景图像可以是对诱虫板图像进行处理后得到的只包括诱虫板的图像。

[0116]

在一些实施例中,害虫图像可以是害虫个体的图像。例如,害虫图像可以是通过电子设备拍摄的在实际场景(例如,农场、田地等)中的害虫的图像。前景图像可以是去除掉害虫图像的背景的只有害虫目标的图像,或者,将害虫图像的背景色设置为已知值的图像。

[0117]

由于诱虫板图像和/或害虫图像是从实际场景中实际拍摄的图像,其与前述待处理图像的拍摄条件比较类似,因此,利用该诱虫板图像和害虫图像分别生成背景图像和前景图像并且利用该背景图像和前景图像生成学习数据,能够使该学习数据更真实、更接近待处理图像数据,进而提高神经网络模型的质量。

[0118]

图12是本技术实施例的步骤1001的一示意图,图13是本技术实施例的生成背景图像的一示意图。在一些实施例中,如图12和图13所示,步骤1001中所述的预处理可以是如下处理:

[0119]

10011,在诱虫板图像e中确定诱虫板对应的图像区域e1;其中,步骤10011例如可以采用与步骤101或202类似的方式,确定诱虫板对应的图像区域e1。

[0120]

10012,计算诱虫板对应的图像区域e1内的最大内接矩形e2的位置和大小;以及

[0121]

10013,根据最大内接矩形e2的位置和大小,裁剪出背景图像e3。

[0122]

图14是本技术实施例的步骤1002的一示意图,图15是本技术实施例的生成前景图像的一示意图。在一些实施例中,如图14和图15所示,步骤1002中所述的预处理可以是如下

处理:

[0123]

10021,在害虫图像f中确定害虫对应的图像区域;

[0124]

10022,将害虫图像f中的除了害虫对应的图像区域之外的区域的像素填充为第二值,得到前景图像f1。

[0125]

例如,可以先确定害虫图像中害虫的边界,根据边界的像素亮度值以及漫水填充算法,将边界之外的像素填充为最大值,例如,亮度值为r,g,b=255。但是,本技术不限于此,也可以采用其他方式生成前景图像。

[0126]

图16是本技术实施例的步骤1003的一示意图,图17是本技术实施例的生成合成图像的一示意图。在一些实施例中,如图16和图17所示,步骤1003可以包括如下处理:

[0127]

10031,根据角度随机数旋转前景图像f1;和/或,根据尺寸随机数缩放前景图像f1;以及

[0128]

10032,根据位置随机数在背景图像e3的对应位置处合成经过旋转和/或缩放的前景图像f1,得到合成图像g。

[0129]

在一些实施例中,角度随机数、尺寸随机数和位置随机数可以是利用随机数算法生成的任意类型的随机数。角度随机数可以表示前景图像的旋转的角度,尺寸随机数可以表示对前景图像进行缩放的比例,位置随机数可以表示前景图像的规定点(例如,中心点)在背景图像中的位置。由此,能够随机地旋转前景图像,随机地缩放害虫图像,随机、均匀地布置前景图像。

[0130]

在一些实施例中,步骤10032可以包括如下处理:

[0131]

10032-1,根据位置随机数、角度随机数和尺寸随机数,确定合成图像中的背景图像与前景图像重合的像素集;以及

[0132]

10032-2,在像素集中的第一像素的位置与前景图像中的害虫对应的图像区域的第二像素的位置相同时,将第一像素的取值设置为第二像素的取值。

[0133]

在步骤10032-2中,例如,可以根据前景图像中的像素的值确定合成图像的像素的值,例如,可以按照如下公式1对合成图像的像素进行赋值:

[0134][0135]

其中,pixel

fusion

为合成图像中的背景图像与前景图像重合的像素集的像素的值,pixel

background

为背景图像中的像素的值,pixel

foreground

为前景图像中的像素的值。

[0136]

根据上述公式1,在前景图像中的像素的值为(255,255,255)时,将合成图像对应的像素的值设置为对应的背景图像的像素的值,在前景图像中的像素的值不为(255,255,255)时,将合成图像对应的像素的值设置为该前景图像的像素的值。

[0137]

在一些实施例中,步骤1003还可以包括如下处理:

[0138]

10033,根据位置随机数,确定方位信息;

[0139]

10034,根据尺寸随机数,确定尺寸信息;以及

[0140]

10035,根据前景图像,确定类型信息。

[0141]

其中,方位信息可以是表示前景图像在背景图像中的位置的信息,例如,其可以通过如下方式表示:(中心锚点x坐标,中心锚点y坐标),但是,本技术不限于此,也可以以其他

方式表示。在生成前景图像时,可以存储前景图像对应的害虫的类型信息,由此,能够根据前景图像获取类型信息。

[0142]

在一些实施例中,神经网络模型的结构可以为yolo v5网络结构,通过采用该网络结构,能够提高对害虫这类较小的对象物的识别准确率。但是,本技术不限于此,也可以是其他类型的网络结构。

[0143]

在一些实施例中,神经网络模型可以通过如下方式训练生成:利用mosaic数据增强技术和giou损失函数对神经网络进行训练。

[0144]

由于害虫在诱虫板图像上具有形态小的特点,并且,虫害严重的情况下,还具有害虫密度大的特点,通过采用mosaic数据增强技术,能够强化神经网络模型对小目标的检测性能。此外,通过采用giou损失函数能够强化对稠密条件下的目标检测性能。但是,本技术不限于此,也可以是其他类型的数据增强技术或损失函数。

[0145]

在一些实施例中,在对神经网络进行训练的过程中,可以利用验证测试数据集对神经网络模型进行评价,在评价结果满足规定的条件时,将当前的神经网络模型作为可用的神经网络模型。

[0146]

在一些实施例中,验证测试数据集可以包括实际场景中的在诱虫板上粘附有害虫的图像。

[0147]

例如,将实际场景中的在诱虫板上粘附有害虫的图像作为待处理图像数据输入神经网络模型中,比较神经网络模型输出的识别结果与图像中的害虫信息,在识别结果的误检率和/或漏检率低于规定值的情况下,可以将当前的神经网络模型作为可用的神经网络模型。

[0148]

以上仅对与本技术相关的各步骤或过程进行了说明,但本技术不限于此。害虫识别方法还可以包括其他步骤或者过程,关于这些步骤或者过程的具体内容,可以参考现有技术。此外,以上仅以神经网络模型的一些结构为例对本技术实施例进行了示例性说明,但本技术不限于这些结构,还可以对这些结构进行适当的变型,这些变型的实施方式均应包含在本技术实施例的范围之内。

[0149]

以上各个实施例仅对本技术实施例进行了示例性说明,但本技术不限于此,还可以在以上各个实施例的基础上进行适当的变型。例如,可以单独使用上述各个实施例,也可以将以上各个实施例中的一种或多种结合起来。

[0150]

根据上述实施例,通过将待处理图像数据划分为诱虫板图像区域和背景图像区域、利用滑动窗口对划分后的待处理图像进行采样、利用神经网络对采样得到的图像进行识别,能够避免对目标的漏检和误检,提高了害虫识别的准确率。

[0151]

第二方面的实施例

[0152]

本技术实施例提供一种害虫识别装置和电子设备,与第一方面的实施例相同的内容不再赘述。

[0153]

图18是本技术实施例的害虫识别装置的一示意图,如图18所示,该装置1800可以包括:

[0154]

第一图像处理部1801,其将待处理图像数据划分为与诱虫板对应的诱虫板图像区域和背景图像区域,并将背景图像区域内的像素设置为第一值,得到第一图像数据;

[0155]

第二图像处理部1802,其对第一图像数据进行滑动窗口采样,得到多个第二图像

数据;以及

[0156]

识别部1803,其利用神经网络模型对多个第二图像数据进行识别,确定每个第二图像数据中的害虫的位置信息和/或类型信息。

[0157]

在一些实施例中,第二图像处理部1802可以采用等步长滑动窗口采样。

[0158]

在一些实施例中,害虫识别装置1800还可以包括:

[0159]

标注部1804,其在第二图像数据中示出位置信息和/或类型信息;以及

[0160]

合并部1805,其根据第二图像数据在第一图像数据中的定位信息,对示出位置信息和/或类型信息的第二图像数据进行合并。

[0161]

在一些实施例中,在滑动窗口采样中使用的窗口的尺度是根据神经网络模型的参数确定的。

[0162]

在一些实施例中,害虫识别装置1800还可以包括:

[0163]

通信部1806,其接收利用电子设备拍摄的并发送的待处理图像数据。

[0164]

在一些实施例中,害虫识别装置1800中还可以设置学习数据生成装置,该学习数据生成装置1807可以包括:

[0165]

第一处理部,其对获取的诱虫板图像进行预处理得到背景图像;

[0166]

第二处理部,其对获取的害虫图像进行预处理得到前景图像;以及

[0167]

第三处理部,其对背景图像与前景图像进行合成以生成学习数据,

[0168]

其中,学习数据包括:由背景图像与前景图像合成得到的合成图像、前景图像在背景图像中的方位信息、前景图像的尺寸信息以及前景图像对应的害虫的类型信息。

[0169]

在一些实施例中,第一处理部可以在诱虫板图像中确定诱虫板对应的图像区域;计算诱虫板对应的图像区域内的最大内接矩形的位置和大小;以及根据最大内接矩形的位置和大小,裁剪出背景图像。

[0170]

在一些实施例中,第二处理部可以在害虫图像中确定害虫对应的图像区域;以及将害虫图像中的除了害虫对应的图像区域之外的区域的像素填充为第二值,得到前景图像。

[0171]

在一些实施例中,第三处理部可以根据角度随机数旋转前景图像;和/或,根据尺寸随机数缩放前景图像;以及根据位置随机数在背景图像的对应位置处合成经过旋转和/或缩放的前景图像,得到合成图像。

[0172]

在一些实施例中,第三处理部还可以根据位置随机数、角度随机数和尺寸随机数,确定背景图像中的与前景图像重合的像素集;在像素集中的第一像素的位置与前景图像中的害虫对应的图像区域的第二像素的位置相同时,将第一像素的取值设置为第二像素的取值。

[0173]

在一些实施例中,第三处理部还可以根据位置随机数确定方位信息;根据尺寸随机数确定尺寸信息;以及根据前景图像确定类型信息。

[0174]

在一些实施例中,害虫识别装置1800中还可以设置神经网络模型的训练装置1808,该神经网络模型的训练装置1808可以包括:

[0175]

训练部,其根据学习数据生成装置1807生成的学习数据,对神经网络模型进行训练,生成可用的神经网络模型。

[0176]

在一些实施例中,神经网络模型的结构为yolo v5网络结构,训练部可以通过如下

方式训练生成神经网络模型:利用mosaic数据增强技术和giou损失函数对神经网络进行训练。

[0177]

在一些实施例中,训练部还可以利用验证测试数据集对神经网络模型进行评价,在评价结果满足规定的条件时,将当前的神经网络模型作为可用的神经网络模型。

[0178]

在一些实施例中,验证测试数据集包括实际场景中的在诱虫板上粘附有害虫的图像。

[0179]

值得注意的是,以上仅对与本技术相关的各部件或模块进行了说明,但本技术不限于此。害虫识别装置1800还可以包括其他部件或者模块,关于这些部件或者模块的具体内容,可以参考相关技术。

[0180]

为了简单起见,图18中仅示例性示出了各个部件或模块之间的连接关系或信号走向,但是本领域技术人员应该清楚的是,可以采用总线连接等各种相关技术。上述各个部件或模块可以通过例如处理器、存储器等硬件设施来实现;本技术实施例并不对此进行限制。

[0181]

以上各个实施例仅对本技术实施例进行了示例性说明,但本技术不限于此,还可以在以上各个实施例的基础上进行适当的变型。例如,可以单独使用上述各个实施例,也可以将以上各个实施例中的一种或多种结合起来。

[0182]

根据上述实施例,通过将待处理图像数据划分为诱虫板图像区域和背景图像区域、利用滑动窗口对划分后的待处理图像进行采样、利用神经网络对采样得到的图像进行识别,能够避免对目标的漏检和误检,提高了害虫识别的准确率。

[0183]

第三方面的实施例

[0184]

本技术实施例提供一种学习数据生成方法。与第一方面的实施例相同的内容不再赘述。

[0185]

图19是本技术实施例的学习数据生成方法的一示意图,如图19所示,学习数据生成方法包括:

[0186]

1901,对获取的诱虫板图像进行预处理得到背景图像;

[0187]

1902,对获取的害虫图像进行预处理得到前景图像;以及

[0188]

1903,对背景图像与前景图像进行合成以生成学习数据,其中,学习数据包括:由背景图像与前景图像合成得到的合成图像、前景图像在背景图像中的方位信息、前景图像的尺寸信息以及前景图像对应的害虫的类型信息。

[0189]

其中,步骤1901-1903的内容可以参见第一方面的实施例的步骤1001-1003,此处不再赘述。

[0190]

在现有技术中,通常以如下方式生成学习数据,例如,利用人工对图像中的害虫信息进行标注。由于需要人工对图像中的害虫逐个标注位置信息和类型信息,因此,存在由于人为误判而引起目标误检的问题,并且,通过人工进行信息标注,开发成本较高。在本实施例中,通过将背景图像和前景图像进行合成而生成学习数据,由此,不需要人工标注害虫信息,从而避免了由于人为误判而导致的目标误检,并且能够减少开发成本。

[0191]

在一些实施例中,步骤1901中所述的预处理可以是如下处理:

[0192]

在诱虫板图像中确定诱虫板对应的图像区域;

[0193]

计算诱虫板对应的图像区域内的最大内接矩形的位置和大小;以及

[0194]

根据最大内接矩形的位置和大小,裁剪出背景图像。

[0195]

在一些实施例中,步骤1902中所述的预处理可以是如下处理:

[0196]

在害虫图像中确定害虫对应的图像区域;

[0197]

将害虫图像中的除了害虫对应的图像区域之外的区域的像素填充为第二值,得到前景图像。

[0198]

在一些实施例中,步骤1903可以包括如下处理:

[0199]

根据角度随机数旋转前景图像;和/或,根据尺寸随机数缩放前景图像;以及

[0200]

根据位置随机数在背景图像的对应位置处合成经过旋转和/或缩放的前景图像,得到合成图像。

[0201]

在一些实施例中,根据位置随机数在背景图像的对应位置处合成经过旋转和/或缩放的前景图像可以包括如下处理:

[0202]

根据位置随机数、角度随机数和尺寸随机数,确定合成图像中的背景图像与前景图像重合的像素集;以及

[0203]

在像素集中的第一像素的位置与前景图像中的害虫对应的图像区域的第二像素的位置相同时,将第一像素的取值设置为第二像素的取值。

[0204]

在一些实施例中,步骤1903还可以包括如下处理:

[0205]

根据位置随机数,确定方位信息;

[0206]

根据尺寸随机数,确定尺寸信息;以及

[0207]

根据前景图像,确定类型信息。

[0208]

以上仅对与本技术相关的各步骤或过程进行了说明,但本技术不限于此。学习数据生成方法还可以包括其他步骤或者过程,关于这些步骤或者过程的具体内容,可以参考现有技术。

[0209]

以上各个实施例仅对本技术实施例进行了示例性说明,但本技术不限于此,还可以在以上各个实施例的基础上进行适当的变型。例如,可以单独使用上述各个实施例,也可以将以上各个实施例中的一种或多种结合起来。

[0210]

根据上述实施例,通过将背景图像和前景图像进行合成而生成学习数据,由此,不需要人工标注害虫信息,从而避免了由于人为误判而导致的目标误检,并且能够减少开发成本。

[0211]

第四方面的实施例

[0212]

本技术实施例提供一种学习数据生成装置和电子设备,与第一方面和第三方面的实施例相同的内容不再赘述。

[0213]

图20是本技术实施例的学习数据生成装置的一示意图,如图20所示,该装置2000可以包括:

[0214]

第一处理部2001,其对获取的诱虫板图像进行预处理得到背景图像;

[0215]

第二处理部2002,其对获取的害虫图像进行预处理得到前景图像;以及

[0216]

第三处理部2003,其对背景图像与前景图像进行合成以生成学习数据,其中,学习数据包括:由背景图像与前景图像合成得到的合成图像、前景图像在背景图像中的方位信息、前景图像的尺寸信息以及前景图像对应的害虫的类型信息。

[0217]

在一些实施例中,第一处理部2001可以在诱虫板图像中确定诱虫板对应的图像区域;计算诱虫板对应的图像区域内的最大内接矩形的位置和大小;以及根据最大内接矩形

的位置和大小,裁剪出背景图像。

[0218]

在一些实施例中,第二处理部2002可以在害虫图像中确定害虫对应的图像区域;以及将害虫图像中的除了害虫对应的图像区域之外的区域的像素填充为第二值,得到前景图像。

[0219]

在一些实施例中,第三处理部2003可以根据角度随机数旋转前景图像;和/或,根据尺寸随机数缩放前景图像;以及根据位置随机数在背景图像的对应位置处合成经过旋转和/或缩放的前景图像,得到合成图像。

[0220]

在一些实施例中,第三处理部2003还可以根据位置随机数、角度随机数和尺寸随机数,确定背景图像中的与前景图像重合的像素集;在像素集中的第一像素的位置与前景图像中的害虫对应的图像区域的第二像素的位置相同时,将第一像素的取值设置为第二像素的取值。

[0221]

在一些实施例中,第三处理部2003还可以根据位置随机数,确定方位信息;根据尺寸随机数,确定尺寸信息;以及根据前景图像,确定类型信息。

[0222]

其中,第一处理部2001、第二处理部2002和第三处理部2003可以参照第一方面的实施例的第一处理部、第二处理部和第三处理部,此处不再赘述。

[0223]

值得注意的是,以上仅对与本技术相关的各部件或模块进行了说明,但本技术不限于此。学习数据生成装置2000还可以包括其他部件或者模块,关于这些部件或者模块的具体内容,可以参考相关技术。

[0224]

为了简单起见,图20中仅示例性示出了各个部件或模块之间的连接关系或信号走向,但是本领域技术人员应该清楚的是,可以采用总线连接等各种相关技术。上述各个部件或模块可以通过例如处理器、存储器等硬件设施来实现;本技术实施例并不对此进行限制。

[0225]

以上各个实施例仅对本技术实施例进行了示例性说明,但本技术不限于此,还可以在以上各个实施例的基础上进行适当的变型。例如,可以单独使用上述各个实施例,也可以将以上各个实施例中的一种或多种结合起来。

[0226]

根据上述实施例,通过将背景图像和前景图像进行合成而生成学习数据,由此,不需要人工标注害虫信息,从而避免了由于人为误判而导致的目标误检,并且能够减少开发成本。

[0227]

第五方面的实施例

[0228]

本技术实施例提供一种神经网络模型的训练方法。与第一方面的实施例相同的内容不再赘述。

[0229]

图21是本技术实施例的神经网络模型的训练方法的一示意图,如图21所示,神经网络模型的训练方法包括:

[0230]

2101,生成学习数据,其中,该学习数据可以是根据第三方面的实施例的学习数据生成方法生成的;以及

[0231]

2102,根据学习数据,对神经网络模型进行训练,生成可用的神经网络模型。其具体实现可以参照第一方面的实施例的相关内容。

[0232]

在一些实施例中,神经网络模型的结构可以为yolo v5网络结构,通过采用该网络结构,能够提高对害虫这类较小的对象物的识别准确率。但是,本技术不限于此,也可以是其他类型的网络结构。

[0233]

在一些实施例中,利用mosaic数据增强技术和giou损失函数对神经网络进行训练。

[0234]

由于害虫在诱虫板图像上具有形态小的特点,并且,虫害严重的情况下,还具有害虫密度大的特点,通过采用mosaic数据增强技术,能够强化神经网络模型对小目标的检测性能。此外,通过采用giou损失函数能够强化对稠密条件下的目标检测性能。但是,本技术不限于此,也可以是其他类型的数据增强技术或损失函数。

[0235]

在一些实施例中,在对神经网络进行训练的过程中,可以利用验证测试数据集对神经网络模型进行评价,在评价结果满足规定的条件时,将当前的神经网络模型作为可用的神经网络模型。

[0236]

在一些实施例中,验证测试数据集可以包括实际场景中的在诱虫板上粘附有害虫的图像。

[0237]

例如,将实际场景中的在诱虫板上粘附有害虫的图像作为待处理图像数据输入神经网络模型中,比较神经网络模型输出的识别结果与图像中的害虫信息,在识别结果的误检率和/或漏检率低于规定值的情况下,可以将当前的神经网络模型作为可用的神经网络模型。

[0238]

以上仅对与本技术相关的各步骤或过程进行了说明,但本技术不限于此。神经网络模型的训练方法还可以包括其他步骤或者过程,关于这些步骤或者过程的具体内容,可以参考现有技术。此外,以上仅以神经网络模型的一些结构为例对本技术实施例进行了示例性说明,但本技术不限于这些结构,还可以对这些结构进行适当的变型,这些变型的实施方式均应包含在本技术实施例的范围之内。

[0239]

以上各个实施例仅对本技术实施例进行了示例性说明,但本技术不限于此,还可以在以上各个实施例的基础上进行适当的变型。例如,可以单独使用上述各个实施例,也可以将以上各个实施例中的一种或多种结合起来。

[0240]

根据上述实施例,通过采用根据第三方面的实施例的学习数据生成方法生成的学习数据对神经网络模型进行训练,能够提高神经网络模型的可靠性。

[0241]

第六方面的实施例

[0242]

本技术实施例提供一种神经网络模型的训练装置,与第一方面和第五方面的实施例相同的内容不再赘述。

[0243]

图22是本技术实施例的神经网络模型的训练装置的一示意图,如图22所示,该装置2200可以包括:

[0244]

生成部2201,其生成学习数据,其中,该学习数据可以是根据第三方面的实施例的学习数据生成方法生成的;以及

[0245]

训练部2202,其根据学习数据,对神经网络模型进行训练,生成可用的神经网络模型。其具体实现可以参照第一方面和第五方面的实施例的相关内容。

[0246]

在一些实施例中,神经网络模型的结构可以为yolo v5网络结构,通过采用该网络结构,能够提高对害虫这类较小的对象物的识别准确率。但是,本技术不限于此,也可以是其他类型的网络结构。

[0247]

在一些实施例中,训练部2202利用mosaic数据增强技术和giou损失函数对神经网络进行训练。

[0248]

由于害虫在诱虫板图像上具有形态小的特点,并且,虫害严重的情况下,还具有害虫密度大的特点,通过采用mosaic数据增强技术,能够强化神经网络模型对小目标的检测性能。此外,通过采用giou损失函数能够强化对稠密条件下的目标检测性能。但是,本技术不限于此,也可以是其他类型的数据增强技术或损失函数。

[0249]

在一些实施例中,在对神经网络进行训练的过程中,训练部2202可以利用验证测试数据集对神经网络模型进行评价,在评价结果满足规定的条件时,将当前的神经网络模型作为可用的神经网络模型。

[0250]

在一些实施例中,验证测试数据集可以包括实际场景中的在诱虫板上粘附有害虫的图像。

[0251]

例如,将实际场景中的在诱虫板上粘附有害虫的图像作为待处理图像数据输入神经网络模型中,比较神经网络模型输出的识别结果与图像中的害虫信息,在识别结果的误检率和/或漏检率低于规定值的情况下,可以将当前的神经网络模型作为可用的神经网络模型。

[0252]

值得注意的是,以上仅对与本技术相关的各部件或模块进行了说明,但本技术不限于此。神经网络模型的训练装置2200还可以包括其他部件或者模块,关于这些部件或者模块的具体内容,可以参考相关技术。

[0253]

为了简单起见,图22中仅示例性示出了各个部件或模块之间的连接关系或信号走向,但是本领域技术人员应该清楚的是,可以采用总线连接等各种相关技术。上述各个部件或模块可以通过例如处理器、存储器等硬件设施来实现;本技术实施例并不对此进行限制。

[0254]

以上各个实施例仅对本技术实施例进行了示例性说明,但本技术不限于此,还可以在以上各个实施例的基础上进行适当的变型。例如,可以单独使用上述各个实施例,也可以将以上各个实施例中的一种或多种结合起来。

[0255]

根据上述实施例,通过采用根据第三方面的实施例的学习数据生成方法生成的学习数据对神经网络模型进行训练,能够提高神经网络模型的可靠性。

[0256]

第七方面的实施例

[0257]

本技术实施例提供一种电子设备,与第一方面至第六方面的实施例相同的内容不再赘述。

[0258]

电子设备可以包括第二方面的实施例中的害虫识别装置1800,和/或第四方面的实施例中的学习数据生成装置2000,和/或第六方面的实施例中的神经网络的训练装置2200,其内容被合并于此。该电子设备例如可以是计算机、服务器、工作站、膝上型计算机、智能手机,等等;但本技术实施例不限于此。

[0259]

图23是本技术实施例的电子设备的示意图。如图23所示,电子设备2300可以包括:处理器(例如中央处理器cpu)2310和存储器2320;存储器2320耦合到中央处理器2310。其中该存储器2320可存储各种数据;此外还存储信息处理的程序2321,并且在处理器2310的控制下执行该程序2321。

[0260]

在一些实施例中,害虫识别装置1800,和/或学习数据生成装置2000,和/或神经网络的训练装置2200的功能被集成到处理器2310中实现。其中,处理器2310被配置为实现如第一方面的实施例所述的害虫识别方法,和/或第三方面的实施例中的学习数据生成方法,和/或第六方面的实施例中的神经网络的训练方法。

[0261]

在一些实施例中,害虫识别装置1800,和/或学习数据生成装置2000,和/或神经网络的训练装置2200与处理器2310分开配置,例如可以将害虫识别装置1800,和/或学习数据生成装置2000,和/或神经网络的训练装置2200配置为与处理器2310连接的芯片,通过处理器2310的控制来实现害虫识别装置1800,和/或学习数据生成装置2000,和/或神经网络的训练装置2200的功能。

[0262]

例如,处理器2310被配置为进行如下的控制:将待处理图像数据划分为与诱虫板对应的诱虫板图像区域和背景图像区域,将背景图像区域内的像素设置为第一值,得到第一图像数据;对第一图像数据进行滑动窗口采样,得到至少一个第二图像数据;以及利用神经网络模型对第二图像数据进行识别,确定第二图像数据中的害虫的位置信息和/或类型信息。

[0263]

又例如,处理器2310被配置为进行如下的控制:对获取的诱虫板图像进行预处理得到背景图像;对获取的害虫图像进行预处理得到前景图像;以及对背景图像与前景图像进行合成以生成学习数据,其中,学习数据包括:由背景图像与前景图像合成得到的合成图像、前景图像在背景图像中的定位信息、前景图像的尺寸信息以及前景图像对应的害虫的类型信息。

[0264]

又例如,处理器2310被配置为进行如下的控制:根据第三方面的实施例的学习数据生成方法生成学习数据;以及根据学习数据,对神经网络模型进行训练,生成可用的神经网络模型。

[0265]

此外,如图23所示,电子设备2300还可以包括:输入输出(i/o)设备2330和显示器2340等;其中,上述部件的功能与现有技术类似,此处不再赘述。值得注意的是,电子设备2300也并不是必须要包括图23中所示的所有部件;此外,电子设备2300还可以包括图23中没有示出的部件,可以参考相关技术。

[0266]

本技术实施例还提供一种计算机可读程序,其中当在电子设备中执行所述程序时,所述程序使得计算机在所述电子设备中执行如第一方面的实施例所述的害虫识别方法,或者如第二方面的实施例所述的学习数据生成方法,或者如第三方面的实施例所述的神经网络模型的训练方法。

[0267]

本技术实施例还提供一种存储有计算机可读程序的存储介质,其中所述计算机可读程序使得计算机在电子设备中执行如第一方面的实施例所述的害虫识别方法,或者如第二方面的实施例所述的学习数据生成方法,或者如第三方面的实施例所述的神经网络模型的训练方法。

[0268]

本技术以上的装置和方法可以由硬件实现,也可以由硬件结合软件实现。本技术涉及这样的计算机可读程序,当该程序被逻辑部件所执行时,能够使该逻辑部件实现上文所述的装置或构成部件,或使该逻辑部件实现上文所述的各种方法或步骤。本技术还涉及用于存储以上程序的存储介质,如硬盘、磁盘、光盘、dvd、flash存储器等。

[0269]

结合本技术实施例描述的方法/装置可直接体现为硬件、由处理器执行的软件模块或二者组合。例如,图中所示的功能框图中的一个或多个和/或功能框图的一个或多个组合,既可以对应于计算机程序流程的各个软件模块,亦可以对应于各个硬件模块。这些软件模块,可以分别对应于图中所示的各个步骤。这些硬件模块例如可利用现场可编程门阵列(fpga)将这些软件模块固化而实现。

[0270]

软件模块可以位于ram存储器、闪存、rom存储器、eprom存储器、eeprom存储器、寄存器、硬盘、移动磁盘、cd-rom或者本领域已知的任何其它形式的存储介质。可以将一种存储介质耦接至处理器,从而使处理器能够从该存储介质读取信息,且可向该存储介质写入信息;或者该存储介质可以是处理器的组成部分。处理器和存储介质可以位于asic中。该软件模块可以存储在移动终端的存储器中,也可以存储在可插入移动终端的存储卡中。例如,若设备(如移动终端)采用的是较大容量的mega-sim卡或者大容量的闪存装置,则该软件模块可存储在该mega-sim卡或者大容量的闪存装置中。

[0271]

针对附图中描述的功能方框中的一个或多个和/或功能方框的一个或多个组合,可以实现为用于执行本技术所描述功能的通用处理器、数字信号处理器(dsp)、专用集成电路(asic)、现场可编程门阵列(fpga)或者其它可编程逻辑器件、分立门或者晶体管逻辑器件、分立硬件组件或者其任意适当组合。针对附图描述的功能方框中的一个或多个和/或功能方框的一个或多个组合,还可以实现为计算设备的组合,例如,dsp和微处理器的组合、多个微处理器、与dsp通信结合的一个或多个微处理器或者任何其它这种配置。

[0272]

关于包括以上实施例的实施方式,还公开下述的附记:

[0273]

1.一种神经网络模型的训练方法,其特征在于,所述方法包括:

[0274]

根据权利要求15所述的方法,生成学习数据;以及

[0275]

根据所述学习数据,对神经网络模型进行训练,生成可用的神经网络模型。

[0276]

2.根据附记1所述的方法,其中,

[0277]

所述神经网络模型的结构为yolo v5网络结构,利用mosaic数据增强技术和giou损失函数对神经网络模型进行训练。

[0278]

3.根据附记1所述的方法,其中,所述方法还包括:

[0279]

利用验证测试数据集对所述神经网络模型进行评价,在评价结果满足规定的条件时,将当前的所述神经网络模型作为可用的神经网络模型。

[0280]

4.一种神经网络模型的训练装置,其特征在于,所述装置包括:

[0281]

生成部,其根据权利要求15所述的方法,生成学习数据;以及

[0282]

训练部,其根据所述学习数据,对神经网络模型进行训练,生成可用的神经网络模型。

[0283]

5.一种计算机可读程序,其中当在电子设备中执行所述程序时,所述程序使得计算机在所述电子设备中执行如权利要求1所述的害虫识别方法。

[0284]

6.一种计算机可读程序,其中当在电子设备中执行所述程序时,所述程序使得计算机在所述电子设备中执行如权利要求15所述的学习数据生成方法。

[0285]

7.一种计算机可读程序,其中当在电子设备中执行所述程序时,所述程序使得计算机在所述电子设备中执行如附记1所述的神经网络模型的训练方法。

[0286]

8.一种存储有计算机可读程序的存储介质,其中所述计算机可读程序使得计算机在电子设备中执行如权利要求1所述的害虫识别方法。

[0287]

9.一种存储有计算机可读程序的存储介质,其中所述计算机可读程序使得计算机在电子设备中执行如权利要求15所述的学习数据生成方法。

[0288]

10.一种存储有计算机可读程序的存储介质,其中所述计算机可读程序使得计算机在电子设备中执行如附记1所述的神经网络模型的训练方法。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1