基于深度学习的结构光照明超分辨成像基因检测方法

1.本发明属于光学显微成像技术和人工智能领域,具体涉及一种低数据获取、高时空分辨的基于深度学习的结构光照明超分辨成像基因检测方法。

背景技术:

2.传统光学显微镜的空间分辨率受制于光的衍射极限,极大地限制了包含基因检测在内的光学显微镜的应用范围。实现高空间分辨率成像一直是光学显微领域的重要研究课题之一。在各类超分辨成像技术中,结构照明显微术(structured illumination microscopy,sim)经过几十年的发展,已逐渐成为除了单分子定位显微术(single molecule localization microscopy,smlm)和受激发射损耗显微术(stimulated emission depletion microscopy,sted)的另一种远场超分辨成像技术。

3.sim采用空间编码的结构光场代替均匀光场照明样品,通过计算得到超衍射极限分辨率图像。在空间频率为k0的正弦条纹调制照明模式的最简单情况下,获取的图像通常是样本频谱的三个副本(即偏移+k0、0和-k0)的叠加。通过分离三个叠加的空间频谱并将它们移到频率空间的正确位置来获得样品的扩展频谱。然后将得到的频谱变换回空域空间,从而得到分辨率加倍的图像。普通的sim成像中,在一个方向的正弦条纹照明下,需要至少采集三个不同相移的原始条纹图像。理想情况下,相移以2π/3为增量,以确保总体照明(即所有图案的总和)产生均匀的照明场。此外,为了在空间各个方向上获得各向同性分辨率增强,通常还需要沿二或三个方向重复该照明过程,以产生多个原始图像来计算最终的超分辨成像结果。目前,线性sim可以获得约100nm的成像分辨率,且具有较低的激发光强、不需要特殊荧光染料等优点,十分适合基因检测的高时空分辨率成像。

4.然而,sim的缺点是超分辨率图像重建过程耗时且容易产生伪影。在普通sim系统中,生成超分辨率图像的基本工作流程是建立在傅立叶变换和空间谱处理的基础上,由于重建过程复杂,不可避免地降低了图像重建速度。此外,与预期成像模型的偏差或对实验参数(如光学传递函数、频谱滤波器、条纹初相位、相移精度等)的错误估计还会引入伪影,降低最终图像质量。为了提高成像的重构速度和精度,基于空域重构(spatial domain reconstruction,sdr)的sim超分辨成像方法被成功用于进行快速的超分辨重构(中国发明专利:cn111077121a),且具有与传统基于频域的重构方法具有相当的成像分辨率。但是,该方法仍受限于传统的数据采集方式,需要采集二或三个方向的6幅或9幅原始图像才能计算重构出一幅超分辨成像结果。这对于基因检测成像中需要快速成像和减少对检测试剂光漂白和光毒性的要求,还需要进一步优化。

技术实现要素:

5.本发明的目的在于联合深度学习、结构光照明显微成像与基因检测需求,提供一种基于深度学习的结构光照明超分辨成像基因检测方法,即deep-sim-net(deep-learning sim network),以克服基因检测成像中分辨率受衍射极限限制、结构光照明超分辨成像需

要大数据量采集以及重构速度受限等问题。

6.深度学习技术已在光学显微成像中逐渐被发展成为背景信息去除及分辨率增强的有效方法。利用卷积神经网络(convolutional neural network,cnn)等已成功实现在显微成像中提高成像效率和分辨率。深度学习神经网络可以在不需要先验信息的条件下,实现高性能的基因检测超分辨成像,在提高成像质量的同时,有效降低sim成像的数据采集量。

7.本发明通过采集两个或三个方向各一幅正弦条纹调制的原始图像,利用卷积神经网络重构出超分辨成像结果,在不丢失细节和成像视场的前提下,显著提高基因检测的数据通量,同时降低照明光对基因检测试剂的光漂泊和光毒性污染风险。

8.为了实现上述目的,本发明采用了以下技术方案:

9.一种基于深度学习的结构光照明超分辨成像基因检测方法,其特殊之处在于,包括以下步骤:

10.步骤1、构建并训练deep-sim-net神经网络模型;

11.步骤1.1、获得训练deep-sim-net神经网络模型所需数据;

12.步骤1.11、获得d

i,1

(x,y),i=1,2或i=1,2,3,即在两个或三个空间方向各获得一幅正弦条纹调制的原始图像;

13.步骤1.12、获得r(x,y),r(x,y)即为采用常规sim方法得到的超分辨图像;

14.步骤1.2、利用步骤1.1所得d

i,1

(x,y)和r(x,y)数据训练deep-sim-net神经网络模型;

15.步骤1.21、利用cnn建立deep-sim-net神经网络模型;

16.步骤1.22、对d

i,1

(x,y)和r(x,y)分别进行分割,获得t组中心到中心的子数据图像对,即和r

*

(x,y);将t组中心到中心的子数据图像对和r

*

(x,y)组成的数据集作为训练数据集;其中作为deep-sim-net神经网络模型的输入,r

*

(x,y)作为deep-sim-net神经网络模型的输出,t为自然数;

17.步骤1.23、确定deep-sim-net神经网络模型的目标为:

18.学习预测值的模型f,其中表示超分辨图像r

*

(x,y)的估计值;

19.步骤1.24、将步骤1.23中f所估计的预测值与对应超分辨图像的平均均方误差作为损失函数,学习deep-sim-net神经网络模型的可训练参数l(θ),该过程表述为:

[0020][0021]

其中t为用于训练网络的子数据图像对总数量,为第p个子数据图像,为对应的超分辨子数据图像;

[0022]

步骤1.25、利用优化求解算法对deep-sim-net神经网络模型的参数进行求解,获得训练好的deep-sim-net神经网络模型;

[0023]

步骤2、利用训练好的deep-sim-net神经网络模型,获得高质量超分辨基因检测图

像;

[0024]

将待检基因样本的两个或三个空间方向各一幅正弦条纹调制的原始数据输入步骤1训练好的deep-sim-net神经网络模型中,即可得出相应的高质量超分辨图像。

[0025]

进一步地,在基因检测中,所述步骤1.11中,选用两个正交方向各一幅正弦条纹调制的原始图像,即d

i,1

(x,y),i=1,2。

[0026]

进一步地,步骤1.12具体通过下述方法得到的超分辨图像r(x,y):

[0027]

将两个正交方向各3幅相移正弦条纹照明图像d

i,j

(x,y),i=1,2,j=1,2,3,按照如下公式获得:

[0028][0029][0030][0031][0032][0033][0034][0035]

其中,3幅相移正弦条纹照明图像的相移步长为i0、m、k0、分别表示照明的平均强度、条纹调制度、空间频率、初始相位。

[0036]

进一步地,deep-sim-net神经网络模型的深度为17或20层。

[0037]

进一步地,步骤1.25中优化求解算法选用自适应矩估计adam算法。

[0038]

本发明的有益效果是:

[0039]

1、本发明将深度学习技术、结构光照明超分辨成像技术与基因检测应用相结合,克服了基因检测成像中分辨率受衍射极限限制、结构光照明超分辨成像需要大数据量采集以及重构速度受限等问题,实现了低数据获取、高时空分辨的基于深度学习的结构光照明基因检测超分辨成像方法。

[0040]

2、本发明可以从两幅或三幅正弦条纹调制的原始成像数据中直接预测超分辨成像结果,与普通sim超分辨成像相比,数据量减少3倍,且降低照明光对基因样品的光漂泊和光毒性污染风险。

附图说明

[0041]

图1是实施例中一种基于dmd产生结构光照明的基因检测超分辨成像系统示意图。

[0042]

1-激光光源,2-tir棱镜,3-dmd,4-准直透镜,5-二向色镜,6-物镜,7-基因样品,8-反射棱镜,9-带通滤光片,10-镜筒透镜,11-相机。

[0043]

图2是以一幅正弦条纹调制条件下的基因检测成像结果为例,将其沿窗扫描方向滑动并分割成若干子数据图像,随后将子数据图像随机排序构成训练数据集。对应的超分辨图像按同样方式进行预处理。

[0044]

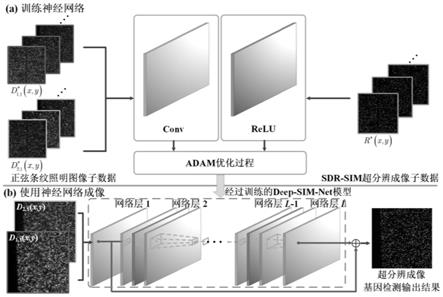

图3是本发明deep-sim-net方法处理原理图。其中:(a)是训练神经网络过程,(b)是使用经过训练的网络进行超分辨图像输出过程。

[0045]

图4是本发明deep-sim-net方法与普通宽场显微成像、sim超分辨成像的基因检测结果对比图,其中:(a)是普通宽场显微成像结果,(b)是sim超分辨成像结果,(c)是本发明deep-sim-net输出结果。

[0046]

图5为图4中随机选取的一个基因检测亮点区域的强度横向分布曲线分辨率比较。

具体实施方式

[0047]

为使本发明的上述目的、特征和优点能够更加明显易懂,下面结合说明书附图对本发明的具体实施方式做详细的说明,显然所描述的实施例是本发明的一部分实施例,而不是全部实施例。基于本发明中的实施例,本领域普通人员在没有做出创造性劳动前提下所获得的所有其他实施例,都应当属于本发明的保护的范围。

[0048]

在下面的描述中阐述了很多具体细节以便于充分理解本发明,但是本发明还可以采用其他不同于在此描述的其它方式来实施,本领域技术人员可以在不违背本发明内涵的情况下做类似推广,因此本发明不受下面公开的具体实施例的限制。

[0049]

参照图1所示,本发明举例说明一种基于dmd(数字微镜)产生结构光照明的基因检测超分辨成像系统。其使用扩束准直的激光1作为照明源来执行sdr-sim超分辨成像和deep-sim-net成像。激光进入全内反射棱镜(tir棱镜2),然后反射到dmd3上之后,调制光通过光学投影系统,包括准直透镜4、二向色镜5和物镜6,将正弦条纹图案投射到待检测基因样品7上。样品荧光信号经过物镜6收集,通过二向色镜5和反射棱镜8,并由带通滤光片9过滤,然后由镜筒透镜10成像到相机11上。

[0050]

在该系统上,可进行sdr-sim与deep-sim-net成像。进行sdr-sim成像时,通过控制dmd3先后加载两个空间方向夹角为90

°

、每个空间方向的三步相移的相移步长为π/2,则两个正交方向的成像过程会产生6幅正弦条纹照明图像d

i,j

(x,y),i=1,2,j=1,2,3。也可以通过控制dmd3先后加载三个空间方向夹角互为120

°

、每个空间方向的三步相移的相移步长为2π/3,则三个空间方向的成像过程会产生9幅正弦条纹照明图像d

i,j

(x,y),i=1,2,3,j=1,2,3。每个方向超分辨图像r(x,y)的获得采用空域重构sdr-sim方法得到(参见中国发明专利cn111077121a)。

[0051]

进行deep-sim-net成像时,通过控制dmd3先后加载两个空间方向夹角为90

°

,每个空间方向各一幅正弦条纹调制的原始图像进行成像,即d

i,1

(x,y),i=1,2。也可以通过控制dmd3先后加载三个空间方向夹角为120

°

,每个空间方向各一幅正弦条纹调制的原始图像进行成像,即d

i,1

(x,y),i=1,2,3。

[0052]

相较于sdr-sim成像,在本发明deep-sim-net成像方法在神经网络训练成功后,便可以直接利用两个空间方向或三个空间方向各一幅正弦条纹调制的原始图像数据直接预测超分辨成像结果,其在不丢失细节和成像视场的情况下,可以显著提高基因检测的数据通量,同时降低照明光对基因样品的光漂泊和光毒性污染风险。

[0053]

为了实现上述目标,下述实施例以在两个正交方向获得相应图像为例进行说明:

[0054]

首先获得sdr-sim的超分辨图像r(x,y),其具体步骤为:

[0055]

将两个正交方向各3幅相移(相移步长为)正弦条纹照明图像d

i,j

(x,y),i=1,2,j=1,2,3,按照如下公式获得超分辨图像r(x,y):

[0056][0057][0058]

其中i0、m、k0、分别表示照明的平均强度、条纹调制度、空间频率、初始相位。

[0059]

然后,获得d

i,1

(x,y),i=1,2,即两个正交方向各一幅正弦条纹调制的原始图像。

[0060]

之后,确定训练数据集,由于分别将整个d

i,1

(x,y)原始图像及超分辨图像r(x,y)作为deep-sim-net神经网络模型的输入/输出将极大地增加训练数据集的大小和计算成本,因此,参照图2所示,本发明对超分辨图像r(x,y)及d

i,1

(x,y)原始图像分别进行分割,产生中心到中心的子数据图像对,即和r

*

(x,y)。本发明将子数据图像对作为训练数据集。由于中心点的信息受到周围区域的影响,因此可以根据点扩散函数确定子数据图像对的边长。具体的,子数据图像对边长256

×

256像素,扫描步长64像素。为了更精确,将多个不同视场的实验数据结合起来使用,从而可以获得几千个子数据图像对,以满足神经网络训练数据集规模要求。

[0061]

随后,参照图3所示,利用cnn建立deep-sim-net神经网络模型,对deep-sim-net神经网络模型进行训练。利用前述所得和r

*

(x,y)数据训练deep-sim-net神经网络模

型并进行成像,其具体步骤为:

[0062]

1)、deep-sim-net神经网络模型的目标是学习预测值的模型f,其中表示超分辨成像结果r

*

(x,y)的估计值。优选的,该网络将具有20层,其具有两种类型的层——卷积层(conv)和校正线性单元层(relu)。继而将f所估计的预测值与对应超分辨图像的平均均方误差作为损失函数,确定deep-sim-net神经网络模型的可训练参数l(θ),该过程表述为:

[0063][0064]

其中t为用于训练deep-sim-net神经网络模型的子数据图像对的总数量,为第p个子数据图像,为对应的sdr-sim超分辨子数据图像;

[0065]

2)、在此基础上,利用adam优化求解算法对deep-sim-net神经网络模型的参数进行求解。其中,动量和重量衰减参数分别设置为0.9和0.0001。为了更快地训练网络,学习率最初设置为0.1,然后每30个阶段降低10倍,90个阶段后停止。该训练过程利用gpu titan v实现。

[0066]

3)、如图3中(b)所示,在得到相应的deep-sim-net神经网络模型后,将待检测基因的两个正交方向各一幅正弦条纹调制sim成像原始数据输入至训练好的deep-sim-net神经网络模型中,即可得出相应的高质量超分辨图像。

[0067]

参照图4所示,举例说明激光照明条件下基因检测成像结果。与普通宽场显微成像结果相比,基于本发明系统的sdr-sim超分辨成像能够有效地提高成像分辨率。相比之下,deep-sim-net的成像质量与sdr-sim成像相当。在计算时间方面,deep-sim-net具有非常出色的计算效率,例如它可以在大约0.01s内处理得到一幅2048

×

2048像素的超分辨图像。

[0068]

参照表1所示,我们利用结构相似性(structural similarity,ssim)和相关系数(correlation coefficient,cc)来衡量deep-sim-net的成像质量,它们的指标范围均为0至1,且高数值表示高相似性。具体地,deep-sim-net与sdr-sim成像结果之间的ssim数值为0.97,cc数值为0.98,从而量化地表明两者成像结果的高度一致性。进一步地,我们还利用峰值信噪比(peak signal to noise ratio,psnr)来评价不同成像结果的性能。具体地,deep-sim-net成像的psnr为36.72db,sdr-sim成像的psnr为36.45db,再次证明本发明实现了低数据获取、高时空分辨的基于深度学习的结构光照明基因检测超分辨成像方法的有效性。

[0069]

表1为图4成像质量量化分析结果对比表。

[0070][0071]

参照图5所示,在相同成像条件下,举例说明不同成像方法在成像分辨率上的性能比较。我们在图4中随机选取一个基因检测亮点区域,对其强度横向分布绘制曲线,并利用高斯函数进行拟合。通过测量曲线的半高宽(full width at half maximum,fwhm),可以看出deep-sim-net和sdr-sim成像的分辨率是相同的,都约是宽场分辨率的1.5倍。

[0072]

因此,本发明以深度学习技术为核心,与结构光照明超分辨成像技术和基因检测应用相结合,克服了基因检测成像中分辨率受衍射极限限制、结构光照明超分辨成像需要大数据量采集以及重构速度受限等问题。本发明另一方面,有效提高了成像速度,对于高帧率、高采样率条件下的超快速二维成像以及三维基因检测成像都具有重要意义。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1