一种基于MIT和FSM的多模态情感分析方法

一种基于mit和fsm的多模态情感分析方法

技术领域

1.本发明涉及多模态情感分析技术领域,特别是指一种基于mit和fsm的多模态情感分析方法。

背景技术:

2.在创新2.0的时代背景下,多模态数据成为网络中的主流数据,不同情感粒度的多模态信息被情感主体并行地向外传播,这使得基于文本词性分析的传统情感分析方法难以适应而导致失败。多模态数据的融合已经成为制约多模态情感分析领域发展的瓶颈,必须设计一种在传统情感分析基础上加入多模态数据融合的新方法,保证多模态情感分析算法的鲁棒性。

3.目前多模态融合算法研究主要分为两类:基于特征融合方法和基于决策融合方法。基于特征融合方法将各模态的特征向量融合为一个多模态特征向量后再进行情感判断,这种方法能够抓取低级表征信息之间的关联。基于决策融合独立学习不同模态的信息进行局部情感分析,再将结果进行融合以获得最终的决策。这种融合方法能够针对各个模态语义空间的不同各自设计特征提取方法,以获取最优局部决策。上述方法存在两个明显问题:(1)多模态数据融合后仅能融合低级表征信息,无法捕获不同主体之间的情感互动;(2)不同模态之间存在语义空间屏障,无法令多模态信息之间进行语义交融。

4.因此,必须寻找一种既能捕获不同主体之间情感互动,又能打破语义空间屏障进行语义交融的融合方法,来保证多模态情感分析算法的性能。

技术实现要素:

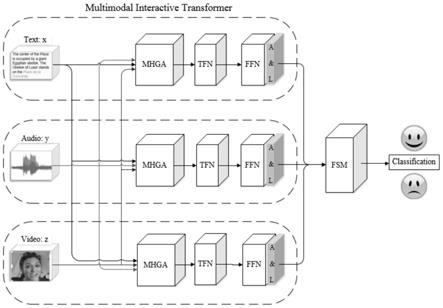

5.针对现有多模态情感分析方法在融合多模态信息时的技术性问题,本发明提出一种基于mit和fsm的多模态情感分析方法,利用multimodal interactive transformer能够捕捉模态之间的关联,feature soft mapping机制能够将特征向量映射到统一的语义空间中,以打破语义空间屏障实现多模态信息的融合;结合两者所提出的多模态情感分析模型能够充分考虑多种模态信息之间的关联,有助于在数据融合后进行情感分类。

6.本发明的技术方案是这样实现的:

7.一种基于mit和fsm的多模态情感分析方法,其步骤如下:

8.步骤一:分别对文本模态数据、语音模态数据和视频模态数据进行预处理,提取文本特征向量、语音特征向量和视频特征向量;

9.步骤二:从文本特征向量、语音特征向量和视频特征向量对应的模态中选择一个模态作为主要模态,其余两个模态作为辅助模态进行组合,得到三个组合,并将三个组合分别输入multimodal interactive transformer中进行辅助学习,分别得到三个学习后的特征矩阵;

10.步骤三:将三个学习后的特征矩阵输入featuresoft mapping中映射到统一的语义空间中进行融合,得到融合特征;

11.步骤四:将融合特征输入分类层,获取情感预测结果。

12.优选地,所述对文本模态数据进行预处理,提取文本特征向量的方法为:将文本模态数据进行分词处理,获取有效单词,并统计有效单词出现的频次作为共现矩阵x的元素x

(i,j)

;使用glove模型将共现矩阵x嵌入到300维的文本特征向量中;其中,共现矩阵x的维度为z

×

z,z为独立词汇的个数,x

(i,j)

表示单词i和单词j出现在同一个窗口中的次数。

13.优选地,所述对语音模态数据进行预处理,提取语音特征向量的方法为:将语音模态数据以40ms为时间刻度,把连续的音频信号在时间刻度内的多个采样点集合为一个讯框,通过一个高通滤波器对音频信号进行预强化以补偿语音信号中的高频部分,利用傅里叶变化将音频信号从时域转化到频域;在每个梅尔刻度上提取对数能量以后再进行离散傅里叶反变换,获取80维的语音特征向量。

14.优选地,所述对视频模态数据进行预处理,提取视频特征向量的方法为:将视频模态数据的每一帧图像的大小都缩放到112

×

112,对于rgb三通道的视频数据来说,每一帧图像的大小为112

×

112

×

3;使用大小为3

×3×

3的卷积核提取每一帧图像的特征,且将卷积核移动的步幅设置为7;三个通道的卷积结果相加,得到每帧图像提取出的大小为256维的视频特征向量。

15.优选地,所述将文本特征向量、语音特征向量和视频特征向量作为一个整体分别输入multimodal interactive transformer中进行辅助学习的方法为:

16.a.文本特征向量对应的模态为主要模态x,语音特征向量和视频特征向量对应的模态为辅助模态y和z;

17.s2.1、将主要模态x的key向量和value向量记为k

x

与v

x

,将辅助模态y和z的query向量分别记为q

y

与q

z

;

18.s2.2、计算k

x

与q

y

的标准内积来获取主要模态x与辅助模态y的相似度权重,并对主要模态x与辅助模态y的相似度权重使用softmax函数进行归一化,再利用归一化后的相似度权重对v

x

进行加权求和;具体计算公式为:

[0019][0020]

其中,d表示特征向量的维度;

[0021]

s2.3、计算每一次操作后的head:

[0022][0023]

其中,head

i'

表示第i'个head的计算结果,表示第i'个head计算时q

y

的权重,表示第i'个head计算时k

x

的权重,表示第i'个head计算时v

x

的权重,i'=1,2,

…

,h,h为步骤s2.2的操作次数;

[0024]

s2.4、将h次的结果进行拼接和线性变化即可得到主要模态x与辅助模态y经过multi

‑

head guided

‑

attention后的结果,表达式为:

[0025]

mhga(q

y

,k

x

,v

x

)=concat(head1,...,head

h

)w

o

;

[0026]

其中,concat(

·

)为拼接操作,w

o

表示给拼接后的值赋予的权重;

[0027]

s2.5、将k

x

、v

x

和q

z

按照步骤s2.2至s2.4的操作方法,获得主要模态x与辅助模态z经过multi

‑

head guided

‑

attention后的结果;

[0028]

s2.6、将主要模态x与辅助模态y经过multi

‑

head guided

‑

attention后的结果记为张量t1,将主要模态x与辅助模态z经过multi

‑

head guided

‑

attention后的结果记为张量t2;

[0029]

s2.7、使用笛卡尔积的跟随向量场定义二维张量融合网络,表示为:

[0030][0031]

其中,坐标(t1,t2)是由两个张量嵌入维度[t

1 1]

t

和[t

2 1]

t

定义的笛卡尔平面中的一个点,利用如下公式计算两个张量的融合结果:

[0032][0033]

其中,t表示融合后的张量;

[0034]

s2.8、将融合后的张量t输入由全连接层和非线性激活函数组成的前向传播层进行一次残差变化和归一化变换,得到文本特征向量对应的学习后的特征矩阵f

text

:

[0035]

f

text

=layernorm(t+sublayer(t));

[0036]

其中,layernorm(

·

)为归一化变换函数,sublayer(

·

)为残差变化函数;

[0037]

b.语音特征向量对应的模态为主要模态x,文本特征向量和视频特征向量对应的模态为辅助模态y和z;按照步骤s2.1至s2.8的操作方式执行,得到语音特征向量对应的学习后的特征矩阵f

audio

;

[0038]

c.视频特征向量对应的模态为主要模态x,文本特征向量和语音特征向量对应的模态为辅助模态y和z;按照步骤s2.1至s2.8的操作方式执行,得到视频特征向量对应的学习后的特征矩阵f

video

。

[0039]

优选地,所述将三个学习后的特征向量输入feature soft mapping中映射到统一的语义空间中进行融合的方法为:

[0040]

s3.1、分别对特征矩阵f

text

、f

audio

、f

video

进行尺寸变换,得到三个新的特征矩阵,分别为m1、m2、m3,其中,m1、m2、m3的维度大小均为2k

×

k;

[0041]

s3.2、利用大小为1

×

2k的向量v

q

分别与每个新的特征矩阵m

q

相乘后再利用softmax函数进行归一化处理,得到大小为1

×

k的向量a

q

:

[0042]

a

q

=softmax(v

q

m

q

);

[0043]

其中,q∈{1,2,3};

[0044]

s3.3、将所有向量a

q

进行加权求和,并将求和结果进行整合,得到大小为k的向量m:

[0045][0046]

其中,w

q

为权重;

[0047]

s3.4、m为视频序列上单个节点上的计算结果,将整个视频序列的所有节点的结果进行堆叠得到融合特征:

[0048][0049]

其中,s为融合特征,m

j'

为第j'个节点的向量,j'=0,1,

…

,n,n为视频的节点数,stacking(

·

)为拼接操作。

[0050]

优选地,所述情感预测结果的表达式为:

[0051]

y~p=w

s

(layernorm(s));

[0052]

其中,y~p为预测分类结果,w

s

为分类层的权重,layernorm(

·

)表示归一化变换函数。

[0053]

与现有技术相比,本发明产生的有益效果为:本发明从三个模态的原始数据中提取特征向量;将三个模态的特征向量分别复制三份,按作用不同记为query(q)向量、key(k)向量、value(v)向量;分别选择一个模态作为主要模态x,两个模态作为辅助模态y、z进行组合,将三个组合传入三个multimodal interactive transformer框架中;将multimodal interactive transformer框架输出的结果传入feature soft mapping中进行融合;将融合后的结果传入分类层获取最终情感预测结果。本发明将guided

‑

attention技术引入到transformer编码框架中,给多模态融合方法的研究指出了一个新的研究思路;feature soft mapping机制将特征向量映射到统一的语义空间,能够在融合时有效获取多模态语义交融信息。

附图说明

[0054]

为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

[0055]

图1为本发明的整体模型示意图。

[0056]

图2为本发明所述multimodal interactive transformer框架示意图。

具体实施方式

[0057]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有付出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0058]

如图1所示,本发明实施例提供了一种基于mit和fsm的多模态情感分析方法,引入guided

‑

attention思路改良传统transformer编码框架,所得到的multimodal interactive transformer框架不但能够融合低级表征信息,还能够捕获不同主体之间的情感互动,给多模态融合方法的研究指出了一个新的研究思路;提出feature soft mapping机制,feature soft mapping机制将特征向量映射到统一的语义空间中,打破不同模态之间的语义空间屏障,能够在融合时有效令多模态信息之间进行语义交融;具体步骤如下:

[0059]

步骤一:从完整视频中提取视频中的文字、声音和视频画面,获得了文本模态数据、语音模态数据和视频模态数据这三种数据;分别对文本模态数据、语音模态数据和视频模态数据进行预处理,提取文本特征向量、语音特征向量和视频特征向量;对于文本模态数据的处理过程分为两个部分:首先要对原始文本数据进行分析,构造一个针对词的共现矩阵;然后基于矩阵的分布表示,利用单词之间的关联对共现矩阵进行分解从而得到单词的

表示向量。具体来讲,将文本模态数据进行分词处理,获取有效单词,并统计有效单词出现的频次作为共现矩阵x的元素x

(i,j)

;使用glove模型将共现矩阵x嵌入到300维的文本特征向量中;其中,共现矩阵x的维度为z

×

z,z为独立词汇的个数,x

(i,j)

表示单词i和单词j出现在同一个窗口中的次数。

[0060]

对于语音模态数据的处理是将语音模态数据以40ms为时间刻度,把连续的音频信号在时间刻度内的多个采样点集合为一个讯框,通过一个高通滤波器对音频信号进行预强化以补偿语音信号中的高频部分,利用傅里叶变化将音频信号从时域转化到频域来观察能量部分状况;接下来将每个讯框获得的频谱经过梅尔滤波器过滤掉人耳无法分辨的频率信息,在每个梅尔刻度上提取对数能量以后再进行离散傅里叶反变换,获取80维的语音特征向量。

[0061]

对于视频模态数据逐帧进行处理,将视频模态数据的每一帧图像的大小都缩放到112

×

112,对于rgb三通道的视频数据来说,每一帧图像的大小为112

×

112

×

3;使用大小为3

×3×

3的卷积核提取每一帧图像的特征,且将卷积核移动的步幅设置为7((112

‑

7)/7+1=16);三个通道的卷积结果相加,得到每帧图像提取出的大小为256维的视频特征向量(16*16=256)。

[0062]

步骤二:从文本特征向量、语音特征向量和视频特征向量对应的模态中选择一个模态作为主要模态,其余两个模态作为辅助模态进行组合,得到三个组合,并将三个组合分别输入multimodal interactive transformer中进行辅助学习,分别得到三个学习后的特征矩阵;

[0063]

multimodal interactive transformer中的实现步骤为:

[0064]

a.文本特征向量对应的模态为主要模态x,语音特征向量和视频特征向量对应的模态为辅助模态y和z;

[0065]

s2.1、将主要模态x的key向量和value向量记为k

x

与v

x

,将辅助模态y和z的query向量分别记为q

y

与q

z

;

[0066]

s2.2、计算k

x

与q

y

的标准内积来获取主要模态x与辅助模态y的相似度权重,并对主要模态x与辅助模态y的相似度权重使用softmax函数进行归一化,再利用归一化后的相似度权重对v

x

进行加权求和;具体计算公式为:

[0067][0068]

其中,d表示特征向量的维度;

[0069]

s2.3、上述操作一共进行h次,每次视为一个head,为了使内积不会过大,通常会将计算出的相似度权重除以k的维度,且每个head中线性变换的参数w都是不相同的;计算每一次操作后的head:

[0070][0071]

其中,head

i'

表示第i'个head的计算结果,表示第i'个head计算时q

y

的权重,表示第i'个head计算时k

x

的权重,表示第i'个head计算时v

x

的权重,i'=1,2,

…

,h,h为步骤s2.2的操作次数;

[0072]

s2.4、将h次的结果进行拼接和线性变化即可得到主要模态x与辅助模态y经过

multi

‑

head guided

‑

attention后的结果,表达式为:

[0073]

mhga(q

y

,k

x

,v

x

)=concat(head1,...,head

h

)w

o

;

[0074]

其中,concat(

·

)为拼接操作,w

o

表示给拼接后的值赋予的权重;

[0075]

s2.5、将k

x

、v

x

和q

z

按照步骤s2.2至s2.4的操作方法,获得主要模态x与辅助模态z经过multi

‑

head guided

‑

attention后的结果;

[0076]

s2.6、将主要模态x与辅助模态y经过multi

‑

head guided

‑

attention后的结果记为张量t1,将主要模态x与辅助模态z经过multi

‑

head guided

‑

attention后的结果记为张量t2;张量t1、t2均为一维张量。

[0077]

s2.7、将主要模态x分别与辅助模态y、z经过multi

‑

head guided

‑

attention后的两个张量t1、t2传入二维张量融合网络(tfn)融合获取低级表征融合信息;使用笛卡尔积的跟随向量场定义二维张量融合网络,表示为:

[0078][0079]

其中,坐标(t1,t2)是由两个张量嵌入维度[t

1 1]

t

和[t

2 1]

t

定义的笛卡尔平面中的一个点,利用如下公式计算两个张量的融合结果:

[0080][0081]

其中,t表示融合后的张量,张量t为二维张量。

[0082]

s2.8、将融合后的张量传入到由全连接层和非线性激活函数组成的前向传播层(ffn);将融合后的张量t输入由全连接层和非线性激活函数组成的前向传播层进行一次残差变化和归一化变换,得到文本特征向量对应的学习后的特征矩阵f

text

:

[0083]

f

text

=layernorm(t+sublayer(t));

[0084]

其中,layernorm(

·

)为归一化变换函数,sublayer(

·

)为残差变化函数。

[0085]

b.语音特征向量对应的模态为主要模态x,文本特征向量和视频特征向量对应的模态为辅助模态y和z;按照步骤s2.1至s2.8的操作方式执行,得到语音特征向量对应的学习后的特征矩阵f

audio

;

[0086]

c.视频特征向量对应的模态为主要模态x,文本特征向量和语音特征向量对应的模态为辅助模态y和z;按照步骤s2.1至s2.8的操作方式执行,得到视频特征向量对应的学习后的特征矩阵f

video

。

[0087]

三个数据模态通过三个结构一样的multimodal interactive transformer来处理,输出三个二维张量(也就是矩阵)。

[0088]

步骤三:将三个学习后的特征矩阵输入feature soft mapping中映射到统一的语义空间中进行融合,得到融合特征;

[0089]

feature soft mapping机制实现的方法为:

[0090]

s3.1、分别对特征矩阵f

text

、f

audio

、f

video

进行尺寸变换,得到三个新的特征矩阵,分别为m1、m2、m3,其中,m1、m2、m3的维度大小均为2k

×

k;

[0091]

s3.2、利用大小为1

×

2k的向量v

q

分别与每个新的特征矩阵m

q

相乘后再利用softmax函数进行归一化处理,得到大小为1

×

k的向量a

q

:

[0092]

a

q

=softmax(v

q

m

q

);

[0093]

其中,q∈{1,2,3};

[0094]

s3.3、将所有向量a

q

进行加权求和,并将求和结果进行整合,得到大小为k的向量m:

[0095][0096]

其中,w

q

为权重;

[0097]

s3.4、m为视频序列上单个节点上的计算结果,将整个视频序列的所有节点的结果进行堆叠得到融合特征:

[0098][0099]

其中,s为融合特征,m

j'

为第j'个节点的向量,j'=0,1,

…

,n,n为视频的节点数,stacking(

·

)为拼接操作。

[0100]

步骤四:将融合特征输入分类层,获取情感预测结果。所述情感预测结果的表达式为:

[0101]

y~p=w

s

(layernorm(s));

[0102]

其中,y~p为预测分类结果,w

s

为分类层的权重,layernorm(

·

)表示归一化变换函数。

[0103]

本发明的实施步骤如下:从三个模态的原始数据中提取特征向量;将三个模态的特征向量分别复制三份,按作用不同记为query(q)向量、key(k)向量、value(v)向量;分别选择一个模态作为主要模态x,两个模态作为辅助模态y、z进行组合,将三个组合分别输入multimodal interactive transformer框架中;将结果传入feature soft mapping中进行融合;将融合后的结果传入分类层获取最终情感预测结果。

[0104]

采用定量评价方式来评价本发明的有效性,本发明方法和各种代表性方法在cmu

‑

mosei数据集上的准确率和f1分数比较结果如表1所示。准确率是指样本预测结果中情感分类正确的数量与全部样本数量的比值,其值越大说明预测效果越好。f1分数是精确率和召回率的调和平均数,其值越大说明预测效果越好。本发明方法与mv

‑

lstm、graph

‑

mfn、raven、cim

‑

mtl相比,在情感2分类准确率和f1分数方面都取得了更好的表现。

[0105]

表1本发明方法与其他方法在cmu

‑

mosei数据集上的比较结果

[0106][0107][0108]

以上所述仅为本发明的较佳实施例而已,并不用以限制本发明,凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1