一种MR/AR/VR互动和生物场景控制方法、移动终端与可读存储介质与流程

一种mr/ar/vr互动和生物场景控制方法、移动终端与可读存储介质

技术领域

1.本技术涉及增强现实技术领域,具体涉及一种mr/ar/vr互动和生物场景控制方法、移动终端与可读存储介质。

背景技术:

2.目前,基于元宇宙的vr眼镜迎来了一波热潮,越来越多的公司和企业宣布加入元宇宙的行列进行相关产品的研发。vr眼镜作为元宇宙的主流产品主打沉浸式和全虚拟,但该类产品由于打造的是全虚拟的世界平台容易让使用者沉迷虚拟世界,逃离现实世界,易于产生降低人均生产效率和生产价值的不良影响。

3.同时,在现实生活中经常出现构想或设计的实际复现成本较大且建设周期较长的情况,并且由于现实世界中缺少互动性和趣味性而让越来越多的人选择在网上畅游,并且在现实世界中的行动成本和检索成本较高而让越来越多的人选择在网上购物、点外卖,上述现象都是由于现实世界与虚拟世界还未实现互联互通所导致的。

4.因此,将虚拟世界与现实世界在同一个平台上进行融合的系统和方法不仅能预防用户沉浸于虚拟世界,而且降低了现实世界的实现成本提高了现实世界的趣味性、互动性和针对性,该项技术、系统与应用能够真正让人们在体验真实生活的同时享受虚拟生活的便利。

技术实现要素:

5.一种mr/ar/vr互动场景控制方法包括如下步骤:

6.s1.通过在智能眼镜上的界面切换或选择进入互动场景的增强现实界面;

7.s2.通过智能眼镜上的定位模块和感知模块获取实时gps信息和图像信息;

8.s3.将实时gps信息和图像信息通过通信模块上传至服务器,与服务器所存储的开发端口制作的二/三维图像/视频数据所设置的gps位置与特征区域位置进行匹配;

9.s4.匹配成功后服务器将对应匹配的二/三维图像/视频数据进行数据回传,通过智能眼镜的通信模块进行数据接收,通过智能眼镜的成像装置进行数据呈现,完成数据的静态/动态可视化呈现;

10.s5.用户根据呈现的图像/视频数据进行相应操作与互动,通过动作捕捉装置完成用户操作的感应,若满足开发端口所设置的触发条件,则图像/视频数据根据开发端口所设置的变量进行可视化呈现。

11.一种mr/ar/vr生物场景控制方法包括如下步骤:

12.s6.通过在智能眼镜上的界面切换或选择进入生物场景的增强现实界面;

13.s7.通过智能眼镜上的定位模块和感知模块获取实时gps信息和图像信息;

14.s8.将实时gps信息和图像信息通过通信模块上传至服务器,与服务器所存储的开发端口制作的生物视频数据所设置的gps位置与特征区域位置进行匹配;

15.s9.匹配成功后服务器将对应匹配的生物视频数据进行数据回传,通过智能眼镜的通信模块进行数据接收,通过智能眼镜的成像装置进行数据呈现,完成数据的动态可视化呈现;

16.s10.用户根据呈现的生物视频数据进行相应操作与互动,通过动作捕捉装置完成用户操作的感应,若满足开发端口所设置的触发条件,则生物视频数据根据开发端口所设置的反馈变量进行可视化呈现。

17.所述的动作捕捉装置的建模步骤如下:

18.s11.将人体等效为“质量-弹簧-阻尼”模型;

19.s12.对人体进行集总建模,将人体等效为弹簧-质量-阻尼模型,包括两个主要部分——人体各关键部位节点、地面;

20.s13.设地面质量无穷大,在人体上取n个节点以更精确地描绘人体的行为动作细节,根据牛顿第二定律及每个节点手里关系列出人体各节点微分方程n个,

[0021][0022]

根据微分方程列出质量矩阵、刚度矩阵、阻尼矩阵,

[0023][0024][0025]

c=αm+βk;

[0026]

s14.通过速度传感器检测此时人体每个节点的速度,结合gps探测每个节点的三维坐标,得到γ0=(x0,y0,z0);即为每个节点速度初始值和位移初始值;

[0027]

s15.使用模态叠加法对方程进行解耦,并将质量矩阵、刚度矩阵、阻尼矩阵对角化,将方程从物理空间求解变到模态空间求解;

[0028]

s16.通过特殊算法或求解工具对方程进行迭代求解;

[0029]

s17.求出n阶模态后,将其叠加,得到物理空间各节点的速度、位移、以及加速度;

[0030]

s18.通过求解出的速度、位移、加速度构建任务移动的模型以及短时内移动的预测模型。

[0031]

所述的生物视频数据的建模步骤如下:

[0032]

s19.构建实际特性数据中的不变量数据,搭建不变量数据的可视化模型;

[0033]

s20.构建实际特性数据中的变量数据,设置变量数据关于时间的公式,将该公式通过传递函数作用在可视化模型上,完成可视化模型的定量变化设置;

[0034]

s21.设置变量数据的阈值,搭建变量数据超过阈值后的可视化模型,若变量数据的值超过所设置的阈值,则将可视化模型进行前后切换,完成可视化模型的定性变化设置。

[0035]

一种移动终端,其特征在于,包括处理器、存储器及存储在所述存储器上并可在所述处理器上运行的计算机程序,所述计算机程序被所述处理器执行时实现所述的控制方法的步骤。

[0036]

一种计算机可读存储介质,其特征在于,所述计算机可读存储介质上存储计算机程序,所述计算机程序被处理器执行时实现所述的控制方法的步骤。

附图说明

[0037]

图1为本技术基于增强现实的智能眼镜系统硬件逻辑框图;

[0038]

图2为本技术实施例一内部逻辑图;

[0039]

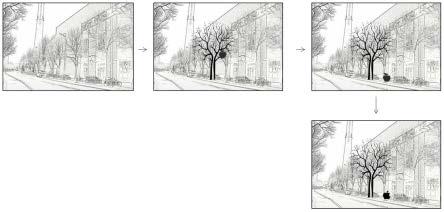

图3为本技术实施例一外部呈现图;

[0040]

图4为本技术实施例二界面呈现图;

[0041]

图5为本技术实施例二外部框架图;

[0042]

图6为本技术实施例二内部逻辑图;

[0043]

图7为本技术实施例二人体等效模型图;

[0044]

图8为本技术实施例二九节点人体等效模型图;

[0045]

图9为本技术实施例二九节点示意图;

[0046]

图10为本技术实施例二模型仿真图;

[0047]

图11为本技术实施例三界面呈现图;

[0048]

图12为本技术实施例三内部逻辑图。

具体实施方式

[0049]

下面详细描述本技术的实施例,所述实施例的示例在附图中示出,其中自始至终相同或类似的标号表示相同或类似的元件或具有相同或类似功能的元件。下面通过参考附图描述的实施例是示例性的,旨在用于解释本技术,而不能理解为对本技术的限制。

[0050]

如图1所示,一种基于增强现实的智能眼镜系统硬件包括若干vr/ar/mr智能眼镜接入设备、服务器以及基于服务器的若干多层互联网区域,其中所述的vr/ar/mr智能眼镜接入设备通过无线通讯与服务器相连,所述的服务器上运行着所述的若干多层互联网区域,所述的互联网区域可视为某一虚拟世界的切片,所述的若干切片可以叠加以特定数量组合成新的切片,用户可通过所述的vr/ar/mr智能眼镜接入设备选择某一切片进行投射。在vr/ar/mr智能眼镜接入设备对所述的互联网区域进行数据获取,即进行信息检索和信息交互功能时:所述的服务器将根据所选切片所对应的目标信息数据对所述的vr/ar/mr智能眼镜接入设备所上传的实时数据进行筛选和分类,保留特定数据,所述的vr/ar/mr智能眼镜接入设备与所述的服务器上的该切片完成特定信息数据的关联和交互,所述的服务器上

的该切片根据特定信息数据的确认将该信息数据所对应的多维数据传输至所述的vr/ar/mr智能眼镜接入设备进行投射。所述的vr/ar/mr智能眼镜接入设备包含若干不同类型的传感器和若干数据输入设备,在vr/ar/mr智能眼镜接入设备对所述的互联网区域进行数据上传,即进行信息发布和信息标记功能时:通过所述的传感器对当下的环境信息和人物动作信息进行抓取,通过所述的数据输入设备进行输入,获得的数据上传至所述的服务器上,所述的服务器上的该切片对数据进行分类和筛选,将筛选后的数据进行数据存储并可在所述的互联网区域的该切片下被检索、被交互并作为特定信息数据被投射至与服务器建立特定信息数据关联和交互的vr/ar/mr智能眼镜接入设备上。

[0051]

实施例一,如图2所示,一种基于增强现实的智能眼镜系统软件包括多元场景,多元场景分为不同的功能性场景,所述的功能性场景包含留言场景、创作场景、互动场景、生物场景、购物场景、检索场景、推送场景、联名场景、设计场景、标注场景、交友场景、导航场景、直播场景,但不限于上述功能性场景,每个功能性场景通过切换或叠加的方式在智能眼镜上进行可视化呈现;其中所述的每个功能性场景中可分为不同的主题性场景,所述的主题性场景包含对应不同人物、游戏、电影、动漫的场景,但不限于上述主题性场景,所述的主题性场景即为上述的切片,所述的若干切片可以叠加,以特定数量组合成新的切片,即所述的主题性场景可以单独在智能眼镜上进行可视化呈现,也可以组合在智能眼睛上进行可视化呈现。若所述的主题性场景有n个,则用户可切换的主题性场景的个数上限为:(2

n-1)。

[0052]

如图3所示,实施例一中基于增强现实的智能眼镜系统硬件包括智能眼镜本体101、交互操控装置102,所述的智能眼镜本体101与所述的交互操控装置102建立数据连接,用户可通过交互操控装置102完成智能眼镜本体101上虚拟场景的切换,其中在所述的智能眼镜本体101上的虚拟成像包含场景标签:场景一201、场景二202、场景三203、场景四204

……

,实现场景间的可视化切换,更进一步地,所述的场景标签可具备下级标签,用以展开某一场景下的下分场景,通过所述的交互操控装置102实现场景的切换与下钻。

[0053]

更进一步地,在数据后台中每一种场景对应有使用率、至少一个特征标准及一组ar参数。其中所述的场景一、场景二、场景三、场景四

……

的排序方式根据每一种场景的对应使用率进行从高到低的排序。其中,所述的使用率计算公式可以为:式中,t(i)为第i个场景的使用时长,为用户使用智能眼镜的总时长。

[0054]

更进一步地,为了逐步适应用户习惯进行数据更新服务,具体方法如下:

[0055]

s52.建立用户数据库存储用户的特征数据,例如对每一种场景的使用时长,或对每一种场景的使用率,或对每一种场景的使用频次;

[0056]

s53.每经过一段时间更新一次用户的特征数据,根据特征数据进行场景由高到低的排序。

[0057]

更进一步地,为了更加匹配用户需求进行个性化定制服务,具体方法如下:

[0058]

s54.对后台所有用户的特征数据进行归类;

[0059]

s55.根据归类后的用户特征数据建立用户画像,每一类用户画像对应于某一用户特征数据的区间,同时对应于某一种场景排序;

[0060]

s56.根据新用户操作完成该用户在用户画像上的归类,执行该类用户画像对应的场景排序。

[0061]

更进一步地,可实现场景的自主切换与选择,具体方法如下:

[0062]

s57.分析检测周围环境数据以取得周围环境的至少一个主体特征;

[0063]

s58.将每一场景的特征标准与该主体特征进行比对,若完成匹配则将场景自主切换至与主体特征匹配的特征标准所对应的场景。

[0064]

在所述的场景的自主切换与选择中,其特征标准可设定为人像占全图像比例的三分之一及以上,也可以是其他比例,例如四分之一、五分之一等,由厂家自行设定。

[0065]

实施例二,如图4所示,一种基于增强现实的智能眼镜系统在互动功能下的可视化场景叠加态可在实景通过所述的智能眼镜的镜片时叠加图像数据的可视化成像,实现互动功能的智能眼镜系统硬件如图5所示,包括智能眼镜本体三701、成像装置三601、感知模块三602、定位模块三605、通信模块三606、动作捕捉装置三603、服务器三607以及图像建模及触发设置端口三702。其中,所述的成像装置三601、感知模块三602、定位模块三605、通信模块三606、动作捕捉装置三603分别与所述的智能眼镜本体三701建立数据连接,所述的通信模块三606与所述的服务器三607采用远程通信方式建立数据连接,所述的图像建模及触发设置端口三702与所述的服务器三607建立数据连接。其中,感知模块三602可以为摄像头,也可以为激光雷达。

[0066]

如图6所示,实施例二中控制具备互动功能的基于增强现实的智能眼镜系统的方法如下:

[0067]

s29.通过在智能眼镜上的界面切换或选择进入互动场景的增强现实界面;

[0068]

s30.通过智能眼镜上的定位模块和感知模块获取实时gps信息和图像信息;

[0069]

s31.将实时gps信息和图像信息通过通信模块上传至服务器,与服务器所存储的开发端口制作的二/三维图像/视频数据所设置的gps位置与特征区域位置进行匹配;

[0070]

s32.匹配成功后服务器将对应匹配的二/三维图像/视频数据进行数据回传,通过智能眼镜的通信模块进行数据接收,通过智能眼镜的成像装置进行数据呈现,完成数据的静态/动态可视化呈现;

[0071]

s33.用户根据呈现的图像/视频数据进行相应操作与互动,通过动作捕捉装置完成用户操作的感应,若满足开发端口所设置的触发条件,则图像/视频数据根据开发端口所设置的变量进行可视化呈现。

[0072]

其中,实施例二的场景可进一步与其他具有知名度的主题结合实现联名场景的构建。

[0073]

更进一步地,为了更详细地描绘人的动作行为,在s33中所述的通过动作捕捉装置完成用户操作的感应,具体方法如下:

[0074]

s331.将人体等效为“质量-弹簧-阻尼”模型,如图7所示;

[0075]

s332.对人体进行集总建模,可将人体等效为弹簧-质量-阻尼模型,包括两个主要部分——人体各关键部位节点、地面;

[0076]

s333.设地面质量无穷大,在人体上取n个节点以更精确地描绘人体的行为动作细节,根据牛顿第二定律及每个节点手里关系列出人体各节点微分方程n个:

[0077][0078]

将上式写作矩阵形式:

[0079][0080][0081][0082][0083][0084]

根据微分方程列出质量矩阵、刚度矩阵、阻尼矩阵。

[0085][0086]

[0087]

c=αm+βk

[0088]

根据以上公式可知,每个节点所受力为f

n-mng,整个人体为一个物理系统,系统所受外力合力为人体的总质量;

[0089]

s334.通过速度传感器检测此时人体每个节点的速度,结合gps探测每个节点的三维坐标,得到γ0=(x0,y0,z0);即为每个节点速度初始值和位移初始值;

[0090]

s335.使用模态叠加法对方程进行解耦,并将质量矩阵、刚度矩阵、阻尼矩阵对角化,将方程从物理空间求解变到模态空间求解;

[0091]

s336.通过特殊算法或求解工具对方程进行迭代求解;

[0092]

s337.求出n阶模态后,将其叠加,得到物理空间各节点的速度、位移、以及加速度;

[0093]

s338.通过求解出的速度、位移、加速度构建任务移动的模型以及短时内移动的预测模型;

[0094]

具体地,如图7和图8所示,s338中所述的构建任务移动的模型以及短时内移动的预测模型的方法如下:

[0095]

s3381.如图9所示,取人体上九个关键节点,设采样九个点,头部2m、左边大臂1.5m、右边大臂1.5m、左边小臂m、右边小臂m、左边大腿2m、右边大腿2m、左边小腿1.5m、左边小腿1.5m。根据牛顿第二定律列写九阶微分方程,用以描绘人体移动信息;

[0096]

s3382.通过速度传感器检测此时人体每个节点的速度,结合gps探测每个节点的三维坐标,即为每个节点速度初始值和位移初始值,此处设每个节点初速度为零,初始位移为零;

[0097]

s3383.列出质量矩阵、刚度矩阵如下所示,根据模态叠加法,设c=αm+βk,将质量矩阵、刚度矩阵、阻尼矩阵同时对角化以简化求解;

[0098]

其中,质量矩阵为:

[0099][0100]

其中,刚度矩阵为:

(θi(t,s,...))为可视化模型的变量数据;f2(θi(m,n,...))为可视化模型的反馈数据;t,s,...为随时间变化而变化并对可视化模型产生影响的参量,例如时间、气候、光照、需进食量;m,n,...为传感器所感应得到的触发参量,例如喂食量、浇水量、互动量。

[0119]

一种基于增强现实的智能眼镜系统在交友功能下的可视化场景叠加态可在实景通过所述的智能眼镜的镜片时叠加相关综合数据的可视化成像,交友功能的智能眼镜为上述实施例中的一项或几项结合,完成智能眼镜间的数据交互,包括图像数据、文字数据和语音数据。

[0120]

一种基于增强现实的智能眼镜系统在导航功能下的可视化场景叠加态可在实景通过所述的智能眼镜的镜片时叠加相关位置数据的可视化成像,导航功能的智能眼镜为上述实施例中的一项或几项结合,完成智能眼镜间的数据交互,包括位置数据和图像数据。

[0121]

一种基于增强现实的智能眼镜系统在直播功能下的可视化场景叠加态可在实景通过所述的智能眼镜的镜片时叠加相关视频数据的可视化成像,直播功能的智能眼镜为上述实施例中的一项或几项结合,完成智能眼镜间的数据交互,包括位置数据和图像数据。

[0122]

其中,智能眼镜系统接入的服务器可以是中心部署的服务器,也可以是边缘部署的分布式服务器,服务器的数量不限。若服务器为分布式服务器,则可以布置在各个位置,智能眼镜可通过gps感应、网络感应、雷达感应等多种空间感应方式完成对分布式服务器的访问,分布式服务器可以布置在如公交车、店铺、学校、医院、事业单位、企业等公共空间内。

[0123]

实施例六,一种基于增强现实的分布式服务器智能眼镜系统包括若干布置于不同位置的分布式服务器和若干可接入网络的ar/mr/vr智能眼镜。一种控制分布式服务器智能眼镜系统的控制方法如下:

[0124]

s59.ar/mr/vr智能眼镜通过网络或gps或雷达或图像访问布置于该空间区域的分布式服务器;

[0125]

s60.被访问的分布式服务器通过数据通信将存储的二/三维图像/视频数据、音频数据、文字数据传输至访问的ar/mr/vr智能眼镜;

[0126]

s61.ar/mr/vr智能眼镜通过成像装置将所接收到的二/三维图像/视频数据、音频数据、文字数据进行可视化呈现。

[0127]

其中,ar/mr/vr智能眼镜通过网络访问布置于该空间区域的分布式服务器具体可以为:ar/mr/vr智能眼镜通过接入分布式服务器的无线局域网络完成访问。

[0128]

其中,ar/mr/vr智能眼镜通过gps访问布置于该空间区域的分布式服务器具体可以为:

[0129]

s591.分布式服务器上传所属区块的gps信息至云端;

[0130]

s592.云端将ar/mr/vr智能眼镜实时上传的gps信息与分布式服务器上传所属区块的gps信息进行比对;

[0131]

s593.若比对时完成匹配,由云端连接ar/mr/vr智能眼镜对对应匹配的分布式服务器进行访问。

[0132]

更进一步地,为了适应在可移动公共空间区域内布置的分布式服务器以及分布式服务器被移动的情况,每隔一定时间间隔对gps信息进行更新并上传;更进一步地,为了区分两种情况并且不占用传输资源提出以下方法:

[0133]

s594.在t1时间内对gps信息进行测量,若在t1时间内gps信息发生变化,则将该服

务器标记为移动区块内的分布式服务器并设置该分布式服务器每隔t2时间间隔对gps信息进行更新并上传;

[0134]

s595.若在t1时间内gps信息没有发生变化,则将将该服务器标记为固定区块内的分布式服务器并设置该分布式服务器每隔t3时间间隔对gps信息进行更新并上传。

[0135]

其中,t1<t3,t2<t3。其中,当固定的分布式服务器完成搬运后,不论它是被搬去固定区块还是移动区块,可以通过手动输入端启动s594和s595的测量。其中,在不同移动区块内的t2的值根据实际情况可以不同,例如不同的移动速度、不同的移动范围对t2的取值区间都有影响。为了避免移动区块在测量过程中出现在t1时间内已从原坐标出发移动一段时间后返回原坐标而并系统错误判定为固定区块,t1应该取得足够小。

[0136]

当然,上述方法只是系统自判别的方法,也可通过手动选择是移动区块还是固定区块来完成gps信息上传的时间间隔的设置。

[0137]

其中,ar/mr/vr智能眼镜通过雷达或图像访问布置于该空间区域的分布式服务器具体可以为:ar/mr/vr智能眼镜通过识别完成分布式服务器的确认,确认完成后通过建立数据连接完成访问。

[0138]

更进一步地,在所有分布式服务器上传的gps区域范围中若出现重合或交叉的情况,云端可通过划分区域或建立用户选择通道或二次条件输入的方法解决服务器数据链路的矛盾。

[0139]

其中,划分区域主要对分布式服务器进行有序规划,建立有序的分布式服务器智能眼镜系统数据通信机制。

[0140]

其中,建立用户选择通道是通过向用户ar/mr/vr智能眼镜的客户端发送选择窗口已手动完成访问/接入服务器的选择。

[0141]

其中,二次条件输入是通过获取用户ar/mr/vr智能眼镜感知模块的图像数据,通过与分布式服务器上所存储的识别数据或定位数据进行比对,计算相似度,选取相似度高的分布式服务器进行访问/接入。

[0142]

更进一步地,为了增加系统互动性,添加下述步骤:

[0143]

s62.ar/mr/vr智能眼镜可通过客户端输入数据信息或编辑已有的数据信息;

[0144]

s63.通过ar/mr/vr智能眼镜的通信模块上传至被访问的分布式服务器;

[0145]

s64.分布式服务器通过数据筛选及数据通信将客户端上传的数据更新信息更新在存储后台并将数据更新信息传输至每个访问的ar/mr/vr智能眼镜中;

[0146]

s65.ar/mr/vr智能眼镜通过成像装置对原本的二/三维图像/视频数据、音频数据、文字数据进行更新。

[0147]

更进一步地,为了防止客户端任意修改更新数据,对二/三维图像/视频数据、音频数据、文字数据有选择性地进行锁定,锁定后只允许分布式服务器对ar/mr/vr智能眼镜进行单向数据传输,不允许ar/mr/vr智能眼镜对分布式服务器进行数据传输。

[0148]

更进一步地,为了防止ar/mr/vr智能眼镜和特定分布式服务器进行数据通信时其他分布式服务器对其进行干扰,需在该分布式服务器上安装信号屏蔽模块,在所属区块内对其他分布式服务器数据进行屏蔽。

[0149]

其中,上述实施例中通过设备获取人为操作的装置可以是图像传感器、雷达传感器、触摸传感器、按键传感器、语音传感器等可以获取人类行为的装置。

[0150]

其中,上述实施例中进入某一场景是通过人为选择完成,也可以通过识别该区域是否设有场景来自动进入该场景,更进一步地,若识别到有多个场景,通过算法获取用户习惯完成场景选择并自动进入该场景。

[0151]

其中,本发明所保护的智能眼镜可以是只具备单独功能/单独场景的单一功能智能眼镜,也可以是具备多种功能/多种场景的多种功能智能眼镜,多种功能智能眼镜可以是单独功能/单独场景的两个及两个以上组合,包括硬件的组合和功能的组合。

[0152]

在本说明书的描述中,参考术语“一个实施例”、“一些实施例”、“示例”、“具体示例”、或“一些示例”等的描述意指结合该实施例或示例描述的具体特征、结构、材料或者特点包含于本技术的至少一个实施例或示例中。在本说明书中,对上述术语的示意性表述不必须针对的是相同的实施例或示例。而且,描述的具体特征、结构、材料或者特点可以在任一个或多个实施例或示例中以合适的方式结合。此外,在不相互矛盾的情况下,本领域的技术人员可以将本说明书中描述的不同实施例或示例以及不同实施例或示例的特征进行结合和组合。

[0153]

尽管上面已经示出和描述了本技术的实施例,可以理解的是,上述实施例是示例性的,不能理解为对本技术的限制,本领域的普通技术人员在本技术的范围内可以对上述实施例进行变化、修改、替换和变型。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1