用于获取融合多尺度第一和第二维感受野信息的方法、系统和计算机可读介质与流程

1.本技术涉及视频理解的领域,具体涉及一种用于获取融合多尺度第一和第二维感受野信息的方法、系统和计算机可读介质。

背景技术:

2.视频是当今大数据不可或缺的一部分。受图像和语音深度学习的进展的推动,使用深度学习技术来理解视频内容已成为最热门的话题之一。视频理解涉及分析视频片段,并解释其中发生的事情。视频分类专注于根据视频片段的语义内容(如人类行为或复杂事件)对视频片段进行自动分类/标记。

技术实现要素:

3.本技术的一个目的是提出一种用于获取融合多尺度第一和第二维感受野信息的方法、系统和计算机可读介质。

4.在本技术的第一方面,一种计算机实施的方法包括:融合来自所有多尺度第一维感受野和每一个多尺度第二维感受野的相应组合的信息,以获取与所述多尺度第二维感受野相应的来自多尺度第一和第二维感受野的信息;其中,第一维的所述多尺度第一维感受野是空间和时间中的一个,第二维的所述多尺度第二维感受野是空间和时间中的另一个;每一个所述多尺度第二维感受野由相应的第一卷积神经网络操作集提供,并且所述第一卷积神经网络操作集中的每一个操作具有相应的第一维局部到局部约束;和融合所述来自多尺度第一和第二维感受野的组合的信息,以获取融合多尺度第一和第二维感受野信息。

5.在本技术的第二方面,一种系统包括至少一个内存和处理器模块。至少一个内存配置为存储程序指令。处理器模块配置为执行程序指令,该程序指令使处理器模块执行以下步骤:融合来自所有多尺度第一维感受野和每一个多尺度第二维感受野的相应组合的信息,以获取与所述多尺度第二维感受野相应的来自多尺度第一和第二维感受野的信息;其中,第一维的所述多尺度第一维感受野是空间和时间中的一个,第二维的所述多尺度第二维感受野是空间和时间中的另一个;每一个所述多尺度第二维感受野由相应的第一卷积神经网络操作集提供,并且所述第一卷积神经网络操作集中的每一个操作具有相应的第一维局部到局部约束;和融合所述来自多尺度第一和第二维感受野的组合的信息,以获取融合多尺度第一和第二维感受野信息。

6.在本技术的第三方面,提供了一种其上存储有程序指令的非暂时性计算机可读介质。当程序指令由处理器模块执行时,使处理器模块执行以下步骤:融合来自所有多尺度第一维感受野和每一个多尺度第二维感受野的相应组合的信息,以获取与所述多尺度第二维感受野相应的来自多尺度第一和第二维感受野的信息;其中,第一维的所述多尺度第一维感受野是空间和时间中的一个,第二维的所述多尺度第二维感受野是空间和时间中的另一个;每一个所述多尺度第二维感受野由相应的第一卷积神经网络操作集提供,并且所述第

一卷积神经网络操作集中的每一个操作具有相应的第一维局部到局部约束;和融合所述来自多尺度第一和第二维感受野的组合的信息,以获取融合多尺度第一和第二维感受野信息。

附图说明

7.为更清楚地说明本技术或相关技术的实施例,简要介绍了将在实施例中进行描述的以下附图。显然,这些附图仅是本技术的一些实施例,本领域普通技术人员可以在不付出创造性劳动的前提下,根据这些附图获取其他附图。

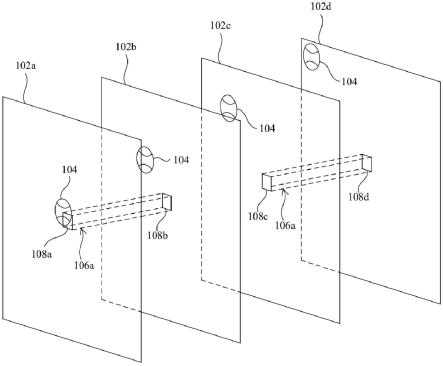

8.图1a和图1b是示出第一卷积神经网络操作集的相应操作的示意图,在对输入特征图序列执行以获取时间重要性时,第一卷积神经网络操作集中的每一个操作具有空间局部到局部约束。

9.图2a和图2b是示出第一卷积神经网络操作集的相应操作的示意图,在对输入特征图序列执行以获取空间重要性时,第一卷积神经网络操作集中的每一个操作具有时间局部到局部约束。

10.图3a和图3b是示出第一卷积神经网络操作集的相应操作的示意图,在对输入特征图序列执行以获取时间重要性时,第一卷积神经网络操作集中的每一个操作具有空间局部到局部约束。

11.图4a和图4b是示出第一卷积神经网络操作集的相应操作的示意图,在对输入特征图序列执行以获取空间重要性时,第一卷积神经网络操作集中的每一个操作具有时间局部到局部约束。

12.图5是示出根据本技术一实施例的终端中的输入、处理和输出硬件模块的框图。

13.图6是示出根据本技术一实施例的融合多尺度第一和第二维感受野信息获取模块的框图。

14.图7是示出根据本技术一实施例的图6中的多尺度第一和第二维感受野信息获取模块的框图,多尺度第一和第二维感受野信息获取模块包括图7中的模块。

15.图8是示出根据本技术一实施例的感受野的组合的图,该感受野的组合对应于图7中的多尺度第一和第二维感受野信息获取模块中的模块以及图6中的融合多尺度第一和第二维感受野信息获取模块中的模块所执行的步骤。

16.图9是示出根据本技术一实施例的图7中的融合多尺度第一维感受野信息获取模块,以及图7及图6中与图9中的融合多尺度第一维感受野信息获取模块相应的模块的框图,融合多尺度第一维感受野信息获取模块包括图9中的模块。

17.图10是示出根据本技术一实施例的图7中的融合多尺度第一维感受野信息获取模块,以及图7及图6中与图10中的融合多尺度第一维感受野信息获取模块相应的模块的框图,融合多尺度第一维感受野信息获取模块包括图10中的模块。

18.图11是示出根据本技术一实施例的图10中第一维重要性获取模块的细节的示意图。

19.图12是示出根据本技术一实施例的图10中的多融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块以及重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息获取模块的细节的框图。

20.图13是示出根据本技术一实施例的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块的框图。

21.图14是示出根据本技术一实施例的由融合时间重要性和输入特征图序列获取模块所获取的具有至少一个更合适时间尺度的上下文的示意图。

22.图15是示出根据本技术一实施例的融合多尺度第一维感受野信息获取模块的背景抑制效果的示意图。

23.图16是示出根据本技术一实施例的由图9中的融合多尺度第一和第二维感受野信息获取模块所获取的具有全局和最精细空间尺度和重要时间尺度的上下文的示意图。

24.图17是示出根据本技术一实施例的由图10中的融合多尺度第一和第二维感受野信息获取模块所获取的具有重要空间尺度和重要时间尺度的上下文的示意图。

25.图18是示出根据本技术一实施例的图6中的多尺度第一和第二维感受野信息获取模块的框图,多尺度第一和第二维感受野信息获取模块包括图18中的模块。

26.图19是示出根据本技术一实施例的感受野的组合的图,该感受野的组合对应于图18中的多尺度第一和第二维感受野信息获取模块中的模块以及图6中的融合多尺度第一和第二维感受野信息获取模块中的模块所执行的步骤。

27.图20是示出根据本技术一实施例的具有多个融合多尺度第一和第二维感受野信息获取模块和多尺度第一维感受野信息获取模块的可分离3d resnet-50网络的示意图。

28.图21是示出根据本技术一实施例的3d残差块的框图。

29.图22是示出根据本技术一实施例的3d残差块的框图。

具体实施方式

30.下面结合附图对本技术实施例的技术内容、结构特征、达到的目的和效果进行详细说明。具体地,本技术实施例中的术语仅用于说明特定实施例的目的,并不用于限制本技术。

31.不同附图中相同的附图标记表示基本相同的元件,对于基本相同的元件,其中一个元件的描述适用于其他元件。

32.本技术中的术语“使用至少一个对象执行至少一个操作”是指至少一个对象被直接用于执行至少一个操作的情况,或者至少一个对象被至少一个中间操作修改,并且修改后的至少一个对象直接用于执行至少一个操作的情况。

33.本技术中的术语“至少一个对象是使用机构获取的”是指获取至少一个对象的步骤包括执行该机构。

34.本技术中的术语“对至少一个对象执行至少一个操作”是指直接使用至少一个对象执行至少一个操作的情况。

35.本技术中的术语“执行至少一个操作来实现结果”是指执行至少一个操作以直接实现结果的情况,或者在至少一个操作之后存在至少一个中间操作以实现结果的情况。

36.在相关技术中,当视频片段的每一帧中包含大量不相关或不重要信息时,视频分类不考虑这些信息是否不相关或不重要,从而影响分类准确性。本技术的一些实施例获取第二维重要性,以强制计算机视觉卷积神经网络(cnn,convolutional neural network)聚焦于第二维域中的重要区域。为获取第二维重要性而执行的第一卷积神经网络操作集的每

一个操作具有第一维局部到局部约束。第一维可以是空间和时间中的一个,而第二维可以是空间和时间中的另一个。

37.图1a和图1b是示出第一卷积神经网络操作集的相应操作106a和106b的示意图,在对输入特征图序列102执行以获取时间重要性时,第一卷积神经网络操作集中的每一个操作具有空间局部到局部约束。第一卷积神经网络操作集包括图1a中的操作106a和图1b中的操作106b,图1a中的操作106a和图1b中的操作106b被对输入特征图序列102执行以获取时间重要性。在图1a和图1b的示例中,输入特征图序列102的大小为t x hx w,其中t、h和w分别表示时间、高度和宽度维度。第一卷积神经网络操作集的操作106a和操作106b是时间池化操作,这些时间池化操作的池化窗口大小分别为t/2和t。第一卷积神经网络操作集的操作106a和操作106b中的每一个具有相应的空间局部到局部约束。也就是说,当对输入特征图序列102执行第一卷积神经网络操作集的操作106a时,由于第一卷积神经网络操作集的操作106a的时空感受野的单一原始尺度的空间部分的尺度,因此第一卷积神经网络操作集的操作106a一次仅看到输入特征图序列102中的并置的局部空间区域108a和108b,且一次仅看到输入特征图序列102中的并置的局部空间区域108c和108d。当对输入特征图序列102执行第一卷积神经网络操作集的操作106b时,由于第一卷积神经网络操作集的操作106b的时空感受野的单一原始尺度的空间部分的尺度,因此第一卷积神经网络操作集的操作106b一次仅看到输入特征图序列102中并置的局部空间区域108a、108b、108c和108d。局部空间区域108a、108b、108c和108d是输入特征图序列102的相应原始空间区域。在图1a和图1b的示例中,并置的局部空间区域是并置的像素。棒球104从与输入特征图序列102中的输入特征图102a相应的视频帧的中心飞到与输入特征图序列102中的输入特征图102d相应的视频帧的左上角。因此,池化窗口大小为t的第一卷积神经网络操作集的操作106b提供的上下文的时间尺度比池化窗口大小为t/2的第一卷积神经网络操作集的操作106a提供的上下文的时间尺度更合适。然而,由于第一卷积神经网络操作集的操作106b的空间局部到局部约束,因此第一卷积神经网络操作集的操作106b不知道与输入特征图102a、102b、102c和102d相应的视频帧中棒球104的整个飞行轨迹。本技术一些实施例的一个优点是,在获取时间重要性时,可以获取具有至少一个更合适时空尺度的上下文,从而提高分类准确度。在上述示例中,具有更合适时空尺度的上下文可以在与输入特征图102a、102b、102c和102相应的相应视频帧中反映棒球104的整个飞行轨迹。

38.图2a和图2b是示出第一卷积神经网络操作集的相应操作206a和206b的示意图,在对输入特征图序列202执行以获取空间重要性时,第一卷积神经网络操作集中的每一个操作都具有时间局部到局部约束。第一卷积神经网络操作集包括图2a中的操作206a和图2b中的操作206b,图2a中的操作206a和图2b中的操作206b被对输入特征图序列102执行以获取时间重要性。在图2a和图2b的示例中,输入特征图序列102的大小为t x hx w,其中t、h和w分别表示时间、高度和宽度维度。第一卷积神经网络操作集的操作206a和操作206b是空间池化操作,这些空间池化操作的池化窗口大小分别为(h/4)x(h/4)和(h/2)x h/2)。第一卷积神经网络操作集的操作206a和操作206b中的每一个具有相应的时间局部到局部约束。也就是说,当对输入特征图序列202执行第一卷积神经网络操作集的操作206a时,由于第一卷积神经网络操作集的操作206a的时空感受野的单一原始尺度的时间部分的尺度,因此第一卷积神经网络操作集的操作206a一次仅看到与输入特征图序列202的局部时间部分210a相

应的空间区域208a,一次仅看到与输入特征图序列202的局部时间部分210b相应的空间区域208b,一次仅看到与输入特征图序列202的局部时间部分210c相应的空间区域208c,且一次仅看到与输入特征图序列202的局部时间部分210d相应的空间区域208d。当对输入特征图序列202执行第一卷积神经网络操作集的操作206b时,由于第一卷积神经网络操作集的操作206b的时空感受野的单一原始尺度的时间部分的尺度,因此第一卷积神经网络操作集的操作206b一次仅看到与输入特征图序列202的局部时间部分210a相应的空间区域212a,一次仅看到与输入特征图序列202的局部时间部分210b相应的空间区域212b,一次仅看到与输入特征图序列202的局部时间部分210c相应的空间区域212c,且一次仅看到与输入特征图序列202的局部时间部分210d相应的空间区域212d。局部时间部分210a、210b、210c和210d是输入特征图序列202的相应原始时间部分。在图2a和图2b的示例中,每一个局部时间部分大小为t/t。棒球204从与输入特征图序列202中的输入特征图202a相应的视频帧的中心飞到与输入特征图序列202中的输入特征图202d的相应的视频帧的左上角。因此,池化窗口大小为(h/2)x(h/2)的第一卷积神经网络操作集的操作206b提供的上下文的空间尺度比池化窗口大小为(h/4)x(h/4)的第一卷积神经网络操作集的操作206a提供的上下文的空间尺度更合适。然而,由于第一卷积神经网络操作集的操作206b的时间局部到局部约束,因此第一卷积神经网络操作集的操作206b不知道与输入特征图202a、202b、202c和202d相应的视频帧中棒球204的整个飞行轨迹。本技术一些实施例的一个优点是,在获取空间重要性时,可以获取具有至少一个更合适时空尺度的上下文,从而提高分类准确度。在上述示例中,具有更合适时空尺度的上下文可以在与输入特征图202a、202b、202c和202d相应的相应视频帧中反映棒球204的整个飞行轨迹。

39.图3a和图3b是示出第一卷积神经网络操作集的相应操作306a和306b的示意图,在对输入特征图序列102执行以获取时间重要性时,第一卷积神经网络操作集的每一个操作都具有空间局部到局部约束。与图1a和图1b中的示例相比,图3a和图3b中的示例的不同之处如下。第一卷积神经网络操作集的操作306a和操作306b是3d池化操作,这些3d池化操作相应的池化窗口大小分别为(t/2)x(h/4)x(w/4)和(t)x(h/4)x(w/4)。对于第一卷积神经网络操作集的操作306a的空间局部到局部约束,并置的局部空间区域308a和308b是并置的(h/4)x(w/4)区域,并且并置的局部空间区域308c和308d是并置的(h/4)x(w/4)区域。对于第一卷积神经网络操作集的操作306b的空间局部到局部约束,并置的局部空间区域308a、308b、308c和308d是并置的(h/4)x(w/4)区域。局部空间区域308a、308b、308c和308d是输入特征图序列102的相应原始空间区域。与图1a和图1b中的示例相似,池化窗口大小为t的第一卷积神经网络操作集的操作306b提供的上下文的时间尺度比池化窗口大小为t/2第一卷积神经网络操作集的操作306a提供的上下文的时间尺度更合适。然而,由于第一卷积神经网络操作集的操作306b的空间局部到局部约束,因此第一卷积神经网络操作集的操作306b不知道与输入特征图102a、102b、102c和102d相应的视频帧中棒球104的整个飞行轨迹。本技术一些实施例的一个优点是,在获取时间重要性时可以获取具有至少一个更合适时空尺度的上下文,从而提高分类准确度。在上述示例中,具有更合适时空尺度的上下文可以在与输入特征图102a、102b、102c和102d相应的相应视频帧中反映棒球104的整个飞行轨迹。

40.图4a和图4b是示出第一卷积神经网络操作集的相应操作406a和406b的示意图,当对输入特征图序列202执行以获取空间重要性时,第一卷积神经网络操作集的每一个操作

都具有时间局部到局部约束。与图2a和图2b中的示例相比。图4a和图4b中的示例的不同之处如下。第一卷积神经网络操作集的操作406a和操作406b是3d池化操作,这些3d池化操作的池化窗口大小分别为(t/2)x(h/4)x(w/4)和(t/2)x(h/2)x(w/2)。对于第一卷积神经网络操作集的操作406a的时间局部到局部约束,输入特征图序列202的局部时间部分410a的大小为t/2,输入特征图序列202的局部时间部分410b的大小为t/2。对于第一卷积神经网络操作集的操作406b的时间局部到局部约束,输入特征图序列202的局部时间部分410a的大小为t/2,输入特征图序列202的局部时间部分410b的大小为t/2。局部时间部分410a、410b、410c和410d是输入特征图序列202的相应原始时间部分。与图2a和图2b中的示例相似,池化窗口大小为(h/2)x(h/2)的第一卷积神经网络操作集的操作406b提供的上下文的空间尺度比池化窗口大小为(h/4)x(h/4)的第一卷积神经网络操作集的操作406a提供的上下文的空间尺度更合适。然而,由于第一卷积神经网络操作集的操作406b的时间局部到局部约束,因此第一卷积神经网络操作集的操作406b不知道与输入特征图202a、202b、202c和202d相应的视频帧中棒球204的整个飞行轨迹。本技术一些实施例的一个优点是,在获取空间重要性时,可以获取具有至少一个更合适的时空尺度的上下文,从而提高分类准确度。在上述示例中,具有更合适时空尺度的上下文可以在与输入特征图202a、202b、202c和202d相应的相应视频帧中反映棒球204的整个飞行轨迹。

41.图5是示出根据本技术一实施例的终端500中的输入、处理和输出硬件模块的框图。如图5所示,终端500包括相机模块502、处理器模块504、内存模块506、显示模块508、存储模块510、有线或无线通信模块512和总线514。终端500可以是手机、智能手机、平板电脑、笔记本电脑、台式电脑或任何具有足够计算能力来执行视频理解的电子设备。

42.摄像头模块502为输入硬件模块,用于采集视频片段2002(示例性地标记在图20中),视频片段2002通过总线514传输到处理器模块504。相机模块502包括rgb(red-green-blue,红-绿-蓝)相机或灰度相机。或者,视频片段2002可以是使用其它的输入硬件模块获取的,比如存储模块510,或者有线或无线通信模块512。存储模块510用于存储视频片段2002,视频片段2002通过总线514传输至处理器模块504。有线或无线通信模块512用于通过有线或无线通信从网络接收视频片段2002,视频片段2002通过总线514传输至处理器模块504。

43.内存模块506存储推理阶段程序指令,处理器模块504执行推理阶段程序指令,使得处理器模块504实现计算机视觉cnn(比如可分离3d resnet-50网络2000,可分离3dresnet-50网络2000具有多个融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块g1至g2,和h1至h3,将参阅图20进行描述),以处理视频片段。内存模块506可以是包括至少一个内存的瞬态或非瞬态计算机可读介质。处理器模块504包括至少一个处理器,该处理器直接或间接地经由总线514向相机模块502、内存模块506、显示模块508、存储模块510和有线或无线通信模块512发送信号和/或从相机模块502、内存模块506、显示模块508、存储模块510和有线或无线通信模块512接收信号。至少一个处理器可以是中央处理单元(cpu,central processing unit)、图形处理单元(gpu,graphics processing unit)和/或数字信号处理器(dsp,digital signal process)。cpu可以通过总线514将面部图像508、一些程序指令和其他数据或指令发送到gpu和/或dsp。

44.显示模块508为输出硬件模块,用于显示计算机视觉cnn获取的结果。或者,计算机

视觉cnn获取的结果可以通过其他的输出硬件模块输出,例如存储模块510,或者有线或无线通信模块512。存储模块510用于存储计算机视觉cnn得到的结果。有线或无线通信模块512用于将计算机视觉cnn获取的结果通过有线或无线通信方式传输至网络。输出硬件模块通过总线514从处理器模块504接收计算机视觉cnn获取的结果。

45.在上述实施例中,终端500是一种计算系统,其所有组件通过总线514集成在一起。其他类型的计算系统,例如具有远程摄像头模块而不是摄像头模块502的计算系统在本技术的涵盖范围之内。

46.图6是示出根据本技术一实施例的融合多尺度第一和第二维感受野信息获取模块600的框图。通过将融合多尺度第一和第二维感受野信息获取模块600应用于计算机视觉cnn,使得计算机视觉cnn聚焦于第二维域中的第一维上下文增强重要区域。在本技术中,第一维可以是空间和时间中的一个,而第二维可以是空间和时间中的另一个。融合多尺度第一和第二维感受野信息获取模块600配置为使用输入特征图序列606获取融合多尺度第一和第二维感受野信息610。融合多尺度第一和第二维感受野信息获取模块600包括多尺度第一和第二维感受野信息获取模块602和多尺度第一和第二维感受野信息融合模块604。

47.多尺度第一和第二维感受野信息获取模块602配置为使用输入特征图序列606融合来自所有多尺度第一维感受野和每一个多尺度第二维感受野的相应组合的信息,以获取与所述多尺度第二维感受野相应的来自多尺度第一和第二维感受野的信息608。多尺度第一和第二维感受野信息获取模块602执行提供每一个多尺度第二维感受野的相应第一卷积神经网络操作集。第一卷积神经网络操作集的每一个操作具有相应的第一维局部到局部约束。

48.多尺度第一和第二维感受野信息融合模块604配置为融合来自多尺度第一和第二维感受野的组合的信息608以获取融合多尺度第一和第二维感受野信息610。

49.图7是示出根据本技术一实施例的图6中的多尺度第一和第二维感受野信息获取模块602的框图,多尺度第一和第二维感受野信息获取模块602包括图7中的模块702和模块704。多尺度第一和第二维感受野信息获取模块602包括融合多尺度第一维感受野信息获取模块702和多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704。

50.融合多尺度第一维感受野信息获取模块702配置为使用输入特征图序列606执行至少一个第二卷积神经网络操作以获取融合多尺度第一维感受野信息706。多尺度第一维感受野中的至少一个由相应的至少一个第二卷积神经网络操作提供,其中多尺度第一维感受野中的至少一个的尺度大于多尺度第一维感受野的最小尺度。

51.多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704配置为使用融合多尺度第一维感受野信息706执行多个第三卷积神经网络操作中的每一个,以获取相应的融合多第一维尺度和单一第二维尺度第一和第二维感受野信息708。每一个第一卷积神经网络操作集是提供相应一个多尺度第二维感受野的相应第三卷积神经网络操作。所有第三卷积神经网络操作的相应融合多第一维尺度和单一第二维尺度第一和第二维感受野信息708是来自多尺度第一和第二维感受野的信息608。

52.图8是示出根据本技术一实施例的感受野的组合的示意图,该感受野的组合对应于图7中的多尺度第一和第二维感受野信息获取模块602中的模块702和704以及图6中的融合多尺度第一和第二维感受野信息获取模块600中的模块604所执行的步骤。在图8的示例

中,对于融合多尺度第一维感受野信息获取模块702,至少一个第二卷积神经网络操作被执行。示例性地,至少一个第二卷积神经网络操作包括多尺度第一维感受野802和804中的至少一个。融合多尺度第一维感受野信息706被获取。也就是说,来自多尺度第一维感受野802和804的组合810的信息被融合。

53.对于多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704,第三卷积神经网络操作中的每一个被执行。示例性地,第三卷积神经网络操作包括两个操作,这两个操作相应地具有多尺度第二维感受野806和808。使用融合多尺度第一维感受野信息706执行第三卷积神经网络操作中的每一个,以获取相应的融合多第一维尺度和单一第二维尺度第一和第二维感受野信息708。也就是说,来自所有多尺度第一维感受野802和804与多尺度第二维感受野806和808中的每一个的相应组合812或814的信息被融合。所有第三卷积神经网络操作的相应融合多第一维尺度和单一第二维尺度第一和第二维感受野信息708是来自多尺度第一和第二维感受野的信息608。也就是说,来自多尺度第一和第二维感受野的信息608是来自所有多尺度第一维感受野802和804和多尺度第二维感受野806和808中的一个806的组合812,以及所有多尺度第一维感受野802和804与多尺度第二维感受野806和808的另一个808的组合814的信息。

54.对于多尺度第一和第二维感受野信息融合模块604,来自多尺度第一和第二维感受野的组合的信息608被融合以获取融合多尺度第一和第二维感受野信息610。也就是说,来自所有多尺度第一维感受野802和804和多尺度第二维感受野806和808中的一个806的组合812以及所有多尺度第一维感受野802和804和多尺度第二维感受野806和808中的另一个808的组合814的组合816的信息被融合。

55.图9是示出根据本技术一实施例的图7中的融合多尺度第一维感受野信息获取模块702,以及图7及图6中与图9中的融合多尺度第一维感受野信息获取模块702相应的模块704和604的框图,融合多尺度第一维感受野信息获取模块702包括图9中的模块902和904。

56.融合多尺度第一维感受野信息获取模块702包括全局第一维信息获取模块902和全局第一维信息和输入特征图序列融合模块904。

57.全局第一维信息获取模块902配置为使用输入特征图序列606执行至少一个第二卷积神经网络操作以获取全局第一维信息910。如图8所示,至少一个第二卷积神经网络操作仅有一个操作,该操作具有多尺度第一维感受野802和804中的一个802。多尺度第一维感受野802和804中的一个802具有全局尺度。

58.全局第一维信息和输入特征图序列融合模块904配置为融合全局第一维信息910和输入特征图序列606,以获取融合全局和最精细尺度第一维感受野信息912。在一个实施例中,全局第一维信息和输入特征图序列融合模块904所执行的融合是逐元素求和操作。如图8所示,输入特征图序列606是通过具有多尺度第一维感受野802和804中的另一个804的操作获取的。因为多尺度第一维感受野802和804中的另一个804直接是获取输入特征图序列606的操作的第一维感受野的尺度,而不是将输入特征图序列606作为输入的至少一个第二卷积神经网络操作中的一个操作的第一维感受野的尺度,所以多尺度第一维感受野802和804中的另一个804具有最精细尺度。通过融合全局第一维信息910和输入特征图序列606,来自多尺度第一维感受野802和804的组合810的信息被融合。

59.如图9所示,相应地,多融合多第一维尺度和单一第二维尺度第一和第二维感受野

信息获取模块704包括多融合全局和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块906。多融合全局和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块906配置为使用融合全局和最精细尺度第一维感受野信息912执行每一个第三卷积神经网络操作,以获取相应的融合全局和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息914。所有第三卷积神经网络操作的相应融合全局和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息914是来自多尺度第一和第二维感受野的信息608。

60.相应地,多尺度第一和第二维感受野信息融合模块604包括全局和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块908。全局和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块908配置为融合来自多尺度第一和第二维感受野的信息608,以获取全局和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息916。

61.图8中感受野的相应组合经必要修改后适用于本实施例,图8中感受野的相应组合对应于上文所描述的图7中的多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704和图6中多尺度第一和第二维感受野信息融合模块604所执行的相应步骤。

62.图10是示出根据本技术一实施例的图7中的融合多尺度第一维感受野信息获取模块702,以及图7及图6中与图10中的融合多尺度第一维感受野信息获取模块702相应的模块704和604的框图,融合多尺度第一维感受野信息获取模块702包括图10中的模块1002和1004。

63.融合多尺度第一维感受野信息获取模块702包括第一维重要性获取模块1002和第一维重要性和输入特征图序列融合模块1004。

64.第一维重要性获取模块1002配置为使用输入特征图序列606执行至少一个第二卷积神经网络操作以获取第一维重要性1010。如图8所示,示例性地,至少一个第二卷积神经网络操作具有两个操作,这两个操作相应地具有多尺度第一维感受野802、804和818(未示出)中的一个802和多尺度第一维感受野802、804和818(未示出)中的另一个804。多尺度第一维感受野802、804和818(未示出)中的一个802具有全局尺度。多尺度第一维感受野802、804和818中的另一个804(未示出)具有比全局尺度更精细的尺度。具有不同相应尺度的相应第一维感受野的其他数量的第二卷积神经网络操作在本技术的涵盖范围内。

65.第一维重要性和输入特征图序列融合模块1004配置为融合第一维重要性1010和输入特征图序列606以获取融合重要和最精细尺度第一维感受野信息1012。在一个实施例中,第一维重要性和输入特征图序列融合模块1004所执行的融合是逐元素求和操作。第一维重要性1010作为残差信息被添加到输入特征图序列606中。还如图8所示,输入特征图序列606是通过具有多尺度第一维感受野802、804和818(未示出)中的又一个818(未示出)的操作来获取的。因为多尺度第一维感受野802、804和818(未示出)的又一个818(未示出)直接是获取输入特征图序列606的操作的第一维感受野的尺度,而不是将输入特征图序列606作为输入的至少一个第二卷积神经网络操作中的一个操作的第一维感受野的尺度,所以多尺度第一维感受野802,804和818(未示出)中的又一个818(未示出)具有最精细的尺度。通过融合第一维重要性1010和输入特征图序列606,来自多尺度第一维感受野802、804和818

(未示出)的组合810的信息被融合。

66.如图10所示,相应地,多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704包括多融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1006。多融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1006配置为使用融合重要和最精细尺度第一维感受野信息1012执行每一个第三卷积神经网络操作,以获取融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息1014。所有第三卷积神经网络操作的相应融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息1014是来自多尺度第一和第二维感受野的信息608。

67.相应地,多尺度第一和第二维感受野信息融合模块604包括重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008。重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008配置为融合来自多尺度第一和第二维感受野的信息608,以获取重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息1016。重要第一维尺度和重要第二维尺度第一和第二维感受野信息在本技术中也被称为第一和第二维重要性。

68.图8中感受野的相应组合经必要修改后适用于本实施例,图8中感受野的相应组合对应于前文所描述的图7中的多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704和图6中多尺度第一和第二维感受野信息融合模块604所执行的相应步骤。

69.第一维重要性和输入特征图序列融合模块1004是可选的。在一些实施例中,融合多尺度第一维感受野信息获取模块702仅包括第一维重要性获取模块1002。

70.图11是根据本技术一实施例的图10中第一维重要性获取模块1002的细节的示意图。第一维重要性获取模块1002配置为使用输入特征图序列606执行至少一个第二卷积神经网络操作以获取第一维重要性1010。在一个实施例中,输入特征图序列606是输入特征图序列1114。输入特征图序列1114的大小为t x h x w,其中t、h和w分别表示时间、高度和宽度维度。至少一个第二卷积神经网络操作是空间池化操作集1102。空间池化操作集1102包括多个空间池化操作1102a、1102b和1102c。空间池化操作1102a、1102b和1102c具有不同的尺度以捕捉不同分辨率的空间信息。空间池化操作1102a使用h x w的池化窗口大小将输入特征图序列1114空间池化为空间池化操作1102a的输出特征图序列1116a,其中空间池化操作1102a的输出特征图序列1116a的大小为t x 1 x 1。空间池化操作1102b使用(h/2)x(w/2)的池化窗口大小将输入特征图序列1114空间池化为空间池化操作1102b的输出特征图序列1116b,其中输出特征图空间池化操作1102b的输出特征图序列1116b的大小为t x 2 x 2。空间池化操作1102c使用(h/4)x(w/4)的池化窗口大小将输入特征图序列1114空间池化为空间池化操作1102c的输出特征图序列1116c,其中输出特征图空间池化操作1102c的输出特征图序列1116c具有t x 4 x 4的大小。优选地,每一个空间池化操作1102a、1102b或1102c是最大池化操作,因为第一维重要性获取模块1002试图捕获最高响应以确定哪个区域对于视频分类更重要。或者,每一个空间池化操作1102a、1102b或1102c可以是平均池化操作。

71.与至少一个第二卷积神经网络操作是空间池化操作集1102的上述实施例相比,至

少一个第二卷积神经网络操作是包括多个空间扩张卷积操作的空间扩张卷积操作集的替代实施例如下。上述实施例通过空间池化操作的相应不同窗口大小来实现多尺度空间感受野。替代实施例通过空间扩张卷积操作的相应不同扩张率来实现多尺度空间感受野。

72.在执行空间池化操作集1102之后,第一维重要性获取模块1002进一步执行重缩放(rescaling)操作集1104、连接(concatenating)操作1106,然后执行减少通道大小(csr,channel size reducing)操作1108,以融合空间池化操作集1102的输出特征图序列1116。对每一个相应空间池化操作1102a、1102b或1102c的输出特征图序列1116a、1116b或1116c进行空间二次采样。重缩放操作集1104包括多个重缩放操作1104a、1104b和1104c。每一个重缩放操作1104a、1104b或1104c将相应空间池化操作1102a、1102b或1102c的相应输出特征图序列1116a、1116b或1116c重缩放回每一个重缩放操作1104a、1104b或1104c的相应输出特征图序列1118a、1118b或1118c。每一个相应重缩放操作1104a、1104b或1104c的输出特征图序列1118a、1118b或1118c的大小为t x h x w。每一个重缩放操作1104a、1104b或1104c可以是内插操作,例如双线性内插操作。或者,每一个重缩放操作1104a、1104b或1104c可以是反卷积操作。连接操作1106沿通道轴连接重缩放操作集1104的相应输出特征图序列1118a、1118b和1118c,使得连接操作1106的输出特征图序列1120大小为t x h x w x 3。将csr操作1108应用于连接操作1106的输出特征图序列1120以获取大小为t x h x w x 1的csr操作1108的输出特征图序列1122。csr操作1208可以是1 x 1 x 1卷积操作。或者,csr操作1208可以是逐元素求和操作。对于至少一个第二卷积神经网络操作是空间扩张卷积操作集的替代实施例,可以不需要重缩放操作集1104。

73.在执行csr操作1108之后,第一维重要性获取模块1002进一步使用csr操作1108的输出特征图序列1122执行空间注意力图序列获取(spatial attention map sequence obtaining)操作1110以获取空间注意力图序列1124。空间注意力图序列获取操作1110可以是softmax函数。或者,空间注意力图序列获取操作1110可以是sigmoid函数。然后,第一维重要性获取模块1002进一步对输入特征图序列1114和空间注意力图序列1124执行逐元素乘法操作1112以获取空间重要性1126。在本实施例中,第一维重要性1010是空间重要性1126。

74.与执行空间注意力图序列获取操作1110以获取空间重要性1126的上述实施例相比,在没有空间注意力图序列获取操作1110的情况下获取空间重要性1126的替代实施例如下。csr操作1108的输出特征图序列1122直接作为空间重要性1126。

75.图12是示出根据本技术一实施例的图10中的多融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1006以及重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008的细节的框图。

76.多融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1006配置为使用融合重要和最精细尺度第一维感受野信息1012执行第三卷积神经网络操作中的每一个操作,以获取相应的融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息1014。在一个实施例中,融合重要和最精细尺度第一维感受野信息1012是融合重要和最精细尺度空间感受野信息1210。融合重要和最精细尺度空间感受野信息1210的大小为t x h x w,其中t、h和w分别表示时间、高度和宽度维度。第三卷积神经网络操作是时间池化操作集1202。时间池化操作集1202包括多个时间池化操作1202a、

1202b和1202c。时间池化操作1202a、1202b和1202c具有不同的尺度以捕捉不同分辨率的时间信息。时间池化操作1202a使用大小为t的池化窗口将融合重要和最精细尺度空间感受野信息1210时间池化到时间池化操作1202a的输出特征图集1212a中,其中时间池化操作1202a的输出特征图集1212a的大小为1 x h x w。时间池化操作1202b使用大小为t/2的池化窗口将融合重要和最精细尺度空间感受野信息1210时间池化到时间池化操作1202b的输出特征图集1212b中,其中时间池化操作1202b的输出特征图集1212b大小为2 x h x w。时间池化操作1202c使用大小为t/4的池化窗口将融合重要和最精细尺度空间感受野信息1210时间池化到时间池化操作1202c的输出特征图集1212c中,其中时间池化操作1202c的输出特征图集1212c的大小为4 x h x w。每一个时间池化操作1202a、1202b或1202c是平均池化操作。或者,每一个时间池化操作1202a、1202b或1202c可以是最大池化操作。在本实施例中,相应的融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息1014是时间池化操作1202a的输出特征图集1212a、时间池化操作1202b的输出特征图集1212b以及时间池化操作1202c的输出特征图集1212c中的每一个。

77.与第三卷积神经网络操作为时间池化操作集1202的上述实施例相比,第三卷积神经网络操作为包括多个时间扩张卷积操作的时间扩张卷积操作集的替代实施例如下。上述实施例通过时间池化操作的相应不同窗口大小实现多尺度时间感受野。替代实施例通过时间扩张卷积操作的相应不同扩张率实现多尺度时间感受野。

78.重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008配置为融合来自多尺度第一和第二维感受野的信息608,以获取重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息1016。在本实施例中,来自多尺度第一和第二维感受野的信息608是时间池化操作1202a的输出特征图集1212a,输出特征图集时间池化操作1202b的1212b,时间池化操作1202c的输出特征图集1212c。重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008执行重缩放操作集1204、连接操作1206、然后执行csr操作1208,以融合时间池化操作集1202的输出特征图集1212。对每一个相应时间池化操作1202a、1202b或1202c的输出特征图集1212a、1212b或1212c进行时间二次采样。重缩放操作集1204包括多个重缩放操作1204a、1204b和1204c。每一个重缩放操作1204a、1204b或1204c将相应时间池化操作1202a、1202b或1202c的相应输出特征图集1212a、1212b或1212c重缩放回每一个重缩放操作1204a、1204b或1204c的相应输出特征图序列1210a、1210b或1210c。每一个相应重缩放操作1204a、1204b或1204c的输出特征图序列1210a、1210b或1210c的大小为t x h x w。每一个重缩放操作1204a、1204b或1204c可以是内插操作,例如双线性内插操作。或者,每一个重缩放操作1204a、1204b或1204c可以是反卷积操作。连接操作1206沿通道轴连接重缩放操作集1204的相应输出特征图序列1210a、1210b和1210c,使得连接操作1206的输出特征图序列1216的大小为t x h x w x 3。将csr操作1208应用于连接操作1206的输出特征图序列1216,以获取大小为t x h x w x 1的重要和最精细空间尺度和重要时间尺度时空感受野信息1218。csr操作1208可以是1 x 1 x 1卷积操作。或者,csr操作1208可以是逐元素求和操作。在本实施例中,重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息1016是重要和最精细空间尺度和重要时间尺度时空感受野信息1218。对于其中第三卷积神经网络操作是时间扩张卷积操作集的替代实施例,可以不需要重缩放操作集1204。

79.与csr操作1208的输出特征图序列直接作为重要和最精细空间尺度和重要时间尺度时空感受野信息1218的上述实施例相比,通过时间注意力图序列获取操作获取重要和最精细空间尺度和重要时间尺度时空感受野信息1218的替代实施例如下。重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008进一步使用csr操作1208的输出特征图序列执行时间注意力图序列获取操作,以获取时间注意力图序列。时间注意力图序列获取操作可以是softma x函数。或者,时间注意力图序列获取操作可以是sigmoid函数。然后,重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008进一步对融合重要和最精细尺度空间感受野信息1210和时间注意力图序列524执行逐元素乘法操作,以获取重要和最精细空间尺度和重要时间尺度时空感受野信息1218。

80.本技术所使用的术语“注意力图序列机制”是指时间注意力图序列获取操作和图11中的空间注意力图序列获取操作1110中的一个或两个。

81.与参阅图11和图12描述的第一维是空间且第二维是时间的上述实施例相比,第一维是空间且第二维是时间的替代实施例如下。对图10中第一维重要性获取模块1002的细节进行必要的修改与参阅图12描述的相同。对图10中的多融合重要和最精细第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1006和重要和最精细第一维尺度和重要第二维尺度第一和第二维感受野信息融合模块1008进行必要的修改与参阅图11描述的相同。

82.图13是示出根据本技术一实施例的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300的框图。融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300配置为使用输入特征图序列606获取融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息1304。融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300包括图6中的融合多尺度第一和第二维感受野信息获取模块600。在图13中,融合多尺度第一和第二维感受野信息获取模块600中的多尺度第一和第二维感受野信息获取模块602包括图7中的融合多尺度第一维感受野信息获取模块702和多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704。融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300还包括融合多尺度第一和第二维感受野信息和融合多尺度第一维感受野信息融合模块1302。融合多尺度第一和第二维感受野信息和融合多尺度第一维感受野信息融合模块1302配置为将融合多尺度第一和第二维感受野信息610和融合多尺度第一维感受野信息706融合为融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息1304。在一个实施例中,融合多尺度第一和第二维感受野信息和融合多尺度第一维感受野信息融合模块1302所执行的融合是逐元素求和操作。在上述的一些实施例中,融合多尺度第一和第二维感受野信息610包括第一和第二维重要性。融合多尺度第一维感受野信息706包括第一维重要性1010和输入特征图序列606。通过融合该融合多尺度第一和第二维感受野信息610和该融合多尺度第一维感受野信息706,第一和第二维重要性以及第一维重要性1010作为残差信息被添加到输入特征图序列606中。

83.如上所述,相关技术具有不能将视频片段的每一帧中的许多不相关或不重要信息视为不相关或不重要的缺点。在下文中,使用图14至图17中的示例来说明参阅图9至图12描述的实施例的效果。在这些示例中,第一维是空间,第二维是时间。

84.如图13所示,假设融合时间重要性和输入特征图序列获取模块与图13中的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300相类似,但与融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300的不同之处在于融合时间重要性和输入特征图序列获取模块不包括融合多尺度第一维感受野信息获取模块702。也就是说,多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704和融合多尺度第一和第二维感受野信息和融合多尺度第一维感受野信息融合模块1302直接地或作适当修改地使用输入特征图序列606,而不使用融合多尺度第一维感受野信息706。融合时间重要性和输入特征图序列获取模块配置为使用输入特征图序列606获取融合时间重要性和输入特征图序列。

85.图14是示出根据本技术一实施例的由融合时间重要性和输入特征图序列获取模块所获取的具有至少一个更合适时间尺度的上下文的示意图。图14是用于示出具有至少一个更合适的时间尺度的上下文的简化示例。在该示例中,示出了时间池化操作1202a和1202b,为简化起见,未示出时间池化操作1202c。输入特征图序列606由输入特征图序列1402表示,输入特征图序列1402反映了具有运动员投掷棒球的视频片段。通过对输入特征图序列1402执行池化窗口大小为t的时间池化操作1202a,时间池化操作1202a的输出特征图1404反映了整个输入特征图序列1402的运动轮廓,该运动轮廓是具有最粗略第一时间尺度的上下文。通过对输入特征图序列1402执行池化窗口大小为t/2的时间池化操作1202b,时间池化操作1202b的输出特征图集1406中的每一个输出特征图1406a或1406b反映输入特征图序列1402的相应一半的运动轮廓,该运动轮廓是具有第二时间尺度的上下文。第二时间尺度不如第一时间尺度粗略。

86.当计算机视觉cnn决定使用融合时间重要性和输入特征图序列对具有运动员投掷棒球的视频片段进行分类时,计算机视觉cnn可以从融合时间重要性和输入特征图序列中学习以下内容。融合时间重要性和输入特征图序列具有以下融合部分:输入特征图1402a、时间池化操作1202b的输出特征图1406a和时间池化操作1202a的输出特征图1404。从输入特征图1402a中,计算机视觉cnn可以获知存在投掷动作,但可能无法获知是否投掷了球或飞盘。从时间池化操作1202b的输出特征图1406a中,计算机视觉cnn可以获知有人和球在移动。从时间池化操作1202a的输出特征图1404中,计算机视觉cnn可以获知有人在移动。在这种情况下,时间池化操作1202b的输出特征图1406a可以是具有至少一个更合适的时间尺度的上下文,具有至少一个更合适的时间尺度的上下文与输入特征图1402a一起被同时考虑以供计算机视觉cnn学习人在投掷球。时间池化操作1202a的输出特征图1404可能过于粗略,而无助于识别棒球投掷动作。通过同时考虑具有至少一个更合适的时间尺度的上下文和输入特征图1402a,在融合时间重要性和输入特征图序列中需要较少信息来识别视频片段中的棒球投掷动作,并且在融合时间重要性和输入特征图序列中,对于识别棒球投掷动作不需要的剩余信息被认为是不相关的或不重要的。

87.在融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300中添加的融合多尺度第一维感受野信息获取模块702具有以下效果。

88.图15是示出根据本技术一实施例的融合多尺度第一维感受野信息获取模块702的背景抑制效果的示意图。通过执行参阅图11所描述的空间池化操作集1102以获取空间重要性1126,计算机视觉cnn被强制聚焦于视频片段中的重要空间区域,这些重要空间区域反映

在融合重要和最精细尺度第一维感受野信息1012中。在图15的示例中,反映在输入特征图序列1402中的视频片段中的不相关背景由输入特征图序列1402中的阴影区域表示。由于计算机视觉cnn被强制聚焦于反映在融合重要和最精细尺度第一维感受野信息1012中的棒球和运动员上,因此融合重要和最精细尺度第一维感受野信息1012由融合重要和最精细尺度第一维感受野信息1502表示,在融合重要和最精细尺度第一维感受野信息1502中,不相关的背景被去除。

89.对于融合重要和最精细尺度第一维感受野信息1012,空间重要性1126作为残差信息被添加到输入特征图序列606中,为计算机视觉cnn提供更多具有不同空间尺度的上下文。因此,实现了以下效果:在做出使用输入特征图序列606对视频片段进行分类的决定时,计算机视觉cnn有更好的机会去同时考虑更合适的上下文,该上下文包括具有至少一个更合适的空间尺度的上下文。

90.图14中所示出的时间池化操作1202a和1202b是一种如图1a和图1b所描述的具有空间局部到局部约束的卷积神经网络操作。由于在参阅图14描述的示例中使用了不包括融合多尺度第一维感受野信息获取模块702的融合时间重要性和输入特征图序列获取模块,因此图14中的时间池化操作1402a和1402b中的每一个仅能看到输入特征图序列1402中的相应并置局部空间区域。如此,融合时间重要性和输入特征图序列获取模块可以获取具有至少一个更合适的时间尺度的上下文,但可能无法获取具有至少一个更合适的时空尺度的上下文。

91.图16是示出根据本技术一实施例的由图9中的融合多尺度第一和第二维感受野信息获取模块600所获取的具有全局和最精细空间尺度和重要时间尺度的上下文的示意图。图16中的示例遵循图1a和图1b中的示例。如前面参阅图1a和图1b所描述的,第一卷积神经网络操作集的操作106b所提供的上下文的时间尺度比第一卷积神经网络操作集的操作106a所提供的上下文的时间尺度更合适。因此,图16仅示出了一个卷积神经网络操作1606,卷积神经网络操作1606的时间池化窗口大小与第一卷积神经网络操作集的操作106b的时间池化窗口大小相同。卷积神经网络操作1606是图9中的融合多尺度第一和第二维感受野信息获取模块600中的多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704所执行的第三卷积神经网络操作中的一个操作的示例。与对输入特征图序列102执行的第一卷积神经网络操作集的操作106b相比,卷积神经网络操作1606对融合全局和最精细尺度第一维感受野特征图序列1602执行。图16中所示出的融合全局和最精细尺度第一维感受野特征图序列1602是图9中融合全局和最精细尺度第一维感受野信息912的示例。如此,即使卷积神经网络操作1606具有空间局部到局部约束,卷积神经网络操作1606的时空感受野的空间部分也具有全局和最精细尺度,而不是单一原始尺度。

92.以由于空间局部到局部约束而对其执行卷积神经网络操作1606的局部空间区域1604b为例。因为局部空间区域1604b在融合全局和最精细尺度第一维感受野特征图序列1602中的一个融合全局和最精细尺度第一维感受野特征图1602b中,所以当对局部空间区域1604b执行卷积神经网络操作1606时,卷积神经网络操作1606具有最精细尺度(即1 x 1)的空间感受野1608和全局尺度(即h x w)的空间感受野1610。如此,即使卷积神经网络操作1606具有空间局部到局部约束,卷积神经网络操作1606在全局尺度下也知道与融合全局和最精细尺度第一维感受野特征图1602a,1602b,1602c,1602d相应的视频帧中棒球104的整

个飞行轨迹1612。因此,与图1b中的第一卷积神经网络操作集的操作106b相比,卷积神经网络操作1606提供具有更合适的时空尺度的上下文。参阅图14所描述的示例与参阅图1a和图1b所描述的示例相类似。与参阅图14所描述的示例相比,参阅图16所描述的示例具有以下优点。由于对飞行轨迹1612的了解,因此卷积神经网络操作1606所提供的具有更合适的时空尺度的上下文相比于参阅图14所描述的具有至少一个更合适的时间尺度的上下文被增强。因此,使用图9中的融合多尺度第一和第二维感受野信息获取模块600所获取的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息1304中,识别棒球投掷动作所需要的信息比融合时间重要性和输入特征图序列中,识别棒球投掷动作所需要的信息更少。使用图9中的融合多尺度第一和第二维感受野信息获取模块600所获取的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息1304中,识别棒球投掷动作所不需要的剩余信息被认为是不相关或不重要。

93.图17是示出根据本技术一实施例的由图10中的融合多尺度第一和第二维感受野信息获取模块600所获取的具有重要空间尺度和重要时间尺度的上下文的示意图。因为允许棒球104的整个飞行轨迹1612被知道的卷积神经网络操作1606的时空感受野的空间部分的尺度是全局的,并且棒球104从与融合全局和最精细尺度第一维感受野特征图1602a相应的视频帧的中心飞行到与融合全局和最精细尺度第一维感受野特征图1602d相应的视频帧的左上角,所以棒球104的飞行轨迹1612可能看不清楚。与图16中的对融合全局和最精细尺度第一维感受野特征图序列1602执行的卷积神经网络操作1606相比,图17中的卷积神经网络操作1706对融合重要和最精细尺度第一维感受野特征图序列1702执行。卷积神经网络操作1706是由图10中的融合多尺度第一和第二维感受野信息获取模块600中的多融合多第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块704所执行的第三卷积神经网络操作中的一个操作的示例。图17中所示出的融合重要和最精细尺度第一维感受野特征图序列1702是图10中的融合重要和最精细尺度第一维感受野信息1012的示例。如此,即使卷积神经网络操作1606具有空间局部到局部约束,卷积神经网络操作1706的时空感受野的空间部分也具有重要和最精细尺度而不是单一原始尺度。重要尺度可以比全局尺度具有至少一个更合适的尺度。

94.以由于空间局部到局部约束而对其执行卷积神经网络操作1706的局部空间区域1704b为例。因为局部空间区域1704b在融合重要和最精细尺度第一维感受野特征图序列1702中的一个融合重要和最精细尺度第一维感受野特征图1702b中,所以当对局部空间区域1704b执行卷积神经网络操作1706时,卷积神经网络操作1706具有最精细尺度(即1 x 1)的空间感受野1708和重要尺度(即h x w、(h/2)x(h/2)和(h/4)x(w/4))的空间感受野1710、1714和1716。如此,即使卷积神经网络操作1706具有空间局部到局部约束,卷积神经网络操作1706在(h/2)x(h/2)尺度下也知道棒球104在与融合重要和最精细尺度第一维感受野特征图1702a、1702b、1702c和1702d相应的视频帧中的整个飞行轨迹1712。因此,与图1b中的第一卷积神经网络操作集的操作106b相比,卷积神经网络操作1706提供具有更合适的时空尺度的上下文。此外,与参阅图16描述的示例相比,参阅图17所描述的示例具有以下优点。由于在(h/2)x(h/2)尺度下对棒球104的飞行轨迹1712的认识,因此棒球104的飞行轨迹1712被更清楚地看到。因此,卷积神经网络操作1706提供的上下文比卷积神经网络操作1606提供的上下文具有更合适的时空尺度。因此,使用图10中的融合多尺度第一和第二维

感受野信息获取模块600所获取的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息1304中,识别视频片段中的棒球投掷动作所需要的信息比使用图9中的融合多尺度第一和第二维感受野信息获取模块600所获取的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息1304中,识别视频片段中的棒球投掷动作所需要的信息更少。使用图10中的融合多尺度第一和第二维感受野信息获取模块600所获取的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息1304中,识别视频片段中的棒球投掷动作所不需要的剩余信息被视为不相关或不重要。

95.本技术的描述中,术语“重要性”或“重要”是指从粗略到精细的尺度,其中至少一个尺度为计算机视觉cnn提供更合适的尺度,以将视频片段的每一帧中的不相关或不重要信息视为不相关或不重要。从粗略到精细的时间尺度的示例是上文参阅图14提供的第一时间尺度和第二时间尺度。从粗略到精细的空间尺度的示例是上文参阅图17提供的尺度h xw、尺度(h/2)x(h/2)和尺度(h/4)x(w/4)。

96.图18是示出根据本技术一实施例的图6中的多尺度第一和第二维感受野信息获取模块602的框图,多尺度第一和第二维感受野信息获取模块602包括图18中的模块1802。多尺度第一和第二维感受野信息获取模块602包括多单一第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1802。

97.多单一第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1802配置为使用输入特征图序列606执行多个第四卷积神经网络操作中的每一个操作,以获取相应的单一第一维尺度和单一第二维尺度第一和第二维感受野信息1804。每一个第一卷积神经网络操作集是提供相应一个多尺度第二维感受野的第四卷积神经网络操作的相应多重操作集,其中每一个多重操作集提供所有多尺度第一维感受野和相应一个多尺度第二维感受野。所有第四卷积神经网络操作的相应单一第一维尺度和单一第二维尺度第一和第二维感受野信息1804是来自多尺度第一和第二维感受野的信息608。在一个实施例中,每一个第四卷积神经网络操作是相应的3d池化操作。

98.图19是示出根据本技术一实施例的感受野的组合的图,该感受野的组合对应于图18中的多尺度第一和第二维感受野信息获取模块602中的模块1802和图6中的融合多尺度第一和第二维感受野信息获取模块600中的模块604所执行的步骤。在图8的示例中,对于多单一第一维尺度和单一第二维尺度第一和第二维感受野信息获取模块1802,每一个第四卷积神经网络操作被执行。每一个第四卷积神经网络操作具有相应的单一第一维尺度和单一第二维尺度第一和第二维感受野1910、1912、1914或1916。单一第一维尺度和单一第二维尺度第一和第二维感受野1910具有单一第一维尺度部分1902和单一第二维尺度部分1906。单一第一维尺度和单一第二维尺度第一和第二维感受野1912具有单一第一维尺度部分1904和单一第二维尺度部分1906。单一第一维尺度和单一第二维尺度第一和第二维感受野1914具有单一第一维尺度部分1902和单一第二维尺度部分1908。单一第一维尺度和单一第二维尺度第一和第二维感受野1916具有单一第一维尺度部分1904和单一第二维尺度部分1908。每一个第一卷积神经网络操作集是第四卷积神经网络操作的相应多重操作集。每一个多重操作集具有所有多尺度第一维感受野1902和1904与多尺度第二维感受野1906和1908中的每一个的相应组合1918或1920。所有第四卷积神经网络操作的相应单一第一维尺度和单一第二维尺度第一和第二维感受野信息1910、1912、1914和1916是来自多尺度第一和第二维

感受野的信息608。

99.对于多尺度第一和第二维感受野信息融合模块604,来自多尺度第一和第二维感受野的组合的信息608被融合,以获取融合多尺度第一和第二维感受野信息610。也就是说,来自单一第一维尺度和单一第二维尺度第一和第二维感受野1910、1912、1914和1916的信息被融合。也就是说,来自所有多尺度第一维感受野1902和1904和多尺度第二维感受野1906和1908中的一个1906的组合1918和所有多尺度第一维感受野1902和1904和多尺度第二维感受野1906和1908中的另一个1908的组合1920的组合1922的信息被融合。

100.参阅图9至图17描述的实施例和效果经适当修改适用于参阅图18至图19描述的实施例。

101.图20是示出根据本技术一实施例的具有多个融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块g1至g2和h1至h3的可分离3dresnet-50网络2000的示意图。在一个实施例中,融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块g1至g2和h1至h3中的每一个的类型为图13中的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块1300。可分离3d resnet-50网络2000配置为对视频片段2002进行分类以获取分类输出2004。可分离3d resnet-50网络2000包括彼此顺序串联连接的多个阶段a至f。阶段b至e相似。阶段b至e中的每一个阶段被称为阶段x以描述共同特征,且被称为相应阶段b、

……

或e以描述特定特征。阶段a包括彼此顺序连接的空间卷积层a1和时间卷积层a2。阶段x包括彼此顺序连接的多个残差块。在最后残差块之前的一部分残差块中的每一个残差块的类型是3d残差块2100,将参阅图21对3d残差块2100进行描述。最后残差块的类型是3d残差块2200,将参阅图22对3d残差块2200进行描述。阶段b、c、d和e分别具有两个、三个、五个和两个类型为3d残差块2100的残差块。阶段c和d更相似。对于阶段c,在残差块c1之后插入融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块g1,在融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块g1之后的阶段c的其它残差块之后插入相应的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块g2。对于阶段d,在残差块d1之后插入融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块h1,在融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块h1之后的阶段d的其它残差块之后插入相应的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块h2或h3。阶段f包括彼此顺序连接的全局平均池化层f1和全连接层f2。

102.与将融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块g1至g2和h1至h3插入可分离3d resnet-50网络2000中的阶段c和d的上述实施例相比,在任何深度cnn架构中的任何相应卷积层之后插入任何数量的融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块中的每一个的替代实施例在本技术的涵盖范围内。每一个融合多尺度第一和第二维感受野信息和多尺度第一维感受野信息获取模块是一个轻量级但通用的组件,用于在任何深度cnn架构中捕获第一和第二维重要性。

103.图21是示出根据本技术一实施例的3d残差块2100的框图。3d残差块2100配置为使用输入特征图序列2112通过多个分离且独立的卷积层2102、2104、2106和2108执行空间卷积和时间卷积,以获取3d残差块2100的输出特征图序列2114。3d残差块2100包括卷积层2102、2104、2106和2108以及逐元素求和操作2110。卷积层2102、2104、2106和2108顺序串联

连接。逐元素求和操作2110将卷积层2108的输出特征图序列和输入特征图序列2112求和。输入特征图序列2112的大小为t x h x w x c,其中t、h、w和c表示时间、高度、宽度和通道数。卷积层2102的内核大小为1 x 1 x 1,步长为1 x 1 x 1。卷积层2102的输出特征图序列的大小为t x h x w x c/4,并且可以通过诸如relu的非线性激活函数来修改。卷积层2104的内核大小为1 x 3 x 3,步长为1 x 1 x 1。卷积层2104的输出特征图序列的大小为t x h x w x c/4,并且可以通过诸如relu的非线性激活函数来修改。卷积层2106的内核大小为3 x 1 x 1,步长为1 x 1 x 1。卷积层2106的输出特征图序列的大小为t x h x w x c/4,并且可以通过诸如relu的非线性激活函数来修改。卷积层2108的内核大小为1 x 1 x 1,步长为1 x 1 x 1。卷积层2108的输出特征图序列的大小为t x h x w x c。逐元素求和操作2110的输出特征图序列可以通过诸如relu的非线性激活函数来修改,以获取3d残差块2100的输出特征图序列2114。3d残差块2100的输出特征图序列2114的大小为t x h x w x c。

104.图22是示出根据本技术一实施例的3d残差块2200的框图。3d残差块2200配置为使用输入特征图序列2214通过多个分离且独立的卷积层2202、2204、2206、2208和2210执行降尺度的空间卷积和时间卷积,以获取3d残差块2200的输出特征图序列2216。3d残差块2200包括卷积层2202、2204、2206、2208和2210以及逐元素求和操作2212。卷积层2202、2204、2206、2208和2210顺序串联连接。逐元素求和操作2212对卷积层2210的输出特征图序列和输入特征图序列2214求和。输入特征图序列2214的大小为t x h x w x c,其中t、h、w和c表示时间、高度、宽度和通道数。卷积层2202的内核大小为1 x 1 x 1,步长为2 x 2 x 2。卷积层2202的输出特征图序列的大小为t/2 x h/2 x w/2 x c,并且可以通过诸如relu的非线性激活函数来修改。卷积层2204的内核大小为1 x 1 x 1,步长为1 x 1 x 1。卷积层2204的输出特征图序列的大小为t x h x w x c/4,并且可以通过诸如relu的非线性激活函数来修改。卷积层2206的内核大小为1 x 3 x 3,步长为1 x 2 x 2。卷积层2206的输出特征图序列的大小为t x h/2 x w/2 x c/4,并且可以通过诸如relu的非线性激活函数来修改。卷积层2208的内核大小为3 x 1 x 1,步长为2 x 1 x 1。卷积层2210的内核大小为1 x 1 x 1,步长为1 x 1 x 1。卷积层2210的输出特征图序列的大小为t/2 x h/2 x w/2 x c。逐元素求和操作2212的输出特征图序列可以通过诸如relu的非线性激活函数来修改,以获取3d残差块2200的输出特征图序列2216。3d残差块2200的输出特征图序列2216的大小为t/2 x h/2 x w/2 x c。

105.本领域普通技术人员理解,本技术实施例中描述和公开的系统或计算机实施的方法的每个单元、模块、层、块、算法和步骤都是使用硬件、固件、软件或其组合实现的。功能是在硬件、固件还是软件中运行取决于技术方案的应用条件和设计要求。本领域普通技术人员可以使用不同的方法来实现每个特定应用的功能,而这种实现不应超出本发明的范围。本领域技术人员理解,由于上述系统、设备、模块和单元的工作过程基本相同,因此他/她可以参阅上述实施例中的系统、设备、模块和单元的工作过程。为了便于描述和简化,这些工作过程将不再详细说明。

106.可以理解的是,本技术实施例中公开的系统、设备和计算机实现方法可以通过其他方式实现。上述实施例只是示例性的。单元或模块的划分仅基于逻辑功能,而其他划分存在于实现中。单元或模块可以是也可以不是物理单元或模块。可以将多个单元或模块组合或集成到一个物理单元或模块中。也可以将任何单元或模块划分为多个物理单元或模块。

也可以省略或跳过某些特征。另一方面,显示或讨论的相互耦合、直接耦合或通信耦合通过一些端口、设备、单元或模块来操作,无论是间接地还是通过电气、机械或其他种类的形式进行通信。

107.作为用于解释的分离组件的单元或模块在物理上是或不是分离的。这些单元或模块位于一个地方或分布在多个网络单元或模块上。根据实施例的目的,使用部分或全部单元或模块。此外,每个实施例中的每个功能单元或模块可以集成在一个在物理上独立的处理单元或模块中,或者集成在具有两个或两个以上单元或模块的一个处理单元或模块中。

108.如果软件功能单元或模块作为产品实现使用和销售,则可以存储在计算机可读存储介质中。基于这样的理解,本技术提出的技术方案可以基本或部分地以软件产品的形式实现。或者,可以将对常规技术有利的技术方案的一部分实现为软件产品的形式。软件产品存储在计算机可读存储介质中,包括用于计算设备(例如个人计算机、移动电话)的处理器模块的多个命令,以运行本发明实施例公开的所有或部分步骤。存储介质包括usb(universal serial bus,通用串行总线)盘、移动硬盘、只读存储器(rom,read-only memory)、随机存取存储器(ram,random access memory)、软盘或能够存储程序指令的其他类型的介质。

109.虽然本发明已结合被视为最实用和优选的实施例进行了描述,但应理解,本技术不限于所公开的实施例,而是旨在覆盖在不背离所附权利要求的最广泛解释的范围的情况下做出的各种布置。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1