一种用于自注意力神经网络的归一化方案的制作方法

本发明涉及自注意力神经网络中的图表示。

背景技术:

1、许多机器学习研究人员认为,学习精确表示的能力是该领域近年来取得巨大成功的主要原因。在图像分析、自然语言处理和强化学习等领域,突破性成果依赖于高效、灵活的深度学习架构,这些深度学习架构能够将复杂输入转换为简单向量,同时保留其大部分重要特征。

2、图表示可以解决以下问题,即通过本地聚合步骤将高维对象映射到简单向量,以便执行机器学习任务,例如回归或分类。需要根据深度图注意力网络(graph attentionnetwork,gat)和深度图转换器等基于注意力的机制来构建深度图神经网络架构,以便用于此类应用。

3、最近引入了许多变体,并且先验方法的主要限制是许多方法不随层数而扩展。在非常深的场景中,深度图神经网络方法普遍存在过度平滑和过度挤压现象(参见uri alon和eran yahav的“论图神经网络的瓶颈及其实践意义(on the bottleneck of graphneural networks and its practical implications)”,eprint={2006.05205},arxiv,cs.lg,2021年;li等人的“深入了解用于半监督学习的图卷积网络(deeper insights intograph convolutional networks for semi-supervised learning)”,aaai人工智能大会,2018年)。这些现象可以通过图神经网络的固有特性(例如,拉普拉斯算子特征值)或数值困难(例如,梯度降至零或激增)来说明。

4、为了捕获图上的远程交互,人们越来越关注找到使得深度图神经网络能够高效执行的方法。

5、构建更深层次图神经网络的先验方法可以分为两大类。

6、首先是正则化水平方法,涉及对节点属性进行归一化以稳定成对特征距离(称为pairnorm)(参见lingxiao zhao和leman akoglou的“pairnorm:处理gnn中的过度平滑(pairnorm:tackling oversmoothing in gnns)”,国际学习表征会议,2020年);或者执行图边缘丢弃(称为dropedge)(参见rong等人的“dropedge:迈向节点分类的深度图卷积网络(dropedge:towards deep graph convolutional networks on node classification)”,国际学习表征会议,2020年);或者对节点表示及其方差进行归一化。

7、其次是对架构设计层面技术的干预,架构设计层面技术包括卷积网络的协同训练和自训练方法(例如,参见li等人的“深入了解用于半监督学习的图卷积网络(deeperinsights into graph convolutional networks for semi-supervised learning)”,aaai人工智能大会,2018年)、或解耦表示转换和节点传播(称为dagnn)(参见liu等人的“迈向更深层次的图神经网络(towards deeper graph neural networks)”,美国计算机学会,《第26届acm sigkdd知识发现与数据挖掘国际会议论文集》,第338–348页,2020年)或整合残余连接(参见xu等人的“图神经网络有多强大?(how powerful are graph neuralnetworks?)”,国际学习表征会议,2019年;gong等人的“图神经网络中的几何原理连接(geometrically principled connections in graph neural networks)”,eprint={2004.02658},arxiv,cs.cv,2020年)。

8、上述方法大多基于图卷积网络,几乎没有一种方法研究基于注意力的图神经网络。此外,尚未开展任何研究来提供基于利普希茨连续性的有效图注意力归一化的理论论据。

9、需要开发一种克服上述问题的方法。

技术实现思路

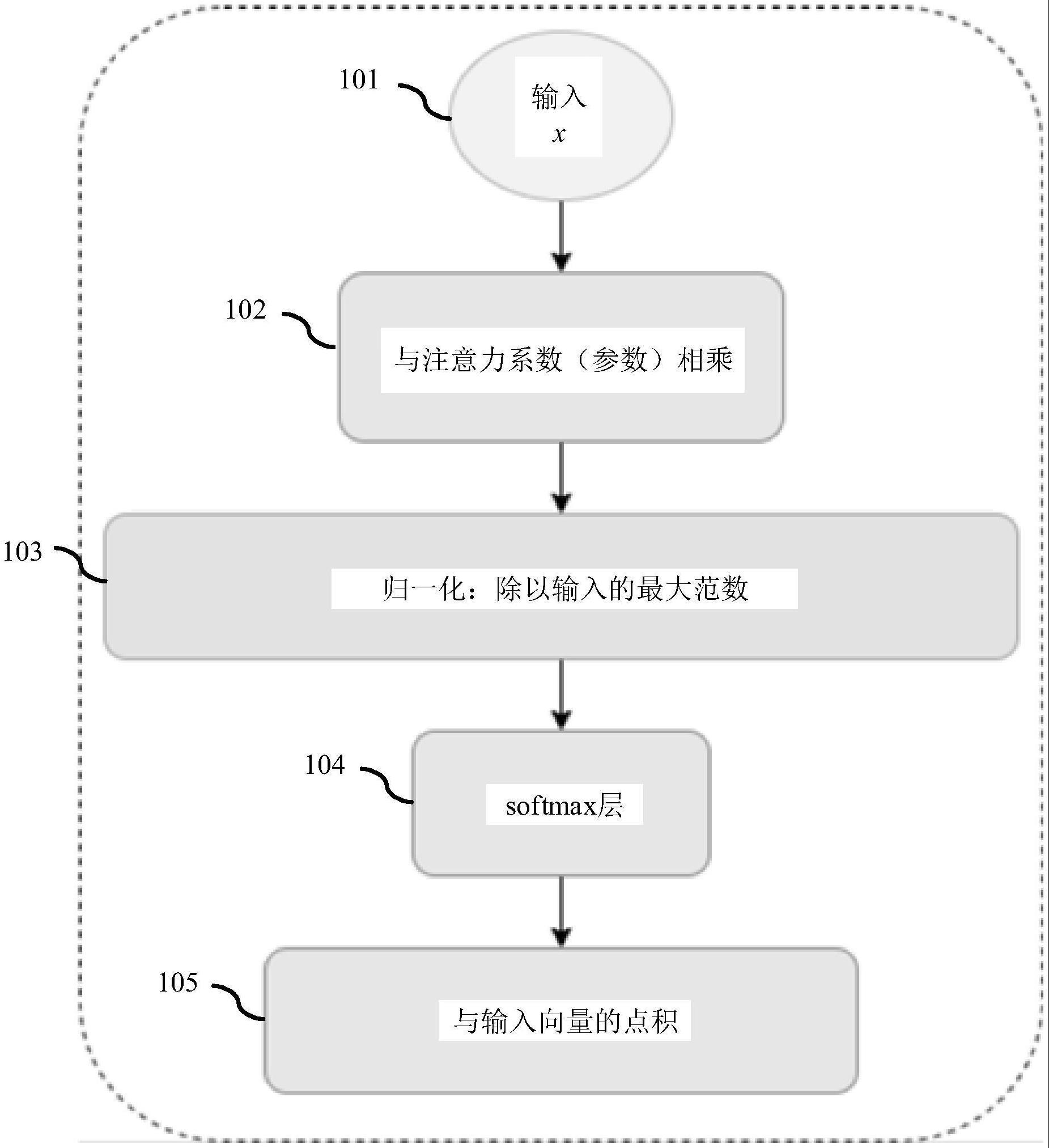

1、根据第一方面,提供了一种数据处理设备,用于对图神经网络执行基于注意力的操作,所述设备用于接收一个或多个输入图,每个输入图具有多个节点,并且对于所述输入图中的至少一个,还用于执行以下操作:形成所述相应输入图中的每个节点的输入节点表示,其中,可以为每个输入节点表示定义相应的范数;形成一组注意力参数;将所述输入节点表示中的每一个与所述一组注意力参数相乘,以形成所述相应输入图的得分函数;基于所述输入节点表示的范数中的最大值,对所述得分函数进行归一化,以形成归一化得分函数;通过所述归一化得分函数的相应元素对所述相应输入图中的每个节点进行加权,来形成加权节点表示。

2、所述得分函数的所述归一化可以通过加强利普希茨连续性使得基于注意力的深度神经网络表现更好。本发明实施例利用输入的最大范数来设计所述归一化。

3、可以将所述输入节点表示中的每一个与所述一组注意力参数的乘法运算作为矩阵乘法来执行,以形成所述相应输入图的得分函数。所述得分函数可以定义为g(x)=qtx,其中,q表示所述注意力参数,x表示相应节点(其为一组节点,更准确地说是一个节点及其邻域的特征)的输入表示。通过对该矩阵乘积进行分解,通过qtxi进行乘法运算,其中,xi是节点特征,并且对每个节点进行乘法运算,即使用每个注意力参数对每个节点进行乘法运算,以得到所述得分函数的元素。

4、在一些实现方式中,所述设备可以用于接收多个输入图。这使得所述设备能够用于应用,例如,以检测图数据中存在的噪声、网络中缺失的链路以及结构模式。

5、所述得分函数可以被归一化,使得所述归一化得分函数的元素总和为1。这使得能够高效地对所述得分函数进行归一化。

6、所述图神经网络的注意力机制可以具有利普希茨连续性。如果存在l,使得则函数称为利普希茨连续函数。因此,f具有有界变差和有界梯度。迭代所述函数时(例如,计算f(f(f(…f(x)…))时),对所述梯度进行更好的控制,并且可以确保所述梯度不会激增。

7、可以对所述归一化的得分函数应用softmax函数。可以对所述图的每个节点和每个相应节点的相邻节点(通过边缘连接到相应节点的节点)的所述得分函数应用所述softmax函数,使得每个邻域的一组得分函数值总和为1。后续确定加权平均值时,这使得所述归一化的得分函数的所考虑元素的权重总和为1。所述softmax函数是实现这一点的一种便捷方式。

8、所述输入节点表示可以给出关于所述相应节点的上下文信息。这使得所述方法能够用于实际应用中,其中,所述输入图描述物理属性或其它参数。所述上下文信息可以采用张量的形式。这可以是所述上下文信息的一种方便的表示。

9、对于每个节点,可以使用点积将所述归一化得分函数的所述相应元素与所述相应节点的所述输入表示相结合,以基于其相邻节点的加权表示来形成所述节点的所述加权节点表示。这可以是形成所述加权节点表示的高效方式。

10、所述图神经网络可以是图注意力网络或图转换器。因此,所述方法适用于不同的基于注意力的图形神经网络。

11、所述图神经网络的注意力机制可以包括多头注意力机制。所述得分函数可以针对所述多头注意力机制中的每个注意力头进行归一化。因此,可以方便地对具有多头注意力的架构应用所述方法。

12、系统可以用于学习所述注意力参数。然后,可以将所述学习的参数与每个输入节点表示相乘,以形成所述输入图的得分函数,然后如上文所述对其进行归一化。

13、根据第二方面,提供了一种方法,用于对数据处理设备中的图神经网络执行基于注意力的操作,所述设备用于接收一个或多个输入图,每个输入图具有多个节点,对于所述输入图中的至少一个,所述方法包括:形成所述相应输入图中的每个节点的输入节点表示,其中,可以为每个输入节点表示定义相应的范数;将所述输入节点表示中的每一个与所述一组注意力参数相乘,以形成所述相应输入图的得分函数;基于所述输入节点表示的范数中的最大值,对所述得分函数进行归一化,以形成归一化得分函数;通过所述归一化得分函数的相应元素对所述相应输入图中的每个节点进行加权,来形成加权节点表示。

14、作为所述方法的一部分执行的所述归一化可以通过加强利普希茨连续性使得基于注意力的深度神经网络表现更好。本发明实施例利用输入的最大范数来设计所述归一化。

15、所述得分函数可以被归一化,使得所述归一化得分函数的元素总和为1。这使得能够高效地对所述得分函数进行归一化。

16、所述图神经网络的注意力机制可以具有利普希茨连续性。

17、根据第三方面,提供了一种计算机程序,所述计算机程序由计算机执行时,使得所述计算机执行所述方法。所述计算机程序可以在非瞬时性计算机可读存储介质上提供。

- 还没有人留言评论。精彩留言会获得点赞!