融合事实文本的问句分解式语义解析方法

1.本发明涉及融合事实文本的问句分解式语义解析方法,属于自然语言处理技术领域。

背景技术:

2.知识库问答技术旨在从预先建立好的结构化知识库中查找问题的答案,因其广泛的应用场景和巨大的应用价值成为学术界和工业界的研究热点之一。随着知识库构建技术的不断发展,知识库的规模越来越大,如freebase、dbpedia、wikidata等大型知识库中存储了丰富的关联知识,这为知识库问答提供了数据基础。

3.然而,目前的问答系统大多只能回答事实型问题,不能很好的处理复杂问题,难以理解问题中的复杂语义。原因在于,回答一个复杂问题通常会涉及知识库中多个关联的三元组信息,三元组需要满足与问题相关的约束条件,再经过一系列多跳推理或数值计算才能得到正确答案。

4.语义解析作为知识库问答技术的主流方法之一,核心是将非结构化的自然语言问题转化成机器能够理解和执行的形式语言,如sparql等,并使用该形式语言作为结构化查询语句对知识库进行查询,从而获取答案。目前,此类方法在解析复杂问题时主要依赖于依存句法等自然语言句法分析方法,为句子中不同的词标记上不同的角色,帮助解析句子的语义。但是,单纯依靠基于句法的模型并不能很好的理解复杂问题中的语义,会导致语义角色标注错误,从而影响后续推理与计算。并且,随着问题复杂度的提高,语义解析的方法几乎失效。因此,如何更好的理解自然语言问句中的复杂语义依旧是一个难点问题。

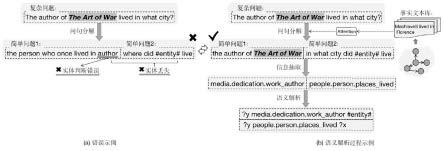

5.事实上,当人类在面临复杂问题时,往往先将其简化成若干个简单问题,先逐个回答简单问题,再进行整合和推理获得最终答案。因此,将复杂问题分解为若干简单问题是解决复杂问题语义理解的有效途径。同样地,本发明借鉴这个分治的思想,先把复杂问题分解得到简单问题序列,这些简单问题往往可以直接从知识库中获取答案,再整合简单问题的信息生成查询语句,这也更符合形式语言的逻辑结构,从而更好的生成正确的查询语句。然而,在将复杂问题分解成简单问题序列的过程中,模型往往会错误地判断或丢失问句中的主题实体,如图1(a)所示。这将导致分解后的子问题与原始的复杂问题并不匹配,从而生成错误的查询语句。

6.针对上述问题,本发明提出了一种融合事实文本的问句分解式语义解析模型。将知识库中的三元组转化成用自然语言描述的事实文本信息,构建了一个事实文本库,采用注意力机制获取更丰富的知识表示作为辅助信息,使生成的子问句与原问题更加切合,提高了子问句的质量,有效减少了错误传播,进而指导模型生成更好的查询语句。本发明将复杂问题的语义解析过程分为三个阶段,如图1(b)所示,首先在问句分解阶段,将复杂问题分解成一系列简单的子问题序列;然后在信息抽取阶段,对原问题和子问题序列进行信息抽取和整合,获取关键信息;最后在语义解析阶段,生成相应的结构化查询语句。

技术实现要素:

7.本发明要解决的技术问题是:本发明提供了融合事实文本的问句分解式语义解析方法,以用于解决在复杂问题分解成简单问题序列的过程中模型错误地判断或丢失问句中的主题实体的问题;解决了知识库问答技术在面对复杂问题时,模型无法准确解析问句中的复杂语义,导致问答系统性能不佳的问题。

8.本发明的技术方案是:融合事实文本的问句分解式语义解析方法,首先,本发明将知识库中的三元组转化成用自然语言描述的事实文本信息,构建了一个事实文本库,采用注意力机制获取更丰富的知识表示作为辅助信息。其次,将复杂问题的语义解析过程分为三个阶段,在第一个问句分解阶段,将复杂问题分解成一系列简单的子问题序列;在第二个信息抽取阶段,对原问题和子问题序列进行信息抽取和整合,获取关键信息;在第三个语义解析阶段,生成相应的结构化查询语句。

9.作为本发明的进一步方案,具体步骤如下:

10.step1、构建了一个事实文本库作为知识来源;在知识库中,信息以三元组的形式存在,包括头实体、关系和尾实体,通过《头实体,关系,尾实体》这样的结构构建了一张图网络;将三元组通过人工设计模版转化成用自然语言描述的句子;

11.step2、基于transformer的编码器-解码器框架,在transformer的基础上利用文本库感知注意力机制融入事实文本信息;

12.step3、在编码端和解码端都利用了文本库感知注意力机制动态地关注输入序列中的局部信息,让模型在面对当前输入序列时更专注于与事实文本相关联的实体信息或关系信息。

13.作为本发明的进一步方案,所述step1的具体步骤为:

14.step1.1、在数据预处理时,首先用斯坦福的命名实体识别工具识别出问句中的实体,得到一个实体集合,以实体集合中的实体作为头实体或尾实体抽取知识库中的三元组;

15.step1.2、然后根据人工设计模板将三元组表示为事实文本;

16.step1.3、最后利用bert将问句和事实文本编码成向量,计算问句和事实文本之间的余弦相似度,选取top-n的事实文本句子构建事实文本库。

17.作为本发明的进一步方案,所述step1.2中:

18.基于freebase知识库,根据freebase的数据格式,三元组包含头实体,谓词关系和尾实体,其中谓词关系为三段式,通过分析,只保留谓词关系的第三段,设计了通用模版为“头实体+谓词关系+is+尾实体”生成一句事实文本。

19.作为本发明的进一步方案,所述step2的具体步骤:

20.step2.1、在统一的编码器-解码器框架中,其输入是由输入序列i={i1,

…

,ii}和附加信息e={e1,

…

,ee}两部分组成,输出是目标序列o={o1,

…

,oo},事实文本集合是f=(ft1,

…

,ftn)。

21.作为本发明的进一步方案,所述step3的具体步骤为:

22.step3.1、在编码端,首先使用transformer的编码器对输入序列i={i1,

…

,ii}进行编码得到向量表示hi,对事实文本集合f=(ft1,

…

,ftn)中每个事实文本序列进行编码得到向量集合并将其进行拼接,拼接后的向量为hf,然后经过文本库感知注意力机制,计算输入序列对事实文本序列的注意力向量为h;

23.step3.2、在解码端,transformer解码器由masked multi-head attention和encoder-decoder attention两大机制组成;在解码端主要做了两处改进:(1)在encoder-decoder attention处,用注意力向量h取代原来的输入序列向量hi作为编码器传递到解码器的隐向量,即k=v=h,q=hv;(2)在解码器中新增了文本库感知注意力机制,输入是事实文本序列的特征向量hf和encoder-decoder attention输出的向量h

enc-dec

,输出是注意力向量h

t-aware

;解码过程遇到“[bos]”标签代表解码开始,遇到“[eos]”标签代表解码结束;使用了基于文本库感知注意力机制的编解码框架,后续用f

enc

(

·

)表示模型的编码过程,f

dec

(

·

)表示模型的解码过程;

[0024]

整个过程表示为:

[0025][0026][0027]

step3.3、在问句分解模块的学习目标是把复杂问题分解成简单子问题序列:

[0028]

输入为复杂问题q,事实文本集合为f,输出为分解后的子问题序列dq;首先在编码端,对输入q进行编码得到问题嵌入hi=f

enc1

(q),对事实文本f进行编码后拼接得到事实文本嵌入hf=f

enc1

(f),经过文本库感知注意力机制得到一个注意力向量h=attention(hi,hf);然后在解码端,接收注意力向量h,并通过文本库感知注意力机制预测分解的表示dq=f

dec1

(h);在每个时间步,先前的输出右移并送入解码器;

[0029]

step3.4、在信息抽取模块的学习目标是从原始复杂问题和简单子问题序列中提取语义信息:

[0030]

输入为子问题序列dq,附加信息为分解阶段的隐层嵌入e=h,事实文本信息为f,输出为语义信息序列ei;首先在编码端,同理得分解嵌入事实文本嵌入注意力向量然后将附加信息和隐向量进行拼接[h,h

dq

];最后在解码端,解码语义信息ei=f

dec2

([h,h

dq

]);

[0031]

step3.5、在语义解析模块的学习目标是整合信息生成结构化查询语句:

[0032]

输入为语义信息ei,附加信息为前两阶段的隐层嵌入e=[h,h

dq

],事实文本信息为f,输出为结构化查询语句lf;同理得语义表示嵌入事实文本嵌入注意力向量拼接向量[h,h

dq

,h

ei

],解码结构化查询语句lf=f

dec3

([h,h

dq

,h

ei

])。

[0033]

所述step3还包括:

[0034]

step3.6、训练目标是生成简单子问题序列,抽取关键谓词和实体信息,最终生成相应的查询语句;设计的联合训练损失函数如下,分别由三个阶段的损失函数l1,l2和l3组成:

[0035]

l(θ)=λ1l1+λ2l2+l3[0036]

其中,三个阶段的任务都使用生成式模型的损失函数:

[0037]

p(x)=softmax(wx+b)

[0038][0039]

step4、为了验证融合事实文本的问句分解式语义解析方法的有效性和优越性,本发明选取了5个当前主流的方法作为基线模型进行对比实验。对本发明在语义解析任务和问题分解任务中的实验结果都进行了相应的比较和分析,并且直观地给出了相应的实例分析。

[0040]

step4.1、实验选取了5个当前主流的方法作为基线模型,分别是pointergenerator,主要利用数据重组的框架将先验知识注入序列到序列的模型中,并且使用了一种基于注意力的复制机制;transformer的整个网络结构完全由注意力机制组成,本发明主要利用transformer做语义解析任务;coarse2fine的一个结构感知的神经架构,采用由粗到细的两阶段生成方法,先生成忽略细节的表示,再将细节填充到之前的表示中;pointernetwork主要通过指针网络生成分割点,对原始复杂问题进行切割和分解,得到一系列简单问题序列;hsp主要针对复杂问题提出基于序列到序列模型的层次语义解析方法,将语义解析任务转化为多层次的生成任务,实验效果显著提高;

[0041]

step4.2、本发明的目标是将自然语言描述的复杂问题最终解析为逻辑形式,即sparql格式的结构化查询语句。因此语义解析任务的实验效果是验证该方法有效性的重要指标。在该任务中,选取pointergenerator、transformer、coarse2fine和hsp作为基线模型在验证集和测试集上进行了对比实验。评价指标为em值,即模型生成sparql语句的正确率;

[0042]

step4.3、本发明提出的方法旨在缓解问句分解过程中的错误积累问题,减少实体误判和丢失的情况,为后续的语义解析任务提供保障。因此提升问题分解任务的实验效果十分必要,能够充分验证分治思想的有效性。在该任务中,选取pointernetwork、pointergenerator和hsp作为基线模型在验证集和测试集上进行了对比实验。评价指标为bleu-4和rouge-l得分。对于所有模型,输入是复杂问题,输出是分解的子问题序列;

[0043]

step4.4、为了直观的对实验结果进行分析和对比,使本发明的方法具备更高的可解释性,本发明结合测试集中的一个实例来分析模型在每个阶段的实验效果,选取性能较好的hsp作为基线模型,验证以上实验结果的准确性。

[0044]

本发明的有益效果是:

[0045]

1、本发明借鉴了分治的思路对复杂问题进行语义解析,使模型能够更充分的理解自然语言问句中的复杂语义;

[0046]

2、本发明融合了三元组中的事实信息,增强了主题实体的识别准确率,降低了主题实体的错误丢失率,减少了错误传播;

[0047]

3、本发明在语义解析任务和问句分解任务中的实验性能相较基线模型均有明显的提升,验证了方法的合理性和有效性。

附图说明

[0048]

图1为本发明中的示例图;

[0049]

图2为本发明中的融合事实文本的问句分解式语义解析模型的整体结构图;

[0050]

图3为本发明中的基于文本库感知注意力机制的编码器-解码器结构图。

具体实施方式

[0051]

实施例1:如图1-3所示,融合事实文本的问句分解式语义解析方法,首先,本发明将知识库中的三元组转化成用自然语言描述的事实文本信息,构建了一个事实文本库,采用注意力机制获取更丰富的知识表示作为辅助信息。其次,将复杂问题的语义解析过程分为三个阶段,在第一个问句分解阶段,将复杂问题分解成一系列简单的子问题序列;在第二个信息抽取阶段,对原问题和子问题序列进行信息抽取和整合,获取关键信息;在第三个语义解析阶段,生成相应的结构化查询语句。

[0052]

作为本发明的进一步方案,具体步骤如下:

[0053]

step1、构建了一个事实文本库作为知识来源;在知识库中,信息以三元组的形式存在,包括头实体、关系和尾实体,通过《头实体,关系,尾实体》这样的结构构建了一张图网络;但是不同的知识图谱中三元组的表述形式也不相同,本发明将知识库的信息与自然语言的问题在形式上保持一致,方便后续的序列建模,本发明将三元组通过人工设计模版转化成用自然语言描述的句子;

[0054]

step2、本发明的语义解析过程主要包括三个模块:问句分解模块、信息抽取模块和语义解析模块。三个模块都是基于transformer的编码器-解码器框架,在transformer的基础上利用文本库感知注意力机制融入事实文本信息;

[0055]

step3、为获取更丰富的知识信息,本发明在每个模块的编码端和解码端都利用了文本库感知注意力机制动态地关注输入序列中的局部信息,让模型在面对当前输入序列时更专注于与事实文本相关联的实体信息或关系信息,有效地缓解了主题实体残缺或错误的问题。

[0056]

作为本发明的进一步方案,所述step1的具体步骤为:

[0057]

step1.1、在数据预处理时,首先用斯坦福的命名实体识别工具识别出问句中的实体,得到一个实体集合,以实体集合中的实体作为头实体或尾实体抽取知识库中的三元组;

[0058]

step1.2、然后根据人工设计模板将三元组表示为事实文本;

[0059]

step1.3、最后利用bert将问句和事实文本编码成向量,计算问句和事实文本之间的余弦相似度,选取top-n的事实文本句子构建事实文本库。

[0060]

作为本发明的进一步方案,所述step1.2中:

[0061]

基于freebase知识库,根据freebase的数据格式,三元组包含头实体,谓词关系和尾实体,其中谓词关系为三段式,通过分析,只保留谓词关系的第三段,设计了通用模版为“头实体+谓词关系+is+尾实体”生成一句事实文本。

[0062]

作为本发明的进一步方案,所述step2的具体步骤:

[0063]

step2.1、在统一的编码器-解码器框架中,其输入是由输入序列i={i1,

…

,ii}和附加信息e={e1,

…

,ee}两部分组成,输出是目标序列o={o1,

…

,oo},事实文本集合是f=(ft1,

…

,ftn)。

[0064]

作为本发明的进一步方案,所述step3的具体步骤为:

[0065]

step3.1、在编码端,首先使用transformer的编码器对输入序列i={i1,

…

,ii}进行编码得到向量表示hi,对事实文本集合f=(ft1,

…

,ftn)中每个事实文本序列进行编码得到向量集合并将其进行拼接,拼接后的向量为hf,然后经过文本库感知注意力机制,计算输入序列对事实文本序列的注意力向量为h;整个过程表示为:

[0066]hi

=f

enc(i)[0067]hft

=f

enc

(ft))

[0068][0069][0070]

其中,f

enc

(

·

)代表transformer编码器的编码过程。

[0071]

step3.2、在解码端,transformer解码器由masked multi-head attention和encoder-decoder attention两大机制组成;在解码端主要做了两处改进:(1)在encoder-decoder attention处,用注意力向量h取代原来的输入序列向量hi作为编码器传递到解码器的隐向量,即k=v=h,q=hv;(2)在解码器中新增了文本库感知注意力机制,输入是事实文本序列的特征向量hf和encoder-decoder attention输出的向量h

enc-dec

,输出是注意力向量h

t-aware

;解码过程遇到“[bos]”标签代表解码开始,遇到“[eos]”标签代表解码结束;使用了基于文本库感知注意力机制的编解码框架,后续用f

enc

(

·

)表示模型的编码过程,f

dec

(

·

)表示模型的解码过程;

[0072]

整个过程表示为:

[0073][0074][0075]

step3.3、在问句分解模块的学习目标是把复杂问题分解成简单子问题序列:

[0076]

输入为复杂问题q,事实文本集合为f,输出为分解后的子问题序列dq;首先在编码端,对输入q进行编码得到问题嵌入hi=f

enc1

(q),对事实文本f进行编码后拼接得到事实文本嵌入hf=f

enc1

(f),经过文本库感知注意力机制得到一个注意力向量h=attention(hi,hf);然后在解码端,接收注意力向量h,并通过文本库感知注意力机制预测分解的表示dq=f

dec1

(h);在每个时间步,先前的输出右移并送入解码器;

[0077]

step3.4、在信息抽取模块的学习目标是从原始复杂问题和简单子问题序列中提取语义信息:

[0078]

输入为子问题序列dq,附加信息为分解阶段的隐层嵌入e=h,事实文本信息为f,输出为语义信息序列ei;首先在编码端,同理得分解嵌入事实文本嵌入注意力向量然后将附加信息和隐向量进行拼接[h,h

dq

];最后在解码端,解码语义信息ei=f

dec2

([h,h

dq

]);

[0079]

step3.5、在语义解析模块的学习目标是整合信息生成结构化查询语句:

[0080]

输入为语义信息ei,附加信息为前两阶段的隐层嵌入e=[h,h

dq

],事实文本信息为f,输出为结构化查询语句lf;同理得语义表示嵌入事实文本嵌入注意力向量拼接向量[h,h

dq

,h

ei

],解码结构化查询语句lf=f

dec3

([h,h

dq

,h

ei

])。

[0081]

所述step3还包括:

[0082]

step3.6、训练目标是生成简单子问题序列,抽取关键谓词和实体信息,最终生成相应的查询语句;设计的联合训练损失函数如下,分别由三个阶段的损失函数l1,l2和l3组成:

[0083]

l(θ)=λ1l1+λ2l2+l3[0084]

其中,三个阶段的任务都使用生成式模型的损失函数:

[0085]

p(x)=softmax(wx+b)

[0086][0087]

step4、为了验证融合事实文本的问句分解式语义解析方法的有效性和优越性,本发明选取了5个当前主流的方法作为基线模型进行对比实验。对本发明在语义解析任务和问题分解任务中的实验结果都进行了相应的比较和分析,并且直观地给出了相应的实例分析。

[0088]

step4.1、本发明在大规模复杂问题数据集complexwebquestions(version1.0)上进行了实验。该数据集包含27734训练样本、3480验证样本和3475测试样本。每个样本都包含复杂问题、分解的子问题序列、sparql格式的结构化查询语句;

[0089]

step4.2、本发明的语料库由复杂问题、所有的中间表示、sparql查询语句和事实文本构成,构造词表时是由语料库中词频大于3的所有单词构成。本发明使用预训练的词嵌入glove,维度为300维。对于没有预训练的词嵌入(包括unk、bos和eos)使用随机初始化。本发明所有的编码器和解码器都是由6个相同层堆叠起来的,隐向量为300维。使用adam优化器,β1=0.9,β2=0.98,ε=10-9

。学习率在训练过程中动态调整。dropout设置为0.2。标签平滑率设置为0.1。在训练过程中,batchsize=64,训练步长为40000。每1200步验证一次,验证过程的batchsize=160。训练结束后,采用beam size=16的束搜索策略生成sparql语句。

[0090]

step4.3、实验选取了5个当前主流的方法作为基线模型,分别是pointergenerator,主要利用数据重组的框架将先验知识注入序列到序列的模型中,并且使用了一种基于注意力的复制机制;transformer的整个网络结构完全由注意力机制组成,本发明主要利用transformer做语义解析任务;coarse2fine的一个结构感知的神经架构,采用由粗到细的两阶段生成方法,先生成忽略细节的表示,再将细节填充到之前的表示中;pointernetwork主要通过指针网络生成分割点,对原始复杂问题进行切割和分解,得到一系列简单问题序列;hsp主要针对复杂问题提出基于序列到序列模型的层次语义解析方法,将语义解析任务转化为多层次的生成任务,实验效果显著提高;

[0091]

step4.4、本发明的目标是将自然语言描述的复杂问题最终解析为逻辑形式,即sparql格式的结构化查询语句。因此语义解析任务的实验效果是验证该方法有效性的重要指标。在该任务中,选取pointergenerator、transformer、coarse2fine和hsp作为基线模型在验证集和测试集上进行了对比实验。评价指标为em值,即模型生成sparql语句的正确率。实验结果如表1所示;

[0092]

表1语义解析任务的实验结果

[0093]

tab.1 experimental results on semantic parsing tasks

[0094]

模型验证集(%)测试集(%)

pointergenerator53.1051.00transformer56.7853.41coarse2fine58.5958.07hsp68.7966.18本发明70.42(+1.63)67.62(+1.44)

[0095]

通过分析表中数据可以得出以下三点结论:

[0096]

(1)transformer在测试集上的准确率为53.41%,比pointergenerator高2.41%。这组实验证明,对于传统的序列到序列模型来说,在complexwebquestions数据集上做语义解析任务是比较困难的。因此针对复杂问题的语义解析任务本身是存在难度的;

[0097]

(2)hsp在测试集上的准确率为66.18%,比coarse2fine高8.11%,性能得到很大提升。这组实验证明,与其他的神经语义解析模型相比,hsp的性能提升显著。说明将复杂问题分解成简单问题,采用分治的思想可以简化模型在每个阶段的表示学习,同时通过信息整合可以帮助模型更好的生成结构化查询语句;

[0098]

(3)本发明的方法在测试集上的准确率为67.62%,比hsp高1.44%。这组实验证明,本发明提出的文本库感知注意力机制能够将知识库中的事实文本信息融入模型的学习过程,使模型在生成任务中获得更高的准确率。

[0099]

step4.5、本发明提出的方法旨在缓解问句分解过程中的错误积累问题,减少实体误判和丢失的情况,为后续的语义解析任务提供保障。因此提升问题分解任务的实验效果十分必要,能够充分验证分治思想的有效性。在该任务中,选取pointernetwork、pointergenerator和hsp作为基线模型在验证集和测试集上进行了对比实验。评价指标为bleu-4和rouge-l得分。对于所有模型,输入是复杂问题,输出是分解的子问题序列。实验结果如表2所示;

[0100]

表2问题分解任务的实验结果

[0101]

tab.2 experimental results on question decomposition tasks

[0102][0103]

通过分析表中数据可以得出以下三点结论:

[0104]

(1)与pointernetwork相比,其他两个模型的实验结果更好,说明对于问题分解任务,相比起利用分割的思想在问题中寻找分割点的方法来说,采用神经生成问题的方法更有效。

[0105]

(2)hsp与其他两个模型相比性能提升显著。说明将复杂问题分解成简单问题的思想能够指导模型更好的理解复杂语义。

[0106]

(3)本发明的方法与hsp相比,在测试集上bleu-4值提升了2.2,rouge-l值提升了0.9。说明在分解任务中,融入事实文本信息能够使模型获取更丰富的知识表示,有效减少错误传播。

[0107]

step4.6、为了直观的对实验结果进行分析和对比,使本发明的方法具备更高的可解释性,我们将结合测试集中的一个实例来分析模型在每个阶段的实验效果,选取性能较好的hsp作为基线模型,验证以上实验结果的准确性。

[0108]

比如输入一个复杂问题”the author of the art of war lived in what city?”,主题实体为”the art of war”。基线模型hsp在经过每个模块后,输出的序列如表3所示。当输入的复杂问题经过问题分解模块后,分解成两个简单子问题序列,使用”[#]”作为分割符,通常第二个子问题会包含第一个子问题的答案实体,使用”[#entity#]”作为占位符。接下来,信息抽取模块将抽取原始复杂问题和简单子问题的关键信息,包括复杂类型和谓词信息,使用”[#]”作为分割符。最后,语义解析模块生成对应的逻辑形式,使用”[.]”作为分隔符,使用”[#entity#]”作为占位符。

[0109]

表3基线模型hsp的输出序列

[0110]

tab.3 output sequence of baseline model hsp

[0111]

复杂问题the author of the art of war lived in what city?分解的子问题the person who once lived in author?#where did#entity#live?抽取的信息composition#people.person.places_lived#people.place_lived.location逻辑形式?y people.person.places_lived#entity#.?y people.place_lived.location?x.

[0112]

对表3中的实例进行分析,可知基线模型hsp中问题分解模块的输出序列是错误的。实现结果表明,问题分解阶段的bleu-4值为0.35*10-4,rouge-l值为0.46。因为第一个子问题将”author”解析成一个居住地点,且两个子问题中都不包含主题实体”the art of war”,导致后续信息抽取和语义解析模块的输出序列仍然是错误的。实验结果表明,语义解析阶段的bleu-4值为0.43*10-3,rouge-l值为0.54。

[0113]

所以,本发明的方法将融入事实文本信息以缓解实体识别错误和实体丢失的现象。仍以该复杂问题为例,融入的事实文本如表4所示。这些文本信息虽然在语法上并不符合规范,但却极大程度的保留了三元组的事实信息。

[0114]

因此,本发明的模型在经过每个模块后,输出的序列如表5所示。可以看出,问题分解模块的输出序列已经被矫正,一定程度上缓解了错误积累的问题。实验结果表明,问题分解阶段和语义解析阶段的的bleu-4值均为1,rouge-l值均为1。由此验证了本发明方法的优越性和准确性。

[0115]

表4融入的事实文本序列

[0116]

tab.4 incorporated factual text sequence

[0117]

[0118][0119]

表5本发明方法的输出序列

[0120]

tab.5 output sequence of the method of the invention

[0121]

复杂问题the author of the art of war lived in what city?分解的子问题the author of the art of war?#in what city did#entity#live?抽取的信息the author of the art of war?#in what city did#entity#live?逻辑形式?y media.dedication.work_author#entity#.?y people.person.places_lived?x.

[0122]

实验结果表明,该方法能够提升知识库问答技术面对复杂问题的理解能力,能够更好的对复杂问题作出回答。本发明在语义解析任务和问题分解任务中比较于基线模型均有明显的提升。

[0123]

上面结合附图对本发明的具体实施方式作了详细说明,但是本发明并不限于上述实施方式,在本领域普通技术人员所具备的知识范围内,还可以在不脱离本发明宗旨的前提下作出各种变化。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1