一种基于改进Unet网络的甲状腺结节分割方法

一种基于改进unet网络的甲状腺结节分割方法

技术领域

1.本发明涉及图像处理技术领域,尤其涉及一种基于改进unet网络的甲状腺结节分割方法。

背景技术:

2.目前,超声成像凭借着廉价、无辐射、实时等优点,成为甲状腺诊断的首选技术;由于超声图像对比度低,存在着大量的噪声,边缘也相对模糊,因此常规的分割方法对于超声甲状腺结节的分割难以达到较高的精确度,不准确的分割容易造成医生的错误诊断与治疗,后果极其严重。

3.随着深度学习的火热,计算机医疗技术的发展,人们越来越关注于深度学习相关的医学图像分割技术。cnn因为其强大的处理比例不变性、建模归纳偏向的能力在深度学习领域应用广泛。其中,ronneberger提出的unet网络凭借着能够在数据量匮乏的医学图像领域仍然有良好的分割效果。

4.由于卷积的作用是局部的,容易出现感受野受限的问题,对于上下文全局信息的捕获具有一定的挑战,即缺少了甲状腺周围组织对于结节分割的辅助作用。同时缺乏语义先验信息,容易出现较小的结节与较大的结节两者边界合并的问题,分割的性能难以达到理想的状况。上述问题可以通过引入自注意力机制进行解决,只是普通的自注意力机制忽略了不同频域的特征,过多地关注低频全局信息,容易丢失边缘等局部细节,使得分割结果不够准确。

技术实现要素:

5.本发明解决的技术问题是:为了帮助医生进行准确的甲状腺结节分割,对结节区域进行精确的定位,同时增强全局上下文与局部信息,降低甲状腺结节分割的误差。

6.本发明所采用的技术方案是:一种基于改进unet网络的甲状腺结节分割方法,包括以下步骤:

7.步骤一、对公共甲状腺超声图像数据集进行图像大小统一、随机翻转、旋转和增强对比度操作,并按照8:1:1划分成训练集、验证集和测试集;

8.步骤二、构建改进unet网络,首先在unet网络的前3个下采样卷积块后增加自注意力残差连接块;其次在第4个下采样卷积块后增加高低频自注意力自适应融合模块;最后在高低频自注意力自适应融合模块之后接入语义增强模块;

9.在编码阶段加入自注意力残差连接块能在多个尺度上捕获远程依赖与上下文全局信息,同时能够将自注意力初始化为卷积,从而弥补自注意力需要大量的数据学习位置偏差的缺陷;

10.高低频自注意力自适应融合模块用于增强语义特征的全局上下文依赖,同时通过高频捕捉局部细节、低频关注全局结构,增强特征提取的准确度;

11.步骤三、使用argmax判断像素值属于结节或背景。

12.本发明的有益效果:

13.1、以unet网络作为本发明网络模型的主体架构,能够帮助模型在数据量缺乏的情况下依然达到理想的效果,在编码阶段加入自注意力残差连接块,在多个尺度上捕获远程依赖与上下文全局信息,同时能够将自注意力初始化为卷积,从而弥补自注意力需要大量的数据学习位置偏差的缺陷;

14.2、高低频自注意力自适应融合模块赋予自注意力同时在高频捕捉局部边缘细节、在低频捕获全局上下文结构的能力;

15.3、语义增强模块通过加入语义先验信息增强特征提取阶段的语义特征,本发明方法在甲状腺数据集tn3k上分割性能有了较大的提升,dsc相比unet提升了2.1%,miou相比unet提升了1.3%;对于甲状腺结节分割任务中噪声等干扰因素过多、边缘不清晰的问题,得以较好地解决。

附图说明

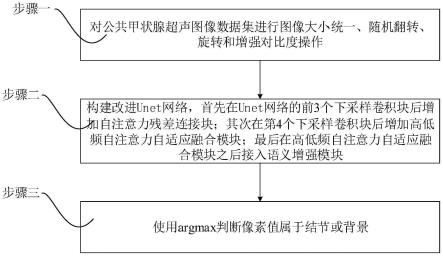

16.图1是本发明的基于改进unet网络的甲状腺结节分割方法流程图;

17.图2是本发明的图像分割模型图;

18.图3是本发明的分割模型内部模块的结构图;

19.图4是本发明的高低频自注意力自适应融合模块;

20.图5是本发明的语义增强模块;

21.图6是本发明的训练好的模型进行分割效果图。

具体实施方式

22.下面结合附图和实施例对本发明作进一步说明,此图为简化的示意图,仅以示意方式说明本发明的基本结构,因此其仅显示与本发明有关的构成。

23.如图1所示,基于改进unet网络的甲状腺结节分割方法包括以下步骤:

24.步骤一、对公共甲状腺超声图像数据集进行图像大小统一、随机翻转、旋转和增强对比度操作,并按照8:1:1划分成训练集、验证集和测试集;

25.s1、将公共的超声甲状腺结节数据集tn3k裁剪成256

×

256尺寸的图像,训练、验证的图像一共2879张;

26.步骤二、构建改进unet网络,首先在unet网络的前3个下采样卷积中增加自注意力残差连接块;其次在第4个下采样后增加高低频自注意力自适应融合模块;最后在高低频自注意力自适应融合模块之后接入语义增强模块;

27.在编码阶段加入自注意力残差连接块能在多个尺度上捕获远程依赖与上下文全局信息,同时能够将自注意力初始化为卷积,从而弥补自注意力需要大量的数据学习位置偏差的缺陷;

28.高低频自注意力自适应融合模块用于增强语义特征的全局上下文依赖,同时通过高频捕捉局部细节、低频关注全局结构,增强特征提取的准确度;

29.s2、搭建基于自注意力残差连接块、高低频自注意力自适应融合模块与语义增强模块的甲状腺结节分割网络,即改进unet网络,将pytorch读取的甲状腺图像数据送进网络中;

30.进一步的,如图2为改进unet网络图,具体包括:

31.s21、unet主体结构包括一个双卷积块、4个下采样卷积块、4个上采样卷积块,下采样卷积块由最大池化,一个双卷积块组成,其中双卷积块为两组3

×

3卷积、bn归一化层和relu激活函数;下采样卷积块由最大池化,一个双卷积块组成,其中双卷积块为两组3

×

3卷积、bn归一化层和relu激活函数;上采样卷积块由双线性上采样,一个双卷积块组成,其中,双卷积块为两组3

×

3卷积、bn归一化层和relu激活函数;

32.一个双卷积块将输入通道数变成64,然后经过4个下采样卷积块,通道数分别变为128、256、512、512,之后经过4个上采样卷积块,通道数变为256、128、64、64,最后1

×

1卷积变成类别个数;

33.s22、如图3为自注意力残差连接块结构图,自注意力残差连接块接在前3个下采样卷积块的后面,将自注意力以残差方式连接,将其初始化为卷积,自注意力残差连接块中分两个残差连接块,第一个残差连接块是bn归一化和高效多头自注意力机制(esa),其中,高效多头自注意力先将特征经过linear线性层映射成query(q),然后将特征送入最大池化层变成8

×

8尺寸的特征图,再经过linear线性层计算自注意力中的key(k)和value(v)以减少计算,公式如下:

[0034][0035]

其中,q为原特征映射的query,k、v为经过最大池化层后再经映射的key、value;t为转置计算;dh为多头注意力机制一个头的隐藏维度数,本实施例中本实施例中用于训练时有更稳定的梯度;softmax为激活函数,用于归一化。

[0036]

第二个残差连接块由bn归一化、relu激活函数和3

×

3卷积组成;

[0037]

s23、如图4为高低频自注意力自适应融合模块结构图,高低频自注意力自适应融合模块以残差连接的方式放置在第4个下采样卷积块的后面,用于增强语义特征的全局上下文依赖,同时通过高频捕捉局部细节、低频关注全局结构,增强特征提取的准确度;高低频自注意力自适应融合模块由窗口多头注意力和高效多头自注意力并行组成,其中,窗口多头注意力先将整个特征(512

×

16

×

16)分成4个小窗口(512

×8×

8),分别在每个窗口内进行自注意力的计算,然后整合;高效多头自注意力中的query(q)由linear线性层映射而来,而key(k)和value(v)需先分别进行最大池化和平均池化,池化特征大小为8

×

8,然后将两个池化结果相加,再经过linear线性层计算key(k)和value(v),并且设置了两个可学习的参数,初始化为1,以残差连接的方式将高低频注意力的特征自适应的加到原特征上,公式如下:

[0038]

y=x

ori

+a1×

x

gao

+a2×

x

di

(2)

[0039]

其中,x

ori

为传入的特征,x

gao

、x

di

分别为高低频注意力处理的特征,a1、a2分别为两个可学习的权重参数;

[0040]

s24、如图5为语义增强模块,语义增强模块放置在高低频自注意力自适应融合模块之后,将高低频自注意力自适应融合模块后的特征经过linear线性层将通道数转换成类别数2作为query(q)、key(k),同样经过linear线性层不改变通道数作为value(v),然后将q转换成512

×

16

×

16进行8倍双线性上采样至原图大小,与标签进行监督,产生的损失为

loss2,同时进行语义注意力(ysa)的计算,将q、k、v传入下式:

[0041]

ysa=softmax(qk

t

)v(3)

[0042]

其中,q、k、v为经过linear层映射到的query、key、value,t为转置,softmax为激活函数,用于归一化。

[0043]

然后将语义注意力处理的特征经过linear线性层,并设置一个可学习的参数λ对特征进行微调,然后与残差连接的特征进行相加,得到最后的语义增强后的特征,语义增强模块产生的损失与最后的预测图产生的损失相加,进入反向传播过程,语义增强的损失权重值为0.4。

[0044]

步骤三、使用argmax判断像素值属于结节还是背景;

[0045]

对于损失函数,使用交叉熵损失函数和dice损失函数进行加权求和,两者各赋予0.5的权值;

[0046]

使用adam优化器进行反向传播,初始学习率设为0.0001,对于学习率调整,首先预热(warm_up)5轮,然后使用余弦退火算法,即通过余弦函数降低学习率,训练的batch_size为24,本次实验所用设备为一个teslav100,软件环境为python3.8,pytorch1.7.0。

[0047]

为了验证本发明模型的性能,使用dice相似系数(dsc)和均交互比(miou)进行实验评估,指标计算公式如下:

[0048][0049][0050]

其中,p为网络预测的分割结果,t为真实标签。

[0051]

最后在验证集上判断网络已经训练稳定,选择dsc最高的一轮模型权重,在测试集上进行测试,可以看出,本发明的分割模型相比unet在dsc上提升了2.1%,在miou上提升了1.3%。

[0052]

网络结构dscmiouunet75.9%84.8%本发明78.0%86.1%

[0053]

以上述依据本发明的理想实施例为启示,通过上述的说明内容,相关工作人员完全可以在不偏离本项发明技术思想的范围内,进行多样的变更以及修改。本项发明的技术性范围并不局限于说明书上的内容,必须要根据权利要求范围来确定其技术性范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1