基于混合神经网络的仿生视觉传感器光流预测方法

1.本发明涉及图像处理领域,具体涉及一种基于混合神经网络的仿生视觉传感器光流预测方法。

背景技术:

2.由于仿生视觉传感器时空数据的离散特性,我们并不能直接用传统的卷积神经网络(cnn)进行时空数据的光流预测。因此以往的仿生视觉传感器时空数据的光流预测大多将时空数据流按固定事件数量或固定时间间隔进切片然后转为图像帧,然后把图像帧送进传统的卷积神经网络(cnn)中进行训练。然而用固定事件数量或固定时间间隔进切片然后转为图像帧的方法会造成图像帧中存在目标拖影或者信息丢失现象,而且网络会对图像帧中的每一个像素进行计算,极大的增加计算量,丧失了仿生视觉传感器低数据量的优势。

3.现如今主流的成像器件为ccd和cmos图像传感器,它们以帧的成像模式输出图像,输出的图像比较直观且能较好的取悦人眼。但以帧为基础的传输方式,对场景中每个画面都成像,有大量的冗余数据,不利于图像的实时处理,而且有帧频的限制,会在帧间隔期间丢失高速运动目标的运动信息,不适用于机器视觉领域,因此便应运而生了仿生视觉传感器。该传感器由于其特殊的像素结构,只对光强发生变化的地方成像,根据像素点的光强变化生成事件(e={x,y,t,p}),输出事件流,在事件(e={x,y,t,p})中包含位置信息(x,y),极性信息(光强变强或变暗)(p),时间信息(t)。因此该仿生视觉传感器的输出数据为由离散事件组成的时空数据流。

4.由于其特殊的数据格式,现有的图像处理算法并不适用于仿生视觉传感器。为了促进仿生视觉传感器在机器视觉方面的应用,一些科研工作者提出了基于仿生视觉传感器的光流估计。

5.现有专利202011408555.1提出一种基于事件相机的端到端的无监督光流估计方法。利用事件相机输出的事件流,首先对原始数据进行预处理,将四维转换为三维,然后将每个样本分为多个子序列,每个子序列用convlstm单独处理,全部处理完以后按通道拼接形成最终送入光流预测网络中的三维数据。采用类似于编码/解码器的光流预测网络,利用事件相机固定频率输出的事件流数据的前后两个灰度帧设计光度误差损失,加上平滑度损失,共同作为无监督损失,促使网络最终估计出光流量。

6.上述所提到的方法,虽然是一种端到端的无监督光流估计方法,但是在数据预处理阶段对时空数据流按固定事件数量进行切割,如果切割不当会造成拖影或者目标丢失现象,从而影响光流预估精度。而且上述方法依旧是将事件构建成图像帧送入网络进行计算,极大的增加了计算量,而且丧失了事件相机低数据量的优势。

技术实现要素:

7.本发明为解决现有光流预测方法存在拖影或者目标丢失现象,进而影响光流预估精度且存在增加计算量,导致丧失事件相机低数据量的优势等问题,提供一种基于混合神

经网络的仿生视觉传感器光流预测方法。

8.基于混合神经网络的仿生视觉传感器光流预测方法,该方法由以下步骤实现:

9.步骤一、获取公开数据集中仿生视觉传感器的时空数据流以及标记光流图像;并对所述时空数据流进行自适应切片;

10.步骤二、构建用于仿生视觉传感器光流预测的混合神经网络,使网络能够进行光流预测;

11.步骤三、设计整体网络训练的损失函数,对网络进行有监督训练,获得有监督光流估计模型;

12.步骤四、利用所述有监督光流估计模型对仿生视觉传感器的时空数据流进行光流预测,获得预测的光流图像。

13.本发明的有益效果:

14.本发明提出的光流预测方法在时空数据流预处理阶段根据场景内目标运动状态进行自适应切割,使进入网络的时空数据流切片内既不存在目标拖影也不存在信息丢失现象,从而提高光流预测精度。

15.本发明提出的网络模型可直接接收离散时空数据流,不再需要将时空数据流构建为图像帧,极大的减少了数据量,提高了计算速度,保留的仿生视觉传感器低数据量的优势。

16.本发明利用标记好光流和预测光流的幅值差和角度差构建损失函数,对网络进行有监督训练,提高光流预测准确性。

附图说明

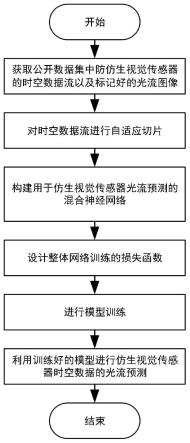

17.图1为本发明所述的基于混合神经网络的仿生视觉传感器光流预测方法的流程图;

18.图2为本发明采用的混合神经网络模型示意图。

具体实施方式

19.结合图1和图2说明本实施方式,基于混合神经网络的仿生视觉传感器光流预测方法,该方法由以下步骤实现:

20.步骤一、获取公开数据集中仿生视觉传感器的时空数据流以及标记光流图像;并对所述时空数据流进行自适应切片;

21.本实施方式中,首先获取网络上公开数据集,从中获取仿生视觉传感器的时空数据流数据以及标记好的光流图像。利用现有专利文件基于仿生视觉传感器时空数据流的自适应切割方法,专利号为2021110973961.0;对时空数据流进行自适应切片,并将时空数据流的空间分辨率限制为256

×

256。然后将切片数据以离散形式送入训练好的混合神经网络进行光流预测。使送入网络的时空数据流切片既不存在信息缺失也不存在目标拖影现象。与现有的仿生视觉传感器光流预测方法相比,该方法具有高预测精度,低运算量的优势。

22.步骤二、构建用于仿生视觉传感器光流预测的混合神经网络,使网络能够进行光流预测;

23.本实施方式中,混合神经网络结构采用多尺度特征相结合的结构,通过多尺度特

征提取,在高尺度下获取更多的细节信息,在低尺度下获取更多的轮廓信息,从而使网络预测出的光流信息更加准确。该混合神经网络由snn下采样脉冲特征编码模块、脉冲特征同步模块、transformer全局特征提取模块,cnn上采样解码模块及光流信息输出层组成,网络整体结构如图2所示。

24.snn下采样脉冲特征编码模块主要用于提取不同尺度的脉冲序列特征图,由三层snn网络组成,每层包含若干个以leaky integrate-and-fire(lif)为模型的神经元,用以完成下采样及特征编码。三层snn网络输出特征通道数量分别为64,128,256。三层网络定义如下:

25.第一层定义输入为单通道的空间分辨率为256

×

256,在时间域上离散时空数据流,输出编码后的64通道空间分辨率为128

×

128脉冲序列特征图;

26.第二层定以输入64通道的空间分辨率为128

×

128脉冲序列特征图,输出编码后的128通道的空间分辨率为64

×

64脉冲序列特征图;

27.第三层定以输入128通道的空间分辨率为64

×

64脉冲序列特征图,输出编码后的256通道的空间分辨率为32

×

32脉冲序列特征图。

28.脉冲特征同步模块用于将snn下采样脉冲特征编码模块输出的脉冲特征序列转换为二维特征图像,用于和cnn解码模块输出的二维特征图相融合。

29.transformer全局特征提取模块为常用的神经网络transformer模块,这里创新性的将其引入到仿生视觉传感器光流预测网络中,主要提取深度全局特征,用于获取时空数据流的轮廓信息。

30.cnn上采样模块组成主要用于二维特征图的上采样,由三层cnn网络组成,每层cnn网络包含一个用于上采样的逆卷积模块。每层定义如下:

31.第一层定义输入为512个通道的空间分辨率为32x32的二维特征图。经过上采样的逆卷积模块输出解码后的128通道的空间分辨率为64x64的二维特征图。

32.第二层定义输入256通道的空间分辨率为64x64的二维特征图。经过上采样的逆卷积模块输出解码后的64通道的空间分辨率为128x128的二维特征图。

33.第三层定义输入128通道的空间分辨率为128x128的二维特征图。经过上采样的逆卷积模块得到解码后的两通道的空间分辨率为256x256的二维特征图。

34.光流信息输出层用于输出网络预测出的光流信息,输入两通道的空间分辨率为256x256的二维特征图。然后经过卷积核大小为3x3步长为1的卷积层得到预测的光流信息。

35.本实施方式中,所述混合神经网络采用跳跃连接,snn下采样脉冲特征编码模块的第一层网络的输出经脉冲特征同步模块后与cnn上采样的解码模块第三层的输入相连。snn下采样脉冲编码模块的第二层网络的输出经脉冲特征同步模块后与cnn上采样的解码模块第二层的输入相连。snn下采样脉冲编码模块的第三层网络的输出经脉冲特征同步模块后与cnn上采样的解码模块第一层的输入相连。本实施方式使网络能够接收离散的时空数据流。降低运算量,保持事件相机低数据量的优势。

36.步骤三、设计整体网络训练的损失函数,对网络进行有监督训练,获得有监督光流估计模型;

37.将步骤一标记好的光流图像及预测的光流图像的幅值差和角度差作为损失函数对光流预测网络进行有监督的训练,从而提高光流预测精度。计算公式如下所示。

[0038][0039]

其中,x为像素点横向运动速度,y为像素点纵向运动速度为标记好的第i个事件切片到第i+1个事件切片的光流,为光流预测网络预测的第i个事件切片到第i+1个事件切片的光流。λ为权重因子,用来调节幅值差和角度差在损失函数中的影响力。

[0040]

步骤四、利用步骤三获取的有监督光流估计模型对仿生视觉传感器的时空数据流进行光流预测,获得预测的光流图像。

[0041]

以上所述实施例的各技术特征可以进行任意的组合,为使描述简洁,未对上述实施例中的各个技术特征所有可能的组合都进行描述,然而,只要这些技术特征的组合不存在矛盾,都应当认为是本说明书记载的范围。

[0042]

以上所述实施例仅表达了本发明的几种实施方式,其描述较为具体和详细,但并不能因此而理解为对发明专利范围的限制。应当指出的是,对于本领域的普通技术人员来说,在不脱离本发明构思的前提下,还可以做出若干变形和改进,这些都属于本发明的保护范围。因此,本发明专利的保护范围应以所附权利要求为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1