一种基于神经辐射场和语义分割的单目视图深度估计方法

1.本发明涉及三维重建单目深度估计技术领域,尤其是一种基于神经辐射场与语义分割信息的单目视图深度估计方法。

背景技术:

2.单目深度估计问题是三维重建领域十分重要的任务,是进行三维重建各类下游任务的前提条件。传统单目深度的获得基本上由深度相机拍摄获取,其估计问题则常常利用运动推断结构法和多视角立体法进行计算,由于这类方法依赖图片质量和纹理特征,所以存在其固有局限性,因而后期发展缓慢。随着深度学习领域的发展,三维重建领域的各类歧义问题引入了新的解法。基于深度学习的三维重建和深度估计技术在最近的几年内发展迅速。单目深度估计是三维重建深度估计中最重要的环节,因为其硬件要求低、操作便利,落地性强,所以是串起整个三维重建流程的重要一环,也为后续的虚拟增强现实技术、机器人技术以及自动驾驶技术等提供强有力的支持。

3.现有的基于深度学习的单目深度估计方法缺乏对低纹理区域特征不足问题的解决方案,无法处理室内场景下难以拥有全局信息时深度歧义的问题。此外,由于室内物体之间相互遮挡关系复杂,常规深度估计方法和神经辐射场算法都难以应对遮挡导致的深度突变问题,使得在部分缝隙处深度估计受前景影响,误差极大。

技术实现要素:

4.本发明的目的是针对现有技术的不足而提供的一种基于神经辐射场和语义分割的单目视图深度估计方法,采用基于神经辐射场的语义分割或者部件分割的方法,利用增强的语义信息提升网络的拟合和自适应能力,实现对单场景下多张视图进行深度估计,有效处理了室内场景下难以拥有全局信息时深度歧义,以及遮挡导致的深度突变问题,使得在部分缝隙处深度估计不受前景影响,误差小,大大提高了单目视图深度深度,尤其是低纹理区域和边缘区域深度的预测效果。该方法使用语义分割网络和深度预测网络构建三维场景或者物体点云进行语义分割或者部件分割系统,将学习的几何卷积核提取点云几何特征,使用网络对点云的边缘进行预测并利用边缘信息更好地提取局部特征,使得点云尤其是边缘区域拥有更好的分割效果。利用场景的语义信息提高图片的物体区分度,解决低纹理区域特征不足问题,并且利用神经辐射场加强全局信息学习,生成的颜色图和语义分割图对网络得到的密度概率信息进行指导,获得更合理和解决真实值的深度信息,有效解决了常规单目深度估计问题中低纹理区域特征不足和自遮挡导致的缝隙深度误差问题,方法简便,使用效果好,优势,具有广泛的应用前景。

5.实现本发明目的的具体技术方案是:一种基于神经辐射场和语义分割的单目视图深度估计方法,其特点是采用基于神经辐射场的语义分割或者部件分割的方法,利用增强的语义信息提升网络的拟合和自适应能力,解决低纹理和自遮挡问题,实现对单场景下多张视图进行深度估计具体包括下述步骤:

步骤1:深度先验预测1-1:将每个场景图片一起输入利用三维重建算法获得场景的稀疏点云,并将点云投影到每个视角下,获得对应视角的稀疏深度图和对应遮罩。

6.1-2:将场景图片单独输入到预训练的深度预测网络,利用其对应的稀疏深度图和尺度不变的损失函数进行指导获得每张图片对应的深度先验图,从而将网络过拟合到该场景,即同一场景所有图片共享网络参数。

7.步骤2:深度先验优化2-1:将每个场景图片单独输入到预训练的语义分割网络,获得对应的语义分割灰度图结果,将语义分割灰度图和步骤1-2获得的深度先验图进行拼接,共同输入到优化网络。

8.2-2:优化网络整体呈编码器-解码器结构,提取不同尺度图片信息,并输出场景每张图片的深度预测图,对深度预测图和步骤1-1获得的稀疏深度图计算尺度不变的损失函数,并与步骤1-2深度预测网络的损失函数一起加权求和,获得总损失函数进行指导,强化场景的语义理解,优化步骤1-2获得的深度先验图。

9.步骤3:神经辐射场训练3-1:利用每张图片的相机位姿参数,在每个像素对应相机视角的射线上采样,采样范围由深度先验图、以及根据深度先验图计算出的深度置信图进行指导,即将颜色图片信息转换为包含点的位置和观察视角的大量空间点的信息。

10.3-2:将所有三维空间点的坐标信息输入到全连接网络,在多层感知机和残差结构后输出每个点对应的密度概率值和分割信息值,同时向网络中输入空间点的视角信息,并在额外的全连接层后输出每个三维空间点的颜色信息值。

11.步骤4:体渲染输出深度图4-1:利用体渲染公式和输出的密度概率信息、分割信息以及颜色信息计算每个像素的预测分割概率分布、预测颜色值,将生成的分割信息和原图对应的语义分割图信息进行比较,计算交叉熵损失;将生成的颜色信息和原图颜色信息进行比较,计算其均方方差损失;将交叉熵损失和均方方差损失的两个函数加权相加,并进行反向传播推进网络训练。

12.4-2:利用完成训练的密度概率信息和每个点采样时的深度信息进行体渲染,得到每个像素最终的深度值,从而完成深度图的生成。

13.4-3:利用体渲染得到的颜色图与输入神经辐射场的原图进行对比,计算其误差作为滤波,对得到的深度图进行过滤优化。

14.所述步骤1的深度先验预测利用场景图片和传统算法预先获得较准确的稀疏深度图作为指导,将常规的预训练深度网络过拟合到当前场景,且所有图片共享网络参数;所述尺度不变的损失函数是指先利用遮罩去除稀疏深度图中不可用的数据,然后利用对数函数放缩数值范围,再计算图片间平均误差,将预测结果每个像素加上平均误差再与真实参考值进行差值计算并求和。

15.所述步骤2的深度优化网络输入将场景图片的语义信息和深度信息拼接,利用语义信息中的类别和边缘信息指导深度图中低纹理区域和边缘区域的深度变化;所述深度优化网络用了u型编码解码结构,充分利用深度预测图和语义分割图的不同尺度信息,并在下采样时在不同尺度上加入原始的卷积层信息,将图片中不同模块的区别度加以强调。

16.所述步骤3的利用深度先验进行神经辐射场采样的指导包括:a1:首先是将每张深度图投影回三维空间形成点,再投影到所有其他视角下,获得每个视角下其他视角投影过来的深度图,并取其中k张误差最小的图作为参考计算其平均误差,误差小的深度值相对准确,误差大的深度值则相反;a2:然后在每个像素对应射线上深度先验的周围采样空间点,并依赖该像素的深度误差图进行采样范围的放缩,其中,由于像素深度误差只可能前景挡后景,所以设置的采样范围主要靠后偏移。

17.所述步骤3的神经辐射场网络除了常规的颜色输出和密度概率输出以外,额外输出与观察视角无关的语义信息,每个空间点输出包含255类语义的概率分布情况。

18.所述步骤4的神经辐射场网络除了利用颜色图进行自监督指导以外,还利用体渲染获得的语义分割信息和先前的语义分割图进行交叉熵计算,进一步加强语义信息的影响;所述过滤是指根据生成颜色图和原图之间的误差设计平面双边滤波器,进一步优化深度图获得最终结果。

19.本发明与现有技术相比具有解决了常规单目深度估计问题中低纹理区域特征不足和自遮挡导致的缝隙深度误差问题,提升了网络的拟合和自适应能力,增强了语义信息,从而提高了深度尤其是低纹理区域和边缘区域深度的预测效果,方法简便,使用效果好,优势,具有广泛的应用前景。

附图说明

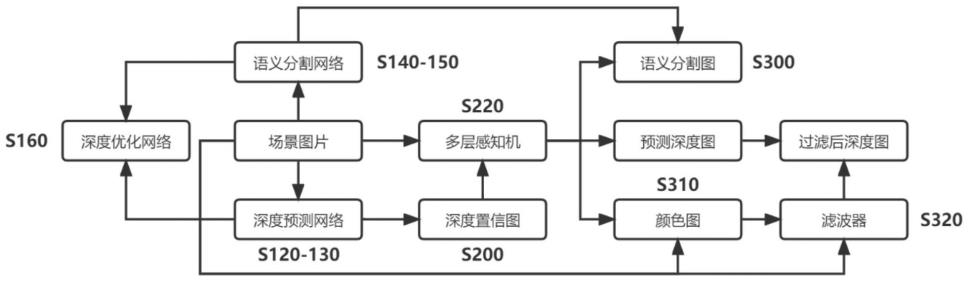

20.图1为本发明流程图;图2为深度先验预测流程图;图3为神经辐射场流程图。

具体实施方式

21.参阅图1,本发明采用基于神经辐射场的语义分割或者部件分割的方法,利用增强的语义信息提升网络的拟合和自适应能力,实现对单场景下多张视图进行深度估计,具体包括下述步骤:s120-130:深度先验预测;s140-150: 深度先验优化;s200-220: 神经辐射场训练;s300-s320: 体渲染输出深度图。

22.本发明利用现有的预训练单目深度估计网络获得场景图片的深度先验,并使用传统三维重建算法获得场景稀疏点云来进行网络的过拟合,将场景图片输入至现有的预训练语义分割网络获得语义分割结果,并与深度先验一起加入进阶网络加强深度先验的语义信息,然后将图片信息输入到全连接网络学习神经辐射场,并利用深度先验指导采样范围,最后利用神经辐射场输出的语义信息进一步加强图片语义理解,从而优化深度学习,利用体渲染算法输出深度图,最后再次利用颜色图对深度图进行过滤优化。

23.以下结合附图及具体实施对本发明作进一步详细描述。

24.实施例1步骤1:深度先验预测参阅图2,深度先验预测具体包括下述步骤:s100:将场景中的多视图rgb图输入到传统的三维重建算法或者软件中(本实施例使用colmap软件),获得场景三维点云。

25.s110:将得到的三维点云投影到每张图片对应的视角下,获得对应的稀疏深度图,同时输出对应的mask遮罩用来去除无深度区域和深度不可靠区域。

26.s120:将场景中图片分别单独输入到预训练好的backbone单目深度预测网络,输出对应深度先验图。

27.s130:利用s110得到的稀疏深度图和s120得到的深度先验图计算尺度不变的损失函数,并进行反向传播从而让网络过拟合到当前场景。

28.所述步骤1中将场景图片单独输入到可用的预训练好的深度预测网络,利用其对应的上述稀疏深度图和尺度不变的损失函数进行指导,从而将网络过拟合到该场景(同一场景所有图片共享网络参数)。

29.步骤2:深度先验优化参阅图2,深度先验优化具体包括下述步骤:s140-150:将场景中图片分别单独输入语义分割网络并直接进行inference预测,不训练网络,获得每张场景图片对应的语义分割图,包含带具体语义的rgb图和只区分不同类别的灰度图,这里只取灰度图。

30.s160:深度优化网络整体为unet结构,上下采样各四次。网络输入为s130中获得的深度先验图和语义分割图(维度拼接),并最终输出灰度图即为优化后的深度图。

31.s170:同样利用s110得到的稀疏深度图和优化网络输出得到的深度图计算尺度不变的损失函数,和s130的损失函数加权在一起共同对深度预测网络和优化网络进行指导和反向传播。

32.所述步骤2中将每个场景图片单独输入到可用的预训练好的语义分割网络,获得对应的语义分割灰度图结果。将语义分割灰度图和s120获得的深度先验图进行拼接,共同输入到优化网络。

33.所述步骤2中的优化网络整体呈编码器-解码器结构,从而提取不同尺度图片信息,并再次输出场景每张图片的深度预测图,与稀疏深度图计算尺度不变的损失函数,与s130的损失函数一起加权求和获得总损失函数进行指导,从而强化场景的语义理解,优化获得的深度先验。

34.步骤3:神经辐射场训练参阅图3,神经辐射场训练具体包括下述步骤:s200:将同一场景的所有深度先验图投影到三维空间中获得对应三维空间点,并将每一张图片的三维空间点投影到其他所有视角下,从而在每个视角下获得自身的深度先验图和其他视角深度先验投影到当前视角下的深度先验图,取其中最接近本身深度先验图的k张,求出它们与本身深度先验图误差的平均值作为当前视角下深度的置信图。

35.s210:过场景中的任一图片的相机光圈中心做m条射线,随机选定图片上的m个像素,每条射线经过各自的像素,根据s130的深度先验设定在射线上采样的基点,采样范围依

赖当前图片对应的深度置信图,如果置信图对应像素值(即误差)小,则围绕采样基点选取较小的采样范围,反之亦然。采样范围设定上下阈值,并且在基点以内的采样阈值较小,在基点以外的采样阈值较大,从而实现大部分采样发生在基点以外。对场景中所有图片进行上述同样处理,获得大量的空间点信息,包含点的位置和观察该点的视角方向。

36.s220:神经辐射场的网络结构整体为一个多层感知机,网络最初的输入是s210中得到的空间点的坐标信息,并在多层感知机设定的某些固定层上附加一个残差结构,重新将网络输入拼接到特征中。

37.s230-250:在神经辐射场多层感知机的多个隐藏层训练后输出每个点的密度概率值和语义分割概率。其中,语义分割概率是指该点属于255个语义类别的概率分布,然后将该点的观察视角信息拼接输入到网络中,继续多层感知机后输出该点的颜色值(rgb三维度)。

38.所述步骤3中的神经辐射场的输入数据是利用每张图片的相机位姿等参数在每个像素对应的过相机视角的射线上采样获得,采样范围由前述深度先验和根据深度先验计算出的深度置信图进行指导,即将颜色图片信息转换为大量空间点的信息,包含点的位置和观察视角。

39.所述步骤3中神经辐射场结构是将所有三维空间点的坐标信息输入到全连接网络,在多层感知机和残差结构后输出每个点对应的密度概率值和分割信息值,同时向网络中输入空间点的视角信息,并在额外的全连接层后输出每个三维空间点的颜色信息值。

40.s220:神经辐射场的网络结构整体为一个多层感知机,网络最初的输入是s210中得到的空间点的坐标信息,并在多层感知机设定的某些固定层上附加一个残差结构,重新将网络输入拼接到特征中。

41.步骤4:体渲染输出深度图参阅图1,体渲染输出深度图具体包括下述步骤:s300-s310:针对每个点在s240和s250输出的颜色值和语义分割概率,利用s230获得的密度概率值和体渲染公式对同一射线上的采样点进行体渲染,获得射线对应图片像素的颜色值和语义分割预测,接着颜色值和原图的像素rgb值计算均方方差损失、语义分割预测和s140-150产出的语义分割图计算交叉熵损失函数,将交叉熵损失和均方方差损失的两个损失函数加权求和,获得总损失函数,反向传播指导网络学习更合理的密度概率分布。

42.s320:利用输入神经辐射场的原图和输出的rgb图进行误差计算,不同于s310计算出整张图片的损失值,此处根据图片逐像素的误差制作置信图,并利用置信图制作平面双边滤波器,对利用体渲染得到的预测深度图(由密度概率值、采样深度计算获得)进一步进行过滤,优化得到最后的深度图结果。

43.所述步骤4中过滤操作是利用体渲染得到的颜色图与输入神经辐射场的原图进行对比,计算其误差作为滤波对得到的深度图进行最后的过滤优化。

44.以上只是对本发明作进一步的说明,并非用以限制本专利,凡为本发明等效实施,均应包含于本专利的权利要求范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1