一种融合自监督多模态特征的视听事件定位方法

1.本发明涉及视听事件定位技术领域,特别是涉及一种融合自监督多模态特征的视听事件定位方法。

背景技术:

2.人类是通过多种不同的感官(比如视觉、听觉、触觉、嗅觉等)协同感知周遭环境的。尽管目前机器学习已经在诸如图像分类(视觉)、语音识别(听觉)与自然语言处理(文本)等单模态任务上取得了飞跃性的进展,但为了更好地教会机器模仿人类感知现实世界的方式,许多需要协同利用多种模态数据的任务被提出。这些多模态的任务更加地贴近实际应用场景,对于其的研究也与日俱增。

3.基于视觉与听觉两种信号进行的视听事件定位是在多模态视频理解与分析领域的重要应用。对于一段给定的视频,算法需要确定在其中何时发生了人们关心的视听事件,并确定发生的事件的类型。由于视听事件具有视觉与听觉两方面的属性,将视频中图像数据与音频数据二者的信息充分利用起来,才能更高效准确地对其进行定位。从一方面来说,尽管多模态的数据相比于单模态提供了更多关于视频内容的有用信息,但由于视觉与听觉信号的构成方式天然不同,这种异质性差别使得融合不同模态的信息存在困难。从另一方面来说,多模态的输入信号也同样带来了更多的噪声。除此之外,当没有感兴趣的视听事件发生时,算法也需要对输入的信号进行处理并将其正确判断为背景。而这些背景往往不像某一特定事件在视觉与听觉上具有显著且独特的特征,使得对其的识别会更加困难。针对这些问题,现有的方法一般将视觉和听觉的特征提取与两种模态信息的融合整合到一个端到端的模型中,并主要聚焦于在融合过程中设计特定的注意力模块对跨模态关系进行建模。但在现有算法中,存在以下主要限制:

4.(1)往往忽视了在特征提取阶段不同模态间信息的交流,这会阻碍后续进行充分的信息融合。

5.(2)在信融合过程中,只考虑了在某些特殊情况下对跨模态关系进行建模时,使得算法整体上缺乏一般性。

6.(3)在没有关心的视听事件发生时,依赖额外的模块或者人工监督去单独识别背景。这些额外的模块/人工监督使得算法在实际应用中的鲁棒性大大降低。

技术实现要素:

7.本发明所要解决的技术问题是提供一种融合自监督多模态特征的视听事件定位方法,能够提高视听事件的识别准确率。

8.本发明解决其技术问题所采用的技术方案是:提供一种融合自监督多模态特征的视听事件定位方法,包括以下步骤:

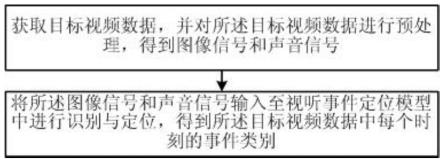

9.获取目标视频数据,并对所述目标视频数据进行预处理,得到图像信号和声音信号;

10.将所述图像信号和声音信号输入至视听事件定位模型中进行识别与定位,得到所述目标视频数据中每个时刻的事件类别;

11.其中,所述视听事件定位模型包括依次连接的视觉-听觉特征提取模块、视听融合模块和分类模块;所述视觉-听觉特征提取模块和所述视听融合模块相互独立;所述视觉-听觉特征提取模块利用cnn和bi-lstm分别对图像信号和声音信号进行空时特征的提取,得到视觉特征和听觉特征;所述视听融合模块基于余弦距离计算异步的视觉特征与听觉特征之间的相似度,并按照时间上相关性衰减的规律对特征对的相似度进行修正再融合特征;所述分类模块基于融合后的视觉特征和听觉特征进行分类,得到所述目标视频数据中每个时刻的事件类别。

12.所述对所述目标视频数据进行预处理具体为:

13.将获取到的目标视频数据分割为若干等长的片段,每个片段中均包含同步的图像数据和声音数据;

14.从每一段图像数据中随机抽取一帧画面并对其进行随机的画面裁切与高斯模糊,得到图像帧信号;将每一段声音数据转换成log-mel谱,得到声音谱信号;

15.将所有的图像帧信号与声音谱信号按时间上的前后顺序排列起来得到图像信号和声音信号。

16.所述视觉-听觉特征提取模块包括视觉提取部分、听觉提取部分、视觉投影层、听觉投影层和互相关矩阵单元,所述视觉提取部分与听觉提取部分结构相同,包括依次连接的cnn和bi-lstm;所述视觉提取部分的输入为所述图像信号,用于提取视觉特征,所述听觉提取部分的输入为所述声音信号,用于提取听觉特征;所述视觉投影层用于将所述视觉特征映射到更高维度的语义空间,得到高维视觉特征;所述听觉投影层用于将所述听觉特征映射到更高维度的语义空间,得到高维听觉特征;所述互相关矩阵单元用于在时间维度上求所述高维视觉特征和所述高维听觉特征之间的互相关矩阵。

17.所述视觉-听觉特征提取模块的损失函数为:其中,c

ij

表示互相关矩阵中第i行第j列个元素,λ是用以平衡对角元素与非对角元素重要性的超参数。

18.所述视听融合模块包括视觉投影矩阵部分、听觉投影矩阵部分、跨模态亲和矩阵部分、视觉更新部分、听觉更新部分和视听融合部分;所述视觉投影矩阵部分用于对所述视觉特征进行可学习参数的线性投影,所述听觉投影矩阵部分用于对所述听觉特征进行可学习参数的线性投影;所述跨模态亲和矩阵部分用于在时间维度求投影后的视觉特征和听觉特征的亲和矩阵,并采用加权矩阵对所述亲和矩阵进行修正;所述视觉更新部分用于基于修正后的亲和矩阵更新视觉特征,所述听觉更新部分用于基于修正后的亲和矩阵更新听觉特征;所述视听融合部分用于对更新后的视觉特征和听觉特征相加以进行融合。

19.所述跨模态亲和矩阵部分通过m

va

=m

avt

求投影后的视觉特征和听觉特征的亲和矩阵,通过对所述亲和矩阵进行逐元素

加权,其中,m

av

和m

va

为亲和矩阵,为可学习参数的听觉投影矩阵,为可学习参数的视觉投影矩阵,d为投影之后特征向量的维度,fa为听觉特征,fv为视觉特征,m

′

av

和m

′

va

为修正后的亲和矩阵,w

av

和w

va

分别是亲和矩阵m

av

和m

va

对应的加权矩阵,表示hadamard乘积,softmax(

·

)表示softmax函数,relu(

·

)表示relu函数。

20.所述视听融合部分通过完成模态间信息的融合,其中,和均为可学习参数的听觉投影矩阵,w

v2

和w

v3

均为可学习参数的视觉投影矩阵。

21.有益效果

22.由于采用了上述的技术方案,本发明与现有技术相比,具有以下的优点和积极效果:本发明在视觉-听觉特征提取的过程中,实现初步的模态间信息交换并缩小视觉与听觉信息之间的异质性差异;在视听信息融合的过程中,减小针对背景的额外人工监督的依赖,并在特征提取的基础之上,通过聚合携带有相似语义信息的视觉与听觉特征来进一步融合跨模态信息,通过上述技术手段提高了视听事件的识别准确率。

附图说明

23.图1是本发明实施方式的流程图;

24.图2是本发明实施方式中视听事件定位模型的示意图;

25.图3是本发明实施方式中视觉-听觉特征提取模块的示意图;

26.图4是本发明实施方式中视听融合模块的示意图。

具体实施方式

27.下面结合具体实施例,进一步阐述本发明。应理解,这些实施例仅用于说明本发明而不用于限制本发明的范围。此外应理解,在阅读了本发明讲授的内容之后,本领域技术人员可以对本发明作各种改动或修改,这些等价形式同样落于本技术所附权利要求书所限定的范围。

28.本发明的实施方式涉及一种融合自监督多模态特征的视听事件定位方法,如图1所示,包括以下步骤:获取目标视频数据,并对所述目标视频数据进行预处理,得到图像信号和声音信号;将所述图像信号和声音信号输入至视听事件定位模型中进行识别与定位,得到所述目标视频数据中每个时刻的事件类别。

29.其中,所述视听事件定位模型包括依次连接的视觉-听觉特征提取模块、视听融合模块和分类模块;所述视觉-听觉特征提取模块和所述视听融合模块相互独立;所述视觉-听觉特征提取模块利用cnn和bi-lstm分别对图像信号和声音信号进行空时特征的提取,得到视觉特征和听觉特征;所述视听融合模块基于余弦距离计算异步的视觉特征与听觉特征之间的相似度,并按照时间上相关性衰减的规律对特征对的相似度进行修正再融合特征;所述分类模块基于融合后的视觉特征和听觉特征进行分类,得到所述目标视频数据中每个时刻的事件类别。

30.本实施方式在视觉-听觉特征提取的过程中,实现初步的模态间信息交换并缩小

视觉与听觉信息之间的异质性差异;在视听信息融合的过程中,减小针对背景的额外人工监督的依赖,并在特征提取的基础之上,通过聚合相似的视觉与听觉特征来进一步融合跨模态信息。如图2所示,本实施方式中的视听事件定位模型整体上不再是端到端的,而是分为前后两个阶段:特征提取与信息融合,并且这两个阶段能够相互促进,大大提高事件定位的效率。

31.本实施方式中视觉-听觉特征提取模块包括视觉提取部分、听觉提取部分、视觉投影层、听觉投影层和互相关矩阵单元,所述视觉提取部分与听觉提取部分结构相同,包括依次连接的cnn和bi-lstm;所述视觉提取部分的输入为所述图像信号,用于提取视觉特征,所述听觉提取部分的输入为所述声音信号,用于提取听觉特征;所述视觉投影层用于将所述视觉特征映射到更高维度的语义空间,得到高维视觉特征;所述听觉投影层用于将所述听觉特征映射到更高维度的语义空间,得到高维听觉特征;所述互相关矩阵单元用于在时间维度上求所述高维视觉特征和所述高维听觉特征之间的互相关矩阵。

32.在第一阶段中,采用自监督的方式对特征提取模块进行训练,如图3所示。首先,对于输入的视频s,将其分割为t个等长的片段,并且每个片段s

t

包含同步的图像数据v

t

和声音数据a

t

。在训练模块的每一个周期中的预处理阶段,都会从每一个图像数据v

t

中随机抽取一帧画面并对其进行随机的画面裁切与高斯模糊,得到图像帧信号frame

t

;将每一个声音数据a

t

转换成log-mel谱,得到声音谱信号spec

t

。将所有的图像帧信号frame

t

与声音谱信号spec

t

按时间上的前后顺序排列起来得到预处理完毕的结果,即图像信号frame与声音信号spec,将它们送入特征提取模块。在特征提取模块中依次使用cnn和bi-lstm进行视觉、听觉信号的空时特征的提取,得到视觉特征fv和听觉特征fa。然后通过两个投影层分别将视觉特征fv和听觉特征fa映射到更高维度的语义空间中,得到高维视觉特征zv和高维听觉特征za。

33.由于同步的视觉与听觉的信号都是由同一事件同时所产生,它们可以看作是对同一事件的两种不同表达,自然而然也具有极高的相关性。为了让特征提取模块能够学习到高质量的视听联合特征,本实施方式提出了一种新的自监督损失函数。为了计算损失函数,先在高维视觉特征zv和高维听觉特征za的时间维度上求它们之间的互相关矩阵c,互相关矩阵c中的第i行第j列个元素c

ij

定义如下:

[0034][0035]

t代表来自第t个视频-音频片段,i和j则是代表在高维听觉特征za和高维视觉特征zv中元素对应所处的位置。然后缩小该互相关矩阵与单位对角阵(同样维度大小)之间的差别,最终损失函数l

avbt

如下:

[0036][0037]

其中,λ是用以平衡对角元素与非对角元素重要性的超参数。在训练过程中最小化l

avbt

即可使得特征提取模块学习如何提取出高质量的特征,通过提高视听特征在语义上的相似性,缩小了不同模态信息之间的异质性差异,初步在同步的视觉、听觉信号之间交换了信息。

[0038]

需要说明的是,在第一阶段对于特征提取模块的训练结束之后,将冻结特征模块中的参数,并用其对于数据集中的视频提取固定的视觉特征fv和听觉特征fa用以后续进一步的跨模态信息融合。

[0039]

本实施方式中,视听融合模块包括视觉投影矩阵部分、听觉投影矩阵部分、跨模态亲和矩阵部分、视觉更新部分、听觉更新部分和视听融合部分;所述视觉投影矩阵部分用于对所述视觉特征进行可学习参数的线性投影,所述听觉投影矩阵部分用于对所述听觉特征进行科学系参数的线性投影;所述跨模态亲和矩阵部分用于在时间维度求投影后的视觉特征和听觉特征的亲和矩阵,并采用加权矩阵对所述亲和矩阵进行修正;所述视觉更新部分用于基于修正后的亲和矩阵更新视觉特征,所述听觉更新部分用于基于修正后的清河矩阵更新听觉特征;所述视听融合部分用于对更新后的视觉特征和听觉特征进行融合。

[0040]

在第二阶段中,将在第一阶段训练得到的视觉特征和听觉特征基础之上,并在训练样本的标签监督之下训练视听融合模块,进一步地融合跨模态信息,具体如图4所示。在这个阶段,主要的目的是基于余弦距离计算异步的视距与听觉特征之间的相似度,并按照时间上相关性衰减的一般规律(即相隔时间越远的视觉与听觉信号之间存在关联程度越弱),对特征对的相似度进行修正之后再聚合相似度高的特征。具体地来说,以将特征提取模块中提取的视觉特征fv和听觉特征fa作为输入,在经过线性投影之后沿着时间维度求它们的亲和矩阵,如下:

[0041][0042]

其中,为可学习参数的听觉投影矩阵,为可学习参数的视觉投影矩阵,d为投影之后特征向量的维度。对m

av

和m

va

使用一个基于视听特征之间时间差的权重对其进行逐元素加权,公式为:

[0043][0044]

其中,relu(

·

)表示relu函数,用于滤除负相关的视听特征对;softmax(

·

)表示softmax函数,用于对矩阵中的每一行进行归一化;表示hadamard乘积,能够实现对每一个视听特征对进行加权;w

av

和w

va

分别是亲和矩阵m

av

和m

va

对应的加权矩阵。以w

av

为例,其计算公式为:

[0045][0046]

其中,i

′

与j

′

分别索引第i

′

时刻的听觉特征与第j

′

时刻的视觉特征(i

′

与j

′

的绝对值差即代表视觉与听觉特征之间的时间差),也同样代表这两个特征的相关性在m

av

中所处的位置;exp(

·

)是指数函数;θ为一个可设置的超参数,用于平衡特征对之间的时间差与特征对本身之间相似度对于加权操作的影响,能够直接影响视听融合模块的最终效果。然后利用经过修正的亲和矩阵分别更新视觉与听觉模态的特征,并将不同模态的特征相加以完成模态间信息的融合,计算公式如下:

[0047]f′a=w

a3

(m

′

av

(w

a2

fa)+fv)

[0048]f′v=w

v3

(m

′

va

(w

v2fv

)+fa)

[0049]

其中,w

a2

和w

a3

均为可学习参数的听觉投影矩阵,w

v2

和w

v3

均为可学习参数的视觉投影矩阵。

[0050]

完成跨模态信息的融合之后,将融合后的视觉特征和听觉特征加在一起,并送入分类模块。在本实施方式中,分类模块是一个3层的感知机,最终的分类结果计算公式如下:

[0051]

p=mlp(layernorm(f

′a)+layernorm(f

′v))

[0052]

其中,layernorm(

·

)是层归一化函数。对于一个被分成t个片段的视频,对其输出的预测p维度为r

txc

,即每个片段分别属于那一类事件亦或是背景。在训练融合模块与分类层的过程中,损失函数为输出预测p与视频真实标签gt之间的交叉熵。

[0053]

为了验证本实施方式的有效性,基于pytorch平台搭建模型并在ave数据集上进行实验。

[0054]

实验数据:ave数据集包括了4143个视频并涵盖了28个视听事件种类,其中包括多个领域例如乐器演奏、人类行为、载具活动以及动物活动等。该数据集默认划分为三个子集:训练集、验证集与测试集,分别包括了3339、402与402个视频。其中每个视频的长度均为10秒,在本实验中将每个视频的画面与声音分割成10个连续且等长的1s片段用于训练模型。在训练阶段(包括图2中的第一阶段与第二阶段),仅使用训练集进行模型的参数训练,用验证集在训练融合模块时监测模型的过拟合程度;在验证阶段,模型在测试集上进行推理。

[0055]

模型评估方法:在ave数据集上进行视听事件定位时,遵循先前算法的评估方式,采用对所有测试视频的所有片段的预测准确率作为指标。由于本实施方式中的模型不再是以端到端的形式构成,因此在第一个阶段通过自监督方式训练特征提取模块时,为了衡量所提取特征的质量,直接将特征在不通过第二阶段视听融合模块的视听融合模块前提下使用分类层直接进行分类预测(即不经过进一步的跨模态信息融合直接用于视听事件定位任务),并用预测的准确率来衡量自监督特征的质量。而第二个阶段的视听融合模块是以第一阶段学习到的自监督特征为输入的,且在训练时直接采用数据集的真实标签进行监督,故在经过融合自监督特征之后得到的分类预测会更加准确,与现有的算法的对比也更加的公平。

[0056]

模型细节:预处理部分,对于每一个10s的视频,按照16的帧率抽取160帧分辨率为256x256的rgb图像;以16khz的采样率抽取10s固定长度的声音信号,并分为10段1s长的片段,对每一个片段都叫短时傅里叶变换并通过梅尔滤波器得到维度为96x64的对数梅尔谱。在特征提取模块中,处理视觉信号的cnn采用的是在imagenet上预训练的resnet-50;处理log-mel谱的cnn采用的是在audioset上预训练的vggish,投影层为3层线性投影层且维度从输入到输出依次为2048、4096与4096。在视听融合模块中,加权矩阵中的θ设置为0.03。

[0057]

模型的训练:在自监督训练特征提取模块的过程中,损失函数l

avbt

的参数λ设置为5e-3,模型使用lars优化器训练100个周期(前10个周期用于学习率热身,后90个周期采用余弦衰减),每个训练批次的样本数量为128,基础学习率为2e-4。在训练视听融合模块时,初试学习率为1e-4且每经过10个周期学习率衰减为0.98倍,训练批次大小为128,使用的是adam优化器。

[0058]

实验结果:在特征提取模块提取的自监督特征部分,将其主要与现有算法中采用的最流行的多模态特征提取方法avel进行对比,不管在输入单模态数据还是多模态数据的

情况下均超越了已有方法,如表1所示。

[0059]

表1本方法中自监督特征的质量与现有方法对比

[0060]

方法准确率(%)avel(仅音频输入)59.5avel(仅画面输入)55.3avel(视听输入)71.3本方法(仅音频输入)63.5本方法(仅画面输入)61.0本方法(视听输入)75.6

[0061]

在信息融合部分,基于本方法中的自监督特征,通过视听融合模块进一步融合跨模态信息之后,将结果与现有算法进行比较,如表2所示,本方法的准确率最高。

[0062]

表2融合自监督特征之后的本方法与现有算法对比

[0063]

模型准确率(%)avsdn72.6dmrn73.1cman73.3dam74.5avrb74.8avin75.2mpn75.2jcan76.2psp76.6avt76.8本方法77.2

[0064]

不难发现,本发明在视觉-听觉特征提取的过程中,实现初步的模态间信息交换并缩小视觉与听觉信息之间的异质性差异;在视听信息融合的过程中,减小针对背景的额外人工监督的依赖,并在特征提取的基础之上,通过聚合携带有相似语义信息的视觉与听觉特征来进一步融合跨模态信息,通过上述技术手段提高了视听事件的识别准确率。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1