一种基于多模态采集的高帧率超分辨率的提升方法与流程

1.本发明涉及人工智能领域,涉及一种基于多模态采集的高帧率超分辨率的提升方法。

背景技术:

2.超分辨率重建是一种利用人工智能技术提升图像的视频质量的重要技术,该技术可以将低分辨率的图像和视频提升到较高的分辨率,此外还可以生成高帧率的视频。例如将2k@30fps的视频提升到4k@60fps的视频,提升了视频图像的分辨率和视频的帧率,画面质量得到明显的提升了。然而,目前的主要问题是:当前流行的大多数超分辨提升技术,大多针对单一的图像进行分辨率的提升,或者只基于单个模态进行超分辨提升,忽视了视频内容的时序性特征,无法有效的利用时空域的信息对分辨率和帧率进行提升。事件相机作为一种基于生物启发设计的传感器,对比帧相机,具有高时间分辨率(100mhz)、宽动态(hdr》80db)等优势,事件相机采集的是异步的独立的像素,当该像素的变化值超过某个阈值时,该像素会被激活,事件相机更适合采集光线复杂的运动场景的数据,此前有多种方法基于事件相机和帧相机超分辨率提升方法被成功应用,然而,他们的方法没有充分发挥事件相机优势。具体地,事件相机的输出数据是一种独立的异步的信号,事件数据包含:(x,y,p,t)四个值,其中(x,y)表示事件像素的坐标值,p表示事件数据的极值,为0和1,t表示事件生成的时间点,由于无法适用当前流行的网络,因此将异步独立的事件数据信号重建为类似图像的方法,许多方法采用将一个固定时间段的事件信息聚合成一个二维的图像矩阵来解决这一问题,然而这种方法无法发挥事件数据的时空优势。解决现存问题及缺陷的难度为:解决现存问题有较大的难度,如果传统相机要实现高帧率高分辨的采集图像信息,会产生大量的数据,同时也会消耗大量的能源,原有的电力供应和数据存储及传输方式已经无法满足,需要定制化的设计相机的电力供应和数据传输存储方式,技术难度高,成本巨大。解决以上问题及缺陷的意义为:通过本发明的方法对两种传感器的有效融合,可以解决高帧率高分辨率的图像采集难点,通过一种低成本低数据量的手段实现了高分辨率高帧率的数据采集需求,对于图像采集和超分辨率具有重要的意义。

技术实现要素:

3.本发明提供了一种基于多模态采集的高帧率超分辨率的提升方法,主要采用两种模态的图像采集设备的数据进行智能融合,将低帧率、低分辨率的视频提升成为高帧率、高分辨率的视频,解决了事件相机的数据重建问题以及两种模态数据特征的融合问题。

4.本发明的技术方案如下:

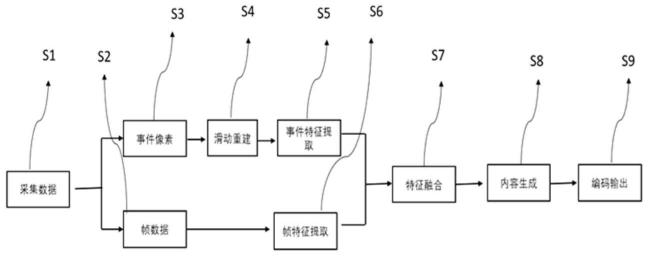

5.本发明的基于多模态采集的高帧率超分辨率的提升方法,包括以下步骤:s1.采集数据:利用事件相机和传统相机在固定位置同时采集相应的数据;s2.获取帧数据:传统相机数据采用帧的形式输入到系统中;s3.获取事件数据:事件数据采用像素点的传输方式,将每个独立的事件像素点输入到系统中;s4.滑动重建:将步骤s3中获取的事件数据重建为

二维的矩阵,使用滑动窗方法实现对事件数据的重建,并将重建后的数据输入到特征提取网络中;s5.事件特征提取:利用特征提取网络中的事件数据的特征提取网络对重建后的事件数据进行特征提取;s6.帧特征提取:利用特征提取网络中的帧数据的特征提取网络对帧数据进行特征提取;s7.特征融合:将步骤s5和步骤s6中分别提取的事件特征和帧特征,利用时间注意力模型进行特征的融合;s8.内容生成:将步骤s7中融合的特征进行视频帧超分重建;s9.编码输出:将步骤s8中生成的视频帧利用avs3编码技术进行视频编码后进行输出;s9.编码输出:将步骤s8中生成的视频帧利用avs3编码技术进行视频编码后进行输出。

6.优选地,在上述基于多模态采集的高帧率超分辨率的提升方法中,在步骤s1中,事件相机和传统相机应固定在同一水平线上,相互间隔不超过20cm,同时启动事件相机和传统相机进行数据采集。

7.优选地,在上述基于多模态采集的高帧率超分辨率的提升方法中,在步骤s4中,利用滑动时间窗将该窗口囊括的所有事件像素进行二维重建,滑动时间窗可以兼顾事件数据的上下关联,事件像素分布在x、y、t组成的三维空间内,滑动窗口t1、t2、t3

……

tn,除了初始t1外,其他的窗口都是包含上一个窗口包含内容的一半信息。

8.优选地,在上述基于多模态采集的高帧率超分辨率的提升方法中,在步骤s5中,特征提取网络分为两个分支:事件数据的特征提取网络和帧数据的特征提取网络,事件数据的特征提取网络由6层卷积网络组成,其输入为重建后的事件数据;帧数据的特征提取网络由9层卷积网络组成,其输入为帧数据,输入重建的事件数据和帧数据应该对应,事件数据的时间的结束时间应对应帧数据的采集时间。

9.优选地,在上述基于多模态采集的高帧率超分辨率的提升方法中,在步骤s7中,将事件特征和帧特征按照权重比例进行融合,将事件特征和帧特征的权重分别设置为3:7,融合后的特征在时间注意力模型网络中进行注意力特征提取,时间注意力模型网络在gru结构中包含着上一时刻帧的信息,通过上一帧的隐藏状态h

t

,与当前帧的状态h

t+1

来计算当前帧的注意力权重,并利用注意力权重优化优化融合后的特征,将优化后的特征输出进行下一个阶段的处理。

10.优选地,在上述基于多模态采集的高帧率超分辨率的提升方法中,在步骤s8中,包括两部分内容:超分重建和插帧重建,基于步骤s7中融合的特征,利用训练好的生成器来进行图像的重建,其中生成器来自于stylegan网络,并生成具有高分辨率的图像帧;在插帧重建部分,利用事件数据的光流特征,对相邻的图像帧进行加帧,通过利用flownet计算两个阶段的重建事件数据的光流特征,根据光流特征计算像素运动的偏移量,并根据像素运动的偏移量结合前后视频帧的来进行插帧,前后帧视频帧是经过超分重建的视频帧。

11.根据本发明的技术方案,产生的有益效果是:

12.本发明的基于多模态采集的高帧率超分辨率的提升方法,采用事件相机和帧相机两种模态的相机采集视频数据,通过滑动窗口的形式重建事件数据,通过特征融合的方法(利用时间注意力网络对两种模态的数据特征进行融合),通过对抗生成网络生成高分辨率及高帧率的视频内容,利用较低的成本可以实现复杂场景下较高的质量的视频内容的采集拍摄。

13.为了更好地理解和说明本发明的构思、工作原理和发明效果,下面结合附图,通过具体实施例,对本发明进行详细说明如下:

附图说明

14.为了更清楚地说明本发明具体实施方式或现有技术中的技术方案,下面将对具体实施方式或现有技术描述中所需要使用的附图作简单地介绍。

15.图1是本发明的基于多模态采集的高帧率超分辨率的提升方法的流程图;

16.图2是本发明涉及的滑动窗口重建事件数据的方式。

具体实施方式

17.为使本发明的目的、技术方法及优点更加清晰,下面结合附图及具体实例,对本发明做进一步的详细说明。这些实例仅仅是说明性的,而并非对本发明的限制。

18.本发明的基于多模态采集的高帧率超分辨率的提升方法的工作原理为:主要利用两种模态数据的特征进行融合,融合后生成具有高分辨率、高帧率的视频数据。主要采用事件数据的重建、两种模态的特征提取、时间注意力的特征融合和超分辨生成这四个主要步骤,通过让对事件相机数据采用滑动窗口重建,充分发挥事件相机在时间分辨率的优势,都装换成光流特征的形式进行融合,融合后的数对原始的帧数据进行超分修复,使得原视频可以从低帧率提升到高帧率的数据。

19.如图1所示,本发明的基于多模态采集的高帧率超分辨率的提升方法,包括以下步骤:

20.s1.采集数据:利用事件相机和传统相机在固定位置同时采集相应的数据。为了保证采集数据差异尽可能的小,事件相机和传统相机应固定在同一水平线上,相互间隔不超过20cm。同时启动事件相机和传统相机进行数据采集。

21.s2.获取帧数据:传统相机数据采用帧的形式输入到系统中。

22.s3.获取事件数据:事件数据采用像素点的传输方式,将每个独立的事件像素点(x,y,p,t)输入到系统中。

23.s4.滑动重建:将步骤s3中获取的事件数据(独立事件像素)重建为二维的矩阵,使用滑动窗方法实现对事件数据的重建,并将重建后的数据输入到特征提取网络中。

24.其中,滑动窗口的事件数据重建为:利用滑动时间窗将该窗口囊括的所有事件像素进行二维重建,滑动时间窗可以兼顾事件数据的上下关联,滑动窗口的事件数据重建如图2所示,事件像素分布在(x,y,t)组成的三维空间内,滑动窗口t1、t2、t3

……

tn,其创新点在于除了初始t1外,其他的窗口都是包含上一个窗口包含内容的一半信息,这样可以有效的关联事件数据在时域上的关联,使得运动信息得到完全的保留,有利后续高帧率的生成。

25.s5.事件特征提取:利用特征提取网络中的事件数据的特征提取网络对重建后的事件数据进行特征提取。

26.本发明采用多模态的特征提取,特征提取网络分为两个分支:事件数据的特征提取网络和帧数据的特征提取网络,两支网络中,事件数据的特征提取网络由6层卷积网络组成,其输入为重建后的事件数据;帧数据的特征提取网络由9层卷积网络组成,其输入为帧数据,此处应注意,输入重建的事件数据和帧数据应该对应,事件数据的时间的结束时间应对应帧数据的采集时间。事件数据的特征提取网络采用n-imagenet数据进行预训练,训练任务是用于目标识别,帧数据的特征提取网络采用imagenet大规模数据集进行预训练,预训练模型后的卷积网络可以有效地提取到事件数据和帧数据的特征。

27.s6.帧特征提取:利用帧数据的特征提取网络对帧数据进行特征提取。

28.s7.特征融合:将步骤s5和步骤s6中分别提取的事件特征和帧特征,利用时间注意力模型进行特征的融合。

29.时间注意力的特征融合:本发明设计一种基于时间注意力的特征融合机制,可以将特征提取网络的两个分支网络提取的特征进行有效地融合,具体地,时间注意力模型是采用gru(一种国际通用的循环神经网络的名称)和注意力网络结构的编码解码结构。首先,将事件特征和帧特征按照权重比例进行融合,根据经验测试,将事件特征和帧特征的权重分别设置为3:7,融合后的特征在时间注意力模型网络中进行注意力特征提取,由于本发明的应用场景是基于时序序列的视频,因此时间注意力模型网络可以有效地利用在时序上的特性,在gru结构中包含着上一时刻帧的信息,通过上一帧的隐藏状态h

t

,与当前帧的状态h

t+1

来计算当前帧的注意力权重,并利用注意力权重优化优化融合后的特征,将优化后的特征输出进行下一个阶段的处理。

30.s8.内容生成:将步骤s7中融合的特征进行视频帧超分重建。

31.该步骤包括:两部分内容,超分重建和插帧重建,相比于以往基于单一特征的视频帧重建,本发明提出基于融合特征的视频帧重建,其技术的关键部分在于将两种模态特征融合后来进行视频帧重建。基于步骤s7中融合的特征,利用训练好的生成器来进行图像的重建,其中生成器来自于stylegan网络,并生成具有高分辨率的图像帧。在插帧重建部分,其技术关键部分在于利用事件数据的光流特征,对相邻的图像帧进行加帧,通过利用flownet计算两个阶段的重建事件数据的光流特征,根据光流特征计算像素运动的偏移量,并根据像素运动的偏移量结合前后视频帧的来进行插帧,前后帧视频帧是经过超分重建的视频帧。

32.s9.编码输出:将步骤s8中生成的视频帧利用avs3编码技术进行视频编码后进行输出。

33.本发明通过利用事件相机和传统相机同时进行数据采集,将采集的数据分别处理,事件数据采用滑动窗口的方法进行重建,充分发挥出事件数据在时空域的优势。然后,利用利用特征提取网络分别对重建后的事件数据和传统相机输出的帧数据进行特征提取,利用时间注意力机制将这两种模态的数据进行融合。融合后特征包含了事件相机的时间域信息和传统相机的空间域信息,利用对抗生成网络进行视频内容的生成,生成具有高帧率和高分辨率的视频数据。本发明通过滑动窗口事件数据重建、多模态特征提取、时间注意力的特征融合和利用生成模糊对融合后的信息进行生成,充分发挥了事件数据高时间分辨率、宽动态的优势,弥补了传统相机在这两个方面的缺点;本发明实现了两种模态的结合,利用两种模态的数据进行充分融合,输出具有高帧率、高分辨率的视频数据,使得该系统在暗光、过度曝光、快速运动等场景可以输出远高于传统相机的帧率和分辨率的视频数据,实现对传统相机的升级以克服各种具有挑战的场景。

34.表1表明本发明提出的方法只需要在较低的数据量和功耗就可以实现高帧率的信息获取,验证了本发明的有效性和先进性。

35.表1

36.相机方案本发明方法传统高速相机方法可实现帧率1000fps240fps

原始数据量3~5mb/s.15~20mb/s.消耗功率450mw~1.5w18w~20w

37.以上说明是依据发明的构思和工作原理的最佳实施例。上述实施例不应理解为对本权利要求保护范围的限制,依照本发明构思的其他实施方式和实现方式的组合均属于本发明的保护范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1