一种面向问句匹配任务的数据增强方法

1.本发明属于自然语言处理技术领域,涉及一种数据增强方法,具体涉及一种面向问句匹配任务的数据增强方法。

背景技术:

2.随着互联网的飞速发展,网民数量不断增加,越来越多的人通过搜索引擎、知乎、小红书等内容服务获取感兴趣的信息。当前基于深度学习的语义匹配模型虽然在标准文本匹配数据集上取得了优秀的成绩,但在真实场景下,无法正确预测一些主观上易于分辨的文本。例如用户搜索“济南大学怎么样”,关联问句中出现了“如何评价暨南大学”,对用户体验及产品形象都造成了损害。

3.这种现象是深度学习模型对数据集的过拟合(overfitting)造成的,具体表现是在训练数据中的拟合效果非常好,但在真实场景中却无法达到预期的效果。数据增强是解决过拟合问题非常有效的手段。其它正则化方法如batch normalization、dropout等直接在网络模型中施加干预,而数据增强更加直观,它是在原始数据集上,对数据应用变换策略,从而提高数据集的多样性。计算机视觉领域通过图片变换、风格转换等数据增强方式取得了非常好的效果,但在自然语言处理领域,数据增强目前仍处于探索阶段。简单数据增强方法(easy data augmentation,eda)通过插入、随机交换等方式实现数据集扩充,但容易带来大量噪声,无法针对性地提高问句匹配效果。hou等采用序列到序列模型多样化对话文本,提高了对话文本语义理解效果。shleifer等、sennrich等采用回译的方式进行数据增强,提高了文本分类与机器翻译模型效果,但数据增强手段较单一。

4.通过对bustm数据集进行分析,将模型的鲁棒性问题归为五个类别,包括词汇理解、句法结构、错别字、口语化文本、对话文本。当前的数据增强方法无法很好地解决上述问题。

技术实现要素:

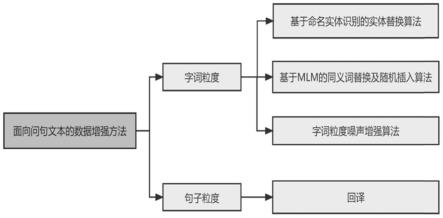

5.为了解决上述技术问题,本发明融合基于命名实体识别的实体替换算法、基于掩码预测语言模型的同义词替换及随机插入算法、字词级别噪声增强算法以及回译方法,提出了一种面向问句匹配任务的数据增强方法、系统及设备。

6.本发明所采用的技术方案是:一种面向问句匹配任务的数据增强方法,采用bert+bilstm-crf的命名实体识别方法对文本词性以及专有名词进行识别及标注处理;采用文本替换与插入方法及字词粒度的噪声增强方法,从字词粒度下对待匹配的两段文本进行数据增强处理;采用回译算法,从句子粒度对待匹配的两段文本进行数据增强处理;

7.所述采用bert+bilstm-crf的命名实体识别方法对文本词性以及专有名词进行识别及标注处理;具体实现包括以下步骤:

8.(1)首先利用bert作为编码器,得到对输入文本的词嵌入表示;

9.(2)使用bilstm计算字符输出为各待选标签的概率,通过crf层得到最终的序列标

注结果。

10.本发明融合基于命名实体识别的实体替换算法、基于掩码预测语言模型的同义词替换及随机插入算法、字词级别噪声增强算法以及回译方法,提出了面向问句匹配任务的数据增强方法。面向问句匹配的数据增强算法能够有效提高模型在问句匹配任务上的鲁棒性以及匹配效果。

附图说明

11.图1为本发明实施例的方法原理框图;

12.图2为本发明实施例的文本命名实体识别模型结构图;

13.图3为本发明实施例的实体替换示例图;

14.图4为本发明实施例的回译算法示例图。

具体实施方式

15.为了便于本领域普通技术人员理解和实施本发明,下面结合附图及实施例对本发明作进一步的详细描述,应当理解,此处所描述的实施示例仅用于说明和解释本发明,并不用于限定本发明。

16.请见图1,本发明提供的一种面向问句匹配任务的数据增强方法,采用bert+bilstm-crf的命名实体识别方法对文本词性以及专有名词进行识别及标注处理;采用文本替换与插入方法及字词粒度的噪声增强方法,从字词粒度下对待匹配的文本进行数据增强处理;采用回译算法,从句子粒度对待匹配的文本进行数据增强处理;

17.本实施例采用bert+bilstm-crf的命名实体识别方法对文本词性以及专有名词进行识别及标注处理;具体实现包括以下步骤:

18.(1)首先利用bert作为编码器,得到对输入文本的词嵌入表示;

19.(2)使用bilstm计算字符输出为各待选标签的概率,通过crf层得到最终的序列标注结果。

20.本实施例中,采用基于掩码预测语言模型bert-mlm的文本替换与插入方法及字词粒度的噪声增强方法,从字词粒度下对待匹配的两段文本进行数据增强处理;

21.基于掩码预测语言模型的文本替换与插入方法,具体实现包括以下步骤:

22.(1)句子预处理;

23.首先对给定文本进行分词处理,得到其分词结果,采用结巴(jieba)中文分词工具实现;并删除其中的停用词,采用哈工大停用词表作为筛选依据。

24.(2)随机插入以及同义词替换;

25.对句子中词语按照语义重要性排序,然后进行遍历,选择重要性大于阈值的词组进行替换,将词语替换为“[mask]”(一个标注),并随机在其左边或右边同样插入“[mask]”,将替换的“[mask]”送入由bert经过掩码预测任务进行微调后得到的bert-mlm中,训练过程中对句子随机遮蔽,采用mask将一些词语进行替换。之后根据上下文信息对“[mask]”位置的词进行预测,从而学习到该单词前后的上下文信息;之后根据上下文信息得到同义词候选集,从同义词中选择前k个再替换,得到新样本的集合,与输入样本形成新的增强数据集;

[0026]

本实施例中语义重要性计算公式为:

[0027][0028]

其中,表示wi在x1中的重要性,表示在x1中去掉wi后的文本,gy(x1,x2)是当输入为(x1,x2)时,掩码预测语言模型的置信度得分,gy′

(x1,x2)表示两种分类结果(特指(x1,x2)与不一致时采用第二种方式进行计算)。

[0029]

本实施例中由bert经过掩码预测任务进行微调后得到的bert-mlm,是根据预测分数emissionscore

ij

进行微调;oi=θ(yiw

p

+d);其中,θ()、w

p

、d为线层的可学习参数,yi为最终的隐藏层输出向量

[0030]

本实施例的字词粒度的噪声增强方法,包括字级别增强和词级别增强;字级别增强,是随机进行噪声增强操作,包括冗余字替换操作、字缺失替换操作、字序错误替换操作和选字错误替换操作,其中,生成文本与原文本编辑距离不超过3;冗余字替换操作,是对文本进行随机的字插入扩充;字缺失替换操作,将该字进行删除,模拟文本缺失错误;字序错误替换操作,是随机选择字,执行顺序调换,模拟字序错误;选字错误替换操作,是进行随机替换,模拟选字错误;词级别增强,包括冗余词替换操作、词缺失替换操作、词序错误替换操作和选词错误替换操作,其中,生成文本与原文本编辑距离不超过3;冗余词替换操作,是对词语进行随机的词插入扩充;词缺失替换操作,是删除该词,模拟文本缺失错误;词序错误替换操作,是将词随机调换位置,模拟词序错误;选词错误替换操作,是利用形近词表、音近词表等进行随机替换,模拟选词错误。此外,考虑到问句文本中可能存在方言口音导致的语法错误,如前后鼻音、卷平舌不分等。因此,将文本识别为拼音格式,随机替换其声母或韵母,模拟方言发音。

[0031]

本实施例中,采用回译算法,从句子粒度对待匹配的两段文本进行数据增强处理;具体实现包括以下步骤:

[0032]

(1)将原始数据通过神经网络模型翻译为其它语言;

[0033]

(2)将译文通过神经网络模型翻译回原始语言得到新的相同语义的文本。

[0034]

请见图2,为本实施例的文本命名实体识别模型结构图,输入文本u={w0,w1,...,wn}首先利用bert作为编码器,得到对wi的词嵌入表示,之后使用bilstm计算字符发射为各待选标签的概率,通过crf层得到最终的序列标注结果。

[0035]

请见图3,为本实施例的实体替换示例图,得到命名实体识别结果后,交换同类型标签问句匹配对的命名实体,扩充原始数据集。

[0036]

请见图4,为本实施例的回译算法示例图,以“今天的天气很好哦”为例,经过翻译模型得到英语、日语、德语三种结果,再将译文进行翻译,得到了正确的语义文本“今天天气很好”,“今天是个好天气”,“今天天气真好啊”。

[0037]

为本实施例的提出了面向问句匹配的数据增强方法,相较于现有方法,本发明从字词、句两种角度实现数据增强,具体而言,为了应对问句文本中常出现的同义词混淆、实体混淆问题,从字词粒度出发,实现了基于命名实体识别的实体替换增强算法与利用预训

练模型强大的语义表达能力实现的基于掩码语言模型的同义词替换及随机插入算法,扩充了样本空间;提出了字词粒度噪声增强算法,通过添加噪声,提高了模型的学习能力;从句子粒度,实现了基于回译方法的数据增强,利用文本生成的思想,提高了样本的多样性。通过在bustm数据集上进行对比实验与消融实验(请给出具体的实验数据集实验结构,对本技术效果进行支撑),,验证了本文提出数据增强方法的有效性与先进性。

[0038]

为本实施例的采用bustm作为训练数据集,数据格式都为(sa,sb,label),其中sa与sb为中文问句label表示sa与sb是否表达了同样的语义。bustm数据集采集于oppo公司旗下的智能语音助手。数据集包含一共167173条匹配语句,正例数据一共115405条,反例数据一共51768条,正负样本比例约2.2∶1,文本的最长包含20个字符,最短只包含一个字符,平均长度为8个字符。

[0039]

为了从词汇理解(lexical semantic)、句法结构(syntactic structure)、错误拼写(misspelling)、口语化文本(speech)、对话文本(dialogue)等多个维度对模型效果进行评测,本文从数据集及互联网中选取了100000条具有代表性的文本组成测试集,通过人工筛选及语义匹配标注,得到如下表所示的测试文本。

[0040]

测试集示例表

[0041][0042]

采用宏平均准确率(macro-accuracy)对文本增强效果进行评价,具体而言,在词汇理解、句法结构、错别字、口语化文本、对话文本等维度下分别计算模型的准确率,并进行平均,计算过程如下所示:

[0043][0044][0045]

其中,i表示第i个维度下的评测结果,n为总的维度数量,tpi表示预测为匹配,标签值也为匹配的数据数量,fpi表示预测为不匹配而标签值实际为匹配的数据数量,tni表示预测为匹配而标签值实际为不匹配的数据数量,fni表示预测为不匹配,标签值也为不匹配的数据数量。

[0046]

设置了多组对照实验,包括原始数据集、eda方法、基于命名实体识别的实体替换方法、基于掩码语言模型的同义词替换及随机插入算法、字词粒度噪声文本增强方法、回译以及结合上述方法的混合方法:

[0047]

原始数据集(original):未进行数据增强操作的原始数据集;

[0048]

eda:采用eda方法实现数据增强,包括同义词替换(sr)、随机插入(ri)、随机交换(rs)、随机删除(rd)四种操作。

[0049]

基于命名实体识别的实体替换方法(ner):基于命名实体识别的实体替换方法对

原始数据集进行数据增强;

[0050]

基于掩码语言模型的同义词替换及随机插入算法(mlm):对原始数据集采用掩码语言模型同义词替换及随机插入算法进行数据增强;

[0051]

字词粒度噪声文本增强方法(noise):对原始数据集采取字词粒度噪声增强;

[0052]

回译(backtrans):对原始数据集采取回译方法实现数据增强。

[0053]

综合ner、mlm、noise、backtrans的混合方法(combine):从字词、句子粒度实现数据集增强。

[0054]

实验结果可以清楚地看出,本实施例提出的数据增强方法显著提升了问句匹配模型的鲁棒性,并且优于现有的数据增强方法eda。

[0055]

应当理解的是,上述针对较佳实施例的描述较为详细,并不能因此而认为是对本发明专利保护范围的限制,本领域的普通技术人员在本发明的启示下,在不脱离本发明权利要求所保护的范围情况下,嗨可以做出替换或变形,均落入本发明的保护范围之内,本发明的请求保护范围应以所附权利要求为准。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1