一种服装风格迁移方法与流程

1.本发明涉及智能技术领域,更具体地说,它涉及一种服装风格迁移方法。

背景技术:

2.近年来,随着计算机视觉在时尚行业的发展,服装图像呈现多样化的风格。个性化是时尚服装设计中的一个重要因素,对服装图像进行风格迁移有利于服装设计的个性化与多样化。服装图像风格迁移也是图像风格迁移的一个重要分支。传统的非参数图像风格迁移是一种分析图像风格的方法,该方法根据风格绘制物理模型或者数学统计模型,对迁移的图像进行纹理合成,使其更好地贴合所构建的模型。此方法需要繁琐的推理公式和复杂的数学模型耗时耗力,导致传统的非参数图像风格迁移研究的应用发展缓慢。hertzmann等提出一种通过推导图像特征映射之间的关系,并将此关系看作风格的纹理特征以实现图像风格迁移的方法。efros等提出使用物理模型绘制和新纹理合成算法相结合以实现图像风格迁移的方法。qian等通过改进ashikhmin算法,把统计特性引入相似性度量中建立了新领域一致性度最方法,实现了图像间风格传输。这类传统的非参数图像风格迁移方法能提取图像的浅层特征而不能提取高层特征,在复杂的服装图像背景和光照条件下处理服装图像的颜色和纹理时,风格迁移后的服装图像效果较为粗糙。

3.深度学习出现后,gatys提出基于cnn的图像风格迁移算法,通过cnn不同层次提取不同特征的属性,实现图像风格和内容的区分。然而该方法生成的图像存在噪声,不清晰、需大量成对的训练图像、需反复迭代、训练速度慢、占用极大的内存等问题,甚至可能导致程序崩溃。zhu等人融合gan和对偶学习的思想提出了循环生成对抗网络,该思想使用2个生成器和2个判别器以完成2种风格域之间的环形转换,通过添加循环一致性损失以保留图像的内容信息。luan等人在cyclegan中加入正则化以防止过拟合来提高图像的生成质量。虽然cyclegan在图像全局风格迁移工作中取得了很好的效果,但在复杂背景服装图像局部风格迁移中存在局部区域难以控制,局部风格迁移后产生边界伪影的问题。

技术实现要素:

4.为了克服现有技术中所存在的上述缺陷,本发明提供了一种服装风格迁移方法,可将用户上传的图片,经过风格迁移,生成新的服装风格,本发明结合了图像分割算法和风格迁移两个领域的研究,自动分割原始输入图像上的服装区域,然后基于分割结果进行相应的全局或局部的风格迁移,服装设计领域、服装个性化定制领域具有促进意义,同时可帮助用户在网上挑选自己喜欢的服装风格。

5.本发明的上述技术目的是通过以下技术方案得以实现的:一种服装风格迁移方法,包括以下步骤:

6.s1、数据收集;

7.s2、数据预处理;

8.s3、图像生成,具体包括以下步骤:

9.a.读取风格迁移模型,根据风格图像和服装图像生成带有风格的服装图像,具体包括以下步骤:

10.1)在计算机上将每张图像表示为3层rgb的矩阵,读取输入的风格图像,利用卷积核对每个像素进行卷积运算,得到图像的特征;

11.2)计算得到各个卷积层的特征,并与服装图像的像素矩阵进行运算还原出对应这种特征的原始图像,即带有风格的服装图像;

12.b.利用实例分割算法mask-rcnn,结合开源的fgvc6数据集,生成带有预训练参数的服装分割模型,定位用户上传的图片中衣服的区域,将图像特征映射转换为向量,并从向量中重建图像。

13.c.将原始图像上的像素替换为新版图像上的像素,得到输出图像。

14.进一步的,步骤s1中的数据收集的具体方法为:使用fgvc6服饰细分数据,获取50000张以上的服装图片和对应的标签。

15.进一步的,步骤s2中的数据预处理的具体方法如下:

16.1)读取所有图像;

17.2)将图像的宽度和长度调整到一致,过滤掉不满足像素要求的图像;

18.3)增加每个图像的采样像素。

19.进一步的,步骤s2中增加图像的采样像素可采用双线性插值法、三次插值法或最近邻插值法。

20.综上所述,本发明具有以下有益效果:可将用户上传的图片,经过风格迁移,生成新的服装风格,本发明结合了图像分割算法和风格迁移两个领域的研究,自动分割原始输入图像上的服装区域,然后基于分割结果进行相应的全局或局部的风格迁移,服装设计领域、服装个性化定制领域具有促进意义,同时可帮助用户在网上挑选自己喜欢的服装风格。

附图说明

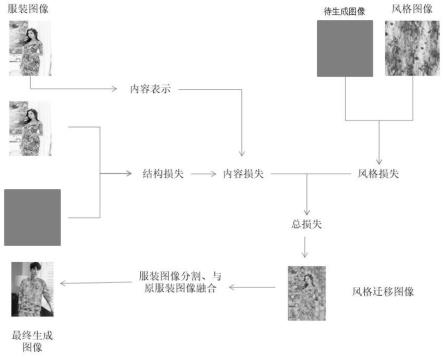

21.图1是本发明实施例中步骤a中生成带有风格的服装图像的流程图;

22.图2是本发明实施例中利用服装分割模型将用户上传的图像分割处的掩膜图;

23.图3是本发明实施例中正在应用的网站的功能演示图。

具体实施方式

24.以下结合附图1-3对本发明作进一步详细说明。

25.实施例:一种服装风格迁移方法,包括以下步骤:

26.s1、数据收集,使用fgvc6服饰细分数据,获取50000张以上的服装图片和对应的标签;

27.s2、数据预处理,具体方法如下:

28.1)读取所有图像;

29.2)将图像的宽度和长度调整到一致,过滤掉不满足像素要求的图像;

30.3)采用双线性插值法、三次插值法或最近邻插值法增加每个图像的采样像素;

31.s3、图像生成,具体包括以下步骤:

32.a.读取风格迁移模型,根据风格图片和内容图片生成带有风格的服装图像,具体

包括以下步骤:

33.1)在计算机上将每张图像表示为3层rgb的矩阵,读取输入的风格图像,利用卷积核对每个像素进行卷积运算,得到图像的特征;

34.2)计算得到各个卷积层的特征,并与服装图像的像素矩阵进行运算还原出对应这种特征的原始图像;

35.如图1所示,为步骤a中生成带有风格的服装图像的流程图,其中,风格迁移本质上是生成一个新的图片,使得风格上趋近于风格图,内容上趋近于内容图。而“趋近”在深度学习中体现在loss函数中,所以需要设定两个loss函数:content loss——度量生成图像的内容和内容图像的内容之间的内容损失;style loss——度量生成图像的风格和风格图像的风格之间的风格损失。不断地更新合成图的信息,得到最终synthetic image。通过最小化损失网络在relu2_2层上的特征重构损失,训练模型可以处理

×

4超分辨率的图像。训练集使用了fgvc6服饰细分数据,共有5k张图像,预处理成为288

×

288大小进行训练,并通过高斯模糊和双线性插值下采样来准备低分辨率输入。我们共进行了200k次迭代的batch_size为4的训练,学习速率为1

×

10-3,没有权值衰减或丢失,以此来得到风格迁移模型。然后在网络输出和低分辨率输入之间执行直方图匹配。使用srcnn作为基线模型,srcnn是一个经过训练的三层卷积网络,可将检测数据集中33

×

33大小图像的每像素损失降至最低。

36.步骤a可用数学符号阐述,如下所示:

37.设用户输入的图像为x

→

,经过图像生成网络生成的图像为y

→

,y

→

在内容上与原始的图像内容yc接近,利用损失网络定义内容损失为:

38.lcontent(y

→

,yc)

39.另一方面,y

→

具有目标风格图像ys的风格,因此定义另一个风格损失:

40.lstyle(y

→

,yc,ys)

41.组合这两个损失得到一个总损失:

42.ltotal(y

→

,yc,ys)

43.总的损失函数包含了风格图像的风格和服装图像的内容,利用总损失在网络中实例化keras函数,梯度更新可生成带有风格的服装图像;

44.b.利用实例分割算法mask-rcnn,结合开源的fgvc6数据集,生成带有预训练参数的服装分割模型,,定位用户上传的图片中衣服的区域,将图像特征映射转换为向量,并从向量中重建图像。

45.此处,可将用户上传的图像分割出mask图,如图2所示,原理为:

46.使用resnet倒数第4层的网络。输入的roi首先获得roi feature,然后将其升维通道,经过两个分支,分支一负责分类和回归,分支二负责生成对应的mask。由于前面进行了多次卷积和池化,减小了对应的分辨率,mask分支开始利用反卷积进行分辨率的提升,同时减少通道的个数,最后输出mask模板。

47.c.将原始图像上的像素替换为新版图像上的像素,得到输出图像。

48.如图3所示,为目前正在应用的网站的功能演示图(https://fzmlsj.nbfzfz.com),首先,用户上传图片,然后选择自己的风格,点击生成按钮,生成迁移后的服装设计图像。

49.本具体实施例仅仅是对本发明的解释,其并不是对本发明的限制,本领域技术人

员在阅读完本说明书后可以根据需要对本实施例做出没有创造性贡献的修改,但只要在本发明的权利要求范围内都受到专利法的保护。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1