一种面向CT影像的肿瘤分割方法及其系统

一种面向ct影像的肿瘤分割方法及其系统

技术领域

1.本发明涉及计算机视觉处理技术领域,尤其是涉及一种面向ct影像的肿瘤分割方法及其系统。

背景技术:

2.图像分割技术是当前人工智能领域,特别是计算机视觉中的重要研究方向,也是帮助机器进行语义理解的重要组成部分,在计算机辅助诊疗中,面向医疗影像的分割任务是辅助医生进行病灶定位、度量等的重要环节。

3.计算机辅助诊疗是指通过影像学分析、生理、生化手段等结合计算机图像处理、机器学习建模等方法对医疗数据进行分析和计算,辅助发现病灶或确定病灶性质提高诊断准确率。其中,准确分割器官或病灶部位可以为后续诊断提供重要参考。现有基于深度学习的医疗影像分割方法大多使用全监督进行模型训练,即需要人工逐像素标注所有病灶部分的分割标签,然而,在实际情况下,这种标注方法费时费力,且难以获得大量准确标注的样本。

4.自2015年之后,基于深度学习的方法成为计算机处理医疗影像分割的主要方法。jonathan等提出了使用全卷积代替全连接的fcn;olaf等提出了基于skipconnection的u-net;fausto等提出了针对3d医疗数据的分割模型v-net;zhou 等针对u-net的局限性设计了更加完善的u型网络结构u-net++。面向ct影像的肺部肿瘤分割问题同样具有较高的研究价值和实际意义,reza等在u-net基础上增加了lstm结构提出了bcdu-net,li等提出了一个联合学习切片内特征和切片之间的特征的模型h-denseunet。然而,和所有医疗影像分割任务一样,现有基于深度学习的方法大多采用全监督的训练方式,即需要人工逐像素标注出目标病灶的分割信息,将耗费大量人力成本,且效率低、无法保证标注的准确性。

5.因此,不仅是在面向ct图像的肺部肿瘤分割任务,包括其他的医疗影像分割任务中,如何有效减少在深度学习模型训练中由于需要逐像素标注而造成的大量人力物力浪费的问题是非常有实际应用价值的。此外,在通用视觉分割任务中,使用的自然图像通常包含丰富的语义信息,即每个需要分割的实例对象都有较为明显且丰富的特征,标注难度较低,不需要很高的领域知识门槛。然而,在医学影像中,需要分割的病灶部分往往没有像自然图像一样具有丰富准确的语义信息因此,如何充分使用医学图像特征也是医学多模态任务的关键之一。

6.综上所述,如何通过自动生成标签的方式减少大量人力标注,以及如何从有限的医疗语义信息中训练出分割精度更准确的模型是当前计算机辅助医疗分割的重要难题,具有较高的研究意义和实际临床应用价值。

技术实现要素:

7.本发明的目的就是为了克服上述现有技术存在的缺陷而提供一种面向ct影像的肿瘤分割方法及其系统,能够高效准确生成标签后进行模型训练,从而解决全监督标注所产生的费时费力问题,提高分割任务的效率及准确性。

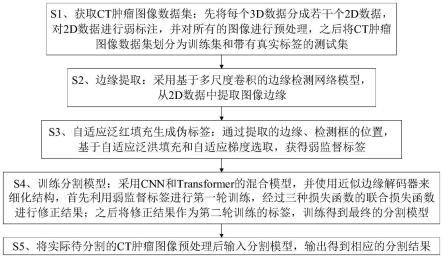

8.本发明的目的可以通过以下技术方案来实现:一种面向ct影像的肿瘤分割方法,包括以下步骤:

9.s1、获取ct肿瘤图像数据集:先将每个3d数据分成若干个2d数据,对2d 数据进行弱标注,并对所有的图像进行预处理,之后将ct肿瘤图像数据集划分为训练集和带有真实标签的测试集;

10.s2、边缘提取:采用基于多尺度卷积的边缘检测网络模型,从2d数据中提取图像边缘;

11.s3、自适应泛红填充生成伪标签:通过提取的边缘、检测框的位置,基于自适应泛洪填充和自适应梯度选取,获得弱监督标签;

12.s4、训练分割模型:采用cnn和transformer的混合模型,并使用近似边缘解码器来细化结构,首先利用弱监督标签进行第一轮训练,经过三种损失函数的联合损失函数进行修正结果;之后将修正结果作为第二轮训练的标签,训练得到最终的分割模型;

13.s5、将实际待分割的ct肿瘤图像预处理后输入分割模型,输出得到相应的分割结果。

14.进一步地,所述步骤s1中对2d数据进行弱标注的具体过程为:在2d数据上针对病灶区域,使用标注软件在数据上点两个点,用于分别指明此区域存在以及不存在肿瘤,以获得相应的json文件。

15.进一步地,所述预处理的具体过程为:将图像调整成统一的352

×

352尺寸,并作标准化处理。

16.进一步地,所述步骤s2具体是将预处理后的2d数据输入多尺度边缘检测网络模型,输出得到边缘特征图。

17.进一步地,所述步骤s3的具体过程为:

18.将边缘特征图、json文件作为输入,采用自适应泛洪填充来获得伪标签,其中,泛洪半径设置为:

[0019][0020]

式中,i为输入图像,r(i)为输入图像i对应的掩码半径,hi和wi分别为输入图像的长度和宽度,γ为设定的超参数;

[0021]

此外,标注的ground truth为:

[0022][0023]

式中,sb和分别为背景像素和第i个标记的肿瘤对象的位置坐标;

[0024]

用于泛洪填充的圆掩模的集合定义为:

[0025][0026]

式中,c为使用下角标变量作为中心、使用上角标变量作为半径的圆;

[0027]

之后结合边缘特征图,将图像分成多个连通的区域:

[0028]

[0029]

式中,f(i)为泛洪填充后获得的连通区域,e(i)为边缘特征图,e(

·

)表示边缘检测器,i为输入图像。

[0030]

进一步地,所述步骤s4中cnn和transformer的混合模型包括embedding部分、encoder部分和decoder部分,其中,embedding部分使用resnet来抽取3个stage的特征图,再基于transformer进行patch_embedding;

[0031]

encoder部分包括12个attentionencodeblock,每个block都依照visiontransformer的设定,即attention模块和mlp模块;

[0032]

decoder部分由两个组件组成,一个visiontransformer(vit)解码器和一个近似边缘检测器。

[0033]

进一步地,所述vit解码器包括四个级联卷积层,每层都有批处理归一化(bn)层、relu激活层和上采样层,以编码器部分的特征输出作为输入,并将各层解码器的相应特征表示为d={di|i=1,2,3,4}。

[0034]

进一步地,所述近似边缘检测器的输出为:

[0035]

fe=σ(cat(r3,d2))

[0036]

其中,σ代表一个3

×

3的卷积层,该卷积层包括bn和relu层。

[0037]

进一步地,所述步骤s4中训练过程具体为:

[0038]

第一轮训练使用弱监督标签进行训练,训练的输入为:2d预处理之后的ct切片图像、预处理之后的边缘图像以及ct图像长宽对齐的弱标签图;

[0039]

模型训练采用sgd优化器,学习率根据训练epoch进行自适应衰减,每10个epoch进行一次衰减,衰减比率为0.1,并采用二元交叉熵损失、局部交叉熵损失和门控crf损失,对于边缘解码器分支,使用二元交叉熵损失来约束e:

[0040][0041]

其中,y为真实标签,e表示边缘图,r和c表示图像的行坐标和列坐标,而解码器分支则使用局部交叉熵损失和门控crf损失,局部交叉熵损失设计的目的是让模型只关注确定区域而忽略不确定区域:

[0042][0043]

其中,j表示标记区域,g表示groundtruth,s表示预测的肿瘤图;

[0044]

门控crf损失为:

[0045][0046]

其中,ki为像素i周围的k

×

k范围所覆盖的区域,d(i,j)定义为:

[0047]

d(i,j)=|s

i-sj|

[0048]

其中,si和sj为位置i和j处s的置信度值,|

·

|表示l1距离,f(i,j)为高斯核带宽滤波器:

[0049][0050]

其中,为归一化的权值,i(

·

)和pt(

·

)为像素的灰度值和像素的位置,σ

pt

和σi为控制高斯核尺度的超参数,由此定义总损失函数为:

[0051]

l

final

=α1l

bce

+α2l

pbce

+α3l

gcrf

[0052]

其中,α1,α2,α3分别为二元交叉熵损失、局部交叉熵损失和门控crf损失对应的权重;

[0053]

第二轮训练使用第一轮训练生成的新的修正标签作为ground truth来监督模型,对其分割能力进行进一步优化,这种自监督的训练方式可以有效地增强模型对医疗影像语义的理解,提升肿瘤的分割精度,将第二轮训练后得到的模型作为最终的分割模型。

[0054]

一种面向ct影像的肿瘤分割系统,包括医学图像预处理模块、边缘检测模块、弱标签生成模块和cnn-vit混合分割模块,所述图像预处理模块用于对ct影像图像进行预处理,以及将医学图像数据集划分为测试集和训练集,将3d格式的数据转化为2d数据;

[0055]

所述边缘检测模块基于rcf网络模型,通过多尺度卷积,并结合设定的阈值参数来获取图像的边缘信息;

[0056]

所述弱标签生成模块采用点标注作为监督信号输入,在边缘图像上通过自适应泛洪填充算法得到弱标签;

[0057]

所述cnn-vit混合分割模块采用混合embedding模式,并将边缘加入解码器,设置三种损失函数组合进行第一轮训练,再使用第一轮生成的标签作为新的监督训练第二轮得到最终的分割模型。

[0058]

与现有技术相比,本发明提出一种面向ct影像的弱监督深度学习肿瘤分割方案,通过简单的弱标注与边缘检测算法自动生成标签,并且通过影像样本和生成的标签训练分割模型,以对ct影像中的肺部肿瘤进行分割,无需人工对ct影像中的肿瘤目标进行逐像素的精细勾画,即可省时省力自动生成粗标注以辅助分割模型进行训练,解决了现有方法需要全监督标注带来的费时费力问题,能够高效准确地自动生成标签,进而确保后续分割模型训练的速度及准确度,提升分割任务的效率及准确性。

[0059]

本发明考虑到医学实际问题和肿瘤ct图像的特点,并没有使用完整的勾画标注作为模型训练的监督信息,取而代之使用的是对于医生标注起来更加简易的点标注方式,通过获取一定程度的边缘信息,采用自适应泛洪填充来获取伪标签,从而完成弱监督标签的生成,不仅限于ct肿瘤影像,这种弱监督的思路能够广泛应用到各种医学场景任务中。

[0060]

本发明在训练分割模型时,采用两轮训练方式,使用第一轮生成的标签作为新的监督训练第二轮得到最终的分割模型,并且在第一轮训练时,提出了一种针对于医学ct肿瘤分割任务的联合损失函数——包括二元交叉熵损失、局部交叉熵损失和门控crf损失,使肿瘤部位和正常的部位更加容易被区分,即肿瘤和正常组织之间的差异被局部交叉熵损失拉开更远的距离,而门控条件随机场也能够让相对粗糙的弱标签训练出更好的结果,进而有效提高ct肿瘤分割任务的性能。

附图说明

[0061]

图1为本发明的方法流程示意图;

[0062]

图2为实施例中用于ct肿瘤影像分割任务的弱监督学习方法的流程图;

[0063]

图3是实施例中使用到的图像组-标签构成图;

[0064]

图4是实施例中编码块的结构图;

[0065]

图5是实施例中加入近似边缘解码器的结构图。

具体实施方式

[0066]

下面结合附图和具体实施例对本发明进行详细说明。

[0067]

实施例

[0068]

如图1所示,一种面向ct影像的肿瘤分割方法,包括以下步骤:

[0069]

s1、获取ct肿瘤图像数据集:先将每个3d数据分成若干个2d数据,对2d 数据进行弱标注,并对所有的图像进行预处理,之后将ct肿瘤图像数据集划分为训练集和带有真实标签的测试集;

[0070]

s2、边缘提取:采用基于多尺度卷积的边缘检测网络模型,从2d数据中提取图像边缘;

[0071]

s3、自适应泛红填充生成伪标签:通过提取的边缘、检测框的位置,基于自适应泛洪填充和自适应梯度选取,获得弱监督标签;

[0072]

s4、训练分割模型:采用cnn和transformer的混合模型,并使用近似边缘解码器来细化结构,首先利用弱监督标签进行第一轮训练,经过三种损失函数的联合损失函数进行修正结果;之后将修正结果作为第二轮训练的标签,训练得到最终的分割模型;

[0073]

s5、将实际待分割的ct肿瘤图像预处理后输入分割模型,输出得到相应的分割结果。

[0074]

本实施例应用上述技术方案,在构建分割模型时,如图1所示,主要包括以下内容:

[0075]

(1)获取带有类别标签的ct肿瘤图像数据集,先将其中每个3d数据分成若干个2d数据,对2d数据进行弱标注,并将所有的图像进行预处理,其中带有类别标签的用意是使用在测试部分,以对后续训练后的模型进行评估。

[0076]

弱标注包括:在2d数据上对于病灶区域,使用labelme等简易标注软件在数据上点两个点来分别指明此区域存在以及不存在肿瘤,从而获得相应的json文件。

[0077]

本实施例中,使用luna16数据集中584个ct肿瘤图像,同样真实标签用于测试。主要的图像格式为mhd和raw格式。然后将图像转化为2d数据并进行标准化处理,将图像裁剪为352

×

352大小,转换为特征向量供模型使用。

[0078]

(2)使用一个基于多尺度卷积的边缘检测网络模型,用于提取融合多尺度信息的边缘图像。

[0079]

本实施例中,边缘检测模型采用的是rcf网络,该网络是基于vgg16构造了一个多尺度网络。将卷积分为5个stage,相邻两个stage和一般的神经网络模型类似地通过池化层来实现降采样的功能,以达到将不同尺度特征融合的效果。同时每个卷积层使用一个卷积核大小为1

×

1并且通道深度是21的卷积操作,然后将每个部分的输出进行元素相加操作来得到一个复合特征。接下来后面再加一个用于放大特征图尺寸的上采样层。在每个上采样

层后面使用一个交叉熵损失与sigmoid 层,然后所有的上采样层的输出进行concatenated形式的叠加,随后使用一个1

×

1 的卷积对各个上采样层的输出进行融合,最后使用一个与上述相同的层得到输出。

[0080]

具体过程为:获取rcf网络的公开模型,使用性能最好的checkpoint进行推理,数据格式为pth,采用多尺度推理模式,经过多次测试,[1.5,2,2.5]是一组较好的参数阈值,能达到较好的边缘提取效果、同时对机器没有过高的要求,在每个尺度进行推理之后将其叠加在一起,即得到最终的边缘图。

[0081]

(3)通过提取的多尺度边缘、检测框的位置,基于自适应泛洪填充和自适应梯度选取,获得弱监督标签。

[0082]

在步骤(1)中已经得到了每个图像的带有点标注信息的json文件,然后将边缘图像、json文件信息作为输入,采用自适应泛洪填充来获得伪标签,泛洪半径设置如下:

[0083][0084]

其中i为输入图像,r(i)为输入图像i对应的掩码半径。hi和wi分别表示输入图像的长度和宽度,γ表示超参数,可以在不同的任务中自行设置。

[0085]

本方法标注的ground truth表示为:

[0086][0087]

其中,sb和分别为背景像素和第i个标记的肿瘤对象的位置坐标。那么用于泛洪填充的圆掩模的集合可以定义为:

[0088][0089]

其中,c表示使用下角标变量作为中心、使用上角标变量作为半径的圆。对于步骤(2)中使用边缘检测器来检测图像的边缘表示为:e(i),其中,e(

·

)表示边缘检测器,i表示输入图像,e表示生成的边缘。通过上述定义的变量,将图像分成多个连通的区域:

[0090][0091]

其中f(i)表示泛洪填充后获得的连通区域,因此对于json文件中标注为前景标签的点,本实施例中,采用γ=20,即图像长宽较小者长度的1/20作为泛洪填充的半径,对于背景的点,本实施例采用γ=8,即图像长宽较小者的1/8作为泛洪填充的半径。

[0092]

具体过程为:读取边缘图像和带有点标注的json文件,其中使用labelme进行标注的点是以字典的形式存放相应的信息,其中的“shape”字段代表的就是点的信息,这个字段中的数据是一个列表,列表中的每一个元素代表一个点。然后根据上述公式设置泛洪的半径,以及rgb三个通道上阻止泛洪的像素值域,由于图像原本是灰度图,所以这三个通道设置相同的值即可,本实施例中采用的泛洪截断像素值为(10,10,10),而每个数据中也包含一个“label”字段,在本实施例中分为两类,一类是肿瘤部位,例如将字段定为“foreground”,反之正常部位则为“background”,分别进行两次泛洪填充得到两种图像,一种是伪标签图,即只包含病灶区域的mask图,还有一种是同时包含病灶点区域和正常点区域的mask的图像,它的作用是进行局部交叉熵的损失计算。

[0093]

(4)训练分割模型,采用cnn和transformer的混合模型,并且根据不同的预设参数,调节使用不同的embedding模型。

[0094]

在embedding部分,使用resnetv2来抽取3个stage的特征图(分别为stage 2,stage 3,stage 5),再基于vit进行patch embedding。

[0095]

接下来在encoder部分设计了12个attention encode block,每个block都依照 vit的设定,即attention模块和mlp模块。

[0096]

decoder部分由两个组件组成,一个vit解码器和一个近似边缘检测器,vit 解码器是四个级联卷积层,每层都有批处理归一化层、relu激活层和上采样层,以编码器部分的特征输出作为输入,并将各层解码器的相应特征表示为d= {di|i=1,2,3,4};此外,由于弱监督标注缺乏结构和细节,本技术方案设计了一个近似边缘解码器作为一个近似的边缘检测器来生成结构以克服这一缺点,具体来说,近似边缘检测器的输出可以表示为fe=σ(cat(r3,d2)),其中σ代表一个3

×

3的卷积层,该卷积层包括归一化和relu层,边缘特征图e可以通过在fe之后添加一个 3

×

3卷积层得到,接着通过将fe与d3、cat(fe,d3)合并,并通过两个卷积层,得到多通道特征fs。类似于e,最后的单一通道特征图s也可以用同样的方法得到。

[0097]

具体实施操作是操作为:首先根据需要设置bool变量来判断是否使用混合模型,若使用则代表需要在transformer中需要训练边缘重构能力。那么在patchembedding之前使用resnetv2预训练模型抽取特征,所抽取的特征是resnetv2 的stage 2、3、5这三个特征,作为解码器的输入之一。该部分的配置和resnetv2 的配置保持一致。在进行vit的部分中,patch大小采用的是16,embedding的维度采用的大小是768。encoder中也基本与常规的vit保持一致,本实施例使用12 个block组成encoder,同样与常规的vit配置保持一致。

[0098]

(5)利用步骤(3)中的弱监督方式得到的标签,进行步骤(4)中的模型第一轮训练,训练的输入为:2d预处理之后的ct切片图像、预处理之后的边缘图像以及和ct图像长宽对齐的弱标签图。本技术方案中,采用二元交叉熵损失、局部交叉熵损失和门控crf损失构造联合损失函数。对于边缘解码器分支,使用二值交叉熵损失来约束e:

[0099][0100]

其中y为真实标签,e表示边缘图,r和c表示图像的行坐标和列坐标。而解码器分支则使用了局部交叉熵损失和门控crf损失。部分二元交叉熵损失设计的目的是让模型只关注确定区域而忽略不确定区域:

[0101][0102]

其中j表示标记区域,g表示ground truth,s表示预测的肿瘤图。为了尽可能学习更好的对象结构,在损失函数中还使用门控crf:

[0103][0104]

其中ki为像素i周围的k

×

k范围所覆盖的区域,d(i,j)定义为:

[0105]

d(i,j)=|s

i-sj|

[0106]

其中si和sj为位置i和j处s的置信度值,|

·

|表示l1距离。f(i,j)为高斯核带宽滤波器:

[0107][0108]

其中为归一化的权值,i(

·

)和pt(

·

)为像素的灰度值和像素的位置,σ

pt

和σi为控制高斯核尺度的超参数。所以总损失函数定义为:

[0109]

l

final

=α1l

bce

+α2l

pbce

+α3l

gcrf

[0110]

其中,α1,α2,α3是三个损失函数对应的权重。本实施例中,均设置为1。

[0111]

具体实施如下:将原图、只包含肿瘤部位弱标签、包含肿瘤和正常部位的弱标签、边缘图作为输入,并将其均转成352

×

352的大小的tensor形式变量。初始化网络之后,第一轮训练的参数配置分别是:batch size为32,优化器使用sgd优化器,初始学习率为0.01,动量为0.9,初始衰减率为0.1,每10个epoch进行一次衰减更改,设置衰减最低下降到5

×

10-4

,训练长度为100个epoch。

[0112]

图2是本实施例中数据中的图像组-标签对构成示意图。其中,原图是基于 luna16数据集的mhd格式数据,可视化结果如图,所示的第二张是预处理的示意图,将肺部的主要部分切分出来而舍弃其他冗余的部分。所示的第三张图是边缘图的示意图,通过边缘检测网络得到的边缘图大致如此,该边缘图既用于自适应泛洪填充,又用于监督近似边缘解码器的重结果的过程。最后一张图就是本实施例的点监督标注的示意图,对于标记为病灶或者肿瘤的部位点为第一种颜色点,另外将正常的非病灶区域位置随机的点,在图上表示为第二种颜色点。

[0113]

图3是本实施例中transformer编码块的结构图。将通过embedding之后的特征表示f0,输入到混合模型的transformer的中,如图3所示。其中为了抑制下游任务的过拟合,在多头注意力层和前馈神经网络层前新增了归一化操作。多头注意力层是为了识别不同的模式,设计的多个注意力来学习不同的投影方法。前馈神经网络层(feed forward network),简称ffn,ffn的结构如下:

[0114]

ffn(hi)=gelu(hiw1+b1)w2+b2[0115]

其中,hi是隐藏层的向量。w1,b1,w2,b2是ffn的参数,gelu为激活函数。如图3所示,在整个模型中该模块被堆叠了12次,embedding之后的f0作为编码器的第一次输入,输出为f1,以此类推,最终构成该模型的编码器。

[0116]

图4是本发明的实施例中加入近似边缘解码器的结构图。近似边缘检测器的输出可以表示为fe=σ(cat(r3,d2)),其中σ代表一个3

×

3的卷积层,该卷积层包括 bn和relu层,将之前得到的边缘图作为监督。最后的边缘特征图e可以通过在 fe之后添加一个3

×

3卷积层得到,接着通过将fe与d3以cat(fe,d3)的形式合并,并通过两个卷积层,得到多通道特征fs。类似于e,最后添加对应的卷积层来得到单一通道特征图s。

[0117]

可以看出,本技术方案充分考虑医学实际问题和肿瘤ct图像的特点,并没有使用完整的勾画标注作为模型训练的监督信息,取而代之使用的是对于医生标注起来更加简易的点标注,随即而来的就是损失一些精细的结构信息。然而本技术方案在加入近似边缘解

码器之后,就能够逐步将病灶位置的相关结构细化,此外本技术方案还提出了一种针对于医学肿瘤分割任务的联合损失函数,使肿瘤部位和正常的部位可以更加容易被区分,即肿瘤和正常组织之间的差异被局部交叉熵损失拉开更远的距离,而门控条件随机场也可以让相对粗糙的弱标签训练的更好,进而为ct 肿瘤分割任务带来一定程度的性能提升。

[0118]

本实施例还提供了一种面向ct影像的肿瘤分割系统,包括:

[0119]

医学图像预处理模块,利用上述步骤(1)中的方法进行医学图像预处理;

[0120]

边缘检测模块,利用上述步骤(2)中的方法进行边缘检测,得到的结果将用于自适应泛洪填充和监督近似边缘解码器。

[0121]

弱标签生成模块,利用上述步骤(3)中的方法,只需要点标注作为监督信号输入,在边缘图像上通过自适应泛洪填充算法即可得到弱标签,该弱标签作用于模型第一次训练。

[0122]

cnn-vit混合分割模块,利用上述步骤(4)~(5)中的方法,分割网络模型采用混合embedding模式,并将边缘加入解码器,设置三种损失函数组合进行训练。再使用第一轮生成的标签作为新的监督训练第二轮得到最终的分割模型。

[0123]

综上可知,本技术方案为实现高效准确的分割任务,首先获取ct肿瘤图像数据集,先将其每个3d数据分成若干个2d数据,对此数据进行弱标注,并将所有的图像进行预处理,同时将ct影像数据集划分为测试集和训练集;之后预训练一个基于多尺度卷积的边缘检测网络模型,用于提取多尺度边缘,获得相应的医学语义级的边缘;再通过提取的多尺度边缘、检测框的位置,基于自适应泛洪填充和自适应梯度选取,获得弱监督标签;最后训练分割模型,采用cnn和transformer 的混合模型,并且根据不同的数据,调节使用不同的模型;一方面将弱监督标签进行第一轮训练经过条件随机场等联合损失函数修正结果;另一方面使用修正结果作为第二轮训练的标签训练得到最终的分割模型。

[0124]

由此,本技术方案适用于在计算机辅助诊疗场景下,自动生成可训练的伪标签并建立面向ct影像的肿瘤分割模型,能够很好地用于临床肿瘤分割任务。本技术方案无需人工对ct影像中的肿瘤目标进行逐像素的精细勾画,而使用省时省力的自动生成的粗标注帮助分割模型进行训练。同时本技术方案具有较高的适应性,对于现阶段流行的卷积神经网络模型和transformer模型均可实现快速部署。本技术方案不仅能够减少大量人力标注,同时也能从有限的医疗语义信息中训练出分割精度更准确的模型,从而确保分割任务的效率和准确性。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1