一种基于文本感知损失的注意力文本超分辨率方法与流程

1.本发明涉及图像处理技术领域,具体涉及一种基于文本感知损失的注意力文本超分辨率方法。

背景技术:

2.场景文本超分辨率是以给定的低分辨率图片作为输入,通过深度神经网络得到更高分辨率的场景文本图片。该任务与一般的图片超分辨率任务相比,主要用于配合场景文本识别和场景文本检测算法以提升这两种方法的性能。因此,场景文本超分辨率技术已发展成为光学字符识别(ocr)任务的关键组成部分。

3.超分辨率目的在于输出与给定低分辨率图像一致的合理高分辨率图像,传统方法,如双线性、双三次,利用了相邻像素通常呈现相似颜色的想法,并根据预定义公式通过在相邻像素的颜色之间插值来生成输出。而在深度学习时代,超分辨率被视为回归问题,其中输入是低分辨率图像,目标输出是高分辨率图像,在输入和目标输出对上训练深度神经网络,以最小化预测和gt之间的距离度量。这些工作主要是在合成数据集上进行的,即其中的低分辨率图像通常由下采样插值或高斯模糊滤波器生成,而在最近的针对场景文本超分辨率的工作中提出了一个新的数据集textzoom,它填补了真实场景下文本超分辨率数据集的不足,此后,针对场景文本超分辨率的工作也逐渐多了起来。

4.最早针对真实场景下场景文本超分辨率的工作发表于2020年的eccv《scene text image super-resolution in the wild》,该方法采用textzoom进行训练和测试,并引入了tps-align模块用于解决低分辨率图片和高分辨率图片之间的像素不对齐问题,同时沿用了srresnet的基础结构,使用了5个顺序的基本块作为网络的基础结构,并在基本块中加入了两个正交方向的gru用于建模两个正交方向的上下文特征。由于该模型是第一个针对场景文本任务的模型,因此其性能在当时也是取得了最优的,并且该网络也成为了场景文本超分辨率任务中一个经典的基础结构,在其之后的相关工作都是在该结构的基础上进行的相关改进,以获得更优秀性能的模型。

技术实现要素:

5.本发明的目的是提供一种基于文本感知损失的注意力文本超分辨率方法,以获得更有性能的超分辨率图像。

6.为达到上述目的,本发明采用的技术方案是:

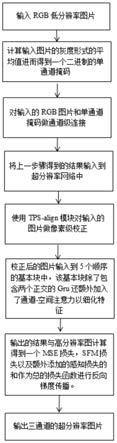

7.一种基于文本感知损失的注意力文本超分辨率方法,包括:

8.s1:输入三通道rgb文本图片,并计算该文本图片的灰度形式的平均值,

9.s2:获取该文本图片的二进制单通道分割掩码,并将该二进制单通道掩码与三通道rgb文本图片进行通道连接,并将结果输入至文本超分辨网络中,

10.s3:对输入的图片做像素级校正,

11.s4:校正后的图片输入到基本块中,该基本块包含两个正交方向的gru模型、通道

注意力、空间注意力用于细化特征,

12.s5:将基本块输出的超分辨率图片和其对应的高分辨率图计算获得mse损失函数、sfm损失函数作为总的损失函数进行反向梯度传播,并最终输出三通道的超分辨率图片。

13.上述技术方案优选地,在s2中,创建一个单通道张量,根据s1中的平均值对该单通道张量赋值,大于该平均值的灰度值设置为255,小于该平均值的灰度值设置为0,获取该文本图片的二进制单通道分割掩码。

14.上述技术方案优选地,在s2中,通过基于阈值的语义分割方法获取二进制单通道分割掩码。

15.上述技术方案优选地,在s2中,通过计算平均值的方法将文本图片划分成文字、背景两个部分,将二进制单通道掩码与文本图片进行通道连接。

16.上述技术方案优选地,使用tps-align模块对输入的图片做像素级校正。

17.上述技术方案优选地,在s4中,在基本块中,先通过两个正交方向的gru模型产生上下文信息感知的特征,再通过通道注意力、空间注意力细化特征关注超分辨率所需要的高频信息。

18.进一步优选地,上下文信息感知的特征为:

[0019][0020][0021]

其中:ht表示gru中的隐藏层,t1,t2分别表示水平方向和垂直方向的循环连接,x

t

表示输入特征,φ表示gru定义的矩阵运算。

[0022]

进一步优选地,通道注意力、空间注意力的方法为:

[0023][0024][0025]

其中:f表示输入特征,mc表示通道注意力,σ表示sigmoid函数,mlp表示多层感知机制,avgpool表示平均池化,maxpool表示最大池化,ms表示空间注意力,f表示卷积运算。

[0026]

进一步优选地,在s5中,使用预训练好的场景文字识别模型crnn作为判别器,超分辨率图片和高分辨率图片分别作为该判别器的输入以得到二者对应的语义特征,两个特征之间的差值通过l1损失函数计算获得所求的感知损失函数。

[0027]

进一步优选地,在s5中,使用由成对低分辨率-高分辨率图片对组成的数据集textzoom做训练和测试数据集。

[0028]

由于上述技术方案运用,本发明与现有技术相比具有下列优点:

[0029]

本发明通过生成分割掩码从而将语义分割信息引入到场景文字超分辨率模型中,并考虑到了利用注意力机制细化双向gru输出的上下文特征以使模型更加关注该任务所需要的高频信息,结合预训练好的识别模型来计算感知损失函数以将识别模型的语义信息引入到场景文字超分辨率模型中,取得了相比此前模型更优秀的性能。

附图说明

[0030]

附图1为本发明方法的流程示意图;

[0031]

附图2a、2b为本发明方法的分割效果对比图;

[0032]

附图3为本发明方法基本块的框架示意图;

[0033]

附图4为本发明方法的通道注意力结构;

[0034]

附图5为本发明方法的空间注意力结构。

具体实施方式

[0035]

下面将结合附图对本发明的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0036]

如图1、2所示的一种基于文本感知损失的注意力文本超分辨率方法,其考虑到了利用语义分割信息,注意力机制以及感知损失来优化场景文字超分辨率模型。具体包括以下步骤:

[0037]

输入三通道rgb文本图片,并计算该文本图片的灰度形式的平均值,创建一个单通道张量,根据s1中的平均值对该单通道张量赋值,针对rgb文本图片的灰度形式,大于该平均值的灰度值设置为255,小于该平均值的灰度值设置为0,这样做的目的是为了获得一个单通道的文本图片“非0即1”二进制分割掩码,并将该二进制单通道掩码与三通道rgb文本图片进行通道连接以利用原图片的语义分割信息。

[0038]

引入语义分割信息能够使模型对于文本图片中的文字部分和背景部分有一个大体的把控,使用基于深度学习的语义分割方法虽然能够得到文本图片对应的二进制掩码,然而由于跨域问题,这样的掩码分割效果并不好,很难对超分辨率任务产生正向的作用,而基于阈值的分割方法虽然方法简单,但针对切割好的文本图片却能够起到非常好的分割效果,本实施例使用阈值方法得到二进制分割掩码。

[0039]

如图2a、2b所示,第一行对应的是阈值方法分割低分辨率图片的输出;第二行对应的是目前的sota文本分割方法texrnet(发表于cvpr2021《rethinking text segmentation:a novel dataset and atext-specific refinement approach》)针对低分辨率图片的输出;第三行对应的是传统阈值方法分割高分辨率图片的输出;最后一行对应的是texrnet针对高分辨率图片的输出。

[0040]

将上一步骤得到的四通道图片输入到文本超分辨率网络中,由于文本图片只包含文字和背景两个组成部分,且文字部分和文字部分之间,背景部分和背景部分之间像素值相近,因此可以通过计算平均值的方法划分成两个部分,而将掩码与图片进行通道级连接后作为网络输入的方法在图像处理,进一步提升性能。

[0041]

输入的图片经过tps-align模块以及若干卷积做像素级校正后被输入到如图3所示的基本块中,该基本块包含两个正交方向的gru模型、通道注意力(channel attention)、空间注意力(spatial attention)用于细化特征。在基本块中,先通过两个正交方向的gru模型产生上下文信息感知的特征,再通过通道注意力、空间注意力细化该特征细化特征关注超分辨率所需要的高频信息(图片中的笔画信息)。

[0042]

两个正交产生上下文信息感知的特征为:

[0043][0044][0045]

其中:ht表示gru中的隐藏层,t1,t2分别表示水平方向和垂直方向的循环连接,x

t

表示输入特征,φ表示gru定义的矩阵运算。

[0046]

这样的特征虽然能够帮助模型考虑到水平方向和垂直方向的上下文信息,但存在的一个问题是这些特征可能过多地包含了对场景文字超分辨率无用的特征,如背景特征,过少地包含了对场景文字超分辨率有用的特征,如前景(文字)特征,而注意力机制的目的就是对已有特征计算出一个权重用于细化现有的特征以更好地捕获特征中的高频信息,通道注意力和空间注意力的结构如图4、5所示,具体方法分别为:

[0047][0048][0049]

其中:f表示输入特征,mc表示通道注意力,σ表示sigmoid函数,mlp表示多层感知机制,avgpool表示平均池化,maxpool表示最大池化,ms表示空间注意力,f表示卷积运算。

[0050]

将基本块输出的超分辨率图片和其对应的高分辨率图计算获得mse损失函数、sfm损失函数作为总的损失函数进行反向梯度传播。使用预训练好的场景文字识别模型crnn作为判别器,将输出的超分辨率图片和其对应的高分辨率图片分别输入到文本识别模型crnn中(不进行后处理分类操作)以得到两组图片对应的语义特征,将两组特征之间的差值通过l1损失函数进行计算得到文本感知损失函数,该感知损失函数、与mse损失函数、sfm损失函共同监督此模型。

[0051]

最终输出对应输入的低分辨率图片的超分辨率图片,该图片可以可视化输出,该输出图片可以继续输入到文本识别模型中测量识别结果,模型采用2020年eccv《scene text image super-resolution in the wild》提出由成对低分辨率-高分辨率图片对组成的数据集textzoom进行训练和测试。

[0052]

该实施例方法的性能与此前方法的性能对比如下表所示:

[0053] easy/crnnmedium/crnnhard/crnntsrn(2020eccv)52.5%38.2%31.4%pcan(2021acmmm)59.6%45.4%34.8%text gestalt(2022aaai)61.2%47.6%35.5%本方法63.3%50.8%36.8%

[0054]

本发明在现有模型的基础上考虑到了利用语义分割信息,注意力机制以及识别模型crnn的语义信息来进行优化,因此该模型的性能相比于此前模型来说性能更优秀。

[0055]

上述实施例只为说明本发明的技术构思及特点,其目的在于让熟悉此项技术的人士能够了解本发明的内容并据以实施,并不能以此限制本发明的保护范围。凡根据本发明精神实质所作的等效变化或修饰,都应涵盖在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1