基于多尺度Transformer的静脉识别神经网络模型、方法与系统与流程

本发明属于生物特征识别,具体涉及一种基于多尺度transformer的静脉识别神经网络模型、方法与系统。

背景技术:

1、现有很多分类模型可以有效的从静脉图片中提取到静脉纹路等特征信息,通常情况下只选取一种尺度下的静脉图像进行特征提取进而分类。但是在静脉识别终端时,由于是非接触式的静脉采集方式,采集到的静脉图像可能由于距离采集终端的远近不同,造成图像尺寸不同,然而,统一尺寸训练的模型对不同尺度的图像是敏感的,尽管可以调整图像大小到一个尺寸,但这样会忽略同一图像在不同尺寸间的相互关系,没有不同尺寸间的相互关系去影响或者补充同一尺寸的不同信息位置块的高级语义,导致模型的识别性能有限。

技术实现思路

1、本发明的目的之一是提供一种基于多尺度transformer的静脉识别神经网络模型,以解决现有模型中忽略了多样的尺寸的相关关系,导致识别性能有限的技术问题。

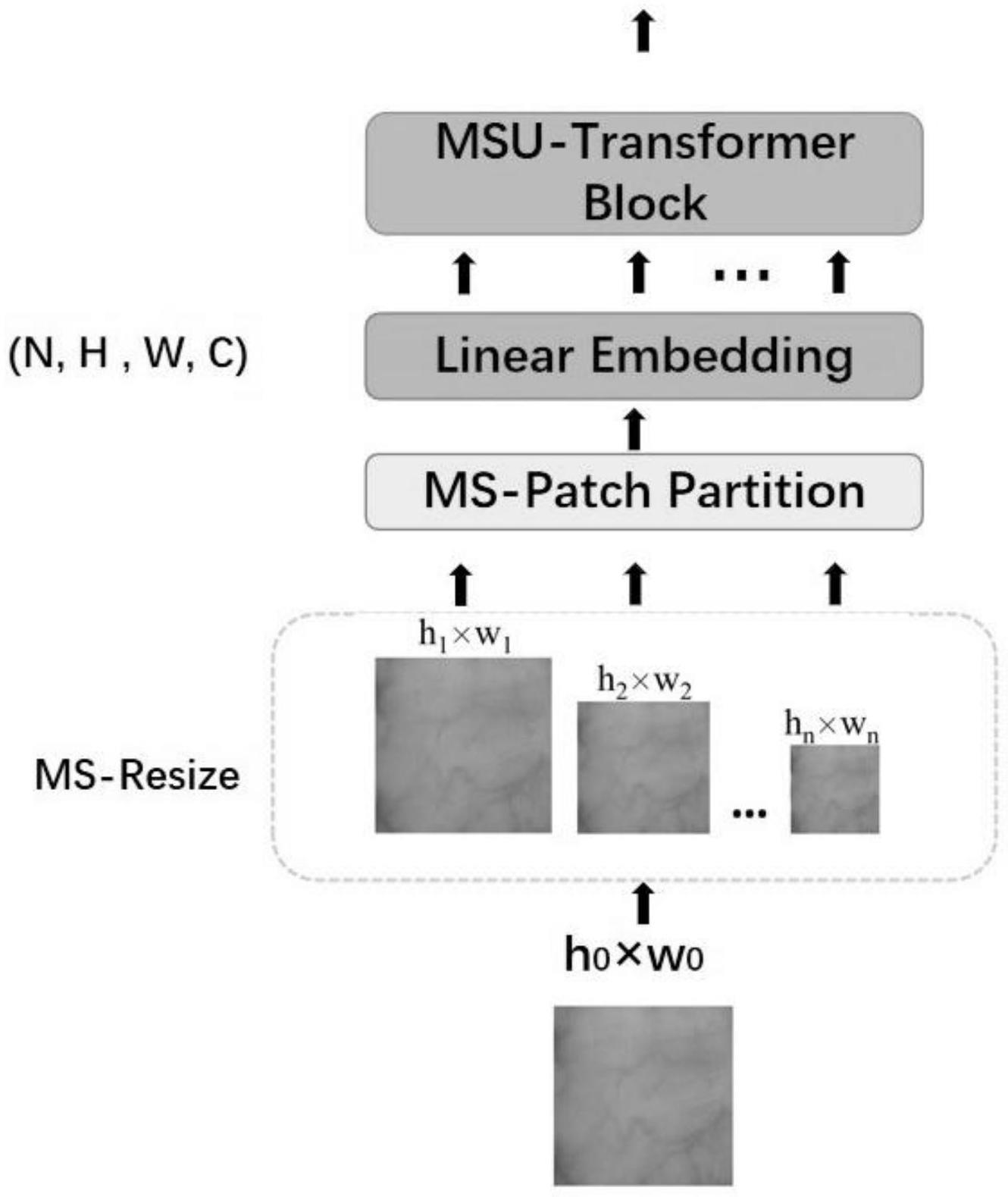

2、本发明中的基于多尺度transformer的静脉识别神经网络模型,包括,依次连接的尺度变换模块、多尺度分割模块、线性嵌入模块和多尺度transformer模块;

3、所述尺度变换模块,用于将静脉图片i,缩放为多个不同的尺寸的子图in,n=1,2…n,令h0、w0、c分别为静脉图片i的高、宽和通道数,hn、wn、c分别为子图in的高、宽和通道数,有:h1>h2>…hn,w1>w2>…wn;

4、所述多尺度分割模块用于将各子图in分割为尺寸为p×l的位置块(patch),其中对于尺寸最大的i1,采用无重叠分割;其余子图均采用有重叠分割,该有重叠分割使得各子图被分割为相同数量的,尺寸为p×l的位置块;

5、以及,将各子图的各个位置块展平为长度为c=plc的序列pm,n,m=1,2…m,n=1,2…n;其中m为位置块的数量,有:

6、m=h×w

7、

8、所述线性嵌入模块,用于通过可学习的映射矩阵e,将各序列pm,n映射为长度为d的特征(token)tm,n,并将各子的特征拼接为一维的特征序列it,n;

9、以及,对各特征序列it,n分别实施可学习的位置编码;

10、以及,增加一可学习的,形式与特征序列it,n相同的尺度嵌入序列escale,与各子图的特征序列共同组成特征序列集ite;

11、所述多尺度transformer模块包括了依次连接的尺度自注意力计算部分和空间自注意力计算部分;

12、所述尺度自注意力计算部分,用于基于输入的特征序列集ite计算不同的子图上对应于同一位置的位置块间的自注意力权重,称尺度自注意力权重,并得到基于特征图块集ite的输出xnew;

13、所述空间自注意力计算部分,用于基于输入xnew计算同一子图上对应于不同位置的位置块间的自注意力权重,称空间自注意力权重,并得到基于xnew的输出x(1)。

14、进一步的,所述多尺度transformer模块还包括连接在空间自注意力计算部分之后的多层感知部分,包括了依次连接的归一化层(ln)和多层感知子模块(mlp),该部分中引入有droppath机制以及残差连接,该部分的输出y为所述多尺度transformer模块的输出。

15、进一步的,所述尺度自注意力计算部分,包括依次连接的归一化层(ln)、尺度自注意力子模块(scale attention)和前馈网络模块(ffn),该部分中在前馈网络模块之后引入有droppath机制以及残差连接;

16、其中,所述尺度自注意力子模块用于,以输入中的各特征序列/尺度嵌入序列内对应于同一图块位置的共计n+1个特征为一组输入序列,分别计算各组输入序列中的各特征间的自注意力权重。

17、进一步的,所述空间自注意力计算部分,包括依次连接的归一化层(ln)和空间自注意力子模块(space attention),该部分中在空间自注意力子模块之后引入有droppath机制以及残差连接;

18、其中,所述空间自注意力子模块用于,以输入中同一子图或尺度嵌入图块所对应的特征序列为一组输入序列,计算各输入序列中各特征序列间的自注意力权重。

19、进一步的,所述多尺度transformer模块中的自注意力计算为多头自注意力计算。

20、进一步的,还包括图块卷积模块;

21、至少一个所述的多尺度transformer模块与所述图块卷积模块连接形成多尺度transformer-卷积模组;

22、若所述多尺度transformer-卷积模组包含多个多尺度transformer模块,则各个多尺度transformer模块依次级联,其中最后一级多尺度transformer模块与所述图块卷积模块连接;

23、所述多尺度transformer模块的输出y的形式在进入多尺度transformer-卷积模组时,变换二维特征矩阵集的形式;

24、所述图块卷积模块,包括依次连接的第一颗粒卷堆栈块、第二颗粒卷堆栈块和降采样层;

25、所述第一粒卷堆栈块用于,一方面令输入y通过串连的一全连接层和一卷积核为1×1,步长为1的二维卷积层得到输出y(1),其中,全连接层和卷积层的输出通道数均为输入y的通道数的γ<1倍;

26、令输入y首先通过一全连接-dw卷积子模块,该子模块中在全连接层的基础上还加入了卷积核为k×k步长为1的dw(depth-wise)卷积层(dw-conv)再经过一卷积核为1×1步长为1的二维卷积层,得到输出y(2),全连接-dw卷积子模块和二维卷积层的输出通道数均为输入y的通道数的γ<1倍;

27、以及,将所述y(1)、y和y(3)在通道维度上依次连接,得到输出z;

28、所述第二粒卷堆栈块,用于采用与第一粒卷堆栈块同样的方式,基于输入z得到输出z(1);

29、所述降采样层用于基于一2×2的卷积核对z(1)实施降采样,且输入通道数为输入通道数的一半。

30、进一步的,包括多组级联的所述多尺度transformer-卷积模组;

31、其中,后一级多尺度transformer-卷积模组中的神经网络形式适应于前一级多尺度transformer-卷积模组的输出形式;

32、并且,后一级多尺度transformer-卷积模组中多头自注意计算的头数是前一级多尺度transformer-卷积模组中的2γ+1倍。

33、进一步的,包括四组级联的多尺度transformer-卷积模组。

34、本发明的另一目的是提供一种静脉识别方法,包括:

35、步骤1获取静脉图片;

36、步骤2将该静脉图片输入已训练好的前述的基于多尺度transformer的静脉识别神经网络模型中得到识别结果。

37、本发明的又一目的是提供一种静脉识别系统,包括静脉图片获取模块和识别模块;

38、所述静脉图片获取模块用于获取需识别的静脉图片;

39、所述识别模块内部署有已训练好的前述的基于多尺度transformer的静脉识别神经网络模型,用于根据输入的静脉图片,通过该静脉识别神经网络模型得到识别结果。

40、进一步的,还包括训练模块,该模块用于获取用于训练所述静脉识别神经网络模型的静脉图片样本;

41、以及利用静脉图片样本对基于多尺度transformer的静脉识别神经网络模型实施训练,进而更新该神经网络模型中的参数。

42、本发明的原理和有益效果在于:

43、本发明有别于现有技术中基于cnn的深度学习静脉识别模型,提出了基于transformer的静脉识别神经网络模型,其中,本发明对现有的vit(vision transformer)模型进行了多尺度化改进,将输入图片通过尺寸变换化为包括了不同尺寸的子图的图集,且每一子图均被划分/重叠划分为同样数量同样尺寸的位置块,再通过不同尺度间的同一位置的图块的特征序列来进行计算不同尺寸的子图上此处位置间的联系,进而让模型学习到尺寸的联系,间接的消除不同尺寸的敏感性。模型先分位置学习到同一位置上不同尺度间的注意力信息,再分子图学习传统的统一尺寸下的不同位之间注意力信息,此时带有丰富的尺度间信息,使得全局信息更加完善,提取的特征更加友好。为了满足不同尺度下同时能够计算不同位置的相关信息,本模型中又多加了一个记忆不同尺度信息的特征图块序列,与各子图的特征图块形式一致。本发明通过不同尺度同一位置间以及同一尺度不同位置间的关系去影响分类结果,提高了的模型识别性能。

44、另外,将每幅图像转换为多个不同尺度的图像,扩大训练样本,从而可以提高识别性能。

45、由于自注意力计算中更为注重全局注意力信息,在本发明一些实施例中,额外的在多尺度transformer模块后增加新型的图块卷积模块(patch convnn block),起到提取局部信息,归纳偏置与降采样作用。卷积算子允许通过使用局部感野并共享权值来学习局部特征,而transformer中的自注意机制能够捕获全局特征,两个模块的组合可以形成互补,以提高静脉识别精度。

46、另外,基于transformer的神经网络模型通常包含较多的需要训练的参数,然而,在静脉识别任务中并没有大量的训练样本,这使得模型的容量可能无法得到有效的利用,模型受训练条件的影响进而在实际应用中对静脉识别任务识别精度的提升有限。本发明实施例中将卷积合并到transformer中的策略,可以从另一个侧面提高识别精度,对于不具备海量训练样本的静脉识别任务来说非常具有实际意义。

- 还没有人留言评论。精彩留言会获得点赞!