一种基于移动计算设备的眼动追踪方法与流程

本发明涉及眼动追踪,特别是涉及一种基于移动计算设备的眼动追踪方法。

背景技术:

1、眼球运动对于揭示人的认知活动状态有重要价值。传统上的眼动追踪技术主要通过眼动仪实现。眼动仪依赖于特定的硬件设备,比如红外光源和高时空分辨率近红外相机等,成本较高。随着手机和平板电脑等移动计算设备的普及,以及基于轻量级神经网络的新一代眼动追踪算法的出现,基于移动计算设备的眼动追踪技术成为可能。然而,目前已有的移动设备端眼动追踪技术距离实际应用仍有差距,追踪准确度低是其核心缺陷。比如,基于ios系统arkit api的眼动追踪算法的追踪准确度仅可达到3.2度视角左右,无法应用于健康评估等移动端应用场景。部分开源和众筹的眼动追踪解决方案(如webgazer和turkergaze)也得到了一定的关注,但是追踪准确度也不理想。在一项研究工作中,krafka等人(2016)建立了一个由移动端摄像头采集的眼动追踪数据集(gazecapture)并据此开发了一款基于卷积神经网络的眼动追踪算法(itracker)。该眼动追踪算法的准确性在手机端和平板电脑端分别达到了约1.71cm和2.53cm,但该算法无法报告以视角为单位的追踪误差。采用与krafka等人(2016)类似的技术路线,google的研究人员(2020)报告了追踪准确度低于1度视角的追踪算法;但是,在该研究中,用于测试的面部数据来自模型训练时使用过的人脸,该算法的泛化能力存疑。

2、目前可用于实验室研究和医疗用途的高准确度眼动追踪设备的追踪误差通常低于1度视角。基于专用硬件的可穿戴眼动追踪设备(如tobii glasses2)实测的追踪准确性通常在1.5度左右。如上述,移动设备端的各种眼动追踪技术的追踪准确性未能达到与专业追踪设备相当的水平,这是阻碍其广泛商业应用的关键障碍。

技术实现思路

1、本发明的目的是提供一种基于移动计算设备的眼动追踪方法,其能够利用移动计算设备上现有的摄像头实现高准确度的眼动追踪。

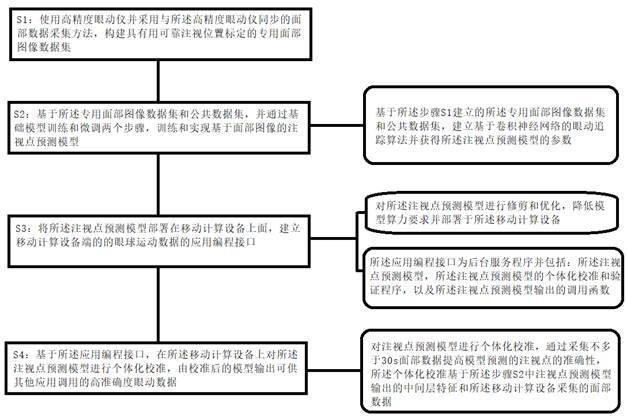

2、为实现上述技术目的,本发明提供一种基于移动计算设备的眼动追踪方法,所述移动计算设备具有摄像头和屏幕,其中:所述眼动追踪方法包括如下步骤:s1:使用高精度眼动仪并采用与所述高精度眼动仪同步的面部数据采集方法,构建具有用可靠注视位置标定的专用面部图像数据集;s2:基于所述专用面部图像数据集和公共数据集,并通过基础模型训练和微调两个步骤,训练和实现基于面部图像的注视点预测模型;s3:将所述注视点预测模型部署在移动计算设备上面,建立移动计算设备端的的注视点等眼球运动数据的应用编程接口,所述应用编程接口包含三个模块:1)注视点预测模型;2)校准和验证模块;3)注视点预测模型输出的调用模块;s4:基于所述应用编程接口,在所述移动计算设备上对所述注视点预测模型进行个体化校准,由校准后的模型输出可供其他应用调用的高准确度注视点位置等眼动数据。

3、本发明提供一种基于移动计算设备的眼动追踪方法,建立专用面部图像数据集并训练注视点预测模型,再将模型架构往移动端的迁移并建立应用编程接口api,在移动计算设备上进行个体化校准,并供其他应用调用。本发明公开的方法可应用到基于移动端摄像头的眼球运动追踪系统及设备。

4、作为进一步的改进,所述移动计算设备的移动计算平台采用android、鸿蒙和ios中的之一系统;在用户自然手持设备的情况下,实现低于1度视角的追踪准确度。

5、作为进一步的改进,在所述步骤s2中,基于所述步骤s1建立的所述专用面部图像数据集和公共数据集,建立基于卷积神经网络的眼动追踪算法并获得所述注视点预测模型的参数;在所述步骤s3中,对所述注视点预测模型进行修剪和优化,降低模型算力要求并部署于所述移动计算设备。

6、作为进一步的改进,在所述步骤s3中,所述应用编程接口为后台服务程序并包括:所述注视点预测模型,所述注视点预测模型的个体化校准和验证程序,以及所述注视点预测模型输出的调用函数。

7、作为进一步的改进,所述注视点预测模型主要负责对输入的面部图像信息进行处理并输出模型预测的注视点位置;所述校准和验证模块的主要功能为用个体的眼球运动数据对注视点预测模型进行校准并对校准后的模型预测准确度进行验证;所述注视点模型输出的调用模块将所述注视点预测模型输出,以被其他应用实时读取和调用。

8、作为进一步的改进,在步骤s4中,对注视点预测模型进行个体化校准,通过采集不多于30s面部数据提高模型预测的注视点的准确性,所述个体化校准基于所述步骤s2中注视点预测模型输出的中间层特征和所述移动计算设备采集的面部数据。

9、作为进一步的改进,所述个体化校准包括三个模块:1)个体化数据采集;2)基于机器学习算法的模型校准;3)校准结果的验证。

10、作为进一步的改进,个体化数据采集使用步骤s4中的移动计算设备端校准程序完成,该程序在屏幕上呈现目标,所述目标沿事先设定的轨迹运动,用户注视所述目标完成设定的用户任务,在所述目标运动的过程中记录用户的面部图像。

11、作为进一步的改进,从记录的所述面部图像中选取部分作为注视点预测模型的输入,以提取模型的第一层fc(fully-connected layer)特征;使用机器学习算法建立fc特征与目标位置之间的对应关系,完成模型的个体化校准;校准完成以后,用户可以使用所述校准和验证模块对校准的效果进行验证,该模块会在屏上呈现按预设轨迹运动的目标刺激并采集用户面部图像,用户分别注视各个点,然后根据步骤s4中的个体化校准过程完成注视点预测模型的个体化校准,验证模块会调用经过个体校准的模型的输出来预测用户的注视位置,在屏幕上呈现目标并将其与经过个体化校准的注视点预测模型进行比较,为注视点预测模型的误差进行直观的量化,评定并以图示的方式向用户反馈屏幕各区域的注视点预测准确性。

12、作为进一步的改进,在步骤s1中,在移动计算设备端的屏幕上提供移动标识点,获取眼睛随标识点移动时的面部图像数据以及移动标识点位置;在所述高精度眼动仪数据服务器端,采用网络通信协议(tcp/udp)广播个体的实时注视位置;在所述移动计算设备端将所述面部图像数据与眼动仪广播的实时眼动数据同时记录;建立大样本的所述专用面部图像数据集。

13、作为进一步的改进,每一数据样本包括样本的人脸图像、样本人脸图像对应的注视点标注信息,以及采集面部图像所采用的移动计算设备信息;所述每一数据样本中的每张人脸图像都以相应的注视位置进行标注,标注信息由同时采集的眼动仪提供的注视点信息进行检验以确保标定注视点位置是可靠的。

14、作为进一步的改进,在所述步骤s2中,所述注视点预测模型是基于混合注意力机制的卷积神经网络模型;所述基于混合注意力机制的卷积神经网络包括第一网络模块、第二网络模块、第三网络模块和第四网络模块;所述第一网络模块用于提取人脸特征,所述第二网络模块用于提取眼睛区域的特征,所述第三网络模块用于提取眼睛和人脸相对坐标的位置特征,所述第四网络模块用于融合以上三个网络模块特征回归出眼睛的注视点。

15、作为进一步的改进,注视点预测模型的构建包括训练阶段和预测阶段,在所述训练阶段,同时基于混合注意力机制的卷积神经网络模型输入:使用预先设定人脸检测算法获取的人脸图像、使用预先设定人脸关键点算法检测出的左右眼睛图像、通过人脸关键点算法计算出的人脸眼睛坐标的相对坐标和尺度信息;其中需要向第二网络模块同时输入左右眼睛区域的图像,具体实现是第二网络模块进行权重共享复用,将其一个用于输入左眼图像,另一个输入右眼图像;最后网络输出眼睛的注视点位置信息,使用基于眼动仪获取的标签,使用常用l1或者l2损失函数进行监督训练;在所述预测阶段,所述第一网络模块的输入端用于输入人脸图像;所述第二卷积网络的输入端用于输入对应人脸的左右眼睛区域图像;所述第三网络输入端用于输入所述人脸图像中的眼睛在所述目标人脸图像上的位相对坐标和尺度信息;所述第二网络具体使用时分解为两个并联网络分支使用,一个输入左眼区域图像,另一个输入右眼区域图像;所述第一网络和所述第二网络均包括多个且依次连接的卷积注意力单元;第三网络为全连接层,其中,按照数据流传输方向,所述卷积注意力单元包括依次连接的卷积层、通道注意力子单元和空间注意力子单元。

16、作为进一步的改进,在所述步骤s2中,所述注视点预测模型的训练包括基础模型训练和模型参数微调两个步骤,所述注视点预测模型的训练方法为下列方法之一:1)使用公共数据集训练基础模型,然后使用步骤s1建立的专用面部图像数据集的部分数据进行模型参数微调;2)使用步骤s1建立的专用面部图像数据集训练基础模型,然后公共数据集的部分数据进行模型参数微调;3)使用公共数据集和步骤s1建立的专用面部图像数据集中的部分数据进行交替训练和微调,直到模型具有鲁棒的输出和良好的泛化性;4)针对关键面部特征进行模型优化,形成一组特异的注视点预测模型,允许模型根据输入的面部图像的关键特征调用经过特异性优化的注视点预测模型。

17、作为进一步的改进,在移动计算平台的部署包括如下三个模块:1)注视点预测模块;2)图像采集和预处理模块;3)模型输出的参照系转换模块;所述三个模块的工作流程如下:图像采集和预处理模块调用移动计算设备摄像头采集面部图像数据,然后对图像进行预处理,识别出人脸、眼睛等区域,并据此生成注视点模型可接受的特征输入,包括人脸图像、左眼图像、右眼图像以及人脸框和眼睛框的左上角和右下角坐标;注视点预测模块对这些数据输入进行处理,输出为模型预测的注视点位置。

18、作为进一步的改进,模型输出的注视点位置的参照原点为移动计算设备的摄像头,单位为厘米。

19、作为进一步的改进,为了便于设备间的一致性,接收到模型的输出以后,模型输出的参照系转换模块会把注视点位置坐标转换成以移动计算设备屏幕为参照系,以像素为单位的注视位置,所述注视点预测模型的注视点输出为x和y坐标,以便于移动计算设备端的其他软件调用注视点预测模型的输出。

20、作为进一步的改进,在步骤s4中,提供通用的移动端注视点预测模型应用编程接口,允许第三方应用调用实时眼动数据进行应用开发。

21、本发明所提供的一种基于移动计算设备的眼动追踪方法,以及其体现的技术框架,基于并利用移动端摄像头实现眼动追踪算法和技术框架,通过模型修剪获得能够在移动设备端部署的低量级深度学习模型,该模型具有跨设备进行眼动追踪的功能。提供完整的移动端软件开发接口,允许第三方软件实时读取模型输出的、以移动设备屏幕为参照的眼睛注视位置(gaze position)。能够在捕捉面部图像时保护用户隐私,只采集模型所需的面部框和眼部图像数据。

- 还没有人留言评论。精彩留言会获得点赞!