一种基于深度学习的税号分类及关联要素识别方法

本发明涉及深度学习,具体是一种基于深度学习的税号分类及关联要素识别方法。

背景技术:

1、企业自行申报报关单内容并自主缴纳税款的方式为通关速度带来重大提升,但随之而来的税号误报识别问题也难以解决;传统税号识别依托人工经验,但易于混淆的申报要素会为申报企业和审核人员对税号的识别带来极高的困惑度;

2、随着人工智能的发展,基于深度学习的方式税号识别是海关应用领域中一大研究重点问题,这其中使用自然语言处理技术解决该问题是一个可靠的途径;但目前主流的使用预训练语言模型的文本分类方法所需的下游训练开销大,随着模型的参数规模增加,效果会更好,但训练成本也随之上升;同时大部分现有研究未完全使用海关编码的层级结构,未能充分利用税号与文本之间的特征进行文本分类,导致最终的分类结果并不理想;即使模型输出了预测的税号,也由于深度学习的黑盒特性导致业务人员不敢轻易的使用预测结果;因此,如何更有效地挖掘基于税号编码层次的多层级特征提高分类准确度,以及如何能够像业务人员提供人类能够理解的税号分类和研判过程,是税号分类的实现和在海关领域真实应用的两大难点。

3、因此,人们需要一种基于深度学习的税号分类及关联要素识别方法来解决上述问题。

技术实现思路

1、本发明的目的在于提供一种基于深度学习的税号分类及关联要素识别方法,以解决上述背景技术中提出的问题。

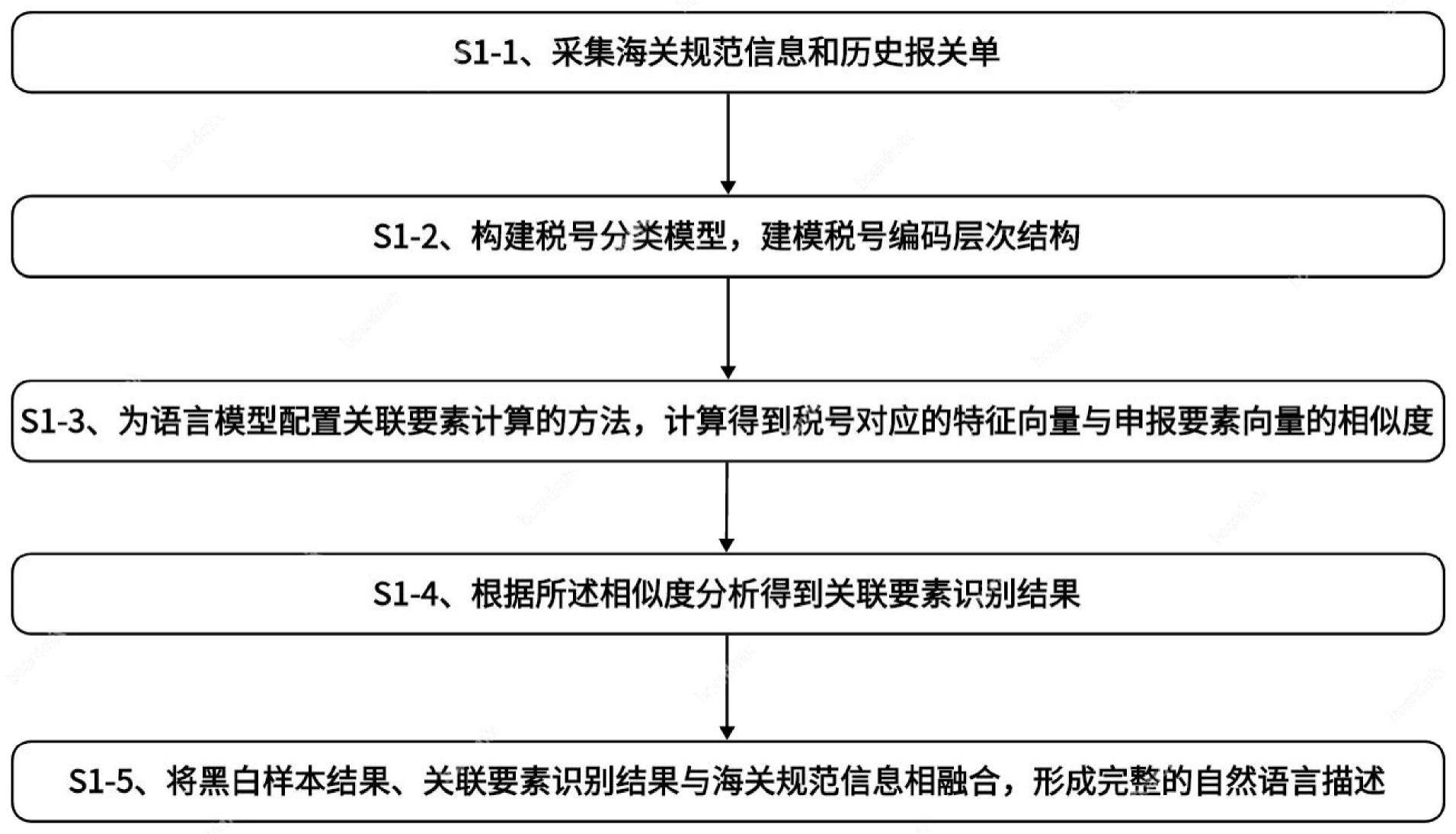

2、为了解决上述技术问题,本发明提供如下技术方案:一种基于深度学习的税号分类及关联要素识别方法,其特征在于:本发明包括以下步骤:

3、s1-1、采集海关规范信息和历史报关单;

4、s1-2、税号分类模型构建,建模税号编码层次结构;

5、s1-3、为语言模型配置关联要素计算的方法,计算得到税号对应的特征向量与申报要素向量的相似度;

6、s1-4、根据所述相似度分析得到关联要素识别结果;

7、s1-5、将黑白样本结果、关联要素识别结果与海关规范信息相融合,形成完整的自然语言描述。

8、进一步的,步骤s1-2中所述税号分类模型的构建包括以下步骤:

9、s2-1、从历史报关单中按比例抽取不同税号对应的样本,并整合生成预训练数据集;

10、s2-2、对预训练数据集的构建方法进行优化,,对基于bert的预训练语言模型结构进行优化并构建税号分类模型;

11、s2-3、对分类任务顺序学习的损失进行优化;

12、s2-4、对照样本所填报的税号,区分黑白样本。

13、进一步的,步骤s2-1中所述数据集的生成方式如下:

14、s3-1、从历史报关单中按比例抽取不同税号对应的样本,在训练集中保持真实环境的样本比例;

15、s3-2、将样本中自然语言的相关内容进行整合,通过模板的方式集成,作为输入,同时将税号作为输出;模板指一段文字模板,例如:“【商品名称】的属性包含:【属性1】、【属性2】,其所对应的商品类别为【类别】。”。

16、s3-3、对数据集中的10位税号进一步拆分,按照章节号、目号、国际子目号1、国际子目号2、中国子目号1、中国子目号2、附加码的方式拆分,并进一步将98个章节号聚集为22个商品类别号,按照上述8种类别分别构建为8个不同精度的税号分类数据集。

17、进一步的,步骤s2-2中对基于bert的预训练语言模型结构进行优化的过程如下:

18、s4-1、引入multi-lora的ml-bert,在hm-bert基础上,对直接微调预训练参数的方法进行了优化;multi-lora模块通过学习多个任务特定adapter的方法,并对adapter进行融合进而优化某相关任务的效果的思想,同时利用lora弥补传统adapter置于attention末尾从而引发的计算复杂度增加问题;

19、s4-2、引入lora模块,固定预训练参数仅训练lora模块,完成轻量级微调模型的效果;使用多个lora模块分别学习不同层次税号的分类知识,并融合各层次分类知识对10-digit税号进行预测;多层lora模块中,每个lora模块的结构相同,都处于multi-head-attention内q与v矩阵的旁路中。原始multi-head-attention的计算方法如下:

20、

21、其中,k表示key矩阵所计算得出的特征矩阵;q为query计算出的特征矩阵;v为value计算出的特征矩阵;dk表示输入特征向量的维度大小;

22、lora模块作为q与v的计算矩阵wq与wv的旁路添加到attention的计算中;此时,计算方法如下:

23、qorigin=x·wq,vorigin=x·wν

24、qlora=x·(wq+scale·ba)

25、=x·wq+scale·x·bkak(a∈dxr,b∈rxk,scale=α/r)

26、vlora=x·(wv+scale·ba)

27、=x·wv+scale·x·bvav(a∈dxr,b∈rxv,scale=α/r)

28、其中,qorigin为原始attention中query的计算方式;x为输入;wq为对应q的神经网络参数矩阵;vorigin为原始attention中value的计算方式;wv为对应v的神经网络参数矩阵;qlora为引入lora后query的计算方法;a为升维矩阵;b为降维矩阵;scale为缩放系数;bk为加在query旁路的降维矩阵;ak为加在query旁路的升维矩阵;dxr为降维矩阵大小为输入特征向量维度d与低秩维度r;v1ora为引入lora后value的计算方法;av为加在value计算旁路的降维矩阵;bv为加在value计算旁路的升维矩阵;rxk表示query对应的升维矩阵大小为低秩维度r与输出维度k;rxv为value对应的升维矩阵大小为低秩维度r与输出维度v;d为调整缩放大小的超参数;r表示设置的降维后的维度,即旁路矩阵的内在秩;每个q与v的计算都利用升维矩阵a与降维矩阵b作为需要学习的参数,与原生的wq和wv共同对输入x进行计算并融合得到最终结果,b矩阵初始化为0使初始旁路计算输出为0;

29、s4-3、而对于多个lora模块的情况,multi-lora计算q与v是通过合并多个lora旁路的计算结果,其计算公式如下式3:

30、

31、

32、其中,qlora为引入lora后query的计算方法;x为输入;wq为对应q的神经网络参数矩阵;scale为缩放系数;为训练第i个分类任务时query旁路中索引为i的升维矩阵;为训练第i个分类任务时query旁路中索引为i的降维矩阵;vlora为引入lora后value的计算方法;wv为对应v的神经网络参数矩阵;为训练第i个分类任务时value旁路中索引为i的降维矩阵;为训练第i个分类任务时value旁路中索引为i的降维矩阵。

33、而对于多个顺序学习的任务,在计算当前任务的输出时,由于后续任务的lora模块还未训练故输出为0,使后续任务的lora模块不会影响前置任务的学习,其表示如下式:

34、

35、

36、其中,qlora为引入lora后query的计算方法;x为输入;wq为对应q的神经网络参数矩阵;scale为缩放系数;为训练第i个分类任务时query旁路中索引为i的升维矩阵;为训练第i个分类任务时query旁路中索引为i的降维矩阵;为对于第c个任务后的每个任务多对应应该学习的第j个lora模块中的升维矩阵;为对于第c个任务后的每个任务多对应应该学习的第j个lora模块中的降维矩阵;vlora为引入lora后value的计算方法;wv为对应v的神经网络参数矩阵;为训练第i个分类任务时value旁路中索引为i的降维矩阵;为训练第i个分类任务时value旁路中索引为i的降维矩阵;如此在学习每个分类任务时,都能够利用前置的分类知识,并基于此学习后续的分类问题,符合海关税号中各层次编码的顺序依赖性。

37、由于multi-lora模块代替全量微调方法需要根据不同分类任务逐一训练lora模块,因此本研究相比hm-bert所提出的多任务学习方法,需要将多任务学习方式转变为多个分类任务顺序学习,以此建模海关编码构成中的顺序构成特性,但也导致ml-bert的损失函数与原始hm-bert的多任务损失有所区别。

38、进一步的,步骤s2-3中损失优化的方法如下:

39、s5-1、在学习特定分类任务时,先将预训练参数及除当前任务外的所有lora模块的参数固定,并训练各个encoder block中对应当前任务的lora模块参数;

40、s5-2、学习完特定任务的分类知识后,在最终的10-digit税号分类任务上,基于前置分类任务lora模块的输出结果进一步微调10-digit分类效果;其中训练某一个任务的lora模块时,其损失函数与hm-bert中交叉熵计算方式相同,计算方式如下:

41、ltask=h(y|ptask)

42、=-[y·logptask+(1-y)logptask]

43、其中,ltask为任务task对应的损失;ptask为模型输出的不同类别所构成的概率分布,y为真实的样本标签0-1分布;此处log的底数为10;

44、通过共享参数并输出多任务结果进行损失相加,多任务损失计算方法如下:

45、lall=∑taskltask

46、其中,lall为最终完整的训练损失;ltask为任务task对应的损失。

47、多任务损失计算方法通过共享参数并输出多任务结果进行损失相加的多任务损失计算方法,ml-bert则仅利用了交叉熵计算方式的单任务损失优化每个子任务学习,而在训练过程中,对于hm-bert中具有重要意义的共享参数思想,则是通过对浅层lora进行剪枝代替,通过共享浅层固定的预训练参数保证信息共享,能够为任务学习提供泛化特征。

48、进一步的,步骤s2-4中黑白样本的区分方法如下:

49、s6-1、引入lora后的bert模型,并保留10-digit税号分类器;

50、s6-2、将输入文本通过tokenizer转化为特征向量,并输入模型使用神经网络进行特征计算;

51、s6-2、通过softmax输出最终的税号分类概率,选择概率最大的一项作为当前输出概率;

52、s6-3、与预测值相同,则为白样本;与预测值若不同,则为黑样本。

53、进一步的,步骤s1-3包含以下步骤:

54、s7-1、在进行申报要素输入模板合并的同时,对输入样本形成切分序列,所述切分序列用于描述申报要素内容;

55、s7-2、在计算税号分类的过程中,ml-bert会输出等同于句子长度l的l个token的向量;其中,第一个token为tokenizer所添加的[cls]标签,该标签具备全部的文本特征,可作为税号对应的特征向量;

56、s7-3、将标记序列通过one-hot转码转化为要素标注矩阵,把上述税号对应的特征向量拼接构成特征矩阵,将特征矩阵与要素标注矩阵进行相乘得到k个申报要素向量;

57、s7-4、使用上述税号对应的特征向量逐一与所述申报要素向量进行相似度计算,分析得到关联要素。

58、进一步的,步骤s7-4中的相似度计算方法如下:

59、s8-1、将税号特征向量作为attention中的query向量,将关联要素矩阵作为key和value矩阵;

60、s8-2、通过上述数据,分析得到具有概率意义的相似度;

61、s8-3、直接与模型对接,进一步对相似度计算进行重参数化,并加入可训练的参数提供扩展的可能。

62、进一步的,步骤s1-5中信息整合的方法如下:

63、s9-1、通过结合税号分类模型,获得对黑白样本的识别结果;根据模型输出的税号分类,获取关联要素识别结果;

64、s9-2、通过模板的方式,将黑白样本的识别结果、关联要素识别结果与部分海关规范信息进行整合;针对白样本数据,构建关联要素与税号的关联性,帮助业务人员依据历史的正确查验结果对当前研判的内容进行判断;针对黑样本数据,提示业务人员注意某要素与税号之间的关联性存在历史误报情况,并给出此类误报带来的潜在税收风险;

65、s9-3、将整合的信息形成完整的自然语言描述,给业务人员提供能够理解的辅助研判依据。

66、与现有技术相比,本发明所达到的有益效果是:

67、1.本发明提出的一种基于深度学习的税号分类及关联要素识别方法,利用lora改进了税号分类模型,实现了轻量级的模型训练以及多层次分类任务的级联学习,解决了过往研究中未充分利用不同层次分类特征的问题,同时缓解了预训练语言模型全量参数微调带来的训练开销问题;

68、2.本发明进一步提高向量的相似度,缓解了深度学习自身黑盒模型的特性,在一定程度上给出了模型判别税号分类的原因,增加了分类结果的可解释性;

69、3.本发明通过组合成完整的自然语言表述方式,帮助业务人员更直观的理解税号分类的原因、结果和误报税号引发的后果,解决当前海关业务人员在税号误报研判中对易混淆或不清楚规范的税号审核上出现误判,同时加快了研判速度,增速通关效率。

- 还没有人留言评论。精彩留言会获得点赞!