一种张量流模型的转化方法、系统、装置及可读存储介质与流程

本发明涉及计算机,更具体的说是涉及一种张量流模型的转化方法、系统、装置及可读存储介质。

背景技术:

1、随着人工智能平台相关应用在互联网行业的广泛使用,互联网公司对于人工智能平台的需求也日渐提升。大量互联网公司均搭建了公开对外或对内使用的人工智能平台,这些平台大多基于kubernetes调度平台集成模型库,支持包括tensorflow和pytorch等引擎的训练和推理,以满足公司内部的需求。

2、目前的人工智能平台中,模型方式支持模型查询,模型导入,模型导出,模型校验及模型删除等功能,可以通过扩充人工智能平台内置的模型引擎支持对新增框架模型的版本部署。用户在模型部署时可按模型需求选择对应的模型框架进行服务部署,目前模型部署支持的框架类型包括pytorch、tensorflow、triton、onnx和tvm,支持的功能如图1所示。

3、但是,这类人工智能平台不会针对张量流模型(tensorflow模型)的部署进行相应的适配性处理,这使得张量流模型框架在缺乏相应插件集成的情况下难以发挥其真正作用,从客观层面来讲不利于效率的提升。目前在张量流模型部署层面常使用tensorflowserving框架模型版本导入tensorflow savedmodel格式的模型进行部署,其在使用过程中虽然可提供较为稳定且兼容性高的模型部署,但对于模型的推理性能及效率的提升较为有限,难以达到高性能推理的效果。

技术实现思路

1、针对以上问题,本发明的目的在于提供一种张量流模型的转化方法、系统、装置及可读存储介质,通过将张量流模型转化为高性能推理模型,有效提升了部署推理服务的推理效率,以及用户的使用效率和体验。

2、本发明为实现上述目的,通过以下技术方案实现:

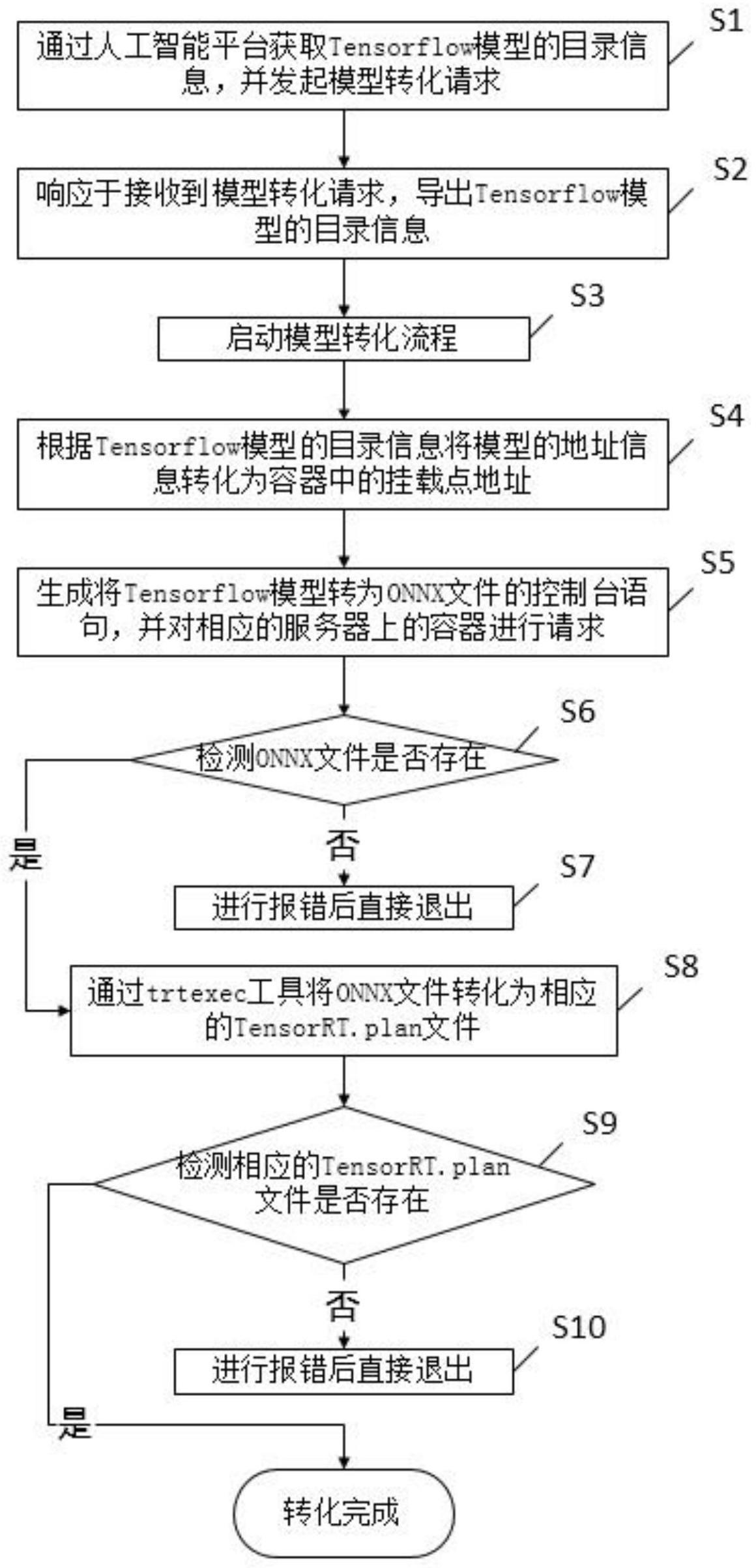

3、第一方面,本发明公开了一种张量流模型的转化方法,包括:

4、通过人工智能平台获取张量流模型的目录信息,并发起模型转化请求;

5、响应于接收到模型转化请求,导出张量流模型的目录信息;

6、启动模型转化流程;

7、根据张量流模型的目录信息将模型的地址信息转化为容器中的挂载点地址;生成将张量流模型转为onnx文件的控制台语句,并对相应的服务器上的容器进行请求;

8、利用张量流模型的目录信息检测onnx文件是否存在;

9、若不存在,则进行报错后直接退出;若存在,则通过模型优化工具将onnx文件转化为相应的推理模型文件;

10、利用张量流模型的目录信息检测相应的推理模型文件是否存在;

11、若不存在,则进行报错后直接退出;若存在,则转化完成。

12、进一步,所述启动模型转化流程,包括:

13、在转化模式选择列表中,选择转化模式为推理模型转化,并将转化状态设置为进行中。

14、进一步,所述根据张量流模型的目录信息将模型的地址信息转化为容器中的挂载点地址,包括:

15、根据模型转化请求的主键从数据库取出相应的张量流模型的目录信息;

16、将张量流模型的导入和导出地址转化为在容器中的挂载点地址。

17、进一步,所述生成将张量流模型转为onnx文件的控制台语句,包括:根据容器内挂载点地址,使用注解获得当前服务器配置下的容器信息,并将其注入到对应属性上,以生成控制台语句;

18、通过控制台语句将张流量模型转化为onnx文件。

19、进一步,所述利用张量流模型的目录信息检测onnx文件是否存在,包括:

20、利用张量流模型的目录信息获取相应的挂载点地址;

21、检测挂载点地址上是否关联有onnx文件;

22、若是,则onnx文件存在;否则onnx文件不存在。

23、进一步,所述利用张量流模型的目录信息检测相应的优化模型文件是否存在,包括:

24、利用张量流模型的目录信息获取相应的挂载点地址;

25、检测挂载点地址上是否关联有推理模型文件;

26、若是,则推理模型文件存在;否则推理模型文件不存在。

27、进一步,所述容器信息包括:容器的名称、所在的服务器地址、挂载的网络文件系统地址。

28、第二方面,本发明还公开了一种张量流模型的转化系统,包括:

29、请求发起单元,配置用于通过人工智能平台获取张量流模型的目录信息,并发起模型转化请求;

30、目录导出单元,配置用于响应于接收到模型转化请求,导出张量流模型的目录信息;

31、转化启动单元,配置用于启动模型转化流程;

32、地址转化单元,配置用于根据张量流模型的目录信息将模型的地址信息转化为容器中的挂载点地址;

33、指令生成单元,配置用于生成将张量流模型转为onnx文件的控制台语句,并对相应的服务器上的容器进行请求;

34、第一文件检测单元,配置用于利用张量流模型的目录信息检测onnx文件是否存在;

35、文件转化单元,配置用于当第一文件检测单元检测到onnx文件存在时,通过模型优化工具将onnx文件转化为相应的推理模型文件;

36、第二文件检测单元,配置用于利用张量流模型的目录信息检测相应的推理模型文件是否存在;

37、报警单元,配置用于当第一文件检测单元未检测到onnx文件或第二文件检测单元未检测到推理模型文件时,进行报错后直接退出。

38、进一步,所述转化启动单元具体用于:在转化模式选择列表中,选择转化模式为推理模型转化,并将转化状态设置为进行中。

39、进一步,所述地址转化单元具体用于:根据模型转化请求的主键从数据库取出相应的张量流模型的目录信息;将张量流模型的导入和导出地址转化为在容器中的挂载点地址。

40、进一步,所述文件转化单元具体用于:根据容器内挂载点地址,使用注解获得当前服务器配置下的容器信息,并将其注入到对应属性上,以生成控制台语句;通过控制台语句将张流量模型转化为onnx文件。

41、进一步,所述第一文件检测单元具体用于:利用张量流模型的目录信息获取相应的挂载点地址;检测挂载点地址上是否关联有onnx文件;若是,则onnx文件存在;否则onnx文件不存在。

42、进一步,所述第二文件检测单元具体用于:利用张量流模型的目录信息获取相应的挂载点地址;检测挂载点地址上是否关联有推理模型文件;若是,则推理模型文件存在;否则推理模型文件不存在。

43、第三方面,本发明还公开了一种张量流模型的转化装置,包括:

44、存储器,用于存储张量流模型的转化程序;

45、处理器,用于执行所述张量流模型的转化程序时实现如上文任一项所述张量流模型的转化方法的步骤。

46、第四方面,本发明还公开了一种可读存储介质,所述可读存储介质上存储有张量流模型的转化程序,所述张量流模型的转化程序被处理器执行时实现如上文任一项所述张量流模型的转化方法的步骤。

47、对比现有技术,本发明有益效果在于:本发明公开了一种张量流模型的转化方法、系统、装置及可读存储介质,通过在容器内进行相应的转化配置,生成控制台语句将张量流模型转为onnx文件,从而使用该镜像最终完成张量流模型转化为高性能推理模型的功能。用户可以使用转化后的高性能推理模型进行训练和推理服务的有效部署,达到高性能推理的效果。本发明通过将已有的张量流模型转化为高性能推理模型,有效的压低了用户的模型训练时间,提升了部署推理服务的推理效率,令用户可以轻松使用已有的模型进行高效的推理工作,以提升用户的使用效率和体验。

48、由此可见,本发明与现有技术相比,具有突出的实质性特点和显著的进步,其实施的有益效果也是显而易见的。

- 还没有人留言评论。精彩留言会获得点赞!