一种基于U-Net的部分孪生去雾网络的构造方法

本发明属于图像处理领域,具体涉及一种基于u-net的部分孪生去雾网络的构造方法。

背景技术:

1、随着工业化的迅速发展,糟糕的天气,如雾霾,频繁发生。在雾霾的影响下,人们经常获取到模糊的、色彩失真甚至丢失很多关键信息的图片。因此如何对采集到的图像进行去雾处理成为一个非常重要的问题。图像去雾的效果直接影响本发明获取图像的质量,也影响到高级视觉任务(如目标检测、目标跟踪、人脸识别和图像分类)结果的准确性。如何从模糊的图像中恢复清晰的图像已经成为计算机视觉研究中的一个热门话题。

2、目前,现有的图像去雾方法可以分为两类:基于参数先验的去雾方法和基于学习的去雾方法。基于参数先验的图像去雾方法依赖于大气散射模型。这些方法通过预估全球大气光、传输图等参数,从而实现对图像的去雾处理。尽管在许多情况下,这些先验方法取得了一些重要进展,但在特定条件下,它们可能会面临一些挑战。例如,在光照不均匀或强雾霾等情况下,基于中间参数估计的去雾方法可能会出现较大的误差,从而导致图像中出现伪影、颜色失真等退化现象。随着深度学习的发展,近年来,端到端的去雾方法已成为主流,其通过直接学习了雾到清晰图像之间的映射关系,而无需使用大气散射模型。wu等人发表了《contrastive learning for compact single image dehazing》提出了aecr去雾方法,它将上层编解码层的信息与相应的解码层上的尺度进行融合,并通过在框架的损失函数中引入负样本形成对比正则化损失。qing等人发表了《ffa-net:feature fusionattention network for single image dehazing》通过在网络中堆叠通道注意和像素注意模块来增强网络对雾区域的约束能力并以此提出了去雾方法ffa-net。done等人发表的《multi-scale boosted dehazing network with dense feature fusion》中提出了一种msbdn去雾方法,msbdn在编码层和解码层之间设计了密集的跳跃连接并取得了良好的去雾性能。其中一些方法通过改变网络和设计两阶段的去雾框架来提高框架的约束能力。wei等人基于循环结构设计了一个两阶段的图像去雾框架。jiang等人设计了一个两阶段的图像去雾框架,可以将去雾和细节细化作为两个独立的任务。

3、尽管这些方法可以取得较好的去雾效果,然而由于缺乏约束能力,在处理复杂雾霾图像时仍然存在伪影和色彩失真。具体而言其存在以下问题。

4、(1)本文主要针对两阶段框架的约束缺失问题。尽管两阶段框架可以增强网络的约束能力,但是两阶段框架将第一阶段的输出作为第二阶段的输入,因此第一阶段中丢失的信息无法在第二阶段中重构。因此,由两阶段形成的双重约束是无效的,因此生成的图像中经常出现伪影。

5、(2)这些方法中的大多数通过在编码和解码层之间跳跃来融合信息以减少信息丢失。这些方法的跳跃连接忽视了编码阶段每个级别的重要性,而这些级别包含不同的信息。如果可以在解码层的图像重建过程中有效地融合来自不同编码层的信息,不仅可以增强特征表达能力,还可以有效减少特征信息的稀释。

技术实现思路

1、本发明的目的是为了解决现有图像去雾技术在使用u型网络进行图像去雾时,所存在的对于图像有雾区域缺乏约束的技术问题,以及二阶段框架参数量过大,对有雾区域的约束失效的技术问题;此外,本发明还能解决直传统u型网络直接将解码层与对应尺度的编码层进行融合,缺乏不同层次编码层信息的有效利用的技术问题,以及基于u型网络结构模型的下采样会破坏图像的空间细节信息,上采样的过程中存在特征稀释的技术问题。

2、为了解决上述技术问题,本发明采用的技术方案为:

3、一种基于u-net的部分孪生去雾网络的构造方法,它包括以下步骤,

4、步骤s1:构建部分孪生去雾框架,该框架包含两个权值共享的u型网络、高效特征提取模块;

5、步骤s2:构建u型图像去雾网络,该网络包括:编码层特征提取模块、特征修复模块、解码层图像恢复模块;

6、步骤s3:构建双编解码多尺度特征融合模块,利用s1中编码层特征提取模块所提取特征,将不同层次的特征进行融合;

7、步骤s4:将有雾图像送入u型图像去雾网络,通过多层次特征融合模块和通道非局部信息增强注意力模块,输出清晰的无雾图像,最后利用输出的清晰图像来计算损失,约束网络的训练。

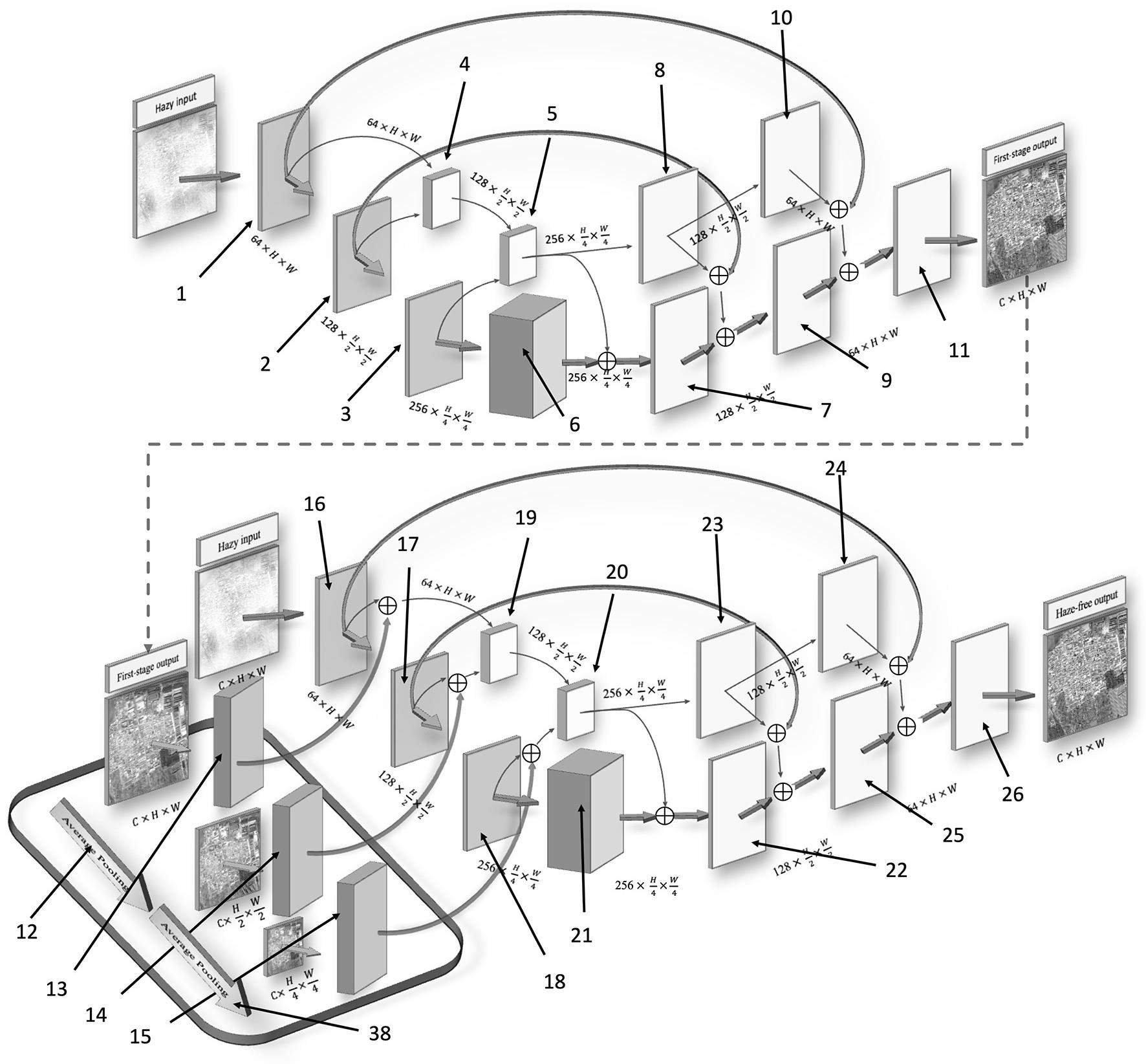

8、在步骤s1中,如图1所示,去雾框架部分孪生框架包含两个具有相同权重共享结构的子网络,每个子网络包括一个高效特征提取模块和一个去雾生成器,为了最大限度地保留和提取输入图像中雾下的隐藏信息,将相同的有雾图像作为两个子网络的输入;通过一系列的损失函数对两个子网络的输出进行约束,使网络能够更好地相互学习,提高图像去雾的能力。

9、构建的部分孪生去雾框架如下:

10、输入图像i→去雾网络u1→第一次去雾图像→高效特征提取模块efecg→先验信息f;

11、输入图像i,先验信息f→去雾网络u2→去雾图像。

12、去雾网络u1具体为:

13、有雾图像→第一个编码层→第一层编码特征→第二个编码层→第二层编码特征→第三个编码层→第三层编码特征;

14、第一层编码特征,第二层编码特征→第一个多尺度特征提取模块→第一个二次编码融合特征;

15、第一个二次编码特征,第三层编码特征→第二个多尺度特征提取模块→第二个二次编码融合特征;

16、其中多尺度特征提取模块操作如下,

17、第一层编码特征→第一个conv层(3*3)→第一个二次编码特征bf1,第二个编码层→第二个conv层(3*3)→第一个instancenorm层→第一个残差特征提取模块→第二个残差特征提取模块→第一个二次编码的多尺度特征;

18、第二层编码特征→第三个conv层(3*3)→第二个二次编码特征bf1,第三个编码层→第四个conv层(3*3)→第二个instancenorm层→第三个残差特征提取模块→第四个残差特征提取模块→第二个二次编码的多尺度特征;

19、第二个二次编码融合特征→第一个反卷积层→第一个二次解码特征→第二个反卷积层→第二个二次解码特征;

20、第三层编码特征→残差特征提取组→第一个解码层→第一个解码层特征,第一个编码层特征,第一个二次编码特征→第二个解码层→第二个解码层特征,第二个编码层特征,第二个二次编码特征→第三个解码层→第一次去雾图像。

21、高效特征提取模块efecg具体为:

22、如图3所示,第一次去雾图像→第一个globalavagepool层→第二个globalavagepool层;

23、第一次去雾图像→第一个卷积层(3*3)→第二个卷积层(3*3)→卷积层1*1层cb4→先验特征f1;

24、第一个globalavagepool层gap→第一个卷积层(3*3)→第二个卷积层(3*3)→第三个卷积层(3*3)→第四个卷积层(1*1)→先验特征f2;

25、第二个globalavagepool层gap→第一个卷积层(3*3)→第二个卷积层(3*3)→第三个卷积层(3*3)→第四个卷积层(1*1)→先验特征f3。

26、所述去雾网络u2具体为:

27、有雾图像→第一个编码层→第一层编码特征→第二个编码层→第二层编码特征→第三个编码层→第三层编码特征;

28、第一层编码特征与先验特征f1的融合特征,第二层编码特征与先验特征f2的融合特征→第一个多尺度特征提取模块→第一个二次编码融合特征;

29、第一个二次编码特征,第三层编码特征与先验特征f3的融合特征→第二个多尺度特征提取模块→第二个二次编码融合特征;

30、其中多尺度特征提取模块操作如下,

31、第一层编码特征→第一个conv层(3*3)→第一个二次编码特征bf1,第二个编码层→第二个conv层(3*3)→第一个instancenorm层→第一个残差特征提取模块→第二个残差特征提取模块→第一个二次编码的多尺度特征;

32、第二层编码特征→第三个conv层(3*3)→第二个二次编码特征bf1,第三个编码层→第四个conv层(3*3)→第二个instancenorm层→第三个残差特征提取模块→第四个残差特征提取模块→第二个二次编码的多尺度特征;

33、第二个二次编码融合特征→第一个反卷积层→第一个二次解码特征→第二个反卷积层→第二个二次解码特征;

34、第三层编码特征→残差特征提取组→第一个解码层→第一个解码层特征,第一个编码层特征,第一个二次编码特征→第二个解码层→第二个解码层特征,第二个编码层特征,第二个二次编码特征→第三个解码层→去雾图像。

35、在步骤s4中,在训练时,使用四种损失约束网络训练具体如下:

36、(1)smoothl1损失,具体公式为:

37、

38、

39、xi和yi分别代表有雾图像和gt图像在像素i处的值,g()代表去雾网络参数,g(xi)代表输入图像i处的像素值然后经过去雾网络参数运算得到的值,n表示图像中的像素个数;

40、(2)感知损失,使用vgg16在imagenet上的预训练模型进行计算感知损失,具体公式为:

41、

42、其中x和y分别代表有雾图像和gt图像,i代表特征图的第i层,h代表特征图的长度,w代表特征图的宽度,c代表特征图的通道,其中ci代表特征图第i层的通道,wi代表特征图第i层的宽度,hi代表特征图第i层的长度,φi(x)代表输入的有雾图像经过vgg16预训练模型后得到第i层大小为长度为hi,宽度为wi,通道数为ci的特征图,||||表示l2范数,n表示在感知损失中使用vgg16预训练模型特征层的数量;

43、(3)多尺度结构相似度损失,具体公式为:

44、

45、其中,x代表生成图像,y代表清晰图像,μx,μy分别代表生成图像和gt图像的均值,σx,σy分别代表标准差,σxy代表生成图像和清晰图像的协方差,βmγm表示两项相对重要性,c1,c2为常数项,m表示尺度的总数;

46、(4)对抗损失,具体公式为:

47、

48、其中,d(y)表示将去雾后的图像y判断为清晰图像的概率,n代表图像总数,整体网络的损失函数表示为:

49、losssod=λ1lsmoothl1+λ2ladv+λ3lperc+λ4lms-ssim

50、其中λ1,λ2,λ3,λ4为每个损失函数的超参数。

51、与现有技术相比,本发明具有如下技术效果:

52、1)通过良好设计的部分孪生去雾框架,可以引入“孪生网络”来构建“孪生约束”,以增强网络对于有雾区域的约束能力,从而改善整个网络的图像去雾能力,特别适用于具有浓雾遮挡的遥感图像。

53、2)提出了一种称为双编解码多尺度信息融合模块的方法,通过双编码器探索如何提高网络中有雾特征的提取,并通过多尺度信息的融合进一步增强特征表达能力,有效减少特征信息的稀释。此外,当数据集受到浓雾的污染时,双编解码多尺度信息融合模块方法能够有效增强去雾的鲁棒性。

54、3)本发明开发了一种名为部分孪生去雾网络的新颖方法,将设计的部分孪生去雾框架和双编解码多尺度信息融合模块无缝集成到部分孪生去雾网络中,用于处理遥感场景中的图像去雾。通过对有雾区域施加更有效的约束,我们的方法在statehazelk]和hrsd等具有挑战性的基准数据集上优于大多数先进方法。

- 还没有人留言评论。精彩留言会获得点赞!