基于轻量化Transformer的文本语义挖掘方法及系统

本发明属于自然语言处理,具体涉及一种基于轻量化transformer的文本语义挖掘方法及系统。

背景技术:

1、随着大数据时代的到来,如何从海量的文本中提取出关键信息,成为自然语言处理领域的热门课题,充分提取自然语言的特征是关键句抽取任务的重要前提。在政务、医疗、金融、交通等领域中都有广泛应用,基于自注意力机制的transformer模型可以捕获长距离依赖信息并高效地并行计算,常用于提取特征。但是transformer模型的复杂度为o(n2),当输入序列较长时,其计算复杂度就会偏大,因此需要做轻量化处理。传统降低transformer复杂度的方法容易使特征信息丢失,导致精度大幅下降,无法获得速度与精度的平衡。

技术实现思路

1、为解决现有技术中的不足,本发明提供一种基于轻量化transformer的文本语义挖掘方法及系统,能够有效降低transformer模型的计算复杂度,从海量的文本中快速、精确地挖掘出感兴趣的句子。

2、为达到上述目的,本发明所采用的技术方案是:

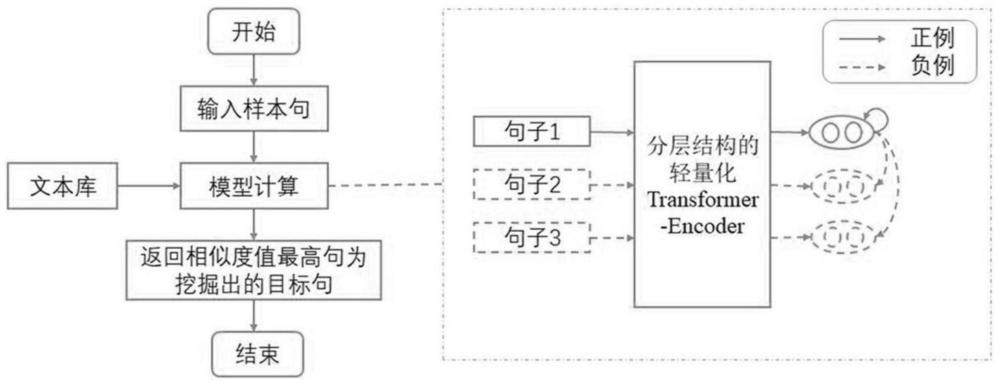

3、第一方面,提供一种文本语义挖掘方法,包括:获取待分析文本;将待分析文本输入基于分层结构的轻量化transformer模型,输出分析向量;基于分析向量构造样例对,进行对比学习,并结合相似度衡量指标从待分析文本中挖掘出所需的文本语义。

4、进一步地,所述基于分层结构的轻量化transformer模型的低层采用局部窗口注意力机制,用于提取局部特征并建立局部特征的上下文联系;所述基于分层结构的轻量化transformer模型的高层采用标准的多头自注意力机制,用于获取全局完整的信息;所述基于分层结构的轻量化transformer模型包括若干个低层,每个所述低层包括一个transformer模块;所述基于分层结构的轻量化transformer模型包括一个高层,所述高层包括一个transformer模块;每个所述transformer模块包含位置编码、局部窗口注意力或标准的多头自注意力、前馈神经网络、层归一化和残差连接。

5、进一步地,所述基于分层结构的轻量化transformer模型的低层采用局部窗口注意力机制,用于提取局部特征并建立局部特征的上下文联系,包括:采用局部窗口注意力机制中的非重叠窗口注意力机制提取各个局部窗口内的特征;采用基于局部敏感哈希的滑动窗口注意力机制计算局部窗口之间的联系。

6、进一步地,采用局部窗口注意力机制中的非重叠窗口注意力机制提取各个局部窗口内的特征,包括:首先对输入的数据做层归一化操作;然后采用非重叠窗口注意力机制,计算各个局部非重叠窗口内的注意力;其次,进行基于局部敏感哈希的滑动窗口注意力计算,以获取跨窗口元素之间的联系;最后,再次进行层归一化后,输入多层感知机用于分类。

7、进一步地,非重叠窗口注意力将输入序列均匀划分为一组不重叠的小窗口,并在每个小窗口中分别执行多头自注意力,则第p个窗口内的注意力机制和多头注意力机制表示如下:

8、

9、multihead(xp)=concat[head(xp)1,…,head(xp)h]

10、其中,xp表示第p个非重叠局部窗口的嵌入向量,wq、wk、wv分别表示将xp投影至三个不同的空间,作为查询query、键key和值value,dk表示编码向量的维度,多头自注意力机制multihead(xp)表示将所有的头拼接后得到的结果;

11、在通过非重叠窗口注意力获得每个窗口的聚合信息后,将它们合并以计算输出。

12、进一步地,采用基于局部敏感哈希的滑动窗口注意力机制计算局部窗口之间的联系,包括:首先,利用局部敏感哈希进行元素间的相似度判断,获得滑动窗口内所有token(transformer把具有独立语义的最小单位称为token)之间的相似度信息,将哈希值相同的,即相似的token置于同一个“桶”中;将哈希值不同的,即不相似的token置于不同“桶”中,具体为:

13、如果‖p-q‖≤r,那么prh[h(q)=h(p)]≥p1

14、如果‖p-q‖≥cr,那么prh[h(q)=h(p)]≤p2

15、其中,p,q表示任意的两个token,r表示特征空间中的距离,c表示近似系数,p1,p2表示两个概率;

16、其次,仅计算不同局部窗口中相似元素的注意力值,用于表示局部窗口之间的联系,并忽略不相似元素之间的注意力,如下公式所示:

17、

18、其中,t表示token,右下标相同的字母表示来自同一非重叠窗口,不同字母表示来自不同非重叠窗口;右上标的相同数字表示为相似的token,不相同数字表示为不相似的token。

19、进一步地,所述基于分层结构的轻量化transformer模型的高层采用标准的多头自注意力机制,用于获取全局完整的信息,包括:在基于分层结构的轻量化transformer模型的高层,每个token与包括自身在内的所有token计算注意力值,具体为:

20、

21、其中,qg,kg和vg分别表示全局的查询、键和值。

22、进一步地,基于分析向量构造样例对,进行对比学习,并结合相似度衡量指标从待分析文本中挖掘出所需的文本语义,包括:将待分析文本输入基于分层结构的轻量化transformer模型两次,得到两个分析向量,将两个分析向量的和作为正例对;使用in-batch negatives的方式得到负例;优化对比损失;通过余弦相似度算法对样本句子和文本库进行相似度匹配,返回相似度值最高的句子即为挖掘出的目标句子,从而从待分析文本中挖掘出所需的文本语义。

23、进一步地,对比损失为:

24、

25、其中,表示两个相似向量的余弦相似度,τ是温度常数。

26、第二方面,提供一种文本语义挖掘系统,包括:文本获取模块,用于获取待分析文本;模型分析模块,用于将待分析文本输入基于分层结构的轻量化transformer模型,输出分析向量;文本语义挖掘模块,用于基于分析向量构造样例对,进行对比学习,并结合相似度衡量指标从待分析文本中挖掘出所需的文本语义。

27、与现有技术相比,本发明所达到的有益效果:

28、(1)本发明通过基于分层结构的轻量化transformer模型,将大部分transformer模块中的标准自注意力机制换成局部窗口注意力机制,使复杂度大幅降低;同时,保留了一层的标准自注意力机制,用于获取全局完整的特征信息,尽可能保留了精度;

29、(2)本发明所使用的局部窗口注意力机制由非重叠窗口注意力机制和基于局部敏感哈希的滑动窗口注意力机制构成,分别用于提取局部特征和建立局部上下文的联系,提升了对局部特征的捕获能力;

30、(3)本发明所使用的基于局部敏感哈希的滑动窗口注意力机制,利用局部敏感哈希预先进行元素间的相似度判断并忽略不相关元素之间的注意力,从而解决了传统滑动窗口注意力在计算局部窗口之间的联系时产生的计算效率低的问题。

- 还没有人留言评论。精彩留言会获得点赞!