采用手臂区域保留策略的虚拟试穿方法

本发明涉及虚拟试穿,具体涉及一种采用手臂区域保留策略的虚拟试穿方法。

背景技术:

1、虚拟试穿在服装电子商务领域具有极大的应用前景。三维虚拟试穿方法通过在三维模型中将衣片贴合至人体的方式来模拟服装上身后的效果,这种方式可以实现多视角的物理仿真,但通常存在对设备要求高、模型复杂、时间成本高等问题。近年来,基于图像生成的虚拟试穿方法随着深度学习的发展应运而生,这类方法无需使用三维信息,在更方便部署的同时,试穿结果图生成效率高、用时短,更适用于现有的服装在线营销场景,引起了广泛关注。

2、当前的虚拟试穿研究通常需借助图像生成方法来实现。han等人提出首个基于图像的虚拟试穿网络viton(han x,wu z,wu z,et al.viton:an image-based virtual try-on network[c]//proceedings of the ieee conference on computer vision andpattern recognition.2018:7543-7552.),该网络使用从粗略到精细的策略将所需的衣服无缝地传送到人体的相应区域。此后,wang等人提出的cp-vton(wang b,zheng h,liang x,et al.toward characteristic-preserving image-based virtual try-on network[c]//proceedings of the european conference on computervision(eccv).2018:589-604.)通过一种新的几何匹配模块(geometric matching module,gmm)学习薄板样条(thin-plate spline,tps)变换的参数来变形服装,并设计了一个基于u-net结构的试穿模块以渲染最终试穿结果图。minar等人提出cp-vton+(minar m r,tuan t t,ahn h,etal.cp-vton+:clothing shape and texture preserving image-based virtual try-on[c]//cvprworkshops.2020,3:10-14.),针对cp-vton中人体表示以及几何匹配模块的设计进行了改进。yang等人提出acgpn(yang h,zhang r,guo x,et al.towards photo-realistic virtual try-on by adaptively generating-preserving image content[c]//proceedings ofthe ieee/cvf conference on computer vision and patternrecognition.2020:7850-7859.),根据预测的人体分割图确定是否需要生成或保留其图像内容。ge等人提出dcton(ge c,song y,ge y,et al.disentangled cycle consistencyfor highly-realistic virtual try-on[c]//proceedings of the ieee/cvfconference on computer vision and pattern recognition.2021:16928-16937.),通过循环一致性学习以自监督的方式对网络进行训练。然而,cp-vton+忽略了人体手臂区域的保留,这导致所得试穿结果中人体手部区域模糊、手指间的边界不清晰,同时,其采用简单的u-net结构来渲染最终试穿图像,试穿结果不够自然;acgpn对图像内容的保留忽略了原始服装所带来的影响,且试穿结果对预测的人体分割图的准确度依赖性极高;由于分割图预测模块的引入或训练策略的影响,acgpn、dcton等网络都具备较高的参数量,对计算资源需求高。

技术实现思路

1、本发明的目的在于提供一种采用手臂区域保留策略的虚拟试穿方法,解决应用现有方法难以获取具备真实感的试穿结果的问题。

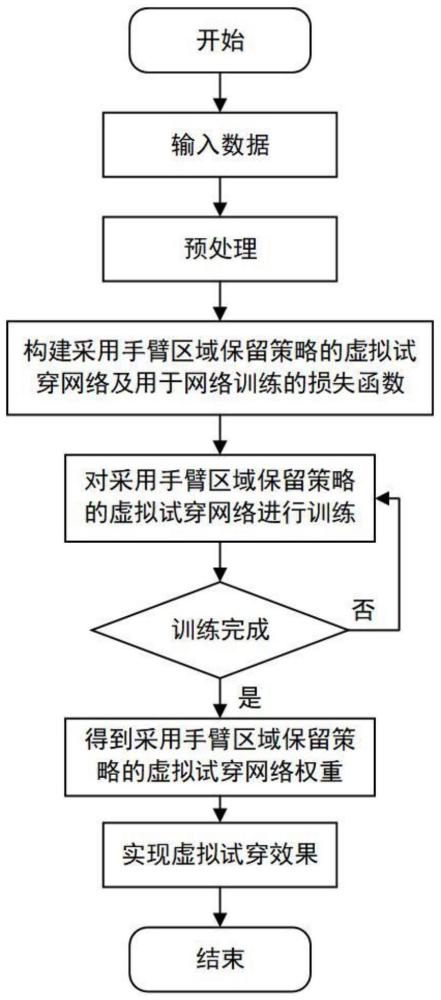

2、本发明所采用的技术方案是,采用手臂区域保留策略的虚拟试穿方法,具体按照以下步骤实施:

3、步骤一、分别对人体图像i和服装图像c进行预处理,得到服装无关的人体表示hp和服装图像c对应的掩码m,获取预处理结果;

4、步骤二、构建一种采用手臂区域保留策略的虚拟试穿网络,构建用于网络训练的损失函数;

5、步骤三、使用配对图像训练集图像和其经过步骤一得到的预处理结果来训练采用手臂区域保留策略的虚拟试穿网络,得到采用手臂区域保留策略的虚拟试穿网络权重;

6、步骤四、将非配对图像测试集中的人物图像和试穿服装图像经步骤一的预处理操作后,利用获得的预处理结果作为输入,基于采用手臂区域保留策略的虚拟试穿网络及网络权重生成逼真的试穿图像,实现在图像中将服装迁移至人体对应区域的虚拟试穿效果。

7、本发明的特征还在于,

8、步骤一具体为:对于人体图像i进行预处理得到服装无关的人体表示hp,预处理的具体过程为:使用openpose姿态估计器对人体图像i中人物进行姿态估计得到的姿势热图、使用lip人体解析器对人体图像i中人物进行图像分割得到的身体形状掩码、利用lip人体解析器从人体图像i中获取头部区域;对于服装图像c进行预处理得到c对应的服装掩码m,预处理的具体过程为:使用lip人体解析器对图像c中服装进行图像分割得到c对应的服装掩码m。

9、步骤二中,构建基于手臂区域保留策略的虚拟试穿网络,基于手臂区域保留策略的虚拟试穿网络包含三个模块,分别为服装变形模块、手臂区域保留模块、试穿生成模块;服装变形模块用于将服装进行变形至贴合人体的形态;手臂区域保留模块用于对人体手臂区域进行自适应的保留,获取修正的服装无关的人体表示;试穿生成模块用于得到的变形服装及修正的服装无关的人体表示生成试穿结果图。

10、步骤二中,服装变形模块包含有两个编码器,相关匹配层co、回归器r、形变模块w;

11、其中,每个编码器都包含四个步幅为2的下采样卷积层和两个步幅为1的卷积层,它们的过滤器数量分别为64、128、256、512、512、512;

12、相关匹配层co包含将输入的其中的两组特征表示分别按通道归一化为单位l2范数并展平为矩阵,在每个位置上对两组特征得到的展平矩阵做点积运算得到相关图;

13、回归器r包含两个步幅为2的下采样卷积层、两个步幅为1的卷积层和一个输出大小为50的全连接输出层,下采样卷积层与卷积层的过滤器数量分别为512、256、128、64;

14、服装变形模块的处理过程为:输入服装无关的人体表示hp与服装图像c对应的服装掩码m,经两个编码器分别对服装无关的人体表示hp与服装掩码m进行特征提取,得到两组特征之后,相关匹配层co将两组特征组合为相关图,将相关图输入至回归器,预测得到形变参数θ;形变模块w基于tps变换根据形变参数θ对服装图像c和服装掩码m做形变处理,得到变形服装cw与变形服装掩码mw;

15、其中,将用于训练服装变形模块的损失函数构建为由像素上的损失和变形正则化损失组合构成:

16、

17、式中,λreg和λc为像素上的损失和变形正则化损失所对应的超参数;像素上的损失定义为变形服装cw与人体图像i中的服装区域ic间的l1范数,用于鼓励网络获取外观接近真值的变形服装;变形正则化损失定义在tps变形网格上,用于对服装的变形幅度进行约束,以保持服装纹理,避免过度变形;

18、的表达式为:

19、

20、式中,p表示tps变形网格上的一个控制点,p表示tps变形网格的控制点集,gx(p)与gy(p)分别表示tps变形网格在控制点p处的x轴坐标与y轴坐标;p0、p1、p2、p3分别表示与控制点p相邻的左、右、上、下侧的控制点;gx(p0)与gx(p1)分别表示tps变形网格在控制点p0与p1处的x轴坐标;gy(p2)与gy(p3)分别表示tps变形网格在控制点p2与p3处的y轴坐标。

21、步骤二中,手臂区域保留模块用于进行变形服装掩码膨胀与反转、手臂区域中原始服装残留像素移除、获取修正的服装无关的人体区域三步操作,最终获取修正的服装无关的人体表示,具体为:

22、s1:变形服装掩码膨胀与反转:使用15*15的结构元素对服装变形模块得到的变形服装掩码mw进行形态学膨胀操作,使变形服装掩码向外扩张。再将扩张后的变形服装掩码的背景与前景区域反转,得到变形服装以外的区域掩码mb=(1-dilate(mw,(15,15)));

23、s2:手臂区域中原始服装残留像素移除:首先,对人体图像i中的原始服装区域所对应的掩码mc做掩码膨胀与翻转操作,得到原始服装以外的区域掩码m′b=(1-dilate(mc,(15,15))),将m′b与人体图像i中的手臂区域iarm在像素上相乘得到移除了原始服装残留像素的手臂区域i′arm,避免原始服装残留像素对试穿生成过程产生影响;

24、s3:获取修正的服装无关的人体区域:对移除了原始服装残留像素的手臂区域i′arm和变形服装以外的区域掩码mb进行像素上的相乘操作,得到试穿服装无关的手臂区域i″arm:

25、i″arm=mb⊙i′arm

26、式中,⊙表示哈达玛积;创建宽度与输入图像相等、高度为hl像素值、位置随机的条状掩码mline,并对试穿服装无关的手臂区域i″arm进行移除,得到最终的保留手臂区域,将最终的保留手臂区域与人体图像i中的身体头部及下装区域ibp组合得到修正的服装无关的的人体区域i′bp:

27、

28、式中,表示像素上的相加;

29、将步骤一预处理得到的服装无关的人体表示hp中的从人体图像i中截取得到的头部区域替换为修正的服装无关的的人体区域i′bp,得到修正的服装无关的人体表示h′p。

30、步骤二中,试穿生成模块包含:编码器、解码器、掩码合成模块;

31、其中,编码器包含四个步幅为2的下采样卷积层和两个步幅为1的卷积层,它们的过滤器数量分别为64、128、256、512、512、512;

32、解码器包含六个由最近邻插值和1*1卷积组成上采样层,每个上采样层后堆叠有一个mobilevit块,上采样层的过滤器数量分别为512,512,256,128,64,4,mobilevit块由局部表示、全局表示、融合这三部分组成;

33、试穿生成模块的处理过程为:将修正的服装无关的人体表示h′p与在通道上堆叠的变形服装cw及变形服装掩码mw输入编码器,提取多级特征;将最后一级特征输入解码器,并在编码器和解码器间通过跳跃连接传递多级特征,以更好的获取下采样过程中容易丢失的信息(本发明通过将mobilevit块堆叠至解码器每个上采样层之后的方式来提高解码器获取全局信息的能力,从而提高生成结果的质量);解码器输出预测的构图掩码mo和渲染的人物图像ir;最后,进行掩码合成操作:使用构图掩码mo将变形服装cw与渲染的人物图像ir融合在一起,得到最终试穿结果io:

34、io=mo⊙cw+(1-mo)⊙ir

35、将用于训练试穿生成模块的损失函数构建为

36、

37、式中,λm、λp、λvgg和λffl为损失所对应的超参数;用于鼓励构图掩码mo更接近人体图像i中的原始服装区域所对应的掩码mc;像素上的损失与特征层面的损失用于在空间域缩小生成结果与真实图像的差距,φi(io)和φi(i)分别表示最终试穿结果io与人体图像i在vgg网络第i层的特征图,λi表示相应的权值;焦点频率损失通过优化频域间距以进一步改善生成质量;焦点频率损失的表达式为:

38、

39、式中,mf、nf分别表示图像的宽和高,(u,v)表示频谱上空间频率的坐标;fr(u,v)表示真实图像在坐标(u,v)处的频率值,fg(u,v)表示生成图像在坐标(u,v)处的频率值,表示真实图像和生成图像之间的频率距离,w(u,v)=|fr(u,v)-fg(u,v)|α表示频谱权重矩阵,α是灵活性的比例因子,频谱权重矩阵使得损失自适应地将集中在难以处理的频率分量上。

40、步骤三中,配对图像训练集由多张人物图像及人物图像对应的所穿服装的图像组成;在训练过程中,使用adam优化器在反向传播过程中优化网络权重;对服装变形模块进行200000代的训练,经手臂区域保留模块获取修正的服装无关的人体表示后,再对试穿生成模块进行200000代的训练。

41、步骤四中,非配对图像测试集由多张人物图像及试穿服装图像组成。

42、本发明的有益效果是:

43、本发明方法提出了一种采用手臂区域保留策略的试穿网络,针结合cp-vton+进行改进,通过手臂区域保留模块对原人体图像中的手臂区域进行灵活保留,组建修正后的服装无关的人体表示,更合理的保留了手臂特征;通过试穿生成模块与mobilevit的结合及焦点频率损失的引入,提高试穿结果的生成质量。在常用数据集上进行验证,证明本发明在人体区域特征和服装与人体的自然贴合等方面,得到了更具真实感的结果。

- 还没有人留言评论。精彩留言会获得点赞!