基于强化学习的多智能体动态追捕任务训练方法及装置

本技术涉及课程学习,特别涉及一种基于强化学习的多智能体动态追捕任务训练方法及装置。

背景技术:

1、追捕-逃跑问题是指在一个大小受限且包含障碍物的场景中,多个慢速的追捕者捕获一个或者多个逃跑者的。连续空间追捕-逃跑任务的研究工作在现实世界中也有应用价值,如无人驾驶飞行器和移动机器人所述,该问题的核心挑战是,多个追捕者如何相互合作,在躲避障碍物的前提下,安全地捕获逃跑者。追捕任务的难度受到多种环境因素的影响,包括追捕者和逃跑者的机动能力,追捕场地的大小和维度,障碍物的密集程度等。

2、目前,可通过非学习类追捕方法和基于强化学习的追捕方法解决上述追捕-逃跑问题。其中,非学习类追捕方法可通过设计多种引力和斥力的数学形式,引导追捕者移动,例如,janosov方法假定每个追捕者都会受到逃跑者的吸引力,朝向逃跑者移动,同时受到队友的斥力,防止碰撞;然而该方法贪心追捕逃跑者,且躲避障碍物,缺少多个追捕者之间的合作性,性能严重受到任务初始条件和逃逸策略的影响,因此,在逃跑者策略更加智能或者任务环境复杂度更高的情况下,该类方法几乎完全失效。

3、而为了解决上述问题,现有技术可通过合作追捕方法利用深度强化学习算法,直接控制追捕者的下一步动作,通过与仿真环境交互,迭代更新追捕策略。例如,相关技术可利用参数共享的置信域策略优化算法(trust region policy optimization,trpo)学习一种追捕策略,该策略可协调多个追击者同时攻击逃逸者,证明深度强化学习方法优于非学习类追捕方法。与非学习类方法相比,深度强化学习使得追捕者之间合作性更强,追捕策略更加多样,其中有些策略无法通过显式规则进行硬编码。

4、尽管基于强化学习的追捕方法已经取得了很大的突破,但这类方法存在根本性缺陷:强化学习的训练方法样本效率低,解决某一种初始条件下的追捕任务,通常需要几天甚至几周的训练时长。而且,基于固定初始条件训练得到的追捕策略,难以应用到不同的场景。例如,空旷场景训练得到的追捕策略,直接应用于障碍物密集的场景,会出现策略崩溃的现象。因此,如何高效地求解追捕者的合作策略,并使其能够应用到不同的场景中,仍然是一个有待解决的问题。

5、另外,目前的追捕方法只研究了二维平面上的追捕问题,任务复杂度低,追捕者可行策略少。而在三维立体场景中,如何让多个追捕者抓捕到一个高速移动的逃跑者,同样是一个未被探索的问题。

6、综上所述,现有技术仅研究环境复杂度低的二维追捕任务,且非学习类追捕方法缺少多个追捕者之间的合作性,性能受到任务初始条件的严重影响,此外,基于强化学习的追捕方法样本效率低、训练时间长、应用局限性较大,亟待解决。

技术实现思路

1、本技术提供一种基于强化学习的多智能体动态追捕任务训练方法及装置,以解决现有技术仅研究环境复杂度低的二维追捕任务,且缺少多个追捕者之间的合作性,性能受到任务初始条件的严重影响,或者存在样本效率低、训练时间长、应用局限性较大等问题。

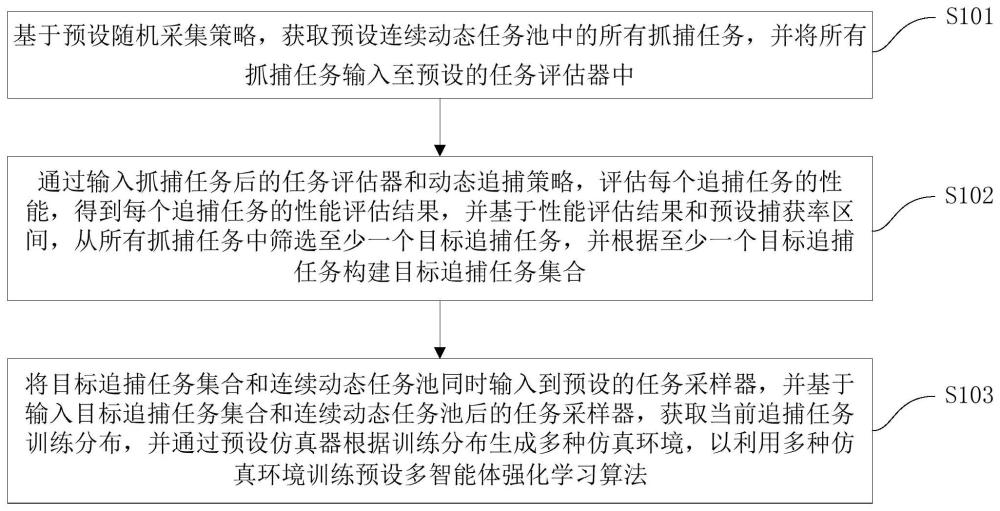

2、本技术第一方面实施例提供一种基于强化学习的多智能体动态追捕任务训练方法,包括以下步骤:基于预设随机采集策略,获取预设连续动态任务池中的所有抓捕任务,并将所述所有抓捕任务输入至预设的任务评估器中;通过输入抓捕任务后的任务评估器和动态追捕策略,评估每个追捕任务的性能,得到所述每个追捕任务的性能评估结果,并基于所述性能评估结果和预设捕获率区间,从所述所有抓捕任务中筛选至少一个目标追捕任务,并根据所述至少一个目标追捕任务构建目标追捕任务集合;将所述目标追捕任务集合和所述连续动态任务池同时输入到预设的任务采样器,并基于输入所述目标追捕任务集合和所述连续动态任务池后的所述任务采样器,获取当前追捕任务训练分布,并通过预设仿真器根据所述训练分布生成多种仿真环境,以利用所述多种仿真环境训练预设多智能体强化学习算法。

3、可选地,在本技术的一个实施例中,在通过输入抓捕任务后的任务评估器和动态追捕策略,评估每个追捕任务的性能,得到所述每个追捕任务的性能评估结果之前,还包括:获取所述每个追捕任务的配置信息,根据预设划分策略划分所述配置信息,得到所述每个追捕任务的配置划分结果;根据所述配置划分结果生成所述每个追捕任务的多个子任务,基于所述每个追捕任务的多个子任务,构建离散任务池。

4、可选地,在本技术的一个实施例中,所述通过输入抓捕任务后的任务评估器和动态追捕策略,评估每个追捕任务的性能,得到所述每个追捕任务的性能评估结果,并基于所述性能评估结果和预设捕获率区间,从所述所有抓捕任务中筛选至少一个目标追捕任务,包括:生成所述离散任务池中每个子任务对应的多种仿真环境,并根据所述动态追捕策略计算所述每个子任务的平均捕获率;当所述平均捕获率处于所述预设捕获率区间时,将所述平均捕获率对应的子任务存储至预设的课程存档中。

5、可选地,在本技术的一个实施例中,所述将所述目标追捕任务集合和所述连续动态任务池同时输入到预设的任务采样器,并基于输入所述目标追捕任务集合和所述连续动态任务池后的所述任务采样器,获取当前追捕任务训练分布,包括:基于所述预设连续动态任务池和所述课程存档,利用预设取样概率采集多个抓捕任务,并构建所述多个抓捕任务对应的训练分布。

6、本技术第二方面实施例提供一种基于强化学习的多智能体动态追捕任务训练装置,包括:获取模块,用于基于预设随机采集策略,获取预设连续动态任务池中的所有抓捕任务,并将所述所有抓捕任务输入至预设的任务评估器中;评估模块,用于通过输入抓捕任务后的任务评估器和动态追捕策略,评估每个追捕任务的性能,得到所述每个追捕任务的性能评估结果,并基于所述性能评估结果和预设捕获率区间,从所述所有抓捕任务中筛选至少一个目标追捕任务,并根据所述至少一个目标追捕任务构建目标追捕任务集合;生成模块,用于将所述目标追捕任务集合和所述连续动态任务池同时输入到预设的任务采样器,并基于输入所述目标追捕任务集合和所述连续动态任务池后的所述任务采样器,获取当前追捕任务训练分布,并通过预设仿真器根据所述训练分布生成多种仿真环境,以利用所述多种仿真环境训练预设多智能体强化学习算法。

7、可选地,在本技术的一个实施例中,还包括:划分模块,用于在通过输入抓捕任务后的任务评估器和动态追捕策略,评估每个追捕任务的性能,得到所述每个追捕任务的性能评估结果之前获取所述每个追捕任务的配置信息,根据预设划分策略划分所述配置信息,得到所述每个追捕任务的配置划分结果;构建模块,用于根据所述配置划分结果生成所述每个追捕任务的多个子任务,基于所述每个追捕任务的多个子任务,构建离散任务池。

8、可选地,在本技术的一个实施例中,所述评估模块包括:计算单元,用于生成所述离散任务池中每个子任务对应的多种仿真环境,并根据所述动态追捕策略计算所述每个子任务的平均捕获率;存储单元,用于当所述平均捕获率处于所述预设捕获率区间时,将所述平均捕获率对应的子任务存储至预设的课程存档中。

9、可选地,在本技术的一个实施例中,所述生成模块包括:采集单元,用于基于所述预设连续动态任务池和所述课程存档,利用预设取样概率采集多个抓捕任务,并构建所述多个抓捕任务对应的训练分布。

10、本技术第三方面实施例提供一种电子设备,包括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,所述处理器执行所述程序,以实现如上述实施例所述的基于强化学习的多智能体动态追捕任务训练方法。

11、本技术第四方面实施例提供一种计算机可读存储介质,所述计算机可读存储介质存储计算机程序,该程序被处理器执行时实现如上的基于强化学习的多智能体动态追捕任务训练方法。

12、由此,本技术的实施例具有以下有益效果:

13、本技术的实施例可通过基于预设随机采集策略,获取预设连续动态任务池中的所有抓捕任务,并将所有抓捕任务输入至预设的任务评估器中;通过输入抓捕任务后的任务评估器和动态追捕策略,评估每个追捕任务的性能,得到每个追捕任务的性能评估结果,并基于性能评估结果和预设捕获率区间,从所有抓捕任务中筛选至少一个目标追捕任务,并根据至少一个目标追捕任务构建目标追捕任务集合;将目标追捕任务集合和连续动态任务池同时输入到预设的任务采样器,并基于输入目标追捕任务集合和连续动态任务池后的任务采样器,获取当前追捕任务训练分布,并通过预设仿真器根据训练分布生成多种仿真环境,以利用多种仿真环境训练预设多智能体强化学习算法。本技术通过课程学习技术,合理地规划了训练样本的分布,提升了训练效率,极大地缩短了训练时长,并且应用于动态变化的任务场景,此外,本技术还可提升追捕之间的合作性和鲁棒性,极大降低了任务初始条件对性能的影响。由此,解决了现有技术仅研究环境复杂度低的二维追捕任务,且缺少多个追捕者之间的合作性,性能受到任务初始条件的严重影响,或者存在样本效率低、训练时间长、应用局限性较大等问题。

14、本技术附加的方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本技术的实践了解到。

- 还没有人留言评论。精彩留言会获得点赞!