一种基于多模态对比学习的场景图生成方法

本发明属于场景图生成,特别涉及一种基于多模态对比学习的场景图生成方法。

背景技术:

1、计算机视觉的最终目标是构建一个智能系统,它能够像人类一样从数字图像、视频或其他形式中提取有价值的信息。在过去的几十年里,机器学习为计算机视觉的发展做出了巨大的贡献。受人类能够轻松解读和理解视觉场景能力的启发,视觉场景理解一直被推崇为计算机视觉的圣杯,并引起了研究界的广泛关注。近年来,深度学习技术在通用目标检测领域取得了显著的突破,不仅推动了机器学习在计算机视觉中的应用,而且为计算机视觉带来了许多场景理解任务的新机会。场景图,因其强大的语义表达能力,在场景理解中的应用尤为显眼,迅速成为了研究的热点。场景图作为一种结构化的表达形式,能够揭示图像中物体的存在以及物体之间的相互关系。

2、现有的场景图生成技术,如基于多层级注意力机制的场景图生成方法(申请号2023108723154);基本上是集中于从图像中提取主体、宾体及其之间的视觉关系,这是通过图像的视觉特征或基于单一视觉概念进行的。

3、但这些方法存在缺陷和不足之处。首先,它们大多只关注图像的视觉信息,而忽略了与图像相关的自然语言描述,这导致了生成的场景图可能缺乏深度和语境的理解。其次,目前许多方法都使用的是监督训练方式,有着不小的人工成本。此外,许多传统方法在处理复杂的图像场景时,可能会遇到识别错误或关系判定不准确的问题。

技术实现思路

1、为了克服上述现有技术的不足,本发明的目的在于提供一种基于多模态对比学习的场景图生成方法,该方法致力于融合图像和与图像相关的自然语言描述,从而生成更准确的场景图;该方法具有多模态融合、综合语义理解的特点。

2、为了实现上述目的,本发明采用的技术方案是:

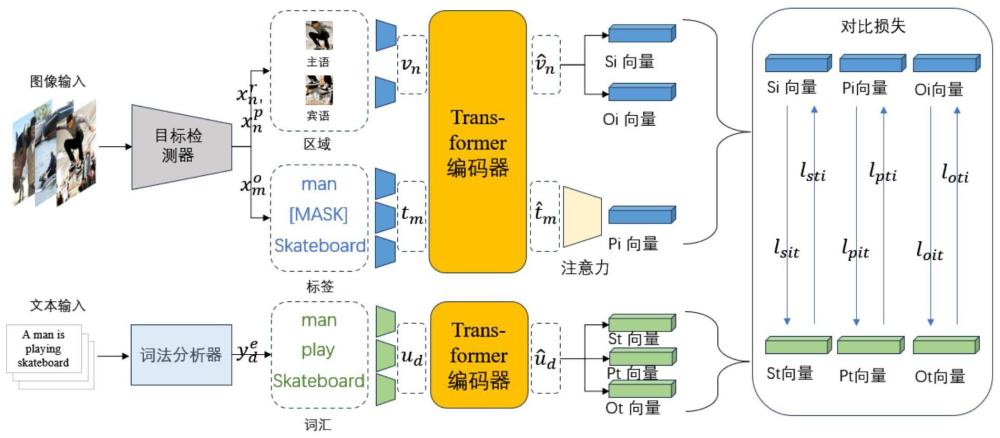

3、一种基于多模态对比学习的场景图生成方法,包括以下步骤:

4、步骤1:输入处理:

5、提取图像中每个区域的视觉特征位置特征和标签特征图像为jpg格式的图片,区域由目标检测器提供,它能对图像自动的提取出实体区域,对于图像相关的自然语言描述,即对图像内容的文字性解释(公开数据集中每个图片自带的图片说明,图像是单模态的,多模态是从此方法结合了图像与文本两种模态信息形成的场景图生成方法体现的),执行基础的文本预处理操作;

6、步骤2:嵌入器的构建,嵌入器分为视觉嵌入器、标签嵌入器和文本嵌入器;

7、2.1:视觉嵌入器将所有目标检测器提取的区域的所述的视觉特征和位置特征转化为统一的高维空间;

8、2.2:标签嵌入器接受主语区域和宾语区域的区域标签(目标检测器提取的每个区域都会有一个标签词,比如一个区域内实体为一个车,标签词就是car)的词嵌入和特殊词“mask”的词嵌入;

9、2.3:针对从与图像相关的自然语言描述中提取的主语、宾语和谓语,将文本信息转化为统一高维空间的文本嵌入器。

10、步骤3:特征编码与融合:

11、采用transformer编码器进行提取和整合所述步骤2得到的视觉和文本信息;这是一个深层的自注意力网络结构,它能够有效地捕捉输入特征之间的长距离依赖关系。

12、步骤4:对比学习训练,通过损失函数对编码器参数进行调优,最终的结果从图像和文本中提取信息后构建生成的场景图。

13、所述步骤1中,提取图像具体为:faster r-cnn检测器在图像中检测实体,通过卷积神经网络提取图像特征,然后使用候选区域提取器生成可能包含物体的候选边界框,并进行目标分类,确定边界框中的物体类别和位置信息,检测后的实体信息进一步用于多模态对比学习的场景图生成方法中,以建立图像和文本描述之间的联系。

14、所述文本预处理操作为分词、小写化;随后,使用spacy工具对预处理操作后的数据即进行分词、小写化操作的文本进行句法分析,将句子中的主谓宾结构抽取出来,从句法分析中得到的主谓宾词汇会通过预训练好的bert模型得到词嵌入y指代从文本中得到的数据,e代表嵌入,d是指共有d个数据。

15、所述步骤2.1具体为,将图像区域的视觉特征和位置特征转换为一个嵌入vn,其中n索引所有区域特征,包括主语(k)、宾语(l);公式为:

16、

17、其中,wr和wp是两个学习参数矩阵,表示一个区域的类型嵌入,ln代表层归一化操作,用于稳定网络训练。

18、所述步骤2.2具体为:

19、(1)主语区域和宾语区域的区域标签的词嵌入

20、(2)特殊词“mask”的词嵌入,记为表示缺失的谓语,该标签嵌入器将输入词嵌入和位置嵌入编码为标签嵌入tm,公式如下:

21、和都属于m包含p、k、l;

22、we是一个学习参数矩阵,表示当前令牌的位置嵌入,该标签嵌入器的目的是将标签信息也编码为统一的高维空间。

23、所述步骤2.3的公式如下:

24、

25、wf是可学习参数矩阵,表示当前令牌的位置嵌入。

26、所述步骤3具体为:对于所述步骤2得到的视觉嵌入vn、标签嵌入tm和文本嵌入ud,分别输入到transformer编码器中,并得到融合了上下文信息的新的嵌入和和上标代表经过transformer处理得到与处理之前的嵌入区别开,右下标代表各自的数据量,比如是从0-n。

27、所述transformer编码器为所有输入令牌之间传递消息。

28、进一步的,通过特征融合策略来整合所述信息,公式如下:

29、文本主语:

30、文本宾语:

31、文本谓语:

32、图像主语:

33、图像宾语:

34、其中,等式左边的spo代表主语谓语宾语,下标t、i代表文本、图像;等式右边依次从上到下是指经过编码器输出的嵌入,右下标k、l、p分别指主语类型、宾语类型、谓语类型;下面同理,其中,ws、wo、wv、wv都是可学习的参数矩阵。

35、特别地,为图像的谓语特征融合引入了注意力机制;具体地:

36、

37、

38、图像谓语:pi=softmax(scores)vs+softmax(scoreo)vo

39、与上一段解释同理,第二排的右上标表示转置,其中,wtq、wsk、wok、wsv、wov是可学习的参数矩阵,dk是键的维度,除以是为了稳定训练,防止权重过大。

40、所述步骤4具体为:在训练阶段,利用对比学习策略来调整模型权重,让模型尽量拉近正样本的距离,同时推远负样本的距离,从训练数据中抽取一个小批量的n个输入对(image,text),并分别计算spo的表示对(av,an,),a包含s,p,o;输入对(image,text)就是输入的图像和文本,spo就是指代主谓宾三元组,就是(sv,sn)(ov,on)(pv,pn),spo代表主语谓语宾语,上标v代表图像,n代表文本,训练目标包含三组损失函数,第一组损耗函数的第i对图像-文本对比损失为:

41、

42、其中,i下标代表第i对,sit代表这个损失计算的是主语-从图片到文本的损失,同理下面损失代表主语-从文本到图像;公式中分别代表第i对中的图像主语和文本主语,是第k对文本主语;其中<>是指计算余弦相似度,τ是可调超参;

43、同理,第i对文本-图像对比损失为:

44、

45、主语综合损失如下:

46、

47、λ是可调参数,通过控制从图像到文本和文本到图像的重要性,值越大图像到文本越重要,其他与上同理;

48、后两组对比损失和第一组对比损失设计同理,得到谓语综合损失及宾语综合损失

49、最终复合损失函数为:

50、

51、其中,λs、λp、λo之和为1,用于调控三个损失的重要;最终的结果从图像和文本中提取信息后构建生成的场景图(scene graph),是一种图结构。

52、本发明应用于对象的遮挡、小物体的存在、背景的噪声;能够准确地识别物体和关系,生成高质量的场景图。

53、本发明的有益效果:

54、1.全面融合多模态信息:与传统的仅依赖图像视觉信息的方法不同,本发明结合了图像和与图像相关的自然语言描述。这种多模态信息融合使得模型能够从多个角度理解图像,从而生成更为丰富和准确的场景图。

55、2.适应复杂场景:由于采用了深度学习技术和transformer架构,本发明在处理复杂的图像场景时具有很强的鲁棒性。

56、3.减少对人工的依赖:本发明采用了对比学习框架,它不依赖于传统意义上的标注数据,模型自动从未标注的数据中生成其自身的伪标签,并被训练以明确区分正样本和负样本,强化它们之间的差异性。这种学习策略大大减少了对人工标注的依赖,从而降低了场景图生成的成本和难度。

57、4.开放性和扩展性:本发明设计上具有很强的开放性和扩展性。可以将新的数据或模块集成到现有系统中,从而持续地提高其性能和适应性。

- 还没有人留言评论。精彩留言会获得点赞!