基于耀斑掩码引导和多感受野感知的图像耀斑去除方法

本发明涉及图像处理以及计算机视觉,尤其是基于耀斑掩码引导和多感受野感知的图像耀斑去除方法。

背景技术:

1、耀斑是一种常见的光学现象,当强光在镜头系统内发生散射或反射时,会在拍摄的照片中产生独特的放射状亮区和光斑,这便是耀斑。耀斑现象可能会导致低对比度和抑制光源周围的细节,降低图像的视觉质量和视觉算法的性能。以空中物体跟踪为例,由透镜耀斑引入的亮点容易误导算法跟踪耀斑而不是飞行物体。而且在监控镜头、智能手机摄像头、无人机和自动驾驶摄像头等移动的平台中,日常磨损、指纹和灰尘会起到光栅的作用,加剧镜头耀斑,使其严重影响这些平台的性能,所以从图像中去除耀斑对于提高户外的计算机视觉系统的适用性和稳定性具有重要的研究意义。另外,耀斑图案取决于透镜的光学特性、透镜保护玻璃、红外截止玻璃、光源的位置和强度、制造缺陷、划痕和日常使用中积累的灰尘。正是因为耀斑的成因多种多样,表现形式也多种多样。典型的耀斑包括光晕、条纹、亮线、饱和点、反射等。这种多样性使得去除耀斑成为一个十分具有挑战性的问题。

2、目前图像耀斑去除方案大体上被分为三大类,即硬件解决方案、软件解决方案以及数据驱动解决方案。大多数硬件解决方案侧重于改善相机的光学系统以消除耀斑,例如优化的透镜镜筒设计、透镜罩或反射涂层。广泛使用的技术是在透镜元件上施加抗反射涂层,以通过破坏干涉来减少内部反射。但是在此情况下,抗反射涂层添加到所有光学表面是昂贵的,并且这种涂层的厚度只能针对特定波长和入射角进行优化。此外,它们只能在捕获过程中减少耀斑,但不能处理耀斑现有图像,并且这些硬件解决方案很难消除整个耀斑。许多基于软件的解决方案,基本上是两阶段方法:首先识别耀斑,然后修复耀斑区域的场景。例如,采用一系列阈值对图像进行二值化,计算二值化后图像的轮廓特征,得到一系列潜在耀斑候选区域,并对这些候选区域进行重建。但基于软件的方法仅适用于有限类型的耀斑,容易将局部亮区作为耀斑处理,难以区分不同类型的耀斑。数据驱动解决方案则是通过深度学习的方法,利用大量的数据来训练神经网络,使得神经网络可以从这些数据中学习到各种各样的耀斑特征,以能够较好地进行耀斑去除。

技术实现思路

1、本发明提出基于耀斑掩码引导和多感受野感知的图像耀斑去除方法,能有效去除耀斑图像上的耀斑。

2、本发明采用以下技术方案。

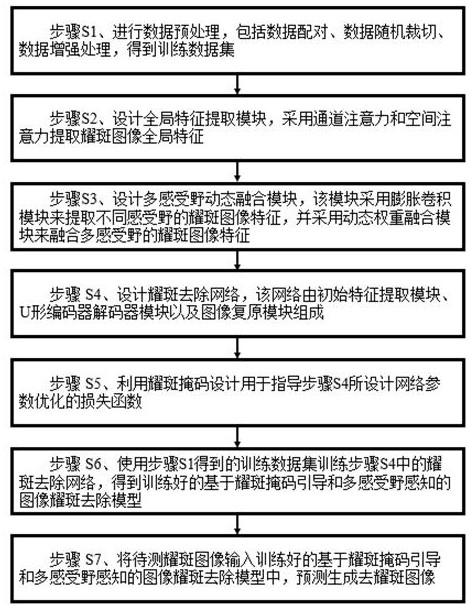

3、基于耀斑掩码引导和多感受野感知的图像耀斑去除方法,包括以下步骤:步骤s1、收集耀斑图像并进行数据预处理,预处理方法包括数据配对、数据随机裁切、数据增强处理,得到训练数据集;

4、步骤s2、设计全局特征提取模块,采用通道注意力和空间注意力提取耀斑图像全局特征;

5、步骤s3、设计多感受野动态融合模块,该模块采用膨胀卷积模块来提取不同感受野的耀斑图像特征,并采用动态权重融合模块来融合多感受野的耀斑图像特征;

6、步骤s4、设计耀斑去除网络,该网络由初始特征提取模块、u形编码器解码器模块以及图像复原模块组成;

7、步骤s5、利用耀斑掩码设计用于指导步骤s4所设计网络参数优化的损失函数;

8、步骤s6、使用步骤s1得到的训练数据集训练步骤s4中的耀斑去除网络,得到训练好的基于耀斑掩码引导和多感受野感知的图像耀斑去除模型;

9、步骤s7、将待测耀斑图像输入训练好的基于耀斑掩码引导和多感受野感知的图像耀斑去除模型中,预测生成去耀斑图像。

10、步骤s1的具体实现步骤如下:

11、步骤s11、根据数据集中所提供的耀斑图、光源图和背景图生成配对的耀斑图像、带有光源的干净图像以及耀斑掩码;

12、步骤s12、将每张尺寸为h×w×3的耀斑图像随机裁切为p×p×3大小的图像,并对其对应的带有光源的干净图像以及耀斑掩码采用相同的随机裁切方式,其中,h、w是耀斑图像的高度和宽度,p是裁切出图像的高度和宽度;

13、步骤s13、随机采用以下8种中的1种增强方式对待训练配对图像进行数据增强:保持原始图像、垂直翻转、旋转90度、旋转90度后垂直翻转、旋转180度、旋转180度后垂直翻转、旋转270度、旋转270度后垂直翻转。

14、步骤s2的具体实现步骤如下:

15、步骤s21、设计通道注意力模块,输入图像特征经过gelu激活函数、自适应平均池化adaptiveavgpool、1×1卷积、gelu激活函数、1×1卷积和sigmoid激活函数得到通道注意力权重attc,与attc相乘得到通道注意力加权后的特征具体公式表示如下:

16、其中,gelu(*)表示gelu激活函数,sigmoid(*)表示sigmoid激活函数,adaptiveavgpool(*)表示自适应平均池化,conv1×1(*)表示卷积核大小为1×1的卷积层,attc表示通道注意力权重;

17、步骤s22、设计空间注意力模块,输入图像特征经过3×3卷积、1×1卷积、gelu激活函数、1×1卷积和sigmoid激活函数得到空间注意力权重atts,与atts相乘得到空间注意力加权后的特征具体公式表示如下:

18、

19、

20、其中,gelu(*)表示gelu激活函数,sigmoid(*)表示sigmoid激活函数,conv1×1(*)表示卷积核大小为1×1的卷积层,conv3×3(*)表示卷积核大小为3×3的卷积层,atts表示空间注意力权重;

21、步骤s23、设计全局特征提取模块,输入图像特征经过groupnorm层、步骤s21的通道注意力模块和步骤s22的空间注意力模块后与相加得到特征经过groupnorm层、3×3卷积、1×1卷积和gelu激活函数后与相加得到输出特征具体公式表示如下:

22、

23、

24、其中,gelu(*)表示gelu激活函数,conv1×1(*)表示卷积核大小为1×1的卷积层,conv3×3(*)表示卷积核大小为3×3的卷积层,groupnorm(*)表示组归一化层,cam(*)表示步骤s21的通道注意力模块,sam(*)表示步骤s22的空间注意力模块。

25、步骤s3的具体实现步骤如下:

26、步骤s31、设计膨胀卷积模块,输入图像特征分别经扩张率为2、4、8的膨胀卷积和gelu激活函数得到输出特征fdial1,fdial2,fdial3(fdial1,fdial2,),具体公式表示如下:

27、

28、

29、

30、其中,gelu(*)表示gelu激活函数,dilatedr=2(*)表示扩张率为2的膨胀卷积,dilatedr=4(*)表示扩张率为4的膨胀卷积,dilatedr=8(*)表示扩张率为8的膨胀卷积;

31、步骤s32、设计动态权重融合模块,输入为步骤s31中的3个膨胀卷积模块的输出特征fdial1,fdial2,fdial3,将这3个特征分别经过自适应平均池化adaptiveavgpool后在通道维度经过cat拼接函数拼接得到特征将经过1×1卷积、lelu激活函数、1×1卷积、gelu激活函数、1×1卷积和sigmoid激活函数得到特征fconv,fconv在通道维度经过chunk分割函数分割生成3个动态特征权重w1,w2,w3(w1,w2,,将3个膨胀卷积模块输出特征fdial1,fdial2,fdial3分别和3个动态特征权重w1,w2,w3相乘后相加得到输出特征ffusion,具体公式表示如下:

32、

33、

34、w1,w2,w3=chunk(fconv)

35、ffusion=fdial1×w1+fdial2×w2+fdial3×w3

36、其中,gelu(*)表示gelu激活函数,sigmoid(*)表示sigmoid激活函数,adaptiveavgpool(*)表示自适应平均池化,cat(*)表示拼接函数,chunk(*)表示分割函数,conv1×1(*)表示卷积核大小为1×1的卷积层,w1,w2,w3为3个动态特征权重;

37、步骤s33、设计多感受野动态融合模块,输入图像特征经过步骤s31中的膨胀卷积模块得到3个膨胀卷积模块输出特征fdial1,fdial2,fdial3,这3个特征经过步骤s32中的动态权重融合模块得到特征ffusion,将与ffusion相加得到输出特征

38、步骤s4的具体实现步骤如下:

39、步骤s41、设计初始特征提取模块,输入为耀斑图像iflars,iflars经过3×3卷积、gelu激活函数和3×3卷积得到初始特征finitial,具体公式表示如下:

40、finitial=conv3×3(gelu(conv3×3(iflare)))

41、其中,gelu(*)表示gelu激活函数,conv3×3(*)表示卷积核大小为3×3的卷积层;

42、步骤s42、设计u型编码器解码器模块中的编码器模块,输入为步骤s41中的初始特征finitial,finitial经过步骤s23中全局特征提取模块和步骤s33中多感受野动态融合模块得到编码特征e1,e1经过下采样、全局特征提取模块和多感受野动态融合模块得到编码特征e2,e2经过下采样、全局特征提取模块和多感受野动态融合模块得到编码特征e3,e3经过下采样、全局特征提取模块和多感受野动态融合模块得到编码特征e4,具体公式表示如下:

43、e1=mfdfm(gfem(finitial))

44、e2=mfdfm(gfem(downsample(e1)))

45、e3=mfdfm(gfem(downsample(e2)))

46、e4=mfdfm(gfem(downsample(e3)))

47、其中,gfem(*)是步骤s23中的全局特征提取模块,mfdfm(*)是步骤s33中的多感受野动态融合模块,downsample(*)是下采样操作;

48、步骤s43、设计u型编码器解码器模块中的解码器模块,输入为步骤s42中的编码特征e4,e4经过上采样再和编码特征e3相加,再通过步骤s23中全局特征提取模块和步骤s33中多感受野动态融合模块得到解码特征d3,d3经过上采样再和编码特征e2相加,再通过全局特征提取模块和多感受野动态融合模块得到解码特征d2,d2经过上采样再和编码特征e1相加,再通过全局特征提取模块和多感受野动态融合模块得到解码特征d1,具体公式表示如下:

49、d3=mfdfm(gfem(upsample(e4)+e3))

50、d2=mfdfm(gfem(upsample(d3)+e2))

51、d1=mfdfm(gfem(upsample(d2)+e1))

52、其中,gfem(*)是步骤s23中的全局特征提取模块,mfdfm(*)是步骤s33中的多感受野动态融合模块,upsample(*)是上采样操作;

53、步骤s44、设计图像复原模块,输入为步骤s43中的解码特征d1,d1经过3×3卷积、gelu激活函数和3×3卷积得到复原特征frestore,复原特征frestore和耀斑图像iflare相加得到最后的去耀斑图像ideflare,具体公式表示如下:

54、frestore=conv3×3(gelu(conv3×3(d1)))

55、ideflare=frestore+iflare

56、其中,gelu(*)表示gelu激活函数,conv3×3(*)表示卷积核大小为3×3的卷积层;

57、步骤s45、设计耀斑去除网络,网络的输入为耀斑图像iflare,iflare经过步骤s41中的初始特征提取模块得到finitial,finitial经过步骤s42和步骤s43的u型编码器和解码器得到解码特征d1,d1和iflare经过步骤s44的图像复原模块得到去耀斑图像ideflare,具体公式表示如下:

58、finitial=ifem(iflare)

59、d1=decoder(encoder(finitial))

60、ideflare=irm(d1,iflare)

61、其中,ifem(*)是步骤s41中的初始特征提取模块,encoder(*)是步骤s42中的编码器模块,decoder(*)是步骤s43中的解码器模块,irm(*)是步骤s44的图像复原模块。

62、步骤s5的具体实现方法如下:设计损失函数,由基本损失lbase和掩码损失lmask组成,网络的总目标损失函数l如下:

63、l=lbase+lmask

64、lbase=lchar_base+lssim_base+λlvgg_base

65、lmask=lchar_mask+lssim_mask+λlvgg_mask

66、lchar_bass=charloss(ideflare,iclear)

67、lssim_bass=1-ssim(ideflare,iclear)

68、lvgg_bass=vggloss(ideflare,iclear)

69、lchar_mask=charloss(ideflare×imask,iclear×imask)

70、lssim_mask=1-ssim(ideflare×imask,iclear×imask)

71、lvgg_mask=vggloss(ideflare×imask,iclear×imask)

72、其中,imask为耀斑掩码图像,ideflare为预测去耀斑图像,iclear为标签图像,charloss(*)为l1charbonnier损失函数,vggloss(*)为vgg感知损失函数,ssim(*)为结构相似性度量,λ表示为损失的权重,×表示逐元素乘法。

73、步骤s6的具体实现方法如下:按每个批次n对耀斑图像进行划分,将步骤s1中训练数据集划分为k个批次;将耀斑图像iflare输入步骤s4中的耀斑去除网络,得到去耀斑图像ideflare;利用步骤s5中设计的损失函数,计算去耀斑图像ideflare的损失;使用adam优化的方式更新网络参数,直至收敛,得到基于耀斑掩码引导和多感受野感知的图像耀斑去除模型。

74、本发明基于深度学习方法,提出的一种基于耀斑掩码引导和多感受野感知的图像耀斑去除方法,使用全局特征提取模块、多感受野动态融合模块和u型编码器解码器结构搭建去耀斑网络,以此提取图像中的耀斑特征,并通过耀斑掩码损失进行监督,引导去耀斑网络的训练,因此能获得更好的去耀斑效果。

- 还没有人留言评论。精彩留言会获得点赞!