基于多模态融合的端到端图像去雾方法

本发明涉及图像去雾,具体涉及基于多模态融合的端到端图像去雾方法。

背景技术:

1、大气中的雾霾严重降低了图像的成像质量,直接影响着目标检测、语义分割等上游任务的性能,因此图像去雾作为计算机视觉的底层任务,得到了学者的广泛关注。当前,单幅图像去雾算法主要分为两类:基于物理先验的参数估计方法和基于数据驱动的深度学习方法。其中,前者利用最大对比度先验、暗通道先验、颜色衰减先验、非局部先验等物理先验知识估计透射率和大气光照,并基于大气散射模型还原去雾后的图像;后者通过构建神经网络模型,在现有成对的雾图像数据集上进行训练,直接得到从雾图像到无雾图像的转化。由于红外波长较长,不易发生散射,可以穿透雾霾,因此一些研究者引入红外图像信息辅助去雾,利用其估计透射率,进一步还原去雾图像。

2、这些方法虽然在一定程度上都能实现去雾,但是当面临不均匀分布的浓雾场景时,它们的去雾性能都会下降。这是因为物理先验信息严重依赖图像的色彩空间特征,当图像某部分区域不满足该先验条件时,基于物理先验的参数估计算法便会失败。而受限于可见光图像提供的单模态信息,神经网络模型很难学习到图像更深层的特征,恢复的图像仍然会显示有残余雾,无法还原被浓雾遮挡的图像细节和色彩。尽管引入红外图像能够改善去雾效果,但是现有方法仅将红外图像作为辅助信息,既没有提取红外图像的深层特征,也没有考虑图像之间的互补融合,从而限制了去雾算法性能的进一步提升。

3、因此,目前迫切需要设计一种针对浓雾环境的多模态融合图像去雾算法,在可见光雾图像严重退化的情况下仍然能实现鲁棒的去雾性能。

技术实现思路

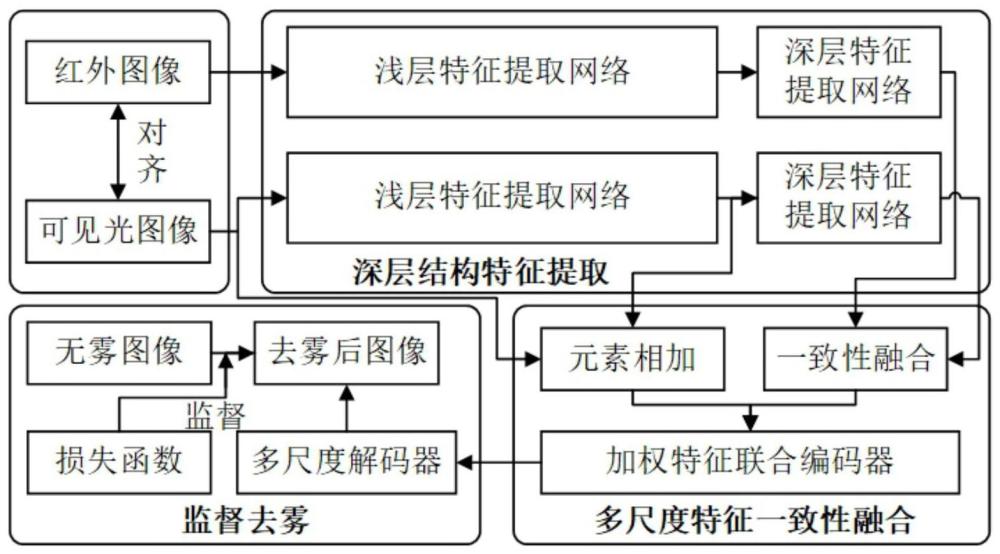

1、有鉴于此,本发明提供了基于多模态融合的端到端图像去雾方法,能够联合可见光图像和红外图像进行去雾,弥补了可见光单模态信息受限的缺点,即使在浓雾场景下本方法也可以实现鲁棒去雾。

2、为达到上述目的,本发明的技术方案包括如下步骤:

3、步骤一:获取雾天场景下像素对齐的可见光-红外图像对,并进行数据预处理得到输入图像张量。

4、步骤二:将输入图像张量输入到双分支深层结构特征提取网络中,分别提取可见光图像和红外图像的多尺度深层结构特征。

5、步骤三:对可见光图像和红外图像的多尺度深层结构特征进行一致性融合,同时对可见光原始图像和可见光图像的浅层特征元素相加,得到可见光图像的上下文特征,联合可见光图像的上下文特征和多模态融合特征进行加权融合编码,获得多尺度加权编码特征。

6、步骤四:对多尺度加权编码特征进行解码,重建恢复后的去雾后的图像,并计算去雾后的图像与真实的无雾图像之间的差异,利用组合损失函数监督训练得到多模态融合去雾模型,训练好的多模态融合去雾模型用于进行图像去雾。

7、进一步地,步骤一中,数据预处理过程包括如下操作:对图像进行大小重置,重置为预设的尺寸,然后进行张量归一化、随机旋转和裁剪。

8、进一步地,步骤二中,双分支深层结构特征提取网络具体包括红外分支网络和可见光分支网络,分别用于提取红外图像的深层结构特征和可见光图像的深层结构特征。

9、红外分支网络和可见光分支网络二者的网络结构相同,包括浅层特征提取网络和深层特征提取网络,分别用于提取浅层特征和深层特征。

10、浅层特征是指经过少于设定数量的卷积层网络提取的特征;深层特征是指在浅层特征的基础上,利用卷积层和下采样层结构进一步对特征进行拼接相加操作提取的特征。

11、进一步地,浅层特征提取网络包括顺次连接的卷积层、两个通道-像素注意力模块以及编码-解码器架构。

12、卷积层用于对输入图像张量进行卷积处理,获得卷积层特征图送入通道-像素注意力模块。

13、通道-像素注意力模块cpab包括通道注意力单元和像素注意力单元,其中通道注意力单元的组成顺次包括平均池化层、卷积层、激活函数层、卷积层、sigmoid函数层以及乘法器,其中通道注意力单元的乘法器的另一输入为通道注意力单元的原始输入;通道注意力单元的输出作为像素注意力单元的原始输入。

14、像素注意力单元的组成顺次包括卷积层、激活函数层、卷积层、sigmoid函数层以及乘法器,其中像素注意力单元的乘法器的另一输入为像素注意力单元的原始输入。

15、卷积层特征图经过两个通道-像素注意力模块,获得浅卷积层特征,作为编码-解码器架构的输入。

16、编码-解码器架构采用跳跃连接将浅卷积层特征引入到上采样过程中,最终获得多个尺度的浅层特征。

17、编码-解码器架构的组成采用u型网络结构,顺次包括第一个下采样单元、第二个下采样单元、卷积单元、第一个上采样单元和第二个上采样单元;其中下采样单元由通道-像素注意力模块cpab层、下采样层和卷积层组成、上采样单元由通道相加层、上采样层以及cpab层组成;卷积单元由在一个卷积层的前后分别嵌入一个cpab层;其中第一个下采样单元跳跃连接第二个上采样单元、第二个下采样单元跳跃连接第一个上采样单元;cpab层与通道-像素注意力模块结构相同。

18、进一步地,深层特征提取网络包括拼接模块、通道-像素注意力模块、下采样模块、卷积层以及sigmoid函数层;拼接模块对同一个尺度的编码器输出特征和解码器输出特征进行拼接,作为该尺度的特征拼接图;利用通道-像素注意力模块计算每个尺度的特征拼接图的权重,最后每个尺度的特征拼接图通过一个卷积层和一个sigmoid激活函数层,得到了对应每个尺度的深层结构特征。

19、进一步地,步骤三包括如下内容:

20、应用不一致函数fi(·,·)来计算融合权值;其中可见光图像的多尺度深层结构特征表示为红外图像的多尺度深层结构特征则第i个尺度的不一致结构特征权值为:

21、

22、其中,α、β分别表示深层结构特征对应和逆运算的深层结构特征的权重。分别表示对进行逆运算;为融合权值。

23、其次,将可见光图像的第i个尺度的深层结构特征与融合权值fi相乘,得到多模块融合特征fi。

24、将可见光图像上下文特征和多模态融合特征输入至加权特征联合编码器进行加权融合编码,获得多尺度加权编码特征。

25、进一步地,加权特征联合编码器对可见光模态的上下文特征应用通道-像素注意力模块cpab,并与相同尺度的加权结构特征进行元素相加,经过下采样操作后输入下一个通道-像素注意力模块cpab,将以上流程重复两次,得到多尺度的加权编码特征fi′,i=1,2,3。

26、进一步地,步骤四中,对多尺度加权编码特征进行解码,重建恢复后的去雾后的图像具体为:

27、采用多尺度解码器对对多尺度加权编码特征进行解码,重建恢复后的去雾后的图像对步骤三经过三次下采样后得到的编码特征应用通道-像素注意力模块cpab,并与相同尺度的加权编码特征经过卷积后进行元素相加,经过上采样操作后输入下一个通道-像素注意力模块cpab,将以上流程重复两次,得到恢复后的去雾后的图像。

28、进一步地,步骤四中,计算去雾后的图像与真实的无雾图像之间的差异,利用组合损失函数监督训练得到多模态融合去雾模型,训练好的多模态融合去雾模型用于进行图像去雾,具体为:

29、使用均值方差损失函数l1比较真实无雾图像y和去雾后的图像x在像素空间的差异。

30、采用多尺度结构相似指数ms-ssim损失函数对模糊边界赋予更高的权重,多尺度结构相似指数损失函数损失lm函数定义为:

31、

32、其中,m为尺度总数,μx、μy和σx、σy分别为x和y的均值和标准差;参数βm和γm表示两个成分在每个尺度中的相对重要性,取值在0-1之间;c1和c2为预设的两个常数。

33、引入dice loss作为训练的损失函数之一,定义为ldice:

34、

35、其中i表示图像的第i个通道,和表示通过sobel算子得到的去雾后的图像和真实无雾图像的二值化边缘映射;对于每个通道,dice损失计算如下:

36、

37、其中和分别为去雾后的图像和真实无雾图像上的第j个像素,c3为常数。

38、通过结合均方差损失l1、ms-ssim损失lm和边缘损失ldice,设置训练阶段的组合损失函数表示为:

39、lall=λ1·l1+λ2·lm+λ3·ldice

40、其中,λ1、λ2、λ3分别为相应的系数。

41、利用组合损失函数监督训练得到多模态融合去雾模型,训练好的多模态融合去雾模型用于进行图像去雾。

42、有益效果:

43、1、本发明提供的一种基于多模态融合的端到端图像去雾方法,构建了可见光-红外模态融合的端到端图像去雾模型,包括深层结构特征提取、多尺度特征一致性融合和监督去雾三个模块。遵循由粗到精的特征提取方法,逐渐提取两种模态的深层结构特征,充分利用上下文信息挖掘了模态的深层特征。基于图像像素相乘增强对比度的性质,提出一致性融合策略,互补各模态的优势所在。本发明还设计了像素级-结构级的组合损失函数,使得模型在训练阶段能更关注多尺度结构特征和边界信息。相比于单模态去雾方法,本方法联合红外图像进行去雾,弥补了可见光单模态信息受限的缺点,由于红外图像不易收到天气的影响,即使在浓雾场景下本方法也可以实现鲁棒去雾。

44、2、本发明提供的基于多模态融合的端到端图像去雾方法,相比于红外模态作为辅助信息的去雾方法,本方法利用深层特征提取网络充分挖掘各模态的深层结构特征,并利用不一致性结构函数计算两模态结构特征的差异,有利于多模态之间更好的优势互补融合,显著提升了图像去雾的性能。

- 还没有人留言评论。精彩留言会获得点赞!