一种基于采样多头自注意力的高效多器官分割方法

本发明涉及医学图像分割,具体指一种基于采样多头自注意力的高效多器官分割方法。

背景技术:

1、在图像分析领域,人工智能(ai)方法在医学图像分析中的应用在计算机辅助诊断中显示出越来越重要的作用。医学图像分割在医学图像处理领域扮演着至关重要的角色,因为它在促进疾病诊断和制定治疗策略方面发挥着关键作用。近年来,由于深度学习算法的快速发展,卷积神经网络(cnn)和transformer已经成为医学辅助分析的两个主要研究方向。这两种方法都具有独特的优势,为解决复杂的医学图像分割挑战提供了新的可能性。u-net是一个典型的纯cnn网络,其由上采样、下采样和跳过连接组成,在多器官分割和皮肤损伤分割等各个领域展现出强大的低复杂度性能,在医学图像分割领域确立了其独特的地位。

2、然而,在医学图像分析中,cnn的应用仍然面临一些挑战。这是因为医学图像通常包含跨越大区域的上下文信息,而cnn在有效捕获远距离相关性方面存在一些限制,这可能导致忽略详细信息,从而影响分割精度。

3、为了克服这个问题,基于自注意力机制的transformer模型引起了广泛的关注。transformer在自然语言处理方面取得了显著的成功,它具有出色的远程依赖建模能力,并已成功引入到计算机视觉领域,在图像分割任务中取得了显著的成就。与cnn不同,transformer在医学图像分割方面具有几个显著的优点:首先,transformer能够捕捉图像中像素之间的全局依赖性,从而更好地理解整体结构。其次,transformer提供了更高的灵活性。传统的cnn模型通常需要人工设计网络结构,而transformer模型可以通过简单的修改来适应不同的任务,因此在处理各种视觉任务时更加灵活。研究人员如cao等人甚至进一步将swin transformer整合到医学图像分割中,用transformer网络替代了解码器和编码器,构建了一个完全基于transformer的u型网络。

4、尽管与cnn相比,transformer具有这些显著的优势,但也存在一个明显的缺陷:基于transformer的网络通常比cnn网络计算效率低,从而导致了高昂的计算成本。因此,如何有效地利用transformer模型成为一个关键问题。

5、面对transformer天然的计算限制,越来越多的研究人员开始探索更高效的基于transformer的unet架构。huang等人提出了missformer,他们重新设计了编码器结构中的前馈网络,以促进更高效的局部和全局上下文特征提取。以往的基于transformer的unet架构大多要么结合了cnn和transformer,要么完全采用了纯transformer结构。尽管它们可以在一定程度上保持局部和全局特征建模,但通常会带来高昂的计算成本和模型参数。

技术实现思路

1、本发明旨在提供一种基于采样多头自注意力的高效多器官分割方法,构建了一种基于局部-全局特征级联的非对称cnn-transformer网络,解决了基于transformer的腹部多器官分割模型的运算效率问题。

2、为了解决上述技术问题,本发明的技术方案为:

3、一种基于采样多头自注意力的高效多器官分割方法,包括如下步骤:

4、步骤1、腹部多器官ct数据集获取以及预处理,将3d体素数据转化为2d格式数据;

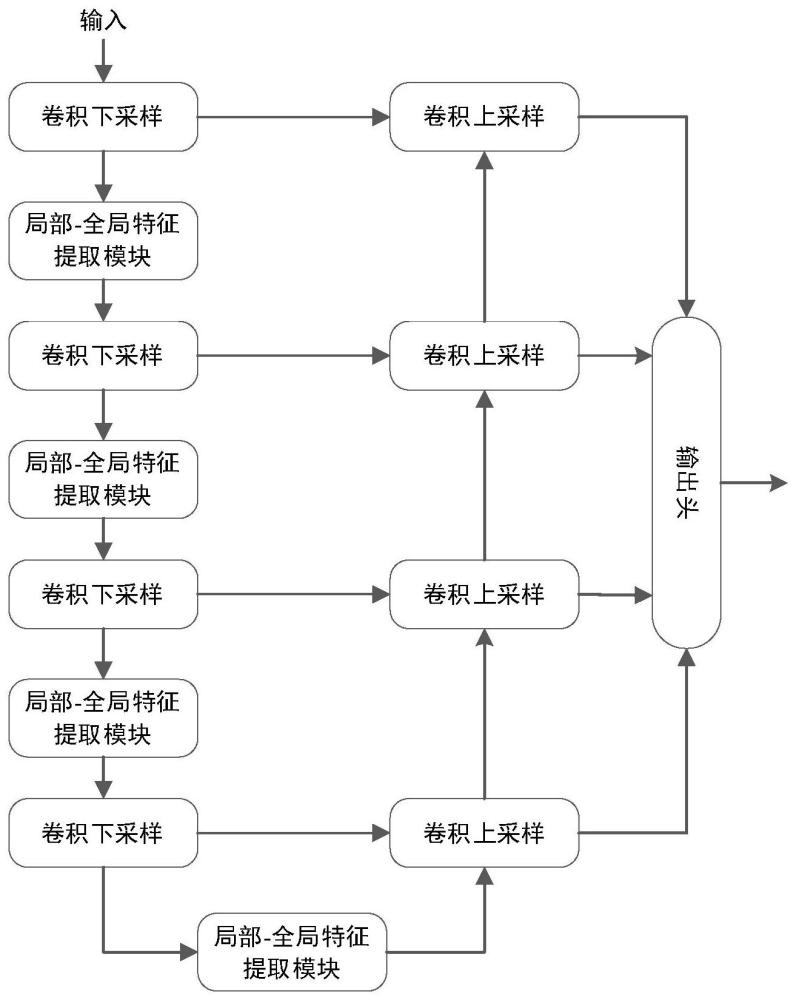

5、步骤2、搭建特征提取网络,所述特征提取网络包括编码器模块、解码器模块和输出头,所述编码器模块由多层编码器叠加而成,所述解码器模块由多层解码器叠加而成;

6、步骤3、设计训练范式,构造用于网络训练的多目标优化损失函数;

7、步骤4、将预处理好的数据放入网络训练模型,使用训练完成的模型推理,实现不同种类器官的分割。

8、作为优选,所述步骤1包括:

9、步骤1.1通过切片的方法将3d体素信息转化为2d切片格式的信息,每个受试者的3d体素信息切成85-195片2d像素信息,统一成224×224像素的图像,维度为512×512;

10、步骤1.2为了加快运行速度,将2d切片的图像信息保存为npy文件,随后通过翻转、旋转以及阈值化处理来增强此2d切片数据的多样性。

11、作为优选,所述步骤2包括:

12、步骤2.1搭建编码器;

13、编码器由卷积模块、下采样模块和基于采样多头自注意力的transformer局部-全局特征提取模块,卷积模块的主体为两层卷积神经网络,卷积核大小均为3×3,每层卷积后为批归一化操作和leakyrelu函数,两层卷积之间加入dropout操作防止模型过拟合,下采样模块为一层最大池化层;

14、步骤2.2搭建解码器;

15、解码器由基本的卷积模块和上采样模块构成来融合来自编码器的多层特征。类似的,卷积模块采用和编码器卷积模块一样的结构,上采样操作由标准的上采样模块实现。

16、步骤2.3网络的输出由多层解码器的输出融合得到,来自多层解码端的特征图通过线性插值的方法统一大小,最后加和作为网络最终的输出。

17、作为优选,搭建基于采样多头自注意力的局部-全局特征提取模块;

18、该模块由两部分构成,使用三层带残差的卷积操作获取局部特征信息,使用采样多头自注意力模块获取全局特征信息,采样多头自注意力模块为改进的transformer模块,首先经过使用随机采样的补丁进行自注意力操作,然后使用一层反卷积操作来恢复特征图大小,该基于采样多头自注意力的局部-全局特征提取模块可表示为:

19、x=localaggregation(xin)+xin (1)

20、y=cmlp(x)+x (2)

21、z=transconv(globalsparseattention(y))+y (3)

22、xout=mlp(z)+z (4)

23、其中,xin、xout分别表示局部-全局特征提取模块的输入和输出特征图,y和z表示中间过程产生的特征图,localaggregation代表局部网络聚合模块,cmlp为带有卷积操作的多层感知机,transconv为反卷积模块,globalsparseattention为采样的多头自注意力模块,mlp为多层感知机。

24、作为优选,构造多目标优化的损失函数;

25、总损失函数l如下式

26、l=α*celoss+β*ohemloss+γ*lovaszsoftmaxloss (5)

27、参数α、β和γ为设置的超参数,celoss为交叉熵损失,衡量分类性能,lovaszsoftmax loss为改良的iou损失,iou损失的公式如下,

28、

29、其中c为类别总数,e函数将模型输出映射为关于第c类的概率分布,j函数计算有关第c类的jaccard系数。

30、使用基于子模损失的凸lovász扩张策略改进iou损失,该损失可以使训练出的模型在iou指标方面表现得更好。最后使用ohem微调,增强模型对困难样本的学习能力,该ohem损失通过筛选训练批次里的交叉熵损失,保留损失较大的样本作为困难样本,在原来损失的基础上加入困难样本的损失,ohem损失可以描述为:

31、

32、

33、ltotal=lorg+lre (9)

34、其中li为第i批数据产生的损失,总共有n个批次的损失,lorg为所有样本产生的交叉熵损失,在此基础上选取损失较大的k个批次困难样本的损失计算lre,ltotal为总体的ohem损失。

35、作为优选,步骤4包括:

36、将多器官ct数据集切片处理后输入到训练好的网络中,网络输出同样大小的特征预测图,根据每个像素点的阈值范围划分出每个点的类别信息,由此得到分割后的视图。

37、本发明具有以下的特点和有益效果:

38、采用上述技术方案,通过改进多头自注意力操作,使用采样补丁计算自注意力,大大降低了模型的运算成本,构建了一种u型transformer的图像分割网络,在编码阶段的多层cnn和transformer结构,从局部特征和全局特征两个维度增强模型的特征提取能力,非对称的结构又使得网络在解码阶段并未引入transformer结构,直接利用来自编码器获得的多尺度特征,简化了整体网络结构。在训练阶段的多目标优化函数可以使得模型在多个目标指导下同时优化,实现更好的综合性能,多层特征级联的设计不仅能够加快模型训练的速度,又进一步提高了器官的分割准确率。

- 还没有人留言评论。精彩留言会获得点赞!