遥感图像变化检测方法及系统与流程

本发明涉及一种遥感图像变化检测方法及系统。

背景技术:

1、遥感变化检测是通过观察一个区域内不同时期拍摄的遥感影像,利用图像处理或者数理模型等方法,识别该区域内地物目标或者某种现象变化的过程,具体包括地物位置、范围的变化和地物性质、状态的变化等。

2、为了实现基于遥感影像的变化检测,早期研究主要集中在传统变化检测算法领域。传统的变化检测算法主要通过利用简单的图像代数或者复杂的特征构造方法获取特征,并通过阈值判断或者机器学习(machine learning,ml)等算法对特征做出变与不变的判断。传统的变化检测算法在面向大范围高分辨率遥感影像数据时,存在着明显的缺陷,因此基于大数据的深度学习(deep learning,dl)变化检测算法成为了研究热点。不同于传统方法,基于dl的变化检测技术可以端对端的输入多期遥感图像,输出变化区域图斑,不仅可以带来更少的人工干预和更高的精度,也能带来更强的鲁棒性和更好的泛化能力。

3、深度学习变化检测算法,按照检测结果粒度可以划分为:场景级变化检测(scene-level change detection,slcd)、目标级变化检测(object-level change detection,olcd)、像素级变化检测(pixel-level change detection,plcd)三种,三种方法的显著差异在于损失函数的设计上。损失函数是决定深度学习模型优化方向的关键因素。在深度学习变化检测的slcd、olcd以及plcd三个领域中,不同领域的损失测均有不同:

4、slcd采用基于图像块分类的方法获得图像块粒度的变化检测结果。虽然slcd算法能较为准确的发现变化图像块,但是受检测粒度的限制,slcd既无法获得变化图斑准确位置,也无法获得精细的变化图斑轮廓。

5、olcd通过获取变化区域的外接矩形精准定位变化区域,且能够对抗一定程度图像配准误差和背景差异,在近年来得到了一定的发展。然而,现有的olcd方法虽然能够获得准确的变化图斑位置,但是约束方法缺少对图斑轮廓的关注。同时,现有的olcd方法往往只能提取建筑物、车辆等简单结构地物的变化,难以处理如道路、施工工地等复杂形态地物变化场景。

6、plcd针对影像中的每个像素完成变与不变的分类,能够同时定位变化并提取完成变化轮廓,是当前变化检测算法的主流模式。然而,现有的plcd方法基于单个像素完成损失计算,所有变化图斑像素享有同等权重,这导致了大图斑的边缘得到过多的关注,而小图斑则在网络优化过程中被忽视,造成误检和漏检。因此,现有的plcd难以实现很好的图斑定位精度。

7、当前的遥感图像变化检测任务存在实际业务需求与特征学习方向偏移的问题,导致现有的变化检测算法难以同时获得高轮廓精度以及高定位精度的变化图斑。其中,轮廓精度代表算法获取的变化图斑轮廓与实际变化区域边界的契合程度,即评价轮廓的精细程度。定位精度代表变化图斑与真实变化区域在空间上的相交程度,即评价图斑的误检漏检情况。考虑到实际大范围的变化检测应用中,变化图斑的定位精度往往比变化图斑的轮廓精度更加重要。在建筑物违建排查、建筑物受灾评估、耕地非法占用、生态保护区监测等应用中,能否准确发现变化是衡量变化检测算法优劣的关键指标。当前主流的变化检测算法基本针对优化变化检测结果的像素级精度(f1、iou等),此种约束方式往往过度追求边界像素精度而损失了变化图斑的定位精度。同时,更明显且具有更多像素的大变化图斑在模型优化过程中获得了更大的优化力度,如此导致了小图斑的误检漏检问题严重。

8、如图1所示,在变化检测任务中图斑的像素精度与定位精度并没有强相关性。在图1中,中间的结果具有很高的像素精度(f1=90%),得益于其检测出的变化图斑轮廓非常规整,与标签切合度很高,然而却在左下角漏掉了两个小图斑,因此定位精度仅有75%(遗漏了25%的图斑)。而在右图中,尽管图中的变化图斑轮廓没有那么精细,像素精度也只有80%,却实现了所有变化图斑的检出,实现了100%的定位精度。在实际如灾害救援、违建排查等应用中,右图的检测结果具有更大的应用价值。综上,当前变化检测研究中追求优化像素精度并不能带来应用中的更好的效果。

技术实现思路

1、有鉴于此,有必要提供一种遥感图像变化检测方法及系统,其能够针对当前兼顾遥感图像变化检测轮廓精度和定位精度的方法缺失的现状,实现实例级约束的变化检测,协同优化模型的定位精度和轮廓精度,提升变化检测的实际应用落地能力。

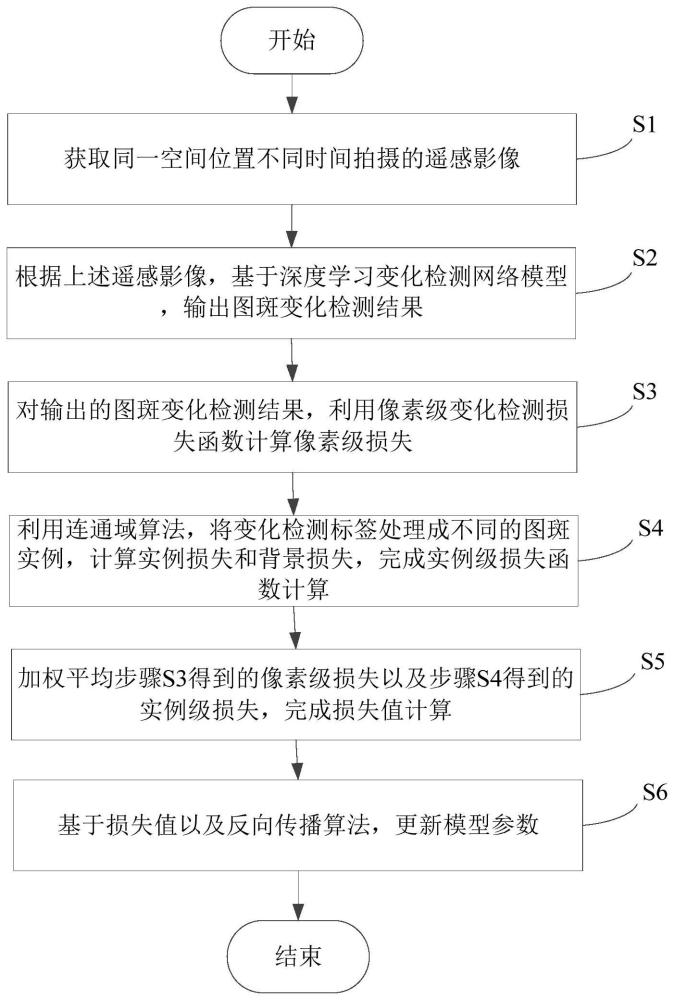

2、本发明提供一种遥感图像变化检测方法,该方法包括如下步骤:

3、a.获取同一空间位置不同时间拍摄的遥感影像;

4、b.根据上述遥感影像,基于深度学习变化检测网络模型,输出图斑变化检测结果;

5、c.对输出的图斑变化检测结果,利用像素级变化检测损失函数计算像素级损失;

6、d.利用连通域算法,将变化检测标签处理成不同的图斑实例,计算实例损失和背景损失,完成实例级损失函数计算;

7、e.加权平均得到的像素级损失以及得到的实例级损失,完成损失值计算。

8、优选地,所述方法还包括:

9、步骤f.基于损失值以及反向传播算法,更新模型参数。

10、所述的步骤a包括:

11、获取双时相遥感影像t1以及t2,其中,所述t1以及t2为不同时间拍摄的同一空间位置。

12、所述的步骤b包括:

13、将t1以及t2输入到深度学习变化检测网络模型f,得到所述网络模型f输出的变化检测结果p:

14、p=f(t1,t2) (1)。

15、所述的步骤c包括:

16、利用通用的bce+dice的像素级损失函数组合,计算变化检测结果p以及变化检测标签l之间的差异;

17、bce计算公式如下:

18、

19、其中,n代表当前参与计算的图像范围内的所有像素个数,pn和ln分别代表预测结果和标签分别在位置n处的值;

20、dice计算公式如下:

21、

22、其中,∩代表p和l之间的交集,|*|代表1-范数;

23、因此,bce+dice的像素级损失表示为:

24、lpix=lbce+ldice (4)。

25、所述的步骤d包括:

26、步骤s41:利用连通域算法,将变化检测标签处理成不同的图斑实例,并获取实例的外接矩形区域;

27、步骤s42:根据标签实例以及对应的外接矩形,提取出预测结果在该外接矩形范围内的区域,并过滤掉属于其他实例的区域;

28、步骤s43:将配对好的标签实例区域以及预测结果区域,利用dice损失函数计算每个实例的损失;

29、步骤s44:剥离出不在实例外接矩形内的背景区域,利用bce损失函数计算背景损失;

30、步骤s45:组合实例损失和背景损失,完成实例级损失函数计算。

31、所述的步骤d进一步包括:

32、步骤s41:将变化检测标签l,利用连通域算法,获取变化检测标签实例集合i={linst,1,linst,2,…,linst,m}以及实例的外接矩形集合b={bbox1,bbox2,…,bboxm};

33、其中,m代表标签中存在的变化图斑实例的个数,linst,*代表属于某个变化实例的所有像素的集合;

34、步骤s42:针对每个标签实例,拆分出模型输出结果中的对应实例区域,对于第m个实例linst,m,通过以下方式获取结果中对应的实例区域,并且过滤掉属于其他标签实例的像素:

35、

36、其中,n∈{1,2,3,…,m}且n≠m;

37、步骤s43:将配对好的标签实例linst与预测结果pinst一起输入dice损失函数,并累加所有的图斑实例损失计算前景实例级损失:

38、

39、其中,a为归一化超参数,通常设为1;

40、步骤s44:约束标签实例矩形框之外的背景区域损失:背景区域g表示为b的补集,背景约束损失通过如下计算:

41、linst,g=lbce(li,pi|i∈g) (7);

42、步骤s45:构建完整的实例级损失约束:通过组合前景实例损失linst,f以及背景实例损失linst,g,得到实例损失约束如下:

43、

44、所述的步骤e包括:

45、加权平均实例级损失以及像素级损失,完成变化检测结果输出的损失值计算:

46、loss=k*linst+j*lpix (9)

47、其中,k和j均为超参数。

48、本发明提供一种遥感图像变化检测系统,该系统包括获取模块、检测模块、像素级损失模块、实例级损失模块、计算模块,其中:

49、所述获取模块用于获取同一空间位置不同时间拍摄的遥感影像;

50、所述检测模块用于根据上述遥感影像,基于深度学习变化检测网络模型,输出图斑变化检测结果;

51、所述像素级损失模块用于对输出的图斑变化检测结果,利用像素级变化检测损失函数计算像素级损失;

52、所述实例级损失模块用于利用连通域算法,将变化检测标签处理成不同的图斑实例,计算实例损失和背景损失,完成实例级损失函数计算;

53、所述计算模块用于加权平均得到的像素级损失以及得到的实例级损失,完成损失值计算。

54、优选地,所述系统还包括:

55、更新模块,用于基于损失值以及反向传播算法,更新模型参数。

56、本发明弥补了现有遥感图像变化检测技术难以同时兼顾变化检测图斑的轮廓精度和图斑误检/漏检率的问题,极大提升了遥感图像变化检测在实际应用中的落地能力。同时,本发明针对实例级的变化检测约束,设计了基于区域匹配的图斑实例约束策略,实现了基于像素级变化检测样本的实例级约束等效计算。

- 还没有人留言评论。精彩留言会获得点赞!