一种文本续写方法、系统、设备及存储介质与流程

本发明涉及数据传输,特别是涉及一种文本续写方法、系统、设备及存储介质。

背景技术:

1、随着人工智能技术驱动的多种自然语言处理工具的发布,越来越多的研究人员意识到,大模型可以对未来带来重大影响,在各个垂直领域上具有很大的发展潜力。

2、文本续写是语言处理模型的一个重要应用,即输入一段文本之后,由语言处理模型进行文本的续写。而要训练一个大的能够实现文本续写的语言处理模型,需要几千个gpu(graphics processing unit,图形处理器)花费几个月的时间,才能完成模型的训练。除了对计算量的需求外,大语言模型的训练过程对ai(artificial intelligence,人工智能)集群的通信带宽也有极高的要求。目前,由于模型参数量巨大,通常在单个gpu内无法放下整个模型的参数,为此通常会采用张量并行、流水并行等方式,将模型拆分到多个计算节点上,每个计算节点中保存模型的一部分参数。这种方法虽然可以有效解决大模型训练过程中单个gpu显存不足的问题,但是与此同时,会为模型的训练过程引入更多的通信数据量。

3、目前的模型并行的算法都是针对具备高速通信带宽的ai集群设计的。例如,对于具有900gb高速带宽的h100和600gb高速带宽的a100计算板卡来说,训练过程引入的这部分数据的通信可以很快完成,对语言处理模型的训练性能影响较小。但是,如果在只有64g通信带宽的计算环境下训练大的语言模型,由于通信带宽降低了10倍,则通信时间开销对模型训练性能的影响也变的显著。

4、综上所述,如何有效地基于语言处理模型实现文本续写,提高语言处理模型的训练效率,是目前本领域技术人员急需解决的技术问题。

技术实现思路

1、本发明的目的是提供一种文本续写方法、系统、设备及存储介质,以有效地实现文本续写,提高训练效率。

2、为解决上述技术问题,本发明提供如下技术方案:

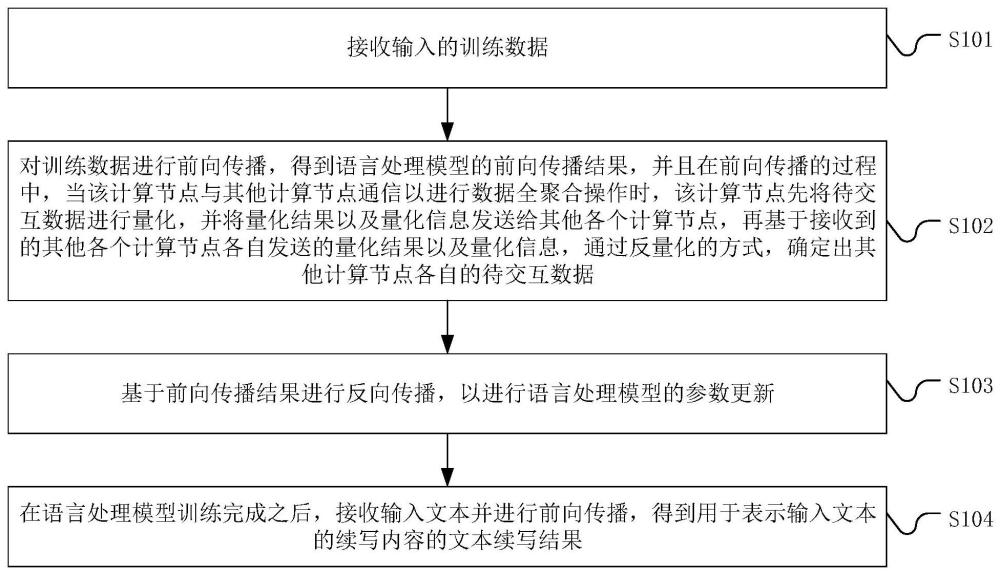

3、一种文本续写方法,应用于语言处理模型中的每一个计算节点中,且所述语言处理模型以张量并行的方式拆分在各个所述计算节点上,所述文本续写方法包括:

4、接收输入的训练数据;

5、对所述训练数据进行前向传播,得到所述语言处理模型的前向传播结果,并且在前向传播的过程中,当该计算节点与其他计算节点通信以进行数据全聚合操作时,该计算节点先将待交互数据进行量化,并将量化结果以及量化信息发送给其他各个计算节点,再基于接收到的其他各个计算节点各自发送的量化结果以及量化信息,通过反量化的方式,确定出其他计算节点各自的待交互数据;

6、基于所述前向传播结果进行反向传播,以进行所述语言处理模型的参数更新;

7、在所述语言处理模型训练完成之后,接收输入文本并进行前向传播,得到用于表示所述输入文本的续写内容的文本续写结果。

8、在一种实施方式中,基于所述前向传播结果进行反向传播,以进行所述语言处理模型的参数更新,包括:

9、基于所述前向传播结果进行反向传播,得到该计算节点的梯度数据,并且在反向传播的过程中,当该计算节点与其他计算节点通信以进行数据全聚合操作时,该计算节点先将待交互数据进行量化,并将量化结果以及量化信息发送给其他各个计算节点,再基于接收到的其他各个计算节点各自发送的量化结果以及量化信息,通过反量化的方式,确定出其他计算节点各自的待交互数据;

10、基于该计算节点的所述梯度数据,进行所述语言处理模型的该计算节点的参数更新。

11、在一种实施方式中,基于该计算节点的所述梯度数据,进行所述语言处理模型的该计算节点的参数更新,包括:

12、将该计算节点的所述梯度数据进行量化,并将量化结果以及量化信息发送至内存中,以使得处理器基于内存中的由各个计算节点各自发送的量化结果以及量化信息,通过反量化的方式确定出各个计算节点各自发送的梯度数据;

13、在所述处理器基于各个计算节点各自发送的梯度数据进行所述语言处理模型的参数更新,得到参数更新结果并存储在内存中之后,接收所述处理器的反馈数据;

14、基于所述处理器发送给自身的反馈数据,通过反量化的方式确定出属于该计算节点的参数更新结果;

15、基于确定出的属于该计算节点的参数更新结果,替换该计算节点此前的参数;

16、其中,所述处理器的反馈数据包括:

17、所述处理器将属于该计算节点的参数更新结果进行量化之后所得到的量化结果以及量化信息。

18、在一种实施方式中,在训练数据的前向传播的过程中,该计算节点的待交互数据为该计算节点的参数数据,或者为该计算节点当前的计算结果。

19、在一种实施方式中,在训练数据的前向传播的过程中,该计算节点将待交互数据进行量化时,待交互数据为单精度浮点数类型的数据,量化之后所得到的量化结果为半精度浮点数类型的数据,或者为8位有符号整数类型的数据,或者为4位有符号整数类型的数据。

20、在一种实施方式中,在训练数据的前向传播的过程中,该计算节点使用双流水线,以通过第一流水线进行数据全聚合操作,并通过第二流水线进行前向传播计算操作。

21、在一种实施方式中,在训练数据的前向传播的过程中,该计算节点将待交互数据进行量化的操作包括:

22、该计算节点确定出待交互数据中的各个数据项的平均值;

23、基于所述平均值,以及待交互数据中的各个数据项的最大值和最小值,确定出缩放系数;

24、基于所述缩放系数对待交互数据进行缩放,并且缩放结果作为该计算节点将待交互数据进行量化后所得到的量化结果,将所述平均值和所述缩放系数作为该计算节点将待交互数据进行量化后所得到的量化信息。

25、一种文本续写系统,应用于语言处理模型中的每一个计算节点中,且所述语言处理模型以张量并行的方式拆分在各个所述计算节点上,所述文本续写系统包括:

26、训练数据接收模块,用于接收输入的训练数据;

27、前向传播模块,用于对所述训练数据进行前向传播,得到所述语言处理模型的前向传播结果,并且在前向传播的过程中,当该计算节点与其他计算节点通信以进行数据全聚合操作时,该计算节点先将待交互数据进行量化,并将量化结果以及量化信息发送给其他各个计算节点,再基于接收到的其他各个计算节点各自发送的量化结果以及量化信息,通过反量化的方式,确定出其他计算节点各自的待交互数据;

28、反向传播模块,用于基于所述前向传播结果进行反向传播,以进行所述语言处理模型的参数更新;

29、执行模块,用于在所述语言处理模型训练完成之后,接收输入文本并进行前向传播,得到用于表示所述输入文本的续写内容的文本续写结果。

30、一种文本续写设备,包括:

31、存储器,用于存储计算机程序;

32、处理器,用于执行所述计算机程序以实现如上述所述的文本续写方法的步骤。

33、一种计算机可读存储介质,所述计算机可读存储介质上存储有计算机程序,所述计算机程序被处理器执行时实现如上述所述的文本续写方法的步骤。

34、应用本发明实施例所提供的技术方案,可以应用于语言处理模型中的每一个计算节点中,且语言处理模型以张量并行的方式拆分在各个计算节点上,对于任意1个计算节点而言,该计算节点接收输入的训练数据之后,便可以对训练数据进行前向传播,得到语言处理模型的前向传播结果,后续再基于前向传播结果进行反向传播,以进行语言处理模型的参数更新。完成了语言处理模型的训练之后,接收输入文本并进行前向传播,便可以得到用于表示输入文本的续写内容的文本续写结果,也即实现了文本续写。

35、进一步的,本技术考虑到,特别是在通信带宽较小的环境下,通信时间开销对模型训练性能的影响较为显著,对此本技术的方案中,对于任意1个计算节点而言,在前向传播的过程中,当该计算节点与其他计算节点通信以进行数据全聚合操作时,该计算节点先将待交互数据进行量化,并将量化结果以及量化信息发送给其他各个计算节点,再基于接收到的其他各个计算节点各自发送的量化结果以及量化信息,通过反量化的方式,确定出其他计算节点各自的待交互数据。可以看出,通过上述的量化过程以及反量化的过程,使得该计算节点能够确定出其他计算节点各自的待交互数据,即不会造成精度的损失。但是,各个计算节点并不是直接进行待交互数据的发送,而是发送的量化结果以及量化信息,相较于待交互数据,量化结果占用的空间要低得多,因此可以有效地降低节点之间的通信开销,也就提高了语言处理模型的训练效率。并且需要说明的是,虽然本技术的方案中进行数据全聚合操作时,相较于传统方案,需要在计算节点之间进行量化信息的通信,但是量化信息是标量,为此所引入的通信时间开销可以忽略不计。

36、综上所述,本技术的方案可以有效地实现文本续写,并且通过量化以及反量化的方式,不会造成精度的损失,且又降低了数据全聚合时的通信开销,也就提高了本技术的语言处理模型的训练效率。

- 还没有人留言评论。精彩留言会获得点赞!