基于神经辐射场的少视图多时相遥感图像三维重建方法

本发明涉及遥感图像三维建模,具体为基于神经辐射场的少视图多时相遥感图像三维重建方法。

背景技术:

1、长期以来,三维重建一直是遥感领域一个有价值的研究领域。它在数字孪生、城市规划、灾后应急响应等方面发挥着重要作用。随着高分辨率卫星图像质量的提高和卫星立体数据集的出现,该领域发展迅速,导致重建结果的准确性、完整性和精细化提高。尽管取得了这些进步,但此类研究的实际应用仍然受到各种卫星图像固有的挑战的严重限制。然而,要重建的区域仅具有很少视图的多时相图像以及不足的几何约束和光照变化对现有算法提出了巨大的挑战。现有的成熟研究难以应对上述输入条件下存在的挑战。当标准卫星立体像对或多视图立体图像作为输入数据时,基于立体匹配的算法通常会产生高质量的重建结果。然而,在少视图、多时相的图像情况下,大交叉角和照明差异的存在通常会带来重大挑战,对匹配质量产生不利影响。

2、近年来神经网络的发展为立体匹配提供了新的思路,并部分缓解了上述挑战。精心设计的卷积神经网络(cnn)提取的准确特征使匹配更加准确。然而,现有研究大多数需要大量深度信息作为网络训练的监督数据,在实际应用中成本高昂。神经辐射场(nerf)在神经渲染领域中获得了极大的关注,用于合成复杂场景的新颖视图。基于渲染理论的网络思想使其能够通过渲染过程的具体设计来适应不同图像中大交叉角带来的挑战。尽管如此,nerf依赖于渲染与输入一致的图像来拟合隐式空间中的精确三维结构,而无需任何其他监督信息。不同日期的遥感图像之间的照明差异会导致重建质量显著下降,进而导致了重建图像准确率低。

技术实现思路

1、本发明的目的是:针对现有技术中,不同日期的遥感图像之间的照明差异会导致图像像素颜色差异,进而导致重建质量显著下降的问题,提出基于神经辐射场的少视图多时相遥感图像三维重建方法。

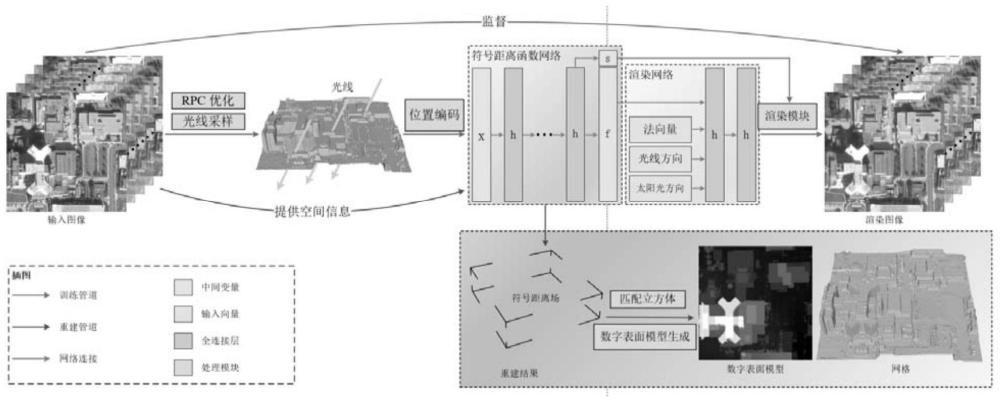

2、本发明为了解决上述技术问题采取的技术方案是:

3、基于神经辐射场的少视图多时相遥感图像三维重建方法,包括以下步骤:

4、步骤一:确定重建区域,并获取该重建区域的多时相遥感图像,之后,在多时相遥感图像中选取一幅遥感图像,并获取该遥感图像最大高程值hmax以及最小高程值hmin,同时获取遥感图像的太阳光方向s;

5、步骤二:建立z轴垂直于地面的空间坐标系,之后,在遥感图像中任选一个像素pi,基于hmax与hmin,并利用rpc模型构造穿透像素pi的光线r(t),之后,获取光线r(t)的方向v;

6、步骤三:对光线r(t)进行等间隔采样,得到对应的采样点集合r={r(ti)|i=0,1,2,...,n-1},其中,n为采样点的总数,i表示第i个采样点;

7、步骤四:基于空间坐标系和光线r(t),得到每个采样点的位置向量x,并对位置向量x进行自适应频率位置编码,得到位置向量p(x);

8、步骤五:对光线r(t)的方向v进行自适应频率位置编码,得到光线方向p(v);

9、步骤六:对太阳光方向s进行自适应频率位置编码,得到太阳光方向p(s);

10、步骤七:将位置向量p(x)输入mlpsdf网络,得到每个采样点的符号距离函数值d(xi)和特征向量f,之后,获取mlpsdf网络中的梯度方向,即法向量n,法向量n表示为:

11、

12、其中,表示求梯度;

13、步骤八:将特征向量f、法向量n、位置向量x、光线方向p(v)以及太阳光方向p(s)输入mlprender浅层网络,得到每个采样点的颜色值ci,所述mlprender浅层网络包括输入层和两层全连接层,层间通过relu激活函数连接;

14、步骤九:对采样点进行权重估计,得到采样点的颜色权重wi,之后,将所有采样点的颜色权重wi和颜色值ci进行加权求和,得到像素pi的渲染颜色

15、步骤十:获取像素pi的真实颜色并利用渲染颜色与像素真实颜色构造颜色损失函数lrgb;

16、步骤十一:利用法向量n和符号距离函数值d(xi),得到梯度下降损失函数lnormal,并结合颜色损失函数lrgb构建总损失函数ltotal;

17、步骤十二:针对多时相遥感图像中的每一个像素,重复步骤一至步骤十一,并利用得到的总损失函数进行反向传播,优化mlpsdf网络,当总损失函数满足预设值时,得到优化后的mlpsdf网络,最后,利用优化后的mlpsdf网络生成mesh网格和数字表面模型,进而完成三维重建。

18、进一步的,所述步骤二中,基于hmax与hmin,并利用rpc模型构造穿透像素pi的光线r(t)的具体步骤为:

19、步骤二一:获取像素pi的坐标xc,l,之后,基于xc,l,并结合hmax和hmin,得到坐标(xc,l,hmin)和(xc,l,hmax);

20、步骤二二:利用rpc模型将坐标(xc,l,hmin)转换为经纬度坐标,之后再将经纬度坐标转换为通用横向墨卡托投影坐标,即utm坐标,并将utm坐标进行归一化,使坐标值范围归一化在[-0.5,0.5]之间,进而得到光线r(t)的初始坐标点xstart;

21、步骤二三:基于步骤二二,基于坐标(xc,l,hmax)得到光线r(t)的最终坐标点xend;

22、步骤二四:根据xstart和xend,得到光线原点o和光线方向v,并利用光线方向v和光线原点o,得到像素pi的光线r(t)。

23、进一步的,所述光线r(t)表示为:

24、r(t)=o+tv

25、

26、o=xstart

27、xstart=u(pinv(xc,l,hmin))

28、xend=u(pinv(xc,l,hmax))

29、其中,o表示光线原点,v表示光线方向,xstart表示光线r(t)的初始坐标点,xend表示光线r(t)的最终坐标点,xc,l表示像素pi的坐标,pinv表示利用rpc模型将图像像素坐标转换为经纬度坐标,u表示将经纬度坐标转换为通用横向墨卡托投影坐标,即utm坐标,t表示在光线最近点tmin到光线最远点tmax之间的点,t∈[tmin,tmax],tmin=0,tmax=||xend-xstart||2。

30、进一步的,所述渲染颜色表示为:

31、

32、进一步的,所述颜色损失函数lrgb表示为:

33、

34、进一步的,所述梯度下降损失函数lnormal表示为:

35、

36、进一步的,所述总损失函数ltotal表示为:

37、ltotal=lrgb+0.1×lnormal。

38、进一步的,所述自适应频率位置编码表示为:

39、

40、fr=[2nfor n in[0,…fdk]∈n+]

41、其中,fd表示频率采样的间隔,fr表示位置编码系数,k表示当前训练正在进行的阶段,p(x,fr)表示向量x处的位置编码值,x表示三维输入向量,n表示中间量。

42、进一步的,所述每个采样点的颜色值ci表示为:

43、ci=frender(x,f,n,p(v),p(s))。

44、进一步的,所述每个采样点的颜色权重wi表示为:

45、

46、

47、

48、

49、其中,αi表示第i个采样点的离散透明度,αj表示第j个采样点的离散透明度,ti表示第i个采样点的累计不透明度,r(ti)表示第i个采样点的采样点位置向量,f(r(ti))表示第i个采样点的sdf值,q表示可学习参数,φs表示sigmoid激活函数。

50、本发明的有益效果是:

51、本技术将太阳光信息融入到渲染过程中,进而解决了多日期图像中光照差异导致的重建质量显著下降问题,提升了重建图像的准确率。

52、本技术可使用不同拍摄时间的遥感图像作为输入,利用光束平差算法对图像有理多项式系数(rpc)进行优化,在感兴趣的区域对射线进行采样,随后,通过光线自适应频率位置编码计算出的位置向量,经过mlp网络后得到采样点sdf值和特征向量,在经过渲染网络得到采样点的颜色值,最终利用采样点的颜色值与sdf值计算得到像素颜色。sdf网络通过监督渲染图像和输入图像之间的相似性损失来实现3d空间的拟合,从训练好的网络中提取sdf场,利用dsm生成模块和marching cube算法重建该场中的dsm和网格。使用该方法,能够准确快速的恢复场景的结构,极大的减少人力与时间的浪费,有利于城市规划、灾后重建、军事侦察等多方面遥感应用。并且本技术解决了现有技术重建场景需要大量稀缺遥感图像资源的问题。

53、经过实验分析,对图像空间分辨率不低于0.35m,图像大小约800×800像素,覆盖区域面积256*256m2重建dsm准确度达到mae<1.42,重建网格准确度达到cd<3.08。

- 还没有人留言评论。精彩留言会获得点赞!