一种基于联邦学习的抗后门攻击方法和系统

本发明涉及机器学习,具体涉及一种基于联邦学习的抗后门攻击方法和系统。

背景技术:

1、随着数字技术进入高速发展期,数据多元化,信息化和多样化成为当今时代的主题,打破“数据孤岛”充分利用数据已经成为当下的热门话题。传统的中心服务器统一训练方式已经显现出众多的安全问题,联邦学习是一种安全的分布式机器学习,可以在数据不离开本地的前提下共同训练全局模型,达到保护隐私的效果。目前常见的抗后门攻击方法有,触发器和后门不匹配方法,这种方法通过预处理输入样本,使得触发器和后门之间的匹配关系被破坏,从而防止后门被激活,但是这会影响输入的质量,降低模型的准确性。后门消除法是通过检测和删除模型中的后门,使得模型不再对触发器敏感,但是需要对模型进行扫描和修改,会增加计算开销和风险。触发器消除法通过检测和过滤带有触发器的中毒样本,使得模型不再接收到异常输入,但是不能修复已经被嵌入后门的模型,只能在测试阶段起作用。

技术实现思路

1、为解决上述技术问题,本发明提出一种基于联邦学习的抗后门攻击方法和系统,解决了传统联邦学习后门防御方法中被恶意攻击者篡改和获取隐私的问题,达到了一定的隐私保护级别,保证了模型的收敛性能,提高了联邦学习的安全性和鲁棒性。

2、为了达到上述目的,本发明采用以下技术方案:

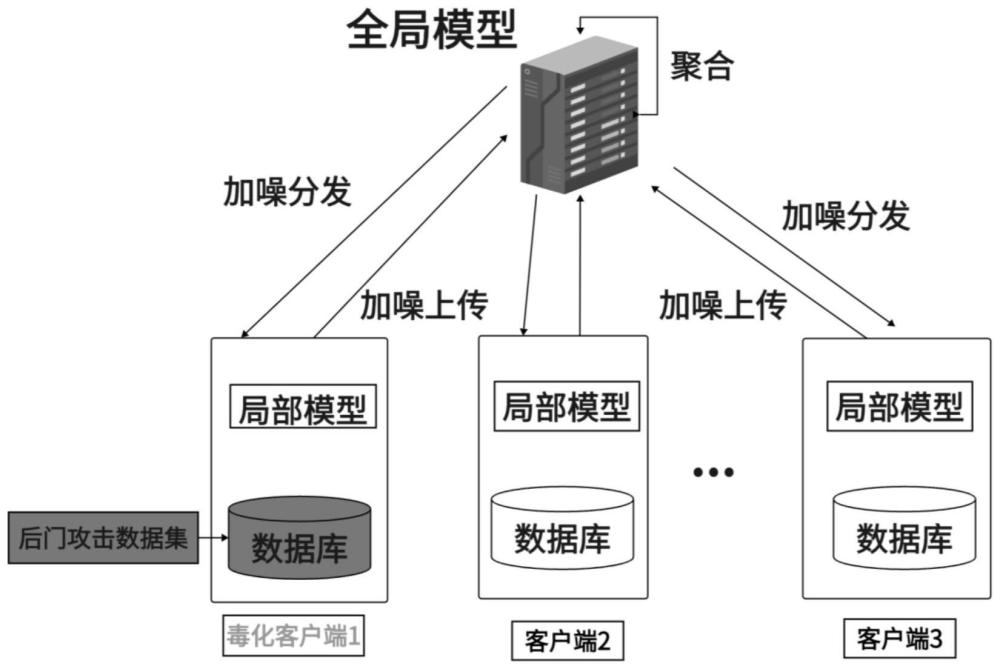

3、本发明提出了一种基于联邦学习的抗后门攻击方法,包括:

4、s1、利用input-instance-key策略进行数据集的毒化处理,得到后门攻击数据集,将该数据集加入选定的客户端的本地数据集中,完成攻击。

5、s2、服务器端初始化全局模型,并广播给所有客户端。

6、s3、每个客户端使用步骤s1中的本地数据集,对接收到的全局模型采用分段式调度策略选择学习率,并使用动量优化器进行训练形成本地局部模型,对该模型进行加噪,并将加噪后的本地局部模型发送给服务器端。

7、s4、服务器端接收到每个客户端加噪的本地局部模型,并计算权重,采用聚合算法更新全局模型。

8、s5、服务器端将更新后的全局模型加噪后广播给所有客户端,重复步骤s3-s5,直到达到预设的聚合轮数。

9、s6、通过差分隐私算法对后门攻击进行防御,得到鲁棒性高的抗后门攻击方法。

10、进一步的,步骤s1中,完成攻击包括以下内容:

11、s101、采用input-instance-key策略,制作后门攻击数据集,具体公式为:

12、∑(x)={clip(x+δ)|δ∈[-5,5]h×w×3}

13、

14、其中,x表示图像的向量表示;∑(x)表示x随机产生的后门攻击数据集;δ表示噪声,是一个h×w×3维度的数,h表示图像的高度,w表示图像的宽度,3为通道数(如rgb),其值在[-5,5]范围内;clip(x)表示裁剪函数,用于将x的每个维度值裁剪到像素值[0,255]范围内。

15、s102、从n个客户端{c1,c2,...,ck,...,cn}中,随机选取m(m<n)个客户端,将∑(x)中抽取r个中毒图像的向量表示构建中毒样本{(x′1,yx),...,(x′r,yx)},其中,x′r表示第r个中毒图像的向量表示,yx表示中毒图像的向量表示的标签,注入到选取的m个客户端的本地训练集中,攻击完成。

16、进一步的,步骤s2中,初始化全局模型参数包括以下内容:

17、对全局模型vgg-16使用预训练权重赋值w0,将最后一个全连接层的输出节点数设定为n,以匹配手写数字的类别数;在服务器端设定目标隐私保护等级ε,用来控制加噪的强度;设置客户端发送给服务器端次数t,客户端本地训练次数t′。

18、进一步的,步骤s3中,更新局部模型参数包括以下内容:

19、s301、利用分段式调度策略自适应地调整学习率,这种策略将训练过程分为多个阶段,每个阶段使用不同的学习率。在训练的早期,学习率较大,以便快速收敛。在训练的后期,学习率较小,以便更好地探索局部最小值。具体公式为:

20、

21、其中,t′表示本地训练轮次数,lt′表示第t′轮训练学习率,l1、l2、l3均表示学习率。

22、s302、使用动量优化器构建一阶动量,对局部模型进行训练,具体公式为:

23、

24、

25、其中,mt′表示第t′轮训练动量;表示第t′轮训练模型梯度;β表示衰减权重,越远的迭代权重越小;m(t-1)′表示第(t-1)′轮训练动量;表示第k个客户端第t′轮训练模型参数;表示第k个客户端第(t-1)′轮训练模型参数。

26、从公式中可以看出,动量优化器中,当前迭代的梯度和之前迭代的累积梯度都会影响参数更新。

27、s303、将噪声添加到本地局部模型中,具体公式为:

28、

29、

30、其中,η表示噪声,服从(μ,σ2)正态分布;μ表示均值;σ2表示标准差;表示第k个客户端训练完t轮的加噪局部模型参数,表示第k个客户端训练完t轮的局部模型参数。

31、进一步的,步骤s4中,更新全局模型包括以下内容:

32、客户端权重根据不同的标准来确定,例如客户端的数据量、数据质量、信誉度等,这里采用客户端的的样本数量来表示,加噪的本地局部模型的权重,具体公式为:

33、

34、其中,表示第k个客户端第t轮聚合的权重,dk表示第k个客户端的本地数据集,|dk|表示第k个客户端的本地数据集的数量。

35、对所有客户端的加噪参数进行加权平均,得到全局模型参数,具体公式为:

36、

37、其中,wt表示第t轮的全局模型。

38、进一步的,步骤s5中,全局模型加噪包括以下内容:

39、向全局模型中添加噪声,具体公式为:

40、

41、其中,表示训练完t轮的加噪全局模型参数。

42、进一步的,本发明还提出一种基于联邦学习的抗后门攻击系统,包括:

43、攻击完成模块,用于利用input-instance-key策略进行数据集的毒化处理,得到后门攻击数据集,将该数据集加入选定的客户端的本地数据集中,完成攻击。

44、模型初始化模块,用于服务器端初始化全局模型,并广播给所有客户端。

45、模型加噪模块,用于每个客户端使用步骤s1中的本地数据集,对接收到的全局模型采用分段式调度策略选择学习率,并使用动量优化器进行训练形成本地局部模型,对该模型进行加噪,并将加噪后的本地局部模型发送给服务器端。

46、模型更新模块,用于服务器端接收到每个客户端加噪的本地局部模型,并计算权重,采用聚合算法更新全局模型。

47、聚合模块,用于服务器端将更新后的全局模型加噪后广播给所有客户端,重复模型加噪模块、模型更新模块和聚合模块的内容,直到达到预设的聚合轮数。

48、进一步的,本发明还提出一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现前文所述的一种基于联邦学习的抗后门攻击方法的步骤。

49、进一步的,本发明还提出一种计算机可读的存储介质,所述计算机可读的存储介质存储有计算机程序,所述计算机程序被处理器运行时执行前文所述的一种基于联邦学习的抗后门攻击方法。

50、与现有技术相比,本发明的有益效果在于:

51、本发明利用在客户端和服务器均添加符合差分隐私的噪声,提出了一种新型的后门攻击防御框,每个被选取客户端将训练完的模型添加噪声,中央服务器在分在全局模型是时候添加噪声,减少被毒化的数据集对模型的影响,从而将降低攻击者的攻击能力和动机。与现有技术比,该系统拥有更好的性能。此外,在单个和多个恶意客户端配置条件中都能够防御成功,能够有效的防御联邦学习中的后门攻击。本发明在应对联邦学习环境下的后门攻击能够有效减少异常客户端的影响,达成防御成功的效果,同时有效保护各个诚实客户端的正常协同训练。

- 还没有人留言评论。精彩留言会获得点赞!