一种全开放词表3D场景图生成方法、装置、设备及介质与流程

本技术涉及计算机视觉和自然语言处理,尤其涉及一种全开放词表3d场景图生成方法、装置、设备及介质。

背景技术:

1、场景图(scene graph)以图的形式表示场景中的物体(图节点)和物体之间的关系(图边)。场景图生成任务可以为许多高级视觉任务提供有用的语义信息,如视觉问答、图像说明、视觉推理、机器人导航等,是计算机视觉领域中的一个重要任务。场景图生成任务通常以场景采集的信息(rgb图像/rgbd图像/3d点云)作为输入,输出场景图作为场景的结构化表示,包括目标位置、语义类别和目标间的关系。

2、现有技术中,一般仅用单视角rgb图作为输入,来生成开放词表场景图。其缺陷在于对空间关系的理解能力有所欠缺。输出是2d目标位置、目标类别和目标间的关系,目标类别和关系种类均不受限,但一对目标仅能有一种关系。其缺陷在于不能同时输出属性,也不支持同一对目标之间有多种关系,场景图的表示能力有所欠缺。并且仅用两个实体的边界框并集作为关系特征提取的主要区域,其缺陷在于缺失全局信息,可能会导致关系预测有偏差。

技术实现思路

1、为克服现有技术中的不足,本技术提供一种全开放词表3d场景图生成方法、装置、设备及介质,能够利用更为准确的空间信息,增强模型对空间的感知能力,提高模型预测的准确性。

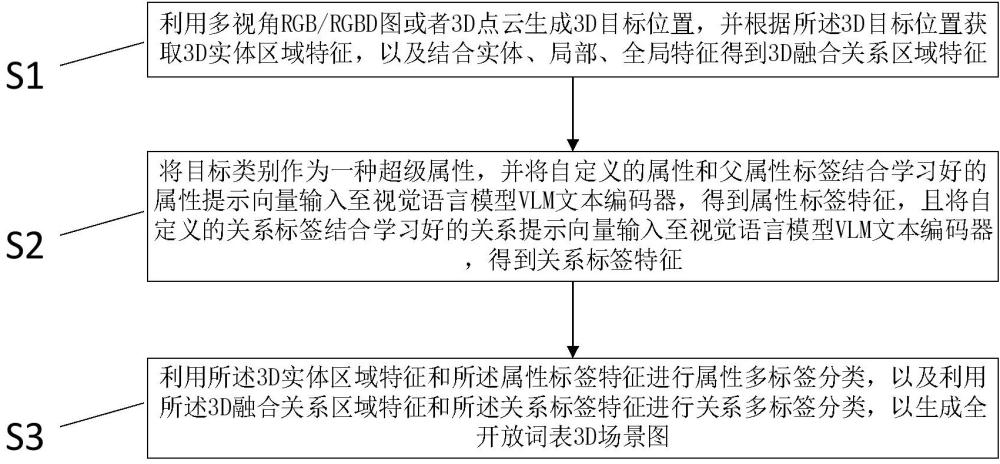

2、第一方面,本技术提供一种全开放词表3d场景图生成方法,所述方法包括以下步骤:

3、利用多视角rgb/rgbd图或者3d点云生成3d目标位置,并根据所述3d目标位置获取3d实体区域特征,以及结合实体、局部、全局特征得到3d融合关系区域特征;

4、将目标类别作为一种超级属性,并将自定义的属性和父属性标签结合学习好的属性提示向量输入至视觉语言模型vlm文本编码器,得到属性标签特征,且将自定义的关系标签结合学习好的关系提示向量输入至视觉语言模型vlm文本编码器,得到关系标签特征;

5、利用所述3d实体区域特征和所述属性标签特征进行属性多标签分类,以及利用所述3d融合关系区域特征和所述关系标签特征进行关系多标签分类,以生成全开放词表3d场景图。

6、在一种可能的实施方式中,利用多视角rgb/rgbd图生成3d目标位置,并根据所述3d目标位置获取3d实体区域特征,以及结合实体、局部、全局特征得到3d融合关系区域特征,包括以下步骤:

7、利用多视角rgb/rgbd图生成每个视角的2d目标位置,将所述2d目标位置投影到3d空间并融合得到3d目标位置;

8、根据所述2d目标位置获取2d实体区域特征,并且根据所述3d目标位置选取若干个视角的2d实体区域特征作为3d实体区域特征;

9、结合实体、局部、全局特征得到2d融合关系区域特征,并且根据所述3d目标位置选取若干个视角的2d融合关系区域特征作为3d融合关系区域特征。

10、在一种可能的实施方式中,在利用多视角rgb/rgbd图生成全开放词表3d场景图时,通过如下方式训练可学习的属性提示向量,包括以下步骤:

11、将属性、父属性和一系列可学习的属性提示向量一起作为vlm文本编码器的输入得到属性标签特征;

12、根据标注的目标框从单个视角的rgb全图裁剪出目标区域作为裁剪实体区域图,且将所述裁剪实体区域图经过vlm图像编码器进行编码处理,得到裁剪实体区域图特征;

13、将属性标签特征和所述裁剪实体区域图特征输入至分类预测模块计算两者的相似度,得到属性多标签分类预测结果。

14、在一种可能的实施方式中,在利用多视角rgb/rgbd图生成全开放词表3d场景图时,通过如下方式训练可学习的关系提示向量,包括以下步骤:

15、将关系类别和一系列可学习的关系提示向量一起作为vlm文本编码器的输入得到关系标签特征;

16、根据标注的目标框从单个视角的rgb全图裁剪出目标区域作为裁剪实体区域图,以及从单个视角的rgb全图上裁剪出任意两个目标框并集的最小外接框区域作为裁剪关系区域图;

17、将rgb全图、裁剪关系区域图和对应的两个实体的裁剪实体区域图分别经过vlm图像编码器进行编码,得到全图特征、裁剪关系区域图特征以及两个裁剪实体区域图特征,且经过特征融合模块进行融合得到融合的关系图特征;

18、将所述关系标签特征和所述融合的关系图特征输入至分类预测模块计算两者的相似度,得到关系多标签分类预测结果。

19、在一种可能的实施方式中,在利用多视角rgb/rgbd图生成全开放词表3d场景图时,利用类不可知的2d区域生成器生成每个视角的2d目标位置,并且根据所述2d目标位置获取2d实体区域特征,以及结合实体、局部、全局特征得到2d融合关系区域特征,其中通过如下方式训练类不可知的2d区域生成器,包括以下步骤:

20、基于输入的单个视角rgb彩色图,或者基于输入的单个视角rgb彩色图和深度图,得到多尺度特征图;

21、在多尺度特征图上接框预测头,框预测头输出2d目标框和目标置信度预测值,特征图和2d目标框坐标输入掩码预测头,得到掩码预测值;

22、根据2d目标框坐标在特征图上提取2d实体区域特征,以及在特征图上提取全图框、任意两个2d目标框、两个2d目标框最小包围框的特征并进行融合得到2d融合关系区域特征。

23、在一种可能的实施方式中,在利用3d点云生成全开放词表3d场景图时,通过如下方式训练可学习的属性提示向量和关系提示向量,均包括以下步骤:

24、将标注的3d目标框投影到每个视角图像上得到2d目标框;

25、根据标注的目标框从每个视角的rgb全图裁剪出目标区域作为多视角裁剪实体区域图;

26、多视角裁剪实体区域图分别经过vlm图像编码器编码后取平均,得到融合的多视角裁剪实体区域图特征。

27、在利用3d点云生成全开放词表3d场景图时,利用类不可知的3d区域生成器生成3d目标位置,并根据所述3d目标位置获取3d实体区域特征,以及结合实体、局部、全局特征得到3d融合关系区域特征,其中通过如下方式训练类不可知的3d区域生成器,包括以下步骤:

28、3d点云经过3d区域生成器得到目标置信度,3d目标框坐标和掩码,并经过3d节点编码器得到初始的节点特征,以及经过3d边缘编码器得到初始的边缘特征;

29、所述初始的节点特征和所述边缘特征经过图神经网络得到更新后的节点特征和边缘特征,并分别作为3d实体区域特征和3d融合关系区域特征。

30、第二方面,本技术提供一种全开放词表3d场景图生成装置,所述装置包括:

31、第一生成模块,用于利用多视角rgb/rgbd图或者3d点云生成3d目标位置,并根据所述3d目标位置获取3d实体区域特征,以及结合实体、局部、全局特征得到3d融合关系区域特征;

32、第二生成模块,用于将目标类别作为一种超级属性,并将自定义的属性和父属性标签结合学习好的属性提示向量输入至视觉语言模型vlm文本编码器,得到属性标签特征,且将自定义的关系标签结合学习好的关系提示向量输入至视觉语言模型vlm文本编码器,得到关系标签特征;

33、分类模块,用于利用所述3d实体区域特征和所述属性标签特征进行属性多标签分类,以及利用所述3d融合关系区域特征和所述关系标签特征进行关系多标签分类,以生成全开放词表3d场景图。

34、第三方面,本技术提供一种电子设备,包括:处理器、存储器和总线,所述存储器存储有所述处理器可执行的机器可读指令,当电子设备运行时,所述处理器与所述存储器之间通过总线通信,所述机器可读指令被所述处理器执行时执行如第一方面任一所述的全开放词表3d场景图生成方法的步骤。

35、第四方面,本技术提供一种计算机可读存储介质,该计算机可读存储介质上存储有计算机程序,该计算机程序被处理器运行时执行如第一方面任一所述的全开放词表3d场景图生成方法的步骤。

36、本实施例提供的一种全开放词表3d场景图生成方法、装置、设备及介质,以多视角rgb/rgbd图或者3d点云作为输入,利用更为准确的空间信息,增强模型对空间的感知能力,提高模型预测的准确性;并且结合实体、局部、全局特征得到3d融合关系区域特征,避免关系预测过于片面,提高关系预测的准确性;同时输出目标的3d位置,对于机器人导航等应用更有利用价值。

- 还没有人留言评论。精彩留言会获得点赞!