多任务推荐模型的训练方法、资源推荐方法、装置及设备与流程

本公开涉及计算机,特别涉及一种多任务推荐模型的训练方法、资源推荐方法、装置及设备。

背景技术:

1、随着互联网技术的发展,在多媒体资源推荐系统中,推荐的目的一般是多样的,可能既考虑用户是否会观看,又会考虑用户是否会点赞等,从而使得推荐是多任务的。然而,在对多任务推荐模型进行训练的过程中,不同任务对应的梯度可能存在方向冲突和幅度冲突。其中,在存在幅度冲突时,不同任务之间的梯度幅度差距较大,导致多任务推荐模型对梯度幅度较大的任务学习的比较好,而对梯度幅度较小的任务学习的比较差,从而使得多任务推荐模型在推荐多媒体资源时会主要考虑梯度幅度较大的任务对多媒体资源的预测结果,降低了多任务推荐模型的准确度。在存在方向冲突时,不同任务之间的梯度方向相互冲突,导致多任务模型学习不到梯度方向相互冲突的任务,从而使得多任务推荐模型在推荐多媒体资源时考虑不到梯度方向相互冲突的任务对多媒体资源的预测结果,降低了多任务推荐模型的准确度。因此,如何解决多任务推荐模型训练过程中多个任务对应的梯度存在的幅度冲突和方向冲突,是一个亟需解决的技术问题。

技术实现思路

1、本公开提供一种多任务推荐模型的训练方法、资源推荐方法、装置及设备,能够在梯度上实现幅度平衡和全局方向平衡,以解决多任务推荐模型训练过程中多个任务对应的梯度存在的幅度冲突和方向冲突,从而提高多任务推荐模型的准确度。本公开的技术方案如下:

2、根据本公开实施例的一方面,提供了一种多任务推荐模型的训练方法,包括:

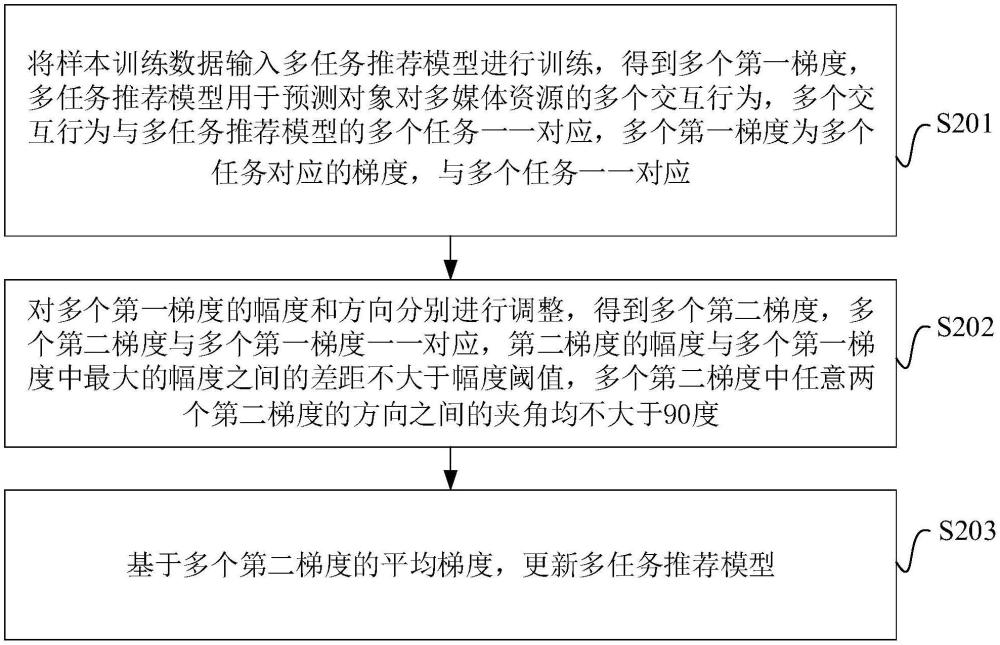

3、将样本训练数据输入多任务推荐模型进行训练,得到多个第一梯度,所述多任务推荐模型用于预测对象对多媒体资源的多个交互行为,所述多个交互行为与所述多任务推荐模型的多个任务一一对应,所述多个第一梯度为所述多个任务对应的梯度,与所述多个任务一一对应;

4、对所述多个第一梯度的幅度和方向分别进行调整,得到多个第二梯度,所述多个第二梯度与所述多个第一梯度一一对应,所述第二梯度的幅度与所述多个第一梯度中最大的幅度之间的差距不大于幅度阈值,所述多个第二梯度中任意两个第二梯度的方向之间的夹角均不大于90度;

5、基于所述多个第二梯度的平均梯度,更新所述多任务推荐模型。

6、根据本公开实施例的另一方面,提供了一种资源推荐方法,包括:

7、获取目标对象的对象特征和多个目标多媒体资源的资源特征;

8、对于任一目标多媒体资源,将所述目标对象的对象特征和所述目标多媒体资源的资源特征输入多任务推荐模型进行处理,得到所述目标对象对所述目标多媒体资源的多个预测交互行为,所述多任务推荐模型基于上述多任务推荐模型的训练方法训练得到;

9、基于所述多个预测交互行为,确定所述目标多媒体资源的推荐概率;

10、基于所述多个目标多媒体资源的推荐概率,将至少一个目标多媒体资源推荐给所述目标对象。

11、根据本公开实施例的另一方面,提供了一种多任务推荐模型的训练装置,包括:

12、训练单元,被配置为将样本训练数据输入多任务推荐模型进行训练,得到多个第一梯度,所述多任务推荐模型用于预测对象对多媒体资源的多个交互行为,所述多个交互行为与所述多任务推荐模型的多个任务一一对应,所述多个第一梯度为所述多个任务对应的梯度,与所述多个任务一一对应;

13、调整单元,被配置为对所述多个第一梯度的幅度和方向分别进行调整,得到多个第二梯度,所述多个第二梯度与所述多个第一梯度一一对应,所述第二梯度的幅度与所述多个第一梯度中最大的幅度之间的差距不大于幅度阈值,所述多个第二梯度中任意两个第二梯度的方向之间的夹角均不大于90度;

14、更新单元,被配置为基于所述多个第二梯度的平均梯度,更新所述多任务推荐模型。

15、在一些实施例中,所述样本训练数据包括多个样本对象的对象特征、多个样本多媒体资源的资源特征以及所述多个样本对象对所述多个样本多媒体资源的多个历史交互行为;

16、所述训练单元,被配置为将所述样本训练数据输入所述多任务推荐模型进行处理,得到所述多个样本对象对所述多个样本多媒体资源的多个预测交互行为;基于所述多个历史交互行为和所述多个预测交互行为,确定所述多个任务对应的多个训练损失,每个任务对应的训练损失用于指示所述任务对应的历史交互行为和预测交互行为之间的差异;基于所述多个训练损失,确定所述多个第一梯度。

17、在一些实施例中,所述调整单元,包括:

18、幅度调整子单元,被配置为对于任一第一梯度,基于目标第一梯度,对所述第一梯度的幅度进行调整,得到所述第一梯度对应的中间梯度,所述目标第一梯度为所述多个第一梯度中幅度最大的梯度,所述中间梯度的幅度与所述目标第一梯度的幅度之间的差距不大于所述幅度阈值;

19、方向调整子单元,被配置为基于至少一个目标中间梯度,对所述中间梯度的方向进行调整,得到所述第二梯度,所述目标中间梯度为所述多个第一梯度对应的中间梯度中与所述中间梯度之间的夹角大于90度的梯度。

20、在一些实施例中,所述幅度调整子单元,被配置为基于所述目标第一梯度的幅度和所述第一梯度的幅度,确定目标倍数,所述目标倍数用于反映所述第一梯度和所述目标第一梯度之间的幅度差距,所述幅度调整参数用于反映幅度调整后的所述第一梯度与所述目标第一梯度之间的幅度差距,所述幅度调整权重与所述目标倍数正相关,与所述幅度调整参数正相关;基于所述目标倍数和幅度调整参数,确定幅度调整权重;基于所述幅度调整权重,对所述第一梯度进行加权处理,得到所述第一梯度对应的中间梯度。

21、在一些实施例中,所述方向调整子单元,被配置为基于所述至少一个目标中间梯度、所述中间梯度以及方向调整参数,确定方向调整权重,所述方向调整参数用于反映方向调整后的所述中间梯度和任一所述目标中间梯度之间的夹角,所述方向调整权重与所述中间梯度和任一所述目标中间梯度之间的夹角正相关,与所述方向调整参数正相关;基于所述方向调整权重,对所述至少一个目标中间梯度和所述中间梯度进行加权求和,得到所述第二梯度。

22、在一些实施例中,所述方向调整子单元,被配置为基于所述至少一个目标中间梯度的幅度、所述中间梯度的幅度以及所述方向调整参数,确定投影向量,所述投影向量用于反映方向调整后的所述中间梯度和任一所述目标中间梯度之间的内积;基于所述投影向量、所述至少一个目标中间梯度以及所述中间梯度,确定所述方向调整权重。

23、在一些实施例中,所述投影向量包括至少一个元素,所述至少一个元素与所述至少一个目标中间梯度一一对应;

24、所述方向调整子单元,被配置为对于任一目标中间梯度,将所述目标中间梯度的幅度、所述中间梯度的幅度以及所述方向调整参数相乘,得到所述投影向量中的所述目标中间梯度对应的元素。

25、在一些实施例中,所述方向调整权重包括至少一个元素,所述至少一个元素与所述至少一个目标中间梯度一一对应;

26、所述方向调整子单元,被配置为对于任一目标中间梯度,基于所述目标中间梯度,确定第一乘积,所述第一乘积为所述目标中间梯度与所述目标中间梯度的转置的乘积;基于所述目标中间梯度和所述中间梯度,确定第二乘积,所述第二乘积为所述目标中间梯度和所述中间梯度的转置的乘积;将所述投影向量中的所述目标中间梯度对应的元素减去所述第二乘积得到的差值除以所述第一乘积,得到所述方向调整权重中所述目标中间梯度对应的元素。

27、根据本公开实施例的另一方面,提供了一种资源推荐装置,包括:

28、获取单元,被配置为获取目标对象的对象特征和多个目标多媒体资源的资源特征;

29、预测单元,被配置为对于任一目标多媒体资源,将所述目标对象的对象特征和所述目标多媒体资源的资源特征输入多任务推荐模型进行处理,得到所述目标对象对所述目标多媒体资源的多个预测交互行为,所述多任务推荐模型基于上述多任务推荐模型的训练方法训练得到;

30、确定单元,被配置为基于所述多个预测交互行为,确定所述目标多媒体资源的推荐概率;

31、推荐单元,被配置为基于所述多个目标多媒体资源的推荐概率,将至少一个目标多媒体资源推荐给所述目标对象。

32、根据本公开实施例的另一方面,提供了一种电子设备,该电子设备包括:

33、一个或多个处理器;

34、用于存储该处理器可执行程序代码的存储器;

35、其中,该处理器被配置为执行该程序代码,以实现上述多任务推荐模型的训练方法,或实现上述资源推方法。

36、根据本公开实施例的另一方面,提供了一种计算机可读存储介质,当该计算机可读存储介质中的程序代码由电子设备的处理器执行时,使得电子设备能够执行上述多任务推荐模型的训练方法,或执行上述资源推方法。

37、根据本公开实施例的另一方面,提供了一种计算机程序产品,包括计算机程序,该计算机程序被处理器执行时实现上述多任务推荐模型的训练方法,或实现上述资源推方法。

38、本公开实施例提供了一种多任务推荐模型的训练方法,通过对多任务推荐模型的多个任务对应的梯度的幅度和方向分别进行调整,能够确保每个任务对应的梯度幅度在合理范围内,避免多个任务对应的梯度之间存在较大的幅度差距。同时,还能够在对任一任务对应的梯度的方向进行调整时,同时考虑与该梯度的方向相互冲突的所有任务对应的梯度,以确保梯度之间的全局非冲突。上述方案能够在梯度上实现幅度平衡和全局方向平衡,以解决多任务推荐模型训练过程中多个任务对应的梯度存在的幅度冲突和方向冲突,从而提高多任务推荐模型的准确度。

39、应当理解的是,以上的一般描述和后文的细节描述仅是示例性和解释性的,并不能限制本公开。

- 还没有人留言评论。精彩留言会获得点赞!