一种带有注意力机制批量训练的树循环神经网络算法的制作方法

1.本发明涉及计算机科学中深度学习领域,尤其涉及深度学习中神经网络的加速训练,更具体地说,本发明涉及一种带有注意力机制批量训练的树循环神经网络算法。

背景技术:

2.现阶段,对于规模养殖场病毒监测,尚未有技术方案采用无人机巡检对养殖场内外监测进行巡检病毒采样监测;通过无接触采集对养殖场入口进行隔离采集监测尚需进一步解决;如何对养殖群远程测温、如何进行全面无接触采集检测、如何进行养殖群监测等问题尚需解决;如何根据监测结果进行智能化控制,并及时安全彻底的进行处理清除病毒仍需改进;因此,有必要提出一种带有注意力机制批量训练的树循环神经网络算法,以至少部分地解决现有技术中存在的问题。

技术实现要素:

3.在发明内容部分中引入了一系列简化形式的概念,这将在具体实施方式部分中进一步详细说明。本发明的发明内容部分并不意味着要试图限定出所要求保护的技术方案的关键特征和必要技术特征,更不意味着试图确定所要求保护的技术方案的保护范围。

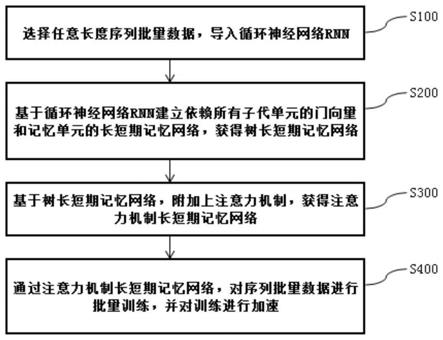

4.为至少部分地解决上述问题,本发明提供了一种带有注意力机制批量训练的树循环神经网络算法,包括:

5.s100、选择任意长度序列批量数据,导入循环神经网络rnn;

6.s200、基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;

7.s300、基于树长短期记忆网络,附加上注意力机制,获得注意力机制长短期记忆网络;

8.s400、通过注意力机制长短期记忆网络,对序列批量数据进行批量训练,并对训练进行加速。

9.优选的,s100包括:

10.s101、建立t个训练数据,将t个训练数据分为多个小批量数据;

11.s102、将步骤s101所述的小批量数据分成多份数据集;

12.s103、根据训练任务选择损失函数,并选择优化器;导入循环神经网络rnn。

13.优选的,s200包括:

14.s201、将循环神经网络rnn的序列变量输入变为树变量输入;

15.s202、对每一个子代k,都建立一个遗忘门f

jk

,选择性包含各子代信息;

16.s203、通过选择性包含各子代信息的循环神经网络rnn运算门,建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络。

17.优选的,s300包括:

18.s301、给定隐藏层状态h1,...,hn,给每个赋予一个权重ak,从而生成一个加权值的

向量g;

19.s302、通过注意力机制多层计算,得到新隐藏层向量

20.s303、用置换树长短期记忆网络中的原隐藏层向量获得注意力机制长短期记忆网络。

21.优选的,s400包括:

22.s401、首先,为每个小批量数据构建一个元树,汇总元树的所有数据;

23.s402、然后,对元树内的数据进行高度分类;聚合全隐藏层向量h内的所有矩阵乘法。

24.s403、依次将小批量数据导入注意力机制长短期记忆网络进行并行优化训练;根据批量训练算法进行并行计算,当训练集和交叉验证集上的损失不再下降或者在很小的范围内波动时,完成训练。

25.优选的,s100还包括:

26.s111、建立t个训练数据包括:设置其中,t为全部训练数据个数,ti为第i个训练数据,yi为第i个输出数据,i为1~t的正整数;多个小批量数据个数设置为n个,设置每个小批量数据包括m个数据;

27.s112、每个小批量数据表示为:其中,tij为小批量数据中的第j个训练数据,yij为小批量数据中的第j个输出数据,m为小批量数据中的数据个数,小批量数据中,i为1~m的正整数、j为1~n的正整数,j为属于第j个小批量;

28.s113、多份数据集包括:训练集数据、测试集数据和交叉验证集数据。

29.优选的,s200还包括:

30.s211、建立数据序列长短期记忆网络;定义每个时间步t的长短期记忆网络的转移函数,公式如下:

31.i

t

=σ(w(i)x

t

+u(i)h

t-1

+b(i))

32.f

t

=σ(w

(f)

x

t

+u

(f)ht-1

+b

(f)

)

33.o

t

=σ(w

(o)

x

t

+u

(o)ht-1

+b

(o)

)

34.u

t

=tanh(w

(u)

x

t

+u

(u)ht-1

+b

(u)

)

35.c

t

=i

t

⊙ut

+f

t

⊙ct-1

36.h

t

=o

t

⊙

tanh(c

t

)

37.其中,i

t

为一个输入门,f

t

为一个遗忘门,o

t

为一个输出门,u

t

为tanh层候选单元,c

t

为一个记忆单元,c

t-1

为记忆单元前一个状态向量,h

t

为一个隐状态,ht-1为隐状态的前一个状态向量,i

t

为门向量,f

t

和o

t

为概率值,其值都在[0,1]范围内,x

t

为当前时间步的输入,σ为sigmoid函数,σ=1/(1+e-t

),w(i)为输入门权重,u(i)为输入门隐状态权重,b(i)为输入门偏置项,w

(f)

为遗忘门权重,u

(f)

为遗忘门隐状态权重,b

(f)

为遗忘门偏置项,w

(o)

为输出门权重,u

(o)

为输出门隐状态权重,b

(o)

为输出门偏置项,w

(u)

为tanh层候选单元权重,u

(u)

为tanh层候选单元隐状态权重,b

(u)

为tanh层候选单元偏置项,tanh为双曲正切函数,

⊙

为驻点乘法;通过遗忘门控制前面哪个记忆单元被遗忘,输入门控制每个单元要更新多少,输出门控制内部记忆状态的输出;

[0038]

s212、根据门控的值对于每个向量元素的变量都不同进行模型学习,表示多个信

息时间尺度;将变量输入由序列变成树,创建树长短期记忆网络;树长短期记忆网络包括:门向量和记忆单元依赖所有的子代单元;对于每一个子代k包含一个遗忘门fjk;网络单元选择性的包含每个子代得信息;树长短期记忆网络算法计算公式如下:

[0039][0040][0041]fjk

=σ(wfxj+ufhk+bf)

[0042][0043][0044][0045]hj

=oj⊙

tanh(cj)

[0046]

其中,为树长短期记忆网络节点j的原隐藏层向量,hk为第k个隐藏层向量,ij为节点j输入门,f

jk

为节点j遗忘门,oj为节点j输出门,uj为节点j tanh层候选单元,cj为节点j记忆单元,ck为记忆单元第k个状态向量,hj为节点j隐状态,ht-1为隐状态的前一个状态向量,i

t

为门向量,f

jk

和oj为概率值,其值都在[0,1]范围内,xj为节点j时间步的输入,σ为sigmoid函数,σ=1/(1+e-t

),wi为节点j输入门权重,ui为节点j输入门隐状态权重,bi为节点j输入门偏置项,wf为节点j遗忘门权重,uf为节点j遗忘门隐状态权重,bf为节点j遗忘门偏置项,wo为节点j输出门权重,uo为节点j输出门隐状态权重,bo为节点j输出门偏置项,wu为节点j tanh层候选单元权重,uu为节点j tanh层候选单元隐状态权重,bu为节点j tanh层候选单元偏置项,tanh为双曲正切函数,

⊙

为驻点乘法;定义cj是节点j的所有子代的集合;k∈cj;通过上述公式,获得树长短期记忆网络。

[0047]

优选的,s302包括:

[0048]

s3021、计算每个子代的隐藏层状态向量mk,计算公式如下:

[0049]

mk=tanh(w

mhk

+bm)

[0050]

s3022、计算每一个隐藏层状态的注意力概率,计算公式如下:

[0051][0052]

s3023、计算加权值的向量g,计算公式如下:

[0053][0054]

s3024、得到新隐藏层向量计算公式如下:

[0055][0056]

其中,mk为每个子代的隐藏层状态向量,ak为每一个隐藏层状态的注意力概率,g为加权值的向量,为新隐藏层向量,其余字母和上述步骤相同字母代表的含义相同;算法每小批量的矩阵乘法的数量从m1*n1个降低到logn1,m1为每个小批量内树的个数,n1为节点的数量。

[0057]

优选的,s103包括:

[0058]

s1031、根据训练任务,构建训练样本,构成训练样本对;所述训练样本由自然语言的语句序列和含噪声语言的语句序列组成,将自然语言的语句序列和含噪声的语句序列构成训练样本对;

[0059]

s1032、采用循环神经网络rnn提取训练样本的深度卷积特征,所述循环神经网络rnn包括主训练网络部分和判别网络部分;

[0060]

s1033、将训练样本输入主训练网络部分,且在自然语言的语句序列分支网络和含噪声语句序列分支网络的每层中间层上进行融合,所述主训练网络部分输出预测的去除噪声的语句序列;

[0061]

s1034、将主训练网络部分输出的预测的去除噪声的语句序列和预测的自然语言的语句序列以及标准语句输入判别网络部分,然后利用损失函数计算预测值与标准值之间的差异,并利用sgd优化器对损失值进行优化,迭代计算,直至损失值不再发散时步骤完成。

[0062]

优选的,s403包括:

[0063]

s4031、依次获取小批量带噪数据和小批量标准数据;计算所述小批量带噪数据的时频隐蔽值标签,在注意力机制长短期记忆网络中设定所述小批量带噪数据的时频隐蔽值标签为训练目标,并将经过预设处理的仿真带噪数据输入至所述注意力机制长短期记忆网络中进行训练;

[0064]

s4032、利用聚类的方式估计所述小批量带噪数据的软时频隐蔽值标签,在所述注意力机制长短期记忆网络中设定所述小批量标准数据的软时频隐蔽值标签为所述小批量标准数据的训练目标,并将经过预设处理的真实带噪数据输入至所述注意力机制长短期记忆网络中进行训练,至训练集和交叉验证集上的损失不再下降或者在很小的范围内波动时,完成训练。

[0065]

相比现有技术,本发明至少包括以下有益效果:

[0066]

本发明一种带有注意力机制批量训练的树循环神经网络算法,通过选择任意长度序列批量数据,导入循环神经网络rnn;基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;基于树长短期记忆网络,附加上注意力机制,获得注意力机制长短期记忆网络;通过注意力机制长短期记忆网络,对序列批量数据进行批量训练,并对训练进行加速;根据训练任务选择损失函数,并选择优化器;将循环神经网络rnn的序列变量输入变为树变量输入;对每一个子代k,都建立一个遗忘门f

jk

,选择性包含各子代信息;基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;通过多层计算,获得注意力机制长短期记忆网络;依次将小批量数据导入注意力机制长短期记忆网络进行并行优化训练;根据批量训练算法进行并行计算,能够批量训练,防止梯度爆炸,树结构也广泛存在于自然语言任务中,在很多任务上比单纯的循环神经网络更加有效,能够加速完成训练效率和提高训练精度。

[0067]

本发明所述的一种带有注意力机制批量训练的树循环神经网络算法,本发明的其它优点、目标和特征将部分通过下面的说明体现,部分还将通过对本发明的研究和实践而为本领域的技术人员所理解。

附图说明

[0068]

附图用来提供对本发明的进一步理解,并且构成说明书的一部分,与本发明的实施例一起用于解释本发明,并不构成对本发明的限制。在附图中:

[0069]

图1为本发明所述的一种带有注意力机制批量训练的树循环神经网络算法步骤图。

[0070]

图2为本发明所述的一种带有注意力机制批量训练的树循环神经网络算法一实施例图。

[0071]

图3为本发明所述的一种带有注意力机制批量训练的树循环神经网络算法另一实施例图。

[0072]

图4为本发明所述的一种带有注意力机制批量训练的树循环神经网络算法的树循环神经网络示意图。

[0073]

图5为本发明所述的一种带有注意力机制批量训练的树循环神经网络算法带注意力机制的树循环神经网络示意图。

[0074]

图6为本发明所述的一种带有注意力机制批量训练的树循环神经网络算法批量动态训练示意图。

具体实施方式

[0075]

下面结合附图以及实施例对本发明做进一步的详细说明,以令本领域技术人员参照说明书文字能够据以实施。如图1-6所示,本发明提供了一种带有注意力机制批量训练的树循环神经网络算法,包括:

[0076]

s100、选择任意长度序列批量数据,导入循环神经网络rnn;

[0077]

s200、基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;

[0078]

s300、基于树长短期记忆网络,附加上注意力机制,获得注意力机制长短期记忆网络;

[0079]

s400、通过注意力机制长短期记忆网络,对序列批量数据进行批量训练,并对训练进行加速。

[0080]

上述技术方案的工作原理为:选择任意长度序列批量数据,导入循环神经网络rnn;基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;基于树长短期记忆网络,附加上注意力机制,获得注意力机制长短期记忆网络;通过注意力机制长短期记忆网络,对序列批量数据进行批量训练,并对训练进行加速。

[0081]

上述技术方案的有益效果为:通过选择任意长度序列批量数据,导入循环神经网络rnn;基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;基于树长短期记忆网络,附加上注意力机制,获得注意力机制长短期记忆网络;通过注意力机制长短期记忆网络,对序列批量数据进行批量训练,并对训练进行加速;根据训练任务选择损失函数,并选择优化器;将循环神经网络rnn的序列变量输入变为树变量输入;对每一个子代k,都建立一个遗忘门f

jk

,选择性包含各子代信息;基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树

长短期记忆网络;通过多层计算,获得注意力机制长短期记忆网络;依次将小批量数据导入注意力机制长短期记忆网络进行并行优化训练;根据批量训练算法进行并行计算,能够批量训练,防止梯度爆炸,树结构也广泛存在于自然语言任务中,在很多任务上比单纯的循环神经网络更加有效,能够加速完成训练效率和提高训练精度。

[0082]

在一个实施例中,s100包括:

[0083]

s101、建立t个训练数据,将t个训练数据分为多个小批量数据;

[0084]

s102、将步骤s101所述的小批量数据分成多份数据集;

[0085]

s103、根据训练任务选择损失函数,并选择优化器;导入循环神经网络rnn。

[0086]

上述技术方案的工作原理为:s100包括:

[0087]

s101、建立t个训练数据,将t个训练数据分为多个小批量数据;

[0088]

s102、将步骤s101所述的小批量数据分成多份数据集;

[0089]

s103、根据训练任务选择损失函数,并选择优化器;导入循环神经网络rnn。

[0090]

上述技术方案的有益效果为:通过选择任意长度序列批量数据,导入循环神经网络rnn;通过多层计算,获得注意力机制长短期记忆网络;依次将小批量数据导入注意力机制长短期记忆网络进行并行优化训练;根据批量训练算法进行并行计算,能够批量训练。

[0091]

在一个实施例中,s200包括:

[0092]

s201、将循环神经网络rnn的序列变量输入变为树变量输入;

[0093]

s202、对每一个子代k,都建立一个遗忘门f

jk

,选择性包含各子代信息;

[0094]

s203、通过选择性包含各子代信息的循环神经网络rnn运算门,建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络。

[0095]

上述技术方案的工作原理为:

[0096]

s201、将循环神经网络rnn的序列变量输入变为树变量输入;

[0097]

s202、对每一个子代k,都建立一个遗忘门f

jk

,选择性包含各子代信息;

[0098]

s203、通过选择性包含各子代信息的循环神经网络rnn运算门,建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络。

[0099]

上述技术方案的有益效果为:基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;对每一个子代k,都建立一个遗忘门f

jk

,选择性包含各子代信息;基于循环神经网络rnn建立依赖所有子代单元的门向量和记忆单元的长短期记忆网络,获得树长短期记忆网络;通过多层计算,获得注意力机制长短期记忆网络。

[0100]

在一个实施例中,s300包括:

[0101]

s301、给定隐藏层状态h1,

…

,hn,给每个赋予一个权重ak,从而生成一个加权值的向量g;

[0102]

s302、通过注意力机制多层计算,得到新隐藏层向量

[0103]

s303、用置换树长短期记忆网络中的原隐藏层向量获得注意力机制长短期记忆网络。

[0104]

上述技术方案的工作原理为:

[0105]

s301、给定隐藏层状态h1,

…

,hn,给每个赋予一个权重ak,从而生成一个加权值的

向量g;

[0106]

s302、通过注意力机制多层计算,得到新隐藏层向量

[0107]

s303、用置换树长短期记忆网络中的原隐藏层向量获得注意力机制长短期记忆网络。

[0108]

上述技术方案的有益效果为:基于树长短期记忆网络,附加上注意力机制,获得注意力机制长短期记忆网络;根据训练任务选择损失函数,并选择优化器;通过多层计算,获得注意力机制长短期记忆网络;树结构也广泛存在于自然语言任务中,在很多任务上比单纯的循环神经网络更加有效;给定隐藏层状态h1,

…

,hn,给每个赋予一个权重ak,从而生成一个加权值的向量g;通过注意力机制多层计算,得到新隐藏层向量用置换树长短期记忆网络中的原隐藏层向量获得注意力机制长短期记忆网络;通过注意力机制长短期记忆网络,对序列批量数据进行批量训练,并对训练进行加速。

[0109]

在一个实施例中,s400包括:

[0110]

s401、首先,为每个小批量数据构建一个元树,汇总元树的所有数据;

[0111]

s402、然后,对元树内的数据进行高度分类;聚合全隐藏层向量h内的所有矩阵乘法。

[0112]

s403、依次将小批量数据导入注意力机制长短期记忆网络进行并行优化训练;根据批量训练算法进行并行计算,当训练集和交叉验证集上的损失不再下降或者在很小的范围内波动时,完成训练。

[0113]

上述技术方案的工作原理为:

[0114]

s401、首先,为每个小批量数据构建一个元树,汇总元树的所有数据;

[0115]

s402、然后,对元树内的数据进行高度分类;聚合全隐藏层向量h内的所有矩阵乘法。

[0116]

s403、依次将小批量数据导入注意力机制长短期记忆网络进行并行优化训练;根据批量训练算法进行并行计算,当训练集和交叉验证集上的损失不再下降或者在很小的范围内波动时,完成训练。

[0117]

上述技术方案的有益效果为:通过注意力机制长短期记忆网络,对序列批量数据进行批量训练,并对训练进行加速;依次将小批量数据导入注意力机制长短期记忆网络进行并行优化训练;根据批量训练算法进行并行计算,能够批量训练,防止梯度爆炸,树结构也广泛存在于自然语言任务中,在很多任务上比单纯的循环神经网络更加有效,能够加速完成训练效率和提高训练精度。

[0118]

在一个实施例中,s100还包括:

[0119]

s111、建立t个训练数据包括:设置其中,t为全部训练数据个数,ti为第i个训练数据,yi为第i个输出数据,i为1~t的正整数;多个小批量数据个数设置为n个,设置每个小批量数据包括m个数据;

[0120]

s112、每个小批量数据表示为:其中,tij为小批量数据中的第j个训练数据,yij为小批量数据中的第j个输出数据,m为小批量数据中的数据个数,小批量

数据中,i为1~m的正整数、j为1~n的正整数,j为属于第j个小批量;

[0121]

s113、多份数据集包括:训练集数据、测试集数据和交叉验证集数据。

[0122]

上述技术方案的工作原理为:

[0123]

s111、建立t个训练数据包括:设置其中,t为全部训练数据个数,ti为第i个训练数据,yi为第i个输出数据,i为1~t的正整数;多个小批量数据个数设置为n个,设置每个小批量数据包括m个数据;

[0124]

s112、每个小批量数据表示为:其中,tij为小批量数据中的第j个训练数据,yij为小批量数据中的第j个输出数据,m为小批量数据中的数据个数,小批量数据中,i为1~m的正整数、j为1~n的正整数,j为属于第j个小批量;

[0125]

s113、多份数据集包括:训练集数据、测试集数据和交叉验证集数据。

[0126]

上述技术方案的有益效果为:通过选择任意长度序列批量数据,导入循环神经网络rnn;其中,t为全部训练数据个数,ti为第i个训练数据,为第i个目标数据,i为1~t的正整数;多个小批量数据个数设置为n个,每个小批量数据包括m个数据;每个小批量数据表示为:其中j表示属于第j个小批量;多份数据集包括:训练集数据、测试集数据和交叉验证集数据。根据批量训练算法进行并行计算,能够批量训练。

[0127]

在一个实施例中,s200还包括:

[0128]

s211、建立数据序列长短期记忆网络;定义每个时间步t的长短期记忆网络的转移函数,公式如下:

[0129]it

=σ(w(i)x

t

+u(i)h

t-1

+b(i))

[0130]ft

=σ(w

(f)

x

t

+u

(f)ht-1

+b

(f)

)

[0131]ot

=σ(w

(o)

x

t

+u

(o)ht-1

+b

(o)

)

[0132]ut

=tanh(w

(u)

x

t

+u

(u)ht-1

+b

(u)

)

[0133]ct

=i

t

⊙ut

+f

t

⊙ct-1

[0134]ht

=o

t

⊙

tanh(c

t

)

[0135]

其中,i

t

为一个输入门,f

t

为一个遗忘门,o

t

为一个输出门,u

t

为tanh层候选单元,c

t

为一个记忆单元,c

t-1

为记忆单元前一个状态向量,h

t

为一个隐状态,ht-1为隐状态的前一个状态向量,i

t

为门向量,f

t

和o

t

为概率值,其值都在[0,1]范围内,x

t

为当前时间步的输入,σ为sigmoid函数,σ=1/(1+e-t

),w(i)为输入门权重,u(i)为输入门隐状态权重,b(i)为输入门偏置项,w

(f)

为遗忘门权重,u

(f)

为遗忘门隐状态权重,b

(f)

为遗忘门偏置项,w

(o)

为输出门权重,u

(o)

为输出门隐状态权重,b

(o)

为输出门偏置项,w

(u)

为tanh层候选单元权重,u

(u)

为tanh层候选单元隐状态权重,b

(u)

为tanh层候选单元偏置项,tanh为双曲正切函数,

⊙

为驻点乘法;通过遗忘门控制前面哪个记忆单元被遗忘,输入门控制每个单元要更新多少,输出门控制内部记忆状态的输出;

[0136]

s212、根据门控的值对于每个向量元素的变量都不同进行模型学习,表示多个信息时间尺度;将变量输入由序列变成树,创建树长短期记忆网络;树长短期记忆网络包括:门向量和记忆单元依赖所有的子代单元;对于每一个子代k包含一个遗忘门fjk;网络单元选择性的包含每个子代得信息;树长短期记忆网络算法计算公式如下:

[0137][0138][0139]fjk

=σ(wfxj+ufhk+bf)

[0140][0141][0142][0143]hj

=oj⊙

tanh(cj)

[0144]

其中,为树长短期记忆网络节点j的原隐藏层向量,hk为第k个隐藏层向量,ij为节点j输入门,f

jk

为节点j遗忘门,oj为节点j输出门,uj为节点j tanh层候选单元,cj为节点j记忆单元,ck为记忆单元第k个状态向量,hj为节点j隐状态,ht-1为隐状态的前一个状态向量,i

t

为门向量,f

jk

和oj为概率值,其值都在[0,1]范围内,xj为节点j时间步的输入,σ为sigmoid函数,σ=1/(1+e-t

),wi为节点j输入门权重,ui为节点j输入门隐状态权重,bi为节点j输入门偏置项,wf为节点j遗忘门权重,uf为节点j遗忘门隐状态权重,bf为节点j遗忘门偏置项,wo为节点j输出门权重,uo为节点j输出门隐状态权重,bo为节点j输出门偏置项,wu为节点j tanh层候选单元权重,uu为节点j tanh层候选单元隐状态权重,bu为节点j tanh层候选单元偏置项,tanh为双曲正切函数,

⊙

为驻点乘法;定义cj是节点j的所有子代的集合;k∈cj;通过上述公式,获得树长短期记忆网络。

[0145]

上述技术方案的工作原理为:

[0146]

s211、建立数据序列长短期记忆网络;定义每个时间步t的长短期记忆网络的转移函数,公式如下:

[0147]it

=σ(w(i)x

t

+u(i)h

t-1

+b(i))

[0148]ft

=σ(w

(f)

x

t

+u

(f)ht-1

+b

(f)

)

[0149]ot

=σ(w

(o)

x

t

+u

(o)ht-1

+b

(o)

)

[0150]ut

=tanh(w

(u)

x

t

+u

(u)ht-1

+b

(u)

)

[0151]ct

=i

t

⊙ut

+f

t

⊙ct-1

[0152]ht

=o

t

⊙

tanh(c

t

)

[0153]

其中,i

t

为一个输入门,f

t

为一个遗忘门,o

t

为一个输出门,u

t

为tanh层候选单元,c

t

为一个记忆单元,c

t-1

为记忆单元前一个状态向量,h

t

为一个隐状态,ht-1为隐状态的前一个状态向量,i

t

为门向量,f

t

和o

t

为概率值,其值都在[0,1]范围内,x

t

为当前时间步的输入,σ为sigmoid函数,σ=1/(1+e-t

),w(i)为输入门权重,u(i)为输入门隐状态权重,b(i)为输入门偏置项,w

(f)

为遗忘门权重,u

(f)

为遗忘门隐状态权重,b

(f)

为遗忘门偏置项,w

(o)

为输出门权重,u

(o)

为输出门隐状态权重,b

(o)

为输出门偏置项,w

(u)

为tanh层候选单元权重,u

(u)

为tanh层候选单元隐状态权重,b

(u)

为tanh层候选单元偏置项,tanh为双曲正切函数,

⊙

为驻点乘法;通过遗忘门控制前面哪个记忆单元被遗忘,输入门控制每个单元要更新多少,输出门控制内部记忆状态的输出;

[0154]

s212、根据门控的值对于每个向量元素的变量都不同进行模型学习,表示多个信

息时间尺度;将变量输入由序列变成树,创建树长短期记忆网络;树长短期记忆网络包括:门向量和记忆单元依赖所有的子代单元;对于每一个子代k包含一个遗忘门fjk;网络单元选择性的包含每个子代得信息;树长短期记忆网络算法计算公式如下:

[0155][0156][0157]fjk

=σ(wfxj+ufhk+bf)

[0158][0159][0160][0161]hj

=oj⊙

tanh(cj)

[0162]

其中,为树长短期记忆网络节点j的原隐藏层向量,hk为第k个隐藏层向量,ij为节点j输入门,f

jk

为节点j遗忘门,oj为节点j输出门,uj为节点j tanh层候选单元,cj为节点j记忆单元,ck为记忆单元第k个状态向量,hj为节点j隐状态,ht-1为隐状态的前一个状态向量,i

t

为门向量,f

jk

和oj为概率值,其值都在[0,1]范围内,xj为节点j时间步的输入,σ为sigmoid函数,σ=1/(1+e-t

),wi为节点j输入门权重,ui为节点j输入门隐状态权重,bi为节点j输入门偏置项,wf为节点j遗忘门权重,uf为节点j遗忘门隐状态权重,bf为节点j遗忘门偏置项,wo为节点j输出门权重,uo为节点j输出门隐状态权重,bo为节点j输出门偏置项,wu为节点j tanh层候选单元权重,uu为节点j tanh层候选单元隐状态权重,bu为节点j tanh层候选单元偏置项,tanh为双曲正切函数,

⊙

为驻点乘法;定义cj是节点j的所有子代的集合;k∈cj;通过上述公式,获得树长短期记忆网络。

[0163]

上述技术方案的有益效果为:建立数据序列长短期记忆网络;定义每个时间步t的长短期记忆网络的转移函数,其中,i

t

为一个输入门,f

t

为一个遗忘门,o

t

为一个输出门,c

t

为一个记忆单元,h

t

为一个隐状态,ht-1为隐状态的上一个状态向量;i

t

为门向量,f

t

和o

t

为概率值,其值都在[0,1]范围内,x

t

为当前时间步的输入,σ为sigmoid函数,σ=1/(1+e-t

),

⊙

为驻点乘法;通过遗忘门控制前面哪个记忆单元被遗忘,输入门控制每个单元要更新多少,输出门控制内部记忆状态的输出;根据门控的值对于每个向量元素的变量都不同进行模型学习,表示多个信息时间尺度;树结构也广泛存在于自然语言任务中,在很多任务上比单纯的循环神经网络更加有效,能够加速完成训练效率和提高训练精度。

[0164]

在一个实施例中,s302包括:

[0165]

s3021、计算每个子代的隐藏层状态向量mk,计算公式如下:

[0166]

mk=tanh(w

mhk

+bm)

[0167]

s3022、计算每一个隐藏层状态的注意力概率,计算公式如下:

[0168][0169]

s3023、计算加权值的向量g,计算公式如下:

[0170][0171]

s3024、得到新隐藏层向量计算公式如下:

[0172][0173]

其中,mk为每个子代的隐藏层状态向量,ak为每一个隐藏层状态的注意力概率,g为加权值的向量,为新隐藏层向量,其余字母和上述步骤相同字母代表的含义相同;算法每小批量的矩阵乘法的数量从m1*n1个降低到logn1,m1为每个小批量内树的个数,n1为节点的数量。

[0174]

上述技术方案的工作原理为:

[0175]

s3021、计算每个子代的隐藏层状态向量mk,计算公式如下:

[0176]

mk=tanh(w

mhk

+bm)

[0177]

s3022、计算每一个隐藏层状态的注意力概率,计算公式如下:

[0178][0179]

s3023、计算加权值的向量g,计算公式如下:

[0180][0181]

s3024、得到新隐藏层向量计算公式如下:

[0182][0183]

其中,mk为每个子代的隐藏层状态向量,ak为每一个隐藏层状态的注意力概率,g为加权值的向量,为新隐藏层向量,其余字母和上述步骤相同字母代表的含义相同;算法每小批量的矩阵乘法的数量从m1*n1个降低到logn1,m1为每个小批量内树的个数,n1为节点的数量。

[0184]

上述技术方案的有益效果为:首先对计算每个子代的隐藏层状态向量mk;然后,计算每一个隐藏层状态的注意力概率;之后,计算加权值的向量g;最后,得到新隐藏层向量

[0185]

在一个实施例中,s103包括:

[0186]

s1031、根据训练任务,构建训练样本,构成训练样本对;所述训练样本由自然语言的语句序列和含噪声语言的语句序列组成,将自然语言的语句序列和含噪声的语句序列构成训练样本对;

[0187]

s1032、采用循环神经网络rnn提取训练样本的深度卷积特征,所述循环神经网络rnn包括主训练网络部分和判别网络部分;

[0188]

s1033、将训练样本输入主训练网络部分,且在自然语言的语句序列分支网络和含噪声语句序列分支网络的每层中间层上进行融合,所述主训练网络部分输出预测的去除噪声的语句序列;

[0189]

s1034、将主训练网络部分输出的预测的去除噪声的语句序列和预测的自然语言的语句序列以及标准语句输入判别网络部分,然后利用损失函数计算预测值与标准值之间的差异,并利用sgd优化器对损失值进行优化,迭代计算,直至损失值不再发散时步骤完成。

[0190]

上述技术方案的工作原理为:根据训练任务,构建训练样本,构成训练样本对;所

述训练样本由自然语言的语句序列和含噪声语言的语句序列组成,将自然语言的语句序列和含噪声的语句序列构成训练样本对;采用循环神经网络rnn提取训练样本的深度卷积特征,所述循环神经网络rnn包括主训练网络部分和判别网络部分;将训练样本输入主训练网络部分,且在自然语言的语句序列分支网络和含噪声语句序列分支网络的每层中间层上进行融合,所述主训练网络部分输出预测的去除噪声的语句序列;将主训练网络部分输出的预测的去除噪声的语句序列和预测的自然语言的语句序列以及标准语句输入判别网络部分,然后利用损失函数计算预测值与标准值之间的差异,并利用sgd优化器对损失值进行优化,迭代计算,直至损失值不再发散时步骤完成。

[0191]

上述技术方案的有益效果为:根据训练任务,构建训练样本,构成训练样本对;所述训练样本由自然语言的语句序列和含噪声语言的语句序列组成,将自然语言的语句序列和含噪声的语句序列构成训练样本对;采用循环神经网络rnn提取训练样本的深度卷积特征,所述循环神经网络rnn包括主训练网络部分和判别网络部分;将训练样本输入主训练网络部分,且在自然语言的语句序列分支网络和含噪声语句序列分支网络的每层中间层上进行融合,所述主训练网络部分输出预测的去除噪声的语句序列;将主训练网络部分输出的预测的去除噪声的语句序列和预测的自然语言的语句序列以及标准语句输入判别网络部分,然后利用损失函数计算预测值与标准值之间的差异,并利用sgd优化器对损失值进行优化,迭代计算,直至损失值不再发散时步骤完成。

[0192]

在一个实施例中,s403包括:

[0193]

s4031、依次获取小批量带噪数据和小批量标准数据;计算所述小批量带噪数据的时频隐蔽值标签,在注意力机制长短期记忆网络中设定所述小批量带噪数据的时频隐蔽值标签为训练目标,并将经过预设处理的仿真带噪数据输入至所述注意力机制长短期记忆网络中进行训练;

[0194]

s4032、利用聚类的方式估计所述小批量带噪数据的软时频隐蔽值标签,在所述注意力机制长短期记忆网络中设定所述小批量标准数据的软时频隐蔽值标签为所述小批量标准数据的训练目标,并将经过预设处理的真实带噪数据输入至所述注意力机制长短期记忆网络中进行训练,至训练集和交叉验证集上的损失不再下降或者在很小的范围内波动时,完成训练。

[0195]

上述技术方案的工作原理为:依次获取小批量带噪数据和小批量标准数据;计算所述小批量带噪数据的时频隐蔽值标签,在注意力机制长短期记忆网络中设定所述小批量带噪数据的时频隐蔽值标签为训练目标,并将经过预设处理的仿真带噪数据输入至所述注意力机制长短期记忆网络中进行训练;利用聚类的方式估计所述小批量带噪数据的软时频隐蔽值标签,在所述注意力机制长短期记忆网络中设定所述小批量标准数据的软时频隐蔽值标签为所述小批量标准数据的训练目标,并将经过预设处理的真实带噪数据输入至所述注意力机制长短期记忆网络中进行训练,至训练集和交叉验证集上的损失不再下降或者在很小的范围内波动时,完成训练。

[0196]

上述技术方案的有益效果为:依次获取小批量带噪数据和小批量标准数据;计算所述小批量带噪数据的时频隐蔽值标签,在注意力机制长短期记忆网络中设定所述小批量带噪数据的时频隐蔽值标签为训练目标,并将经过预设处理的仿真带噪数据输入至所述注意力机制长短期记忆网络中进行训练;利用聚类的方式估计所述小批量带噪数据的软时频

隐蔽值标签,在所述注意力机制长短期记忆网络中设定所述小批量标准数据的软时频隐蔽值标签为所述小批量标准数据的训练目标,并将经过预设处理的真实带噪数据输入至所述注意力机制长短期记忆网络中进行训练,至训练集和交叉验证集上的损失不再下降或者在很小的范围内波动时,完成训练。

[0197]

尽管本发明的实施方案已公开如上,但其并不仅仅限于说明书和实施方式中所列运用,它完全可以被适用于各种适合本发明的领域,对于熟悉本领域的人员而言,可容易地实现另外的修改,因此在不背离权利要求及等同范围所限定的一般概念下,本发明并不限于特定的细节与这里示出与描述的图例。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1