一种基于视觉的游戏康复场景参与度行为识别方法

本发明涉及康复医学与计算机视觉领域,具体涉及一种基于视觉的游戏康复场景参与度行为识别方法。

背景技术:

1、调查显示,中风是成人致残的首位原因。多项临床研究表明,康复训练是改善中风患者运动功能、促进康复的有效途径。康复参与被定义为被激励并积极努力参与康复训练的状态。它可以反映患者对康复的态度、对任务要求的理解以及整个训练过程的有效性。既往研究表明,患者的高水平参与是促进神经重组的重要因素。即使患者不具备完成动作的能力,主动锻炼的意愿也是康复所必需的。然而,康复运动的重复性往往使患者容易感到无聊和疲劳。事实上,患者在康复训练过程中通常表现出低水平的参与行为,导致康复绩效低下和安全隐患。在传统的康复训练中,治疗师的监督和纠正可以减少患者低水平参与的影响。然而,康复医师短缺,患者经常在没有监督和纠正的情况下执行训练任务。因此,评估患者对康复训练的参与情况非常重要,这有利于康复结果的评估和训练任务的调整。

2、研究人员开发了许多评估患者参与度的方法,主要包括基于评分量表和基于生理信号的方法。采用量表的评价方法需要康复医师根据患者在康复训练过程中的参与指标进行观察和评分。这种方法不可避免地引入了医师的主观判断,增加了康复医师的工作量。康复训练期间产生的生理信号也经常用于评估患者参与度。

3、如张进华等人在中国公开发明专利cn105054927a中提供了“一种下肢康复系统中主动参与度的生物量化评估方法”,该方法通过实时检测患者的eeg信号和emg信号来计算在下肢康复系统中的主动参与度,其不足之处在于生理信号的获取依赖于可穿戴传感器,佩戴不便,在康复训练中容易给患者带来不适。

4、脑卒中患者在虚拟游戏康复训练中的低参与度行为往往伴随着许多面部和姿势行为。受这一发现的启发,本发明想利用视觉技术捕捉面部行为的变化,如眼睑运动、瞳孔运动、眼睛睁开度、头部姿势和面部疲劳表情,以直观地检测患者的主观参与。与基于生理信号的方法相比,基于视觉的方法可以以无创方式进行评估,并且不会影响患者的康复训练过程。然而,还没有相关研究将视觉技术应用于检测中风患者的参与度。

5、背景技术部分的内容仅仅是公开人所知晓的技术,并不代表本领域的现有技术。

技术实现思路

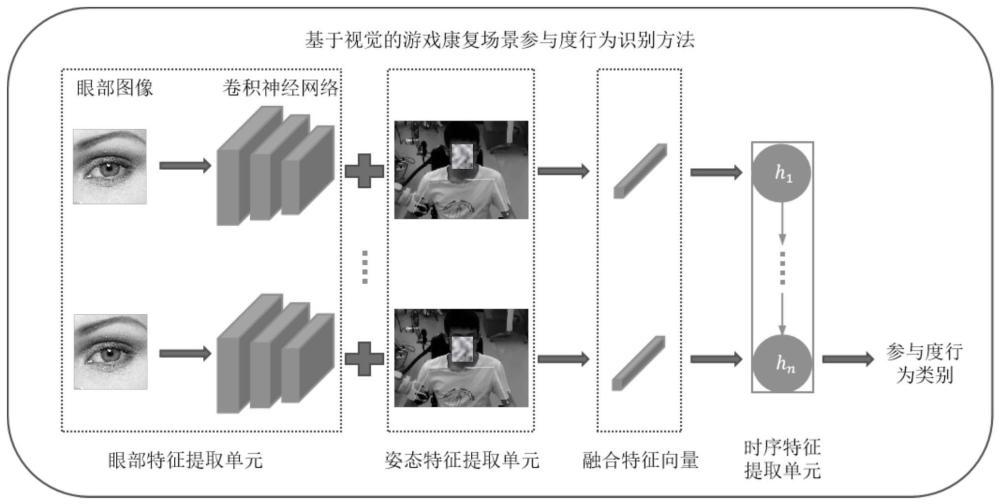

1、本发明的目的是针对现有技术中存在的技术缺陷,为了将视觉技术应用于检测中风患者的参与度,本发明提出了一种基于视觉的游戏康复场景参与度行为识别方法,实现了使用深度学习模型提取视觉图像中的参与度特征,并识别参与度行为。

2、本发明的目的至少通过如下技术方案之一实现。

3、一种基于视觉的游戏康复场景参与度行为识别方法,包括以下步骤:

4、s1、构建基于视觉的游戏康复场景参与度行为识别模型,所述参与度行为识别模型包括眼部特征提取单元、姿态特征提取单元和时序特征提取单元;

5、其中,眼部特征提取单元用于根据原始的视频帧中的截取出眼部图像,获得眼部特征向量;姿态特征提取单元用于从原始图像中提取头部姿态相关的特征点,并进行归一化操作,以获得头部姿态特征向量;时序特征提取单元中,每个视频帧中提取的眼部特征向量和头部姿态特征向量拼接成融合特征向量,一个视频的融合特征向量组输入时序神经网络,得到参与度的分类;

6、s2、对参与度行为识别模型进行训练:在游戏康复场景中采集的训练样本视频数据集中,利用服务器对参与度行为识别模型进行训练,通过降低网络损失函数优化参与度行为识别模型的参数,直至参与度行为识别模型收敛,得到训练完成的参与度行为识别模型;

7、s3、利用参与度行为识别模型在新的游戏康复场景中识别参与度行为。

8、进一步地,为了统一眼部特征提取单元输入,将从原始的视频帧中截取出的眼部图像统一调整大小。

9、进一步地,所述眼部特征提取单元包括顺次连接的第一卷积层、第一池化层、第二卷积层、第二池化层、第三卷积层和全连接层;

10、其中,从原始的视频帧中截取出眼部图像作为输入,通过第一卷积层进行特征提取,得到第一特征图;

11、第一卷积层输出的第一特征图,输入至第一池化层中进行特征降维,得到第二特征图;

12、第一池化层输出的第二特征图,输入至第二卷积层中进一步进行特征提取,得到第三特征图;

13、第二卷积层输出的第三特征图,输入至第二池化层中进行特征降维,得到第四特征图;

14、第二池化层输出的第四特征图,输入至第三卷积层中进一步进行特征提取,得到第五特征图;

15、第五特征图输入至全连接层中进行特征降维,得到输出向量。

16、进一步地,所述姿态特征提取单元中,从原始图像中提取头部姿态相关的特征点包括左肩点、右肩点、躯干顶点、鼻尖点、左眼定位点和右眼定位点,均为二维坐标;

17、其中,躯干顶点分别连接左肩点、右肩点和鼻尖点,鼻尖点分别连接左眼定位点和右眼定位点。

18、进一步地,所述姿态特征提取单元中,对6个头部姿态特征点的归一化操作,首先6个头部姿态特征点的二维坐标分别减去躯干顶点的二维坐标以获得相对坐标,将获得的6个相对坐标进行正态分布标准化处理。

19、进一步地,时序特征提取单元中,将从每个视频帧中提取的眼部特征向量和头部姿态特征向量拼接成融合特征向量,并构建一个视频的帧级的特征表示。

20、进一步地,时序特征提取单元中,将融合特征向量作为tcn时序神经网络的时间步长的输入,tcn时序神经网络最后一个时间步的输出被传递到一个全连接层和一个softmax函数,得到查询视频v的类别预测y′v和损失函数l。

21、进一步地,步骤s2具体包括以下步骤:

22、s2.1、在服务器中构建训练视频样本库,从训练样本库中选取样本视频片段作为参与度行为识别模型的输入;

23、s2.2、利用服务器执行所述眼部特征提取单元,训练样本视频片段按视频帧为单位通过眼部特征提取单元进行眼部特征向量提取,并将输出的眼部特征向量存储在特征库中;

24、s2.3、利用服务器执行所述姿态特征提取单元,训练样本视频片段按视频帧为单位通过姿态特征提取单元进行头部姿态特征向量提取,并将输出的头部姿态特征向量存储在特征库中;

25、s2.4、利用服务器执行所述时序特征提取单元,将每个视频帧的眼部特征向量和头部姿态特征向量拼接,并作为tcn时序神经网络的输入进行时序分析类别预测,得到查询视频v的类别预测y′v和损失函数l;

26、s2.5、利用服务器进行端到端方式的网络训练;参与度行为识别任务损失函数l为预测值和真实值之间的距离,将距离通过一个标准的交叉熵损失函数来最小化,即从查询视频预测类别到其真实类别;

27、s2.6、利用服务器优化目标函数,目标函数采用步骤s2.5中的损失函数l,获取局部最优网络参数作为参与度行为识别模型的网络权重。

28、进一步地,步骤s3具体包括以下步骤:

29、s3.1、利用服务器执行测试样本视频片段生成单元,对一个测试样本视频片段的所有帧进行均匀采样,将得到的视频帧集作为输入;

30、s3.2、利用参与度行为识别模型对得到的视频帧集的进行参与度行为类别。

31、与现有技术相比,本发明具有如下优点和技术效果:

32、提出了一种基于视觉的游戏康复场景参与度行为识别方法,将眼部特征和姿态特征融合实现参与度行为的识别:提出了一个眼部特征提取单元来自动提取眼部图像的高级空间特征;提出了姿态特征提取单元来提取头部空间姿态特征;引入了tcn时序特征提取单元,基于提取到的眼部和姿态空间特征进行时序建模,实现参与度行为的识别,并取得了优异的识别准确率;基于视觉的参与度行为检测方法方便快捷,不需要穿戴物和复杂的实验设置,有利于为患者康复训练进行更好的监督和反馈。

- 还没有人留言评论。精彩留言会获得点赞!