用于游乐乘坐设施的增强现实系统的制作方法

用于游乐乘坐设施的增强现实系统

1.相关申请的交叉引用本申请要求来自2018年9月24日提交的并且标题为“augmented reality system for an amusement ride”的美国临时申请(序列号62/735,754)的优先权以及其权益,所述申请的公开出于所有目的通过引用并入本文中。

技术领域

2.本公开一般涉及增强现实系统,并且更特别地涉及用于游乐乘坐设施的增强现实系统。

背景技术:

3.通常,游乐乘坐设施可以包括乘坐载运器和乘坐路径。乘坐载运器可以沿着乘坐路径移动并且可以运载客人。游乐乘坐设施还可以包括显示器,其可以提供要由客人观看的沿着乘坐路径的某些图像。例如,显示器可以提供某些动画、视频、增强现实图像和其它图像。对于某些乘坐设施,客人可以与显示器交互以控制图像。然而,由于一些游乐乘坐设施的复杂性,显示器可能不被配置成贯穿游乐乘坐设施向客人提供图像。附加地,客人在某些游乐乘坐设施上与所显示的图像交互的能力可能是有限的。

技术实现要素:

4.下面概述了在范围上与所公开的主题相称的某些实施例。这些实施例不旨在限制本公开的范围,而是这些实施例旨在仅提供某些公开的实施例的简要概述。实际上,本公开可以涵盖可以与下面阐述的实施例类似或不同的多种形式。

5.在某些实施例中,用于游乐乘坐设施的增强现实系统包括检测客人的面部的面部识别传感器、检测客人的身体的骨骼识别传感器、检测客人的存在的存在传感器以及控制器。控制器包括处理器和存储器。控制器被配置成基于从存在传感器接收的指示客人的存在的第一信号来生成增强现实动画。响应于从骨骼识别传感器接收到指示客人的身体的第二信号,控制器被配置成基于客人的身体来更新增强现实动画。此外,响应于从面部识别传感器接收到指示客人的面部的第三信号,控制器被配置成基于客人的面部来更新增强现实动画。

附图说明

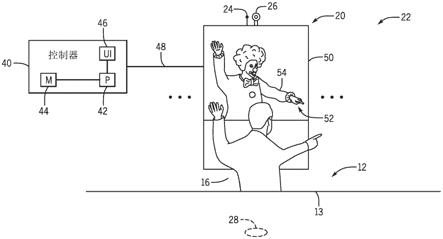

6.当参考附图阅读以下具体实施方式时,本公开的这些和其它特征、方面以及优点将变得更好地被理解,在附图中,贯穿附图,相同的字符表示相同的部分,其中:图1是根据本公开的一方面的游乐乘坐系统的实施例的顶视图;图2是根据本公开的一方面的包括具有增强现实动画的显示组件的图1的游乐乘坐系统的增强现实系统的实施例的侧视图;图3是根据本公开的一方面的包括具有单独增强现实动画的多个显示组件的图1

的游乐乘坐系统的增强现实系统的实施例的侧视图;以及图4是根据本公开的一方面的用于生成、更新和提供用于图2的增强现实系统的增强现实动画的过程的实施例的流程图。

具体实施方式

7.将在下面描述本公开的一个或多个具体实施例。为了提供对这些实施例的简明描述,可能不在说明书中描述实际实施方式的所有特征。应当意识到,在任何这样的实际实施方式的开发中,如在任何工程或设计项目中,必须作出许多特定于实施方式的决策以实现开发者的可能因实施方式而异的具体目标,诸如对与系统相关的约束和与商业相关的约束的依从。此外,应当意识到,这样的开发努力可能复杂并且耗时,尽管如此,但对于得益于本公开的普通技术人员而言,这样的开发努力会是设计、制作以及制造的常规任务。

8.当介绍本公开的各种实施例的元件时,冠词“一”、“一个”、“该”和“所述”旨在意指存在一个或多个元件。术语“包含”、“包括”、和“具有”旨在是包含性的,并且意指可以存在除了所列出的元件之外的附加元件。操作参数和/或环境条件的任何示例不排除所公开的实施例的其它参数/条件。

9.本公开的某些实施例包括具有增强现实系统的游乐乘坐系统。在某些实施例中,游乐乘坐系统和/或增强现实系统包括传感器,其被配置成在客人乘坐在游乐乘坐系统的乘坐载运器中时检测客人的面部、身体、存在或其组合。例如,面部识别传感器可以检测客人的面部和/或身体,骨骼识别传感器可以检测客人的身体,并且存在传感器可以检测乘坐载运器中的客人的存在。每个传感器可以向增强现实系统的控制器输出信号。基于从传感器接收的信号,增强现实系统可以生成增强现实动画,并且可以将增强现实动画提供给布置成邻近乘坐载运器和/或在乘坐载运器上的显示组件。例如,显示组件可以包括可由客人观看的屏幕。因此,增强现实系统和/或游乐乘坐系统可以检测客人的面部、身体、存在或其组合、生成增强现实动画、以及显示增强现实动画以用于由客人观看。在某些实施例中,增强现实系统可以连续地检测客人的面部、身体、存在或其任何组合,并且可以基于客人的面部、身体、存在或其组合来生成并提供增强现实动画,以允许客人贯穿游乐乘坐系统的至少一部分来与增强现实动画交互和/或控制增强现实动画。

10.考虑到前述内容,与增强现实系统相关的本实施例可以用于任何游乐乘坐系统中。例如,图1是游乐乘坐系统10的实施例的顶视图。如所图示的,游乐乘坐系统10包括具有一个或多个座椅13的乘坐载运器12。乘坐载运器12通常可以在方向15上沿着乘坐路径14行进,并且可以将客人16运载穿过游乐乘坐系统10。例如,在乘坐载运器12穿过游乐乘坐系统10行进时,客人16可以落座在座椅13中并且可以被座椅约束件18约束。座椅约束件18可以是膝部杆、座椅安全带、过顶约束件、另一类型的座椅约束件或其组合。在所图示的实施例中,乘坐载运器12包括四个座椅13,尽管乘坐载运器12可以在其它配置中包括不同数量的座椅。附加地,在某些实施例中,游乐乘坐系统10可以包括附加乘坐载运器12(例如,两个乘坐载运器12、三个乘坐载运器12、四个乘坐载运器12)。

11.如所图示的,乘坐路径14是具有限定乘坐载运器12的运动的轨迹的轨道系统。然而,在其它实施例中,乘坐路径14可以是沿着游乐乘坐系统10的底板的路径或者可以是被配置成运载和/或引导乘坐载运器12的另一系统。例如,乘坐载运器12可以是汽车,并且乘

坐路径14可以是被配置成引导乘坐载运器12的通道。附加地,图示了乘坐载运器12,其中客人16面向朝向显示组件20并且通常与方向15交叉(例如,垂直)的小径。在某些实施例中,客人16可以被定位成面向沿着方向15,使得显示组件20在客人16的一侧处。在某些实施例中,在沿着乘坐路径14移动时和/或在乘坐路径14上静止时,客人16可以改变位置。例如,客人16可以从所图示的面向侧面的位置改变到面向前方的位置和/或到另一位置。

12.显示组件20可以耦合和/或安装到乘坐载运器12的侧面,使得当乘坐载运器12沿着乘坐路径14移动时,显示组件20随着乘坐载运器12移动。附加地或可替代地,显示组件20可以耦合和/或安装到乘坐路径14,使得当乘坐载运器12沿着乘坐路径14在方向15上移动时,乘坐载运器12可以绕过显示组件20。在一些实施例中,显示组件20可以通常沿着方向15定位在乘坐载运器12的前方,使得沿着方向15面向朝前的客人16可以观看他们的前方的显示组件20。

13.游乐乘坐系统10包括增强现实系统22。如所图示的,增强现实系统22包括四个显示组件20、四个面部识别传感器24、四个骨骼识别传感器26以及四个存在传感器28。然而,在某些实施例中,增强现实系统22可以包括更多或更少的显示组件20、面部识别传感器24、骨骼识别传感器26和/或存在传感器28。附加地或可替代地,增强现实系统22可以包括可以检测客人的头部、身体、存在、客人的周围环境或其组合的其它类型的传感器和/或装备。在某些实施例中,增强现实系统22可以包括乘坐载运器12和/或乘坐路径14的全部或部分。例如,增强现实系统22可以包括在乘坐载运器12的每个座椅13中的存在传感器28。

14.如下面更详细地解释的,增强现实系统22可以提供增强现实图像和动画以用于由客人16观看和/或交互。增强现实动画可以包括覆盖在客人16的捕获的图像或动画上的图形或动画,使得图形或动画似乎是增强现实动画内的客人16的一部分。这样的图形或动画可以包括利用动画的面部特征代替客人的面部特征(例如,利用动物的鼻子和眼睛代替客人的鼻子和眼睛)、利用动画的头部代替客人的头部、利用动画的身体代替客人的身体、对客人16的捕获的图像或动画的其它修改。在某些实施例中,可以在整个显示组件20上显示动画。例如,在这样的实施例中,整个增强现实动画是动画的,并且不包括客人16和/或客人的周围环境的捕获的图像。

15.面部识别传感器24被配置成检测客人16的面部特征。例如,面部识别传感器24中的一个可以定位在特定客人16的前方并且可以检测该客人16的面部特征。面部识别传感器24还可以检测客人16的骨骼特征。在某些实施例中,面部识别传感器24可以是被配置成检测面部和/或骨骼特征的相机(例如,红/蓝/绿(rgb)检测相机或具有类似检测能力的相机)。面部识别传感器24可以设置于显示组件20上方和/或可以耦合到显示组件20。面部识别传感器24可以准确地检测客人的面部特征,并且可以允许客人16与增强现实系统22和/或游乐乘坐系统10交互。例如,在客人16正在观看显示组件20上的增强现实动画时,面部识别传感器24可以继续监视和检测客人的面部特征并且可以基于客人的移动面部特征更新显示组件20上的增强现实动画。增强现实动画可以包括利用动画的面部特征来代替客人的面部特征的部分或全部(例如,利用动画的鼻子代替客人的鼻子)。因此,客人16可以通过移动他们的面部特征和/或头部来经由面部识别传感器24与增强现实动画交互和/或控制增强现实动画。在某些实施例中,面部识别传感器24可以安装到乘坐载运器12或安装到游乐乘坐系统10的另一部分。

16.骨骼识别传感器26被配置成检测客人16的骨骼特征。例如,骨骼识别传感器26可以是设置在特定客人16的前方的深度传感器,其可以检测客人的头部和/或身体。骨骼识别传感器26可以是通常设置在显示组件20上方的第二相机,或者可以是被配置成检测客人的头部和/或身体的另一类型的传感器。骨骼识别传感器26可以设置在显示组件20上方和/或可以耦合到显示组件20,使得骨骼识别传感器26可以准确地检测客人的头部和/或身体,并且可以允许客人16通过移动他们的头部和/或身体与增强现实系统22和/或游乐乘坐系统10交互。例如,在客人16正在观看显示组件20上的增强现实动画时,骨骼识别传感器26可以继续监视和检测客人的头部和/或身体,并且可以基于客人的移动头部和/或身体来更新显示组件20上的增强现实动画。增强现实动画可以包括利用动画的面部特征来代替客人的面部特征的部分或全部(例如,利用动画的鼻子代替客人的鼻子)。因此,客人16可以通过移动他们的头部和/或身体来经由骨骼识别传感器26与增强现实动画交互和/或控制增强现实动画。在某些实施例中,骨骼识别传感器26可以被安装到乘坐载运器12或者安装到游乐乘坐系统10的另一部分。

17.存在传感器28被配置成检测乘坐载运器12中的客人16的存在。例如,乘坐载运器12可以包括用于每个座椅13的对应的存在传感器28。存在传感器28可以检测客人16在座椅13中的存在。例如,存在传感器28可以是被配置成检测座椅13中的客人16的重量的压力传感器。在某些实施例中,存在传感器28可以是用于座椅13的座椅约束件18。例如,在客人16被定位在座椅13中之后,座椅约束件18可以以指示客人16在座椅13中的存在的方式被固定。在存在传感器28检测到客人16的存在之后,显示组件20可以提供用于由客人16观看的增强现实动画。增强现实动画可以包括似乎是落座在如显示组件20上所示出的座椅13中的动画,或者可以包括占据显示组件20的整个屏幕的动画(例如,不显示客人的周围环境和/或乘坐载运器12的一部分)。

18.附加地或可替代地,在某些实施例中,游乐乘坐系统10和/或增强现实系统22可以包括代替显示组件20或除了显示组件20之外的动画形象(例如,电子动画)。这样的动画形象可以是可以被控制以模仿客人的移动的机器人形象。例如,增强现实系统22可以基于从面部识别传感器24、骨骼识别传感器26和/或存在传感器28接收的(一个或多个)信号来控制动画形象,以允许客人与动画形象和增强现实系统22交互。在一些实施例中,游乐乘坐系统10和/或增强现实系统22可以基于从传感器接收的信号和/或基于乘坐载运器12沿着乘坐路径14的位置来利用动画形象代替显示组件20。

19.游乐乘坐系统10和/或增强现实系统22可以包括控制器40。如所图示的,控制器40包括处理器42和存储器44。在某些实施例中,游乐乘坐系统10和/或增强现实系统22可以包括附加的控制器、处理器、存储器或其组合,以执行各种功能。例如,每个显示组件20可以包括控制器,其被配置成从各种传感器接收信号、控制显示组件20上的动画、与控制器40通信或其组合。在一些实施例中,游乐乘坐系统10的存储器44和其它存储器可以包括存储可由处理器42执行的指令和/或要由处理器42处理的数据的一个或多个有形的、非暂时性的计算机可读介质。例如,存储器44可以包括随机存取存储器(ram)、只读存储器(rom)、可重写非易失性存储器(诸如闪速存储器)、硬盘驱动器、光学盘、其它类型的存储器或其组合。附加地,游乐乘坐系统10的处理器42和其它处理器可以包括一个或多个通用微处理器、一个或多个专用集成电路(asic)、一个或多个现场可编程门阵列(fpga)或其任何组合。

20.控制器40可以还包括用户界面46,其可以促进控制器40与用户(例如,操作者)之间的通信。用户界面46可以设置成邻近游乐乘坐系统10或者在远程控制或自主操作的游乐乘坐系统的情况下可以设置在远程位置处。例如,用户界面46可以包括按钮、键盘、鼠标、轨迹板和/或类似物中的一个或多个以允许与控制器40的用户交互。附加地,用户界面46可以包括电子显示器,以例如经由图形用户界面(gui)、应用界面、文本、静态图像、视频内容或其组合来提供信息的视觉表示。用户界面46可以被配置成从用户(例如,游乐乘坐系统10和/或增强现实系统22的操作者)接收输入。

21.在操作中,控制器40可以经由处理器42从贯穿游乐乘坐系统10和/或增强现实系统22的传感器接收各种输入信号。例如,面部识别传感器24、骨骼识别传感器26和存在传感器28中的每个可以向控制器40输出指示它们的检测到的特征(例如,客人的检测到的面部特征、头部、身体、存在)的信号。由面部识别传感器24、骨骼识别传感器26和存在传感器28输出的信号可以在控制器40的处理器42处被接收。在某些实施例中,每个显示组件20可以包括显示控制器,其从面部识别传感器24、骨骼识别传感器26以及存在传感器28接收信号。显示控制器可以还与控制器40通信和/或可以生成并提供要显示的动画以用于由客人16观看。

22.如所图示的,每个显示组件20经由有线连接48(例如,以太网、通用串行总线(usb)、can总线(canbus)、iso总线(isobus))连接到控制器40并与控制器40通信。例如,每个显示组件20可以经由有线连接48向控制器40输出信号以及从控制器40接收信号。附加地或可替代地,每个显示组件20可以经由无线连接与控制器40通信。例如,每个显示组件20可以包括向控制器40的控制器收发器输出信号以及从控制器40的控制器收发器接收信号的显示收发器。显示收发器和控制器收发器中的每个可以利用任何合适的无线通信协议,诸如标准协议(例如,wi

‑

fi、蓝牙)或专有协议。

23.图2是增强现实系统22的实施例的正视图。如所图示的,增强现实系统22包括显示组件20、面部识别传感器24、骨骼识别传感器26以及存在传感器28。面部识别传感器24被配置成检测客人的面部并且将指示客人的面部的信号输出到控制器40,骨骼识别传感器26被配置成检测客人的身体并且将指示客人的身体的信号输出到控制器40,并且存在传感器28被配置成检测客人的存在并且将指示客人的存在的信号输出到控制器40。在某些实施例中,增强现实系统22可以包括附加显示组件20、面部识别传感器24、骨骼识别传感器26以及存在传感器28。此外,客人16可以落座在乘坐载运器12的座椅13中或者可以站立在乘坐载运器12中。

24.所图示的显示组件20的实施例包括屏幕50,其提供用于由客人16观看的增强现实动画52。如所图示的,增强现实动画52包括可以基于客人的移动由客人16来控制的小丑54。在某些实施例中,增强现实动画52可以包括除了小丑54之外或替代小丑54的其它图像和动画(例如,谷仓动物、卡通、角色)。

25.在某些实施例中,控制器40可以包括用于基于从面部识别传感器24、骨骼识别传感器26、存在传感器28或其组合接收的(一个或多个)信号来生成并提供要在屏幕50上显示的增强现实动画52的指令。例如,基于从存在传感器28接收的指示客人的存在的第一信号,控制器40可以生成增强现实动画52并且可以将增强现实动画52提供给显示组件20以用于由客人16观看。增强现实动画52可以定位在通常对应于客人16的位置的位置处的屏幕50

上。然而,在某些实施例中,指示客人的存在的第一信号本身不允许客人16与某些或全部增强现实动画之间的交互。

26.响应于从骨骼识别传感器26接收到指示客人的身体的第二信号,控制器40可以基于客人的身体来更新增强现实动画52。例如,如果控制器40初始接收到如上所述的指示客人的存在的第一信号,并且随后接收到指示客人的身体的第二信号,则控制器40可以更新增强现实动画52以模仿客人的身体的移动。在某些实施例中,如果控制器40同时接收到来自存在传感器28的指示客人的存在的第一信号以及来自骨骼识别传感器26的指示客人的身体的第二信号两者,则控制器40可以基于客人的身体来生成增强现实动画52。例如,增强现实动画52可以是模仿客人16的移动的动画。以这种方式,控制器40可以允许客人16控制增强现实动画52的身体。

27.响应于从面部识别传感器24接收到指示客人的面部和/或身体的第三信号,控制器40可以基于客人的面部和/或身体来生成或更新增强现实动画52。例如,如果控制器40接收到来自存在传感器28的指示客人的存在的第一信号、来自骨骼识别传感器26的指示客人的身体的第二信号以及来自面部识别传感器24的指示客人的面部和/或身体的第三信号,则控制器40可以基于客人的面部和/或身体来生成增强现实动画52。增强现实动画52可以包括视频馈送的部分,诸如客人16的、乘坐载运器12和/或客人的周围环境的捕获的图像/视频(例如,由面部识别传感器24捕获的视频馈送)。增强现实动画52还可以包括覆盖在视频馈送上的动画,使得动画似乎是客人16的部分和/或视频馈送的部分。例如,增强现实动画52可以包括定位在乘坐载运器12内的客人16的捕获的视频(例如,实时视频馈送)的部分以及似乎是客人16的部分和/或客人的周围环境的部分的动画。动画可以包括代替客人的面部特征、身体部分、整个客人的身体中的一些或其组合。以这种方式,控制器40可以允许客人16控制增强现实动画52的面部特征和/或头部。在某些实施例中,控制器40可以基于指示客人的身体的第二信号和指示客人的面部和/或身体的第三信号两者来生成和提供增强现实动画52,以允许客人16与增强现实动画52交互并控制增强现实动画52的身体和面部特征两者。附加地,控制器40可以更新基于客人的存在和/或身体的先前生成的增强现实动画52,以包括对面部特征的控制。面部识别传感器24连同骨骼识别传感器26和存在传感器28可以继续检测并输出信号至控制器40。当控制器40接收到每个信号时,控制器40基于接收的信号生成和/或更新增强现实动画52。

28.在某些实施例中,游乐乘坐系统10可以包括防止某些传感器检测到客人的特征(例如,面部和身体)的元件。例如,当乘坐载运器12沿着乘坐路径14行进时,游乐乘坐系统10的元件可以防止面部识别传感器24和骨骼识别传感器26的某些传感器检测和/或跟踪客人的相应特征(例如,面部和身体)。如果给定传感器(例如,面部识别传感器24或骨骼识别传感器26)不能检测到客人16,则控制器40可以基于从另一传感器(例如,骨骼识别传感器26或存在传感器28)接收的信号来生成并提供增强现实动画。

29.例如,如果控制器40首先从骨骼识别传感器26接收到指示客人的身体的信号并且没有从面部识别传感器24接收到指示客人的面部的信号,则控制器40可以基于客人的身体来生成增强现实动画52并且将增强现实动画52提供给显示组件20。此外,如果控制器40从存在传感器28接收到指示客人的存在的信号并且没有接收到指示客人的面部的信号或者指示客人的身体的信号,则控制器40可以基于客人的存在来生成增强现实动画52并且将增

强现实动画52提供给显示组件20。然而,在从存在传感器28接收到指示客人的存在的信号之后,如果控制器40从面部识别传感器24接收到指示客人的面部的信号,或者从骨骼识别传感器26接收到指示客人的身体的信号,则控制器40然后将基于新接收的信号(例如,来自面部识别传感器24的指示客人的面部和/或身体的信号或来自骨骼识别传感器26的指示客人的身体的信号)生成更新的增强现实动画52。以这种方式,增强现实动画52或控制增强现实动画52的客人的能力可以基于由控制器40从各种传感器接收的信号而改变。

30.图3是增强现实系统22的实施例的正视图。如所图示的,增强现实系统22包括四个显示组件20、四个面部识别传感器24、四个骨骼识别传感器26以及四个存在传感器28。在某些实施例中,增强现实系统22可以包括更多或更少的显示组件20、面部识别传感器24、骨骼识别传感器26、存在传感器28或其组合。附加地,每个显示组件20可以由独立控制器(例如,图1和2的控制器40)来控制,所述控制器被配置成提供要在显示组件20上显示的增强现实动画52。例如,控制器40可以从对应的面部识别传感器24、对应的骨骼识别传感器26、对应的存在传感器28或其组合来接收信号,并且可以基于接收的信号生成增强现实动画52。在某些实施例中,单个控制器可以从增强现实系统22的所有传感器接收信号,并且可以控制所有显示组件20。

31.在某些实施例中,游乐乘坐系统10和/或增强现实系统22可以包括显示多个增强现实动画的显示组件。例如,单个显示组件可以由多个客人16观看,并且可以为每个客人16显示增强现实动画52。控制器可以针对每个客人16生成多个增强现实动画52并且向单个显示组件提供多个增强现实动画52。

32.每个显示组件20的控制器可以为每个显示组件20提供变化的增强现实动画52。例如,在每个屏幕50上显示的增强现实动画52在图3的所图示的实施例中是不同的。观看显示组件20和/或与显示组件20交互的客人可以对在其相应的显示组件20上显示的增强现实动画52具有变化的控制水平。例如,定位成邻近第一显示组件20a的第一客人可以能够基于能够检测第一客人的面部特征和/或身体的面部识别传感器24中的对应的一个来控制在第一显示组件20a上显示的增强现实动画52的面部特征和/或身体移动。定位成邻近第二显示组件20b的第二客人可以能够基于能够检测第二客人的身体的骨骼识别传感器26中的对应的一个来控制在第二显示组件20b上显示的增强现实动画52的身体移动。定位成邻近第三显示组件20c的第三客人可以基于能够检测第三客人的面部特征和/或身体的面部识别传感器24以及基于能够检测第三客人的身体的骨骼识别传感器26来控制在第三显示组件20c上显示的增强现实动画52的身体移动和面部特征两者。定位成邻近第四显示组件20d的第四客人可以能够基于能够检测(例如,乘坐载运器12中的)第四客人的存在的存在传感器28来观看在第四显示组件20d上显示的增强现实动画52。在一些实施例中,如本文中所描述的,屏幕50中的一些或全部可以利用通常模仿客人的移动的动画形象(例如,电子动画)来代替。

33.图4是用于生成和/或更新图2和3的增强现实动画52的方法60的实施例的流程图。尽管以特定序列示出,但是应当注意的是,关于方法60所描述的操作可以以与所示出和所描述的那样不同的顺序来执行,并且实际上,方法60的这样的排列被本公开所涵盖。方法60可以由增强现实系统22来执行,例如由控制器40执行。如由框62所指示,控制器40可以首先接收图1的乘坐载运器12已经到达显示组件20前方的位置和/或邻近显示组件20的位置的

指示。例如,控制器40可以接收来自游乐乘坐系统10的第二控制器的指示。第二控制器可以被配置成跟踪乘坐载运器12沿着乘坐路径14的位置并且向控制器40输出指示乘坐载运器12的位置的信号。

34.在某些实施例中,控制器40可以接收乘坐序列已经开始的指示。控制器40的存储器44可以存储乘坐路径数据,其包括作为时间和/或其它因素的函数的关于沿着乘坐路径14的乘坐载运器的位置的信息。基于经过的时间的量和/或基于其它因素,控制器40可以确定乘坐载运器12已经到达显示组件20前方的位置和/或邻近显示组件20的位置。在某些实施例中,方法60的框62可以被省略,使得乘坐序列已经开始的指示和/或乘坐载运器12已经到达邻近显示组件20的位置的指示不一定被使用。

35.接下来,控制器40可以从面部识别传感器24、骨骼识别传感器26和存在传感器28中的任何接收对客人16的指示。例如,在框64处,控制器40可以从存在传感器28接收对客人的存在的指示。在框66处,控制器40可以从骨骼识别传感器26接收对客人的身体的指示。在框68处,控制器40可以从面部识别传感器24接收对客人的面部和/或身体的指示。

36.基于接收的对客人16的指示,控制器40可以生成和/或更新增强现实动画52并且将生成的和/或更新的增强现实动画52提供给相应的显示组件20。例如,在框70处,基于对客人的存在的指示,控制器40可以生成/更新增强现实动画52并且将增强现实动画52提供给显示组件20。显示组件20可以将增强现实动画52显示在与乘坐载运器12中的客人的存在对应的位置中以用于由客人16观看。

37.在框72处,基于对客人的身体的指示,控制器40可以生成/更新增强现实动画52并且将增强现实动画52提供给显示器,并且允许客人16观看在显示组件20上显示的增强现实动画52并与之交互。客人16可以移动他们的身体(例如,头部、手臂、躯干),并且控制器40可以更新增强现实动画52以大体上匹配客人的身体的移动以用于由客人16观看。在框74处,基于对客人的面部和/或身体的指示,控制器40可以生成/更新并提供增强现实动画52,以允许客人16观看在显示组件20上显示的增强现实动画52并与之交互。客人16可以移动他们的面部特征(例如,眼睛、眉毛、鼻子、嘴)和/或身体,并且控制器40可以更新增强现实动画52以大体上匹配客人的面部特征和/或身体的移动(例如,增强现实动画52的高兴的面部、悲伤的面部、大笑的面部、眼睛的移动、嘴的移动、以及其它面部特征的移动)以用于由客人16观看。

38.控制器40可以基于指示和对应的增强现实动画52将允许客人16进行的交互的量来确定使用哪个指示来生成和/或更新增强现实动画52。例如,如果控制器40接收到来自存在传感器28的对客人的存在的指示(例如,来自存在传感器28的指示客人的存在的信号)和来自面部识别传感器24的客人的面部和/或身体的指示两者,则控制器40可以基于客人的面部和/或身体来生成和/或更新增强现实动画52。这将通过允许客人16移动他们的面部特征以及利用类似的移动来观看增强现实动画52来允许客人16与游乐乘坐系统10进行更大的交互。

39.作为另一示例,如果控制器40接收到来自存在传感器28的对客人的存在的指示和来自骨骼识别传感器26的对客人的身体的指示两者,则控制器40可以基于客人的身体来生成和/或更新增强现实动画52。此外,如果控制器40接收到来自骨骼识别传感器26的对客人的身体的指示和来自面部识别传感器24的对客人的面部和/或身体的指示两者,则控制器

40可以基于客人的面部和/或身体来生成和/或更新增强现实动画52。在某些实施例中,控制器40可以基于从骨骼识别传感器26接收的对客人的身体的指示以及从面部识别传感器24接收的对客人的面部和/或身体的指示来生成和/或更新增强现实动画,以允许客人16与增强现实动画52的身体和面部两者交互。

40.在生成和/或更新增强现实动画52之后,方法60可以进行到询问76。在询问76处,控制器40可以确定乘坐载运器是否仍然处于显示组件20前方和/或邻近显示组件20的位置。例如,控制器40可以从第二控制器接收乘坐载运器12仍然处于该位置的信号,或者可以基于存储在控制器40的存储器44中的信息来确定乘坐载运器12仍然处于该位置。基于乘坐载运器12仍然处于显示组件20前方和/或邻近显示组件20的位置的确定,方法60可以返回到框64、66或68中的任何。因此,控制器40可以继续接收对客人16的(一个或多个)指示,并且可以通过基于(一个或多个)指示来更新增强现实动画52。

41.基于乘坐载运器12不处于显示组件20前方和/或邻近显示组件20的位置的确定,控制器40可以停止向显示组件20提供增强现实动画52,如由框78所指示。例如,控制器40可以停止向显示组件20输出指示更新的增强现实动画52的信号。作为响应,显示组件20可以停止显示增强现实动画52。在这种情况下,控制器40可以使得显示组件20示出存储的动画、空白屏幕或另一特征。

42.控制器40可以重复地执行块和询问64、66、68、70、72、74和76中的每个,以生成和提供增强现实动画52以用于由客人16观看。例如,在初始地生成和提供增强现实动画52之后,控制器40可以从面部识别传感器24、骨骼识别传感器26、存在传感器28或其组合接收(一个或多个)附加信号,并且可以更新增强现实动画52以及将更新的增强现实动画52提供给显示组件20。因此,控制器40可以基于客人对他们的身体和/或面部特征的移动来更新增强现实动画52。客人16可以观看增强现实动画52的每个版本,并且可以继续移动他们的身体和/或面部特征以使得增强现实动画52移动。以这种方式,客人16可以与增强现实动画52交互和/或控制增强现实动画52。因此,增强现实系统22可以提供为客人16提供娱乐的交互式环境。

43.虽然本文中已经图示和描述了本公开的仅某些特征,但本领域技术人员将想到许多修改和改变。因此,要理解的是,所附权利要求旨在覆盖如落入本公开的真实精神内的所有这样的修改和改变。

44.本文中所呈现并且要求保护的技术被引用并且应用于实际性质的实质对象和具体示例,所述实质对象和具体示例可证明地改进本技术领域并且因此不是抽象的、无形的或纯理论的。此外,如果本说明书的末尾所附的任何权利要求包含指定为“用于[执行]

……

[功能]的装置”或“用于[执行]

……

[功能]的步骤”的一个或多个元素,则旨在这样的元素将根据35 u.s.c. 112(f)来解释。然而,对于包含以任何其它方式指定的元素的任何权利要求,旨在这样的元素将不根据35 u.s.c. 112(f)来解释。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1