一种基于数字孪生的遥操作机器人在线示教系统及方法

1.本发明涉及一种基于数字孪生的遥操作机器人在线示教系统及方法,涉及智能制造和人机交互技术。

背景技术:

2.工业机器人广泛应用于加工制造行业,工业机器人的推广应用率是衡量一个国家工业自动化水平的重要标志。对于遥操作机器人,由于示教人员和实体机器人处于不同的物理空间,导致示教活动的安全性降低,极大限制了遥操作机器人在线示教编程的效率。

3.现有数字孪生技术只是通过建立遥操作机器人的数字孪生模型,对物理机器人的工作状态进行实时监测,但是对机器人进行实时地位姿规划和碰撞检测的应用探索很少。实时的位姿规划和碰撞检测可以提高遥操作机器人在线示教的人机交互性,预测规划路径和姿态下机器人和工作场景之间的碰撞干涉,提高遥操作机器人在线示教的编程效率。

技术实现要素:

4.为了解决上述现有技术中存在的问题,本发明提出了一种基于数字孪生的遥操作机器人在线示教系统及方法,建立机器人及其工作场景的三维模型,并构建碰撞检测模块,在控制物理机器人运动前,先将规划好的示教位姿数据先发送至碰撞检测模块,提前预测机器人和工作场景之间是否存在碰撞,降低了碰撞的风险,提高了遥操作机器人在线示教的可靠性、安全性和示教效率。

5.本发明的技术方案如下:

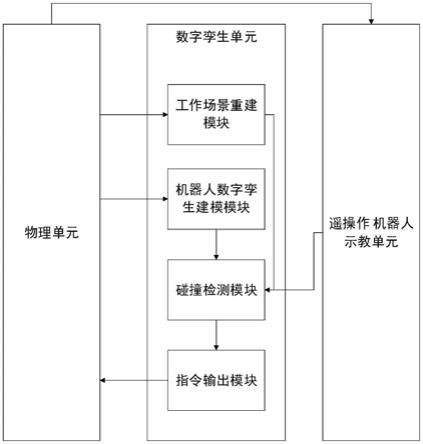

6.一方面,本发明提供一种基于数字孪生的遥操作机器人在线示教系统,包括:数字孪生单元和与数字孪生单元通信连接的物理单元以及遥操作机器人示教单元;

7.所述物理单元用于采集装配场景的三维数据以及物理机器人的位姿数据;且所述物理单元还用于根据指令驱动物理机器人动作;

8.所述遥操作机器人示教单元用于规划机器人的运动路径,并基于运动路径输出示教位姿数据;

9.所述数字孪生单元包括工作场景重建模块、机器人数字孪生建模模块、碰撞检测模块以及指令输出模块;所述工作场景重建模块根据装配场景的三维数据建立工作场景三维模型;所述机器人数字孪生建模模块根据物理机器人的位姿数据建立虚拟机器人三维模型,并创建与物理机器人对应的机器人运动学模型;所述碰撞检测模块基于机器人运动学模型以及所述示教位姿数据控制虚拟机器人三维模型根据规划的运动路径进行运动,并在运动过程中进行虚拟机器人三维模型和工作场景三维模型的碰撞检测;所述指令输出模块用于根据示教位姿数据生成指令,并将指令输出至所述物理单元。

10.作为优选实施方式,所述物理单元包括rgb-d相机、物理机器人以及物理机器人控制柜;

11.所述rgb-d相机用于采集装配场景的三维数据以及物理机器人的位姿数据;

12.所述物理机器人控制柜用于接收指令,并根据指令驱动物理机器人动作。

13.作为优选实施方式,所述遥操作机器人示教单元包括增强现实注册模块和遥示教位姿规划模块;

14.所述增强现实注册模块根据物理机器人的位姿数据建立虚拟机器人三维模型;

15.所述遥示教位姿规划模块用于规划虚拟机器人三维模型的运动路径,并基于运动路径输出示教位姿数据。

16.作为优选实施方式,所述物理单元采集物理机器人的图像,并获取物理机器人在图像中的位姿数据;

17.所述根据物理机器人的位姿数据建立虚拟机器人三维模型通过手眼标定模块实现;

18.所述手眼标定模块获取物理机器人的图像以及物理机器人基坐标系,通过手眼标定算法计算图像坐标系到物理机器人基坐标系的转换矩阵;

19.根据转换矩阵以及物理机器人在图像中的位姿数据获取物理机器人的实际位姿数据;根据物理机器人的实际位姿数据创建与物理机器人及坐标系一致的虚拟机器人三维模型。

20.作为优选实施方式,所述物理单元采集的装配场景的三维数据具体为装配场景的点云图像;

21.所述工作场景重建模块根据图像坐标系到物理机器人基坐标系的转换矩阵,从装配场景的点云图像中剔除物理机器人的点云图像,得到工作场景的点云图像作为工作场景的三维模型。

22.另一方面,本发明还提供一种基于数字孪生的遥操作机器人在线示教方法,包括以下步骤:

23.利用图像采集设备采集装配场景的三维数据以及物理机器人的位姿数据;

24.示教人员在计算机上规划机器人的运动路径,计算机基于运动路径输出示教位姿数据;

25.利用计算机根据装配场景的三维数据以及物理机器人的位姿数据分别建立工作场景三维模型和虚拟机器人三维模型;

26.利用计算机根据示教位姿数据控制虚拟机器人三维模型进行对应的运动,并在运动过程中进行虚拟机器人三维模型和工作场景三维模型的碰撞检测;

27.若无碰撞现象,则计算机基于示教位姿数据输出运动指令至物理机器人控制柜,物理机器人控制柜根据指令控制物理机器人运动;若产生碰撞现象,则返回重新规划机器人的运动路径。

28.作为优选实施方式,所述物理机器人的位姿数据具体为物理机器人在图像采集设备坐标系中的位姿数据,计算机根据物理机器人的位姿数据建立虚拟机器人三维模型的步骤具体为:

29.通过手眼标定算法计算图像采集设备坐标系到物理机器人基坐标系的转换矩阵;

30.根据转换矩阵以及物理机器人的位姿数据获取物理机器人的实际位姿数据;根据物理机器人的实际位姿数据创建与物理机器人及坐标系一致的虚拟机器人三维模型。

31.作为优选实施方式,计算机根据装配场景的三维数据建立工作场景三维模型的步

骤具体为:

32.所述图像采集设备采集的装配场景的三维数据具体为装配场景的深度图像;

33.计算机将装配场景的深度图像转换为装配场景的点云图像;

34.计算机根据图像采集设备坐标系到物理机器人基坐标系的转换矩阵,从装配场景的点云图像中剔除物理机器人的点云图像,得到工作场景的点云图像;

35.根据工作场景的点云图像建立工作场景的八叉树模型。

36.作为优选实施方式,所述计算机将装配场景的深度图像转换为装配场景的点云图像步骤具体为:

37.获取图像采集设备的深度值z;

38.根据下式得到深度图像坐标与点云坐标的转换关系:

[0039][0040]

上式中,(x,y,z)为点云的三维坐标,(x,y)为深度图像坐标,f

x

、fy为在深度图像中x轴和y轴方向上的焦距,c

x

、cy为在深度图像中的主点坐标;

[0041]

移动图像采集设备,采集到不同视角的装配场景深度图像,采用图像帧间的点云配准算法,使用新拍摄的深度图像将前序深度图像中的空洞进行填充,融合拼接得到整个装配场景的点云图像;

[0042]

在获取整个装配场景的点云图像后,还进行滤波处理,具体包括:

[0043]

直通滤波处理:在图像采集设备坐标系各坐标轴上设置一个阈值范围,将阈值范围之外的离群点去除,消除与机器人工作场景无关的点云;

[0044]

体素滤波处理:将直通滤波处理后的点云图像均分成若干个三维体素网格,该体素网格内的所有点都通过体素网格的一个重心点来表示,实现点云图像下采样;

[0045]

半径滤波处理,以点云图像中的某个点云为球心,设置半径r和点云数阈值,若在半径为r的球体内,与球心相邻的点云个数小于点云数阈值,则将该点云和所有相邻的点云都剔除;若大于或等于点云数阈值,则保留所有点云。

[0046]

作为优选实施方式,所述从装配场景的点云图像中剔除物理机器人的点云图像,得到工作场景的点云图像步骤具体为:

[0047]

根据图像采集设备坐标系到物理机器人基坐标系的转换矩阵,使虚拟机器人三维模型坐标系与装配场景的点云图像中的机器人坐标系一致;

[0048]

将虚拟机器人三维模型覆盖在装配场景的点云图像中,删除虚拟机器人三维模型覆盖区域的点云,得到工作场景的点云图像。

[0049]

本发明具有如下有益效果:

[0050]

1、本发明一种基于数字孪生的遥操作机器人在线示教系统,利用数字孪生单元建立机器人及其工作场景的三维模型,并构建碰撞检测模块,在控制物理机器人运动前,先将规划好的示教位姿数据先发送至碰撞检测模块,提前预测机器人和工作场景之间是否存在碰撞,降低了碰撞的风险,提高了遥操作机器人在线示教的可靠性、安全性和示教效率。

[0051]

2、本发明一种基于数字孪生的遥操作机器人在线示教方法,采用直通滤波、体素滤波和半径滤波对点云图像进行处理,缩小点云图像的视野范围,使点云图像的边缘更加清晰。

[0052]

3、本发明一种基于数字孪生的遥操作机器人在线示教方法,将物理机器人点云图像从装配场景的点云图像中剔除,避免将物理机器人误判成障碍物进行碰撞检测。

附图说明

[0053]

图1为本发明实施例一的遥操作机器人在线示教系统的框架图;

[0054]

图2为本发明实施例一的遥操作机器人在线示教系统的硬件组成示意图;

[0055]

图3为本发明实施例二提供的遥操作机器人在线示教示例步骤流程图;

[0056]

图4为本发明实施例二提供的一种获取工作场景的点云图像的流程图;

[0057]

图5为本发明实施例二中将虚拟机器人三维模型覆盖在装配场景的点云数据上的示例图。

具体实施方式

[0058]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例仅仅是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有作出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

[0059]

应当理解,文中所使用的步骤编号仅是为了方便描述,不对作为对步骤执行先后顺序的限定。

[0060]

应当理解,在本发明说明书中所使用的术语仅仅是出于描述特定实施例的目的而并不意在限制本发明。如在本发明说明书和所附权利要求书中所使用的那样,除非上下文清楚地指明其它情况,否则单数形式的“一”、“一个”及“该”意在包括复数形式。

[0061]

术语“包括”和“包含”指示所描述特征、整体、步骤、操作、元素和/或组件的存在,但并不排除一个或多个其它特征、整体、步骤、操作、元素、组件和/或其集合的存在或添加。

[0062]

术语“和/或”是指相关联列出的项中的一个或多个的任何组合以及所有可能组合,并且包括这些组合。

[0063]

实施例一:

[0064]

参见图1,本实施例提供一种基于数字孪生的遥操作机器人在线示教系统,由数字孪生单元和与数字孪生单元通信连接的物理单元以及遥操作机器人示教单元组成;

[0065]

所述物理单元用于采集装配场景的三维数据以及物理机器人的位姿数据并将上述数据发送至数字孪生单元;且所述物理单元还用于根据指令驱动物理机器人动作;

[0066]

所述遥操作机器人示教单元用于规划机器人的运动路径,并基于运动路径输出示教位姿数据并发送至数字孪生单元;

[0067]

所述数字孪生单元包括工作场景重建模块、机器人数字孪生建模模块、碰撞检测模块以及指令输出模块;

[0068]

所述工作场景重建模块根据装配场景的三维数据建立工作场景三维模型;

[0069]

所述机器人数字孪生建模模块根据物理机器人的位姿数据建立虚拟机器人三维

模型,并创建与物理机器人对应的机器人运动学模型;

[0070]

所述碰撞检测模块基于机器人运动学模型以及所述示教位姿数据控制虚拟机器人三维模型根据规划的运动路径进行运动,并在运动过程中进行虚拟机器人三维模型和工作场景三维模型的碰撞检测;若碰撞检测模块检测到产生碰撞现象,则通知遥操作机器人示教单元对机器人运动路径进行重新规划;若碰撞检测模块检测到无碰撞现象,则根据当前规划的运动路径输出的示教位姿数据生成指令,将该指令发送至物理单元。

[0071]

所述指令输出模块用于根据示教位姿数据生成指令,并将指令输出至所述物理单元。

[0072]

具体参见图2,在一种实施例中,本发明所述的在线示教系统的硬件组成包括rgb-d相机10、一号计算机11、二号计算机12、机器人控制柜14、物理机器人15;由示教人员13进行操作。

[0073]

其中,rgb-d相机10、物理机器人15以及物理机器人控制柜14组成物理单元;

[0074]

所述rgb-d相机10用于采集装配场景的深度图像,获取物理机器人的rgb图像,并获取rgb图像中物理机器人的位姿数据;rgb-d相机10将采集到的图像实时发送至一号计算机11和二号计算机12中;

[0075]

所述物理机器人控制柜14用于接收指令,并根据指令驱动物理机器人15动作。

[0076]

其中,遥操作机器人示教单元装载于一号计算机11中,数字孪生单元装载于二号计算机12中;一号计算机11和二号计算机12进行实时通信;机器人控制柜14与二号计算机12进行通信,接收二号计算机12下发的指令。

[0077]

在一种实施例中,所述遥操作机器人示教单元包括增强现实注册模块和遥示教位姿规划模块;

[0078]

所述增强现实注册模块根据物理机器人的位姿数据建立虚拟机器人三维模型;

[0079]

所述遥示教位姿规划模块用于规划虚拟机器人三维模型的运动路径,并基于运动路径输出示教位姿数据发送至数字孪生单元,数字孪生单元根据示教位姿数据实时更新虚拟机器人三维模型中对应关节的运动。

[0080]

在一种实施例中,所述增强现实注册模块和机器人数字孪生建模模块均通过手眼标定模块实现根据物理机器人的位姿数据建立虚拟机器人三维模型;

[0081]

所述手眼标定模块利用手眼标定算法计算rgb-d相机中rgb相机坐标系以及物理机器人基坐标系之间的转换矩阵;

[0082]

根据转换矩阵以及物理机器人在图像中的位姿数据获取物理机器人的实际位姿数据;根据物理机器人的实际位姿数据创建与物理机器人及坐标系一致的虚拟机器人三维模型。

[0083]

在一种实施例中,所述rgb-d相机采集的装配场景的三维数据具体为装配场景的点云图像;首先通过rgb-d相机采集装配场景的深度图像,然后将深度图像转换为点云图像;

[0084]

所述工作场景重建模块根据图像坐标系到物理机器人基坐标系的转换矩阵,从装配场景的点云图像中剔除物理机器人的点云图像,得到工作场景的点云图像;

[0085]

所述工作场景重建模块根据工作场景的点云图像建立工作场景的八叉树模型;碰撞检测模块根据虚拟机器人三维模型和工作场景的点云图像,建立八叉树图碰撞检测模

型,并进行工作场景的点云图像和虚拟机器人三维模型之间的碰撞检测。

[0086]

实施例二:

[0087]

本实施例提供一种基于数字孪生的遥操作机器人在线示教方法,包括以下步骤:

[0088]

利用rgb-d相机采集装配场景的三维数据以及物理机器人的位姿数据;

[0089]

示教人员在计算机上规划机器人的运动路径,计算机基于运动路径输出示教位姿数据(位姿数据指的是位置和姿态数据);

[0090]

利用计算机根据装配场景的三维数据以及物理机器人的位姿数据分别建立工作场景三维模型和虚拟机器人三维模型;

[0091]

利用计算机根据示教位姿数据控制虚拟机器人三维模型进行对应的运动,并在运动过程中进行虚拟机器人三维模型和工作场景三维模型的碰撞检测;

[0092]

若无碰撞现象,则计算机基于示教位姿数据输出运动指令至物理机器人控制柜,物理机器人控制柜根据指令控制物理机器人运动;若产生碰撞现象,则返回重新规划机器人的运动路径。

[0093]

在一种实施例中,所述物理机器人的位姿数据具体为物理机器人在rgb-d相机的rgb相机坐标系中的位姿数据,计算机根据物理机器人的位姿数据建立虚拟机器人三维模型的步骤具体为:

[0094]

通过手眼标定算法计算rgb-d相机中rgb相机坐标系到物理机器人基坐标系的转换矩阵m;

[0095]

根据转换矩阵m以及物理机器人在rgb相机坐标系中的位姿数据获取物理机器人的实际位姿数据;根据物理机器人的实际位姿数据创建与物理机器人及坐标系一致的虚拟机器人三维模型。

[0096]

在一种实施例中,计算机根据装配场景的三维数据建立工作场景三维模型的步骤具体为:

[0097]

所述rgb-d相机通过深度相机采集的装配场景的深度图像;

[0098]

计算机将装配场景的深度图像转换为装配场景的点云图像;

[0099]

计算机根据图像采集设备坐标系到物理机器人基坐标系的转换矩阵,从装配场景的点云图像中剔除物理机器人的点云图像,得到工作场景的点云图像;

[0100]

根据工作场景的点云图像建立工作场景的八叉树模型。

[0101]

参见图3,根据上述实施例,本发明提供一种具体的遥操作机器人在线示教步骤:

[0102]

s10、示教人员根据物理机器人的型号、尺寸以及关节尺寸以及物理机器人的位姿数据,利用计算机建立虚拟机器人三维模型和机器人运动学模型。

[0103]

s20、对物理机器人和rgb-d相机进行手眼标定,得到rgb相机坐标系到物理机器人基坐标系的转换矩阵m;

[0104]

s30、根据所述rgb-d相机采集的装配场景深度图像,生成装配场景的点云图像;根据s20中得到的转换矩阵m,从点云图像中去除物理机器人的点云图像,建立工作场景的点云图像;根据工作场景的点云图像建立工作场景的八叉树模型。

[0105]

s40、示教人员使用计算机规划机器人的运动路径和姿态,计算机实时输出示教位姿数据,并根据示教位姿数据更新虚拟机器人三维模型中机器人对应关节的运动。

[0106]

s50、基于rgb-d相机坐标系到物理机器人基坐标系的转换矩阵m,将虚拟机器人模

型叠加至工作场景八叉树模型中,建立虚拟机机器人三维模型的碰撞检测模型。

[0107]

s60、使用工作场景的八叉树模型和虚拟机器人三维模型,进行碰撞干涉检测,若无碰撞的情况发生,则将当前的示教位姿数据生成机器人运动指令发送至物理机器人控制柜,控制物理机器人运动;若有碰撞发生,则向物理机器人控制柜发送暂停指令,同时返回s40重新规划路径,直至遥操作控制结束。

[0108]

参见图4,在一种实施例中,在步骤s30中生成装配场景的点云图像,并从装配场景的点云图像中去除物理机器人的点云图像,建立工作场景的点云图像的方法如下:

[0109]

获取图像采集设备的深度值z;

[0110]

s301、点云图像生成:所述rgb-d相机采集装配场景的深度图像,利用ros机器人控制系统将深度图像转换成点云图像,实现三维重建。rgb-d相机的深度值z已知,根据下式所示的深度相机成像模型可以得到深度图像坐标与点云坐标的转换关系:

[0111]

根据下式得到深度图像坐标与点云坐标的转换关系:

[0112][0113]

上式中,(x,y,z)为点云的三维坐标,(x,y)为深度图像坐标,f

x

、fy为在深度图像中x轴和y轴方向上的焦距,c

x

、cy为在深度图像中的主点坐标;

[0114]

移动rgb-d相机,采集到不同视角的装配场景深度图像,采用图像帧间的点云配准算法,使用新拍摄的深度图像将前序深度图像中的空洞进行填充,融合拼接得到整个装配场景的点云图像;

[0115]

s302、在获取整个装配场景的点云图像后,还进行滤波处理,由于相机获得的点云图像视野范围过大,会采集到与机器人工作空间无关的场景点云,这会导致点云更新速率变慢和点云图像的边缘过于粗糙,不利于后续的碰撞检测,因此本实施例采用直通滤波、体素滤波和半径滤波对点云图像进行处理,缩小点云图像的视野范围,使点云图像的边缘更加清晰。具体步骤如下:

[0116]

直通滤波处理:在rgb-d相机的深度相机坐标系各坐标轴上设置一个阈值范围(本实施例设置为(0~1.3m)),将阈值范围之外的离群点去除,消除与机器人工作场景无关的点云,缩小点云图像的视野范围;

[0117]

体素滤波处理:将直通滤波处理后的点云图像均分成若干个三维体素网格(本实施例中三维体素网格的大小为0.005m),该体素网格内的所有点都通过体素网格的一个重心点来表示,实现点云图像下采样,使得采样点对应的曲面更为准确,点云边缘更加清晰;

[0118]

半径滤波处理:以点云图像中的某个点云为球心,设置半径r(本实施例中r=0.002m)和点云数阈值(本实施例中点云数阈值设置为30),若在半径为0.002m的球体内,与球心相邻的点云个数小于30个,则将该点云和所有相邻的点云都剔除;若大于或等于30个,则保留所有点云,以此进一步消除与机器人工作场景无关的离群点。

[0119]

s303、为了避免将物理机器人误判成障碍物进行碰撞检测,需要将物理机器人的点云图像从装配场景的点云图像中剔除,具体步骤如下:

[0120]

根据rgb-d相机坐标系到物理机器人基坐标系的转换矩阵m,使虚拟机器人三维模型坐标系与装配场景的点云图像中的机器人坐标系一致;

[0121]

s304、请参阅图5,将虚拟机器人三维模型覆盖在装配场景的点云图像中,删除虚拟机器人三维模型覆盖区域的点云,从而得到工作场景的点云图像。

[0122]

以上所述仅为本发明的实施例,并非因此限制本发明的专利范围,凡是利用本发明说明书及附图内容所作的等效结构或等效流程变换,或直接或间接运用在其他相关的技术领域,均同理包括在本发明的专利保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1