一种基于单臂机械手的强化学习约束控制方法

本发明涉及人工智能及控制,尤其涉及一种基于单臂机械手的强化学习约束控制方法。

背景技术:

1、自20世纪60年代以来,机械手在广泛领域得到应用,如机械加工、点焊、装配、检测、航天等。特别在工业自动化生产线上,工业机械手占据着重要的位置。同时,因工作环境的复杂性易受到各种外部环境的影响,将导致控制效果上可能有所欠缺。为了提高单臂机械手的控制精度,通常需要对连杆的角速度、角加速度变化范围提出约束要求。因此,在控制器设计过程中结合全状态时变约束理论对其进行相应的控制具有一定实际价值和理论意义。除了单臂机械手稳定和满足指定的约束范围外,对于所需要的控制代价同样有着一定的要求,往往希望通过使用较少的控制代价实现较好的控制效果。最优控制是一类考虑系统控制性能和节能效应的控制策略,但机械手的运动过程属于强耦合、时变的高度非线性动力学系统,且存在高度不确定性,这给传统的最优控制方法带来了巨大的挑战。因此,如何在遭受复杂的外部环境干扰的单臂机械手控制过程中满足指定范围约束和降低控制代价成为丞待解决的问题。

技术实现思路

1、本发明的目的是提供一种基于单臂机械手的强化学习约束控制方法,能够使遭受复杂的外部环境干扰的单臂机械手控制过程中满足指定范围约束和降低控制代价。

2、为了实现上述目的,本发明所采用的技术方案是:一种基于单臂机械手的强化学习约束控制方法,包括如下步骤:

3、步骤1、首先对单臂机械手进行数学建模,然后根据机械手物理特性构造全状态约束下的状态方程;

4、步骤2、采用通用变换函数进行等价转换成不受约束的单臂机械手模型的状态方程,并对其采取坐标变换,得到误差变量;

5、步骤3、根据误差变量和最优控制策略,构造哈密顿-雅可比-贝尔曼方程,求解近似最优虚拟控制器,其中包括设计最优代价函数;

6、步骤4、根据近似最优虚拟控制器,通过引入非线性滤波器,得到新的状态变量;

7、步骤5、根据新的状态变量和基于神经网络架构的自适应动态规划方法求解近似最优控制器对所述单臂机械手模型进行控制。

8、优选的,所述的步骤1包括以下步骤:

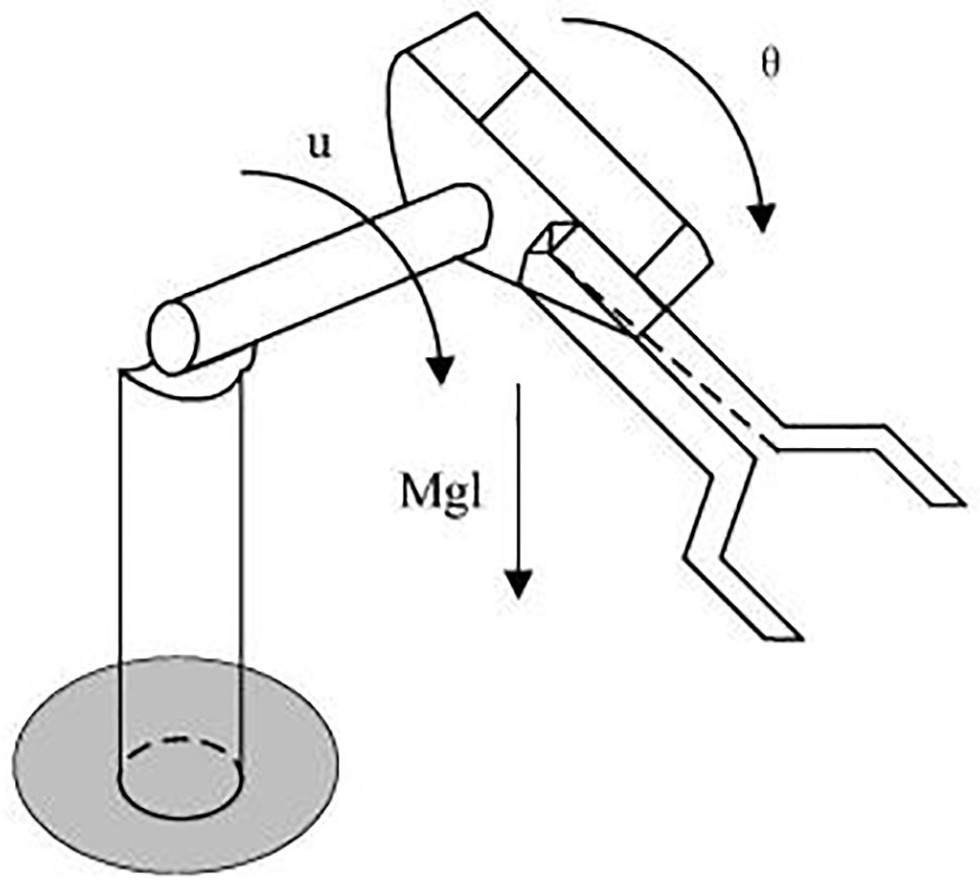

9、步骤1.1、首先根据单臂机械手模型的结构图,建立单臂机械手非线性数学模型为:

10、

11、其中q分别表示连杆的角加速度、角速度和转角位置,j=1kg·m2表示连杆总转动惯量,m=1kg表示连杆总质量,u代表控制输入,d=2n·m·s表示总阻尼系数,g=10m/s2表示重力加速度,l=1m表示从关节轴到连杆质心的距离;

12、步骤1.2、定义变量分别为连杆的角速度和角加速度,单臂机械手的运动模型可表示为如下状态空间方程:

13、

14、其中外部干扰d1(t)=0.1sin(t).d2(t)=0.1cos(t).。

15、优选的,所述的步骤2包括以下步骤:

16、步骤2.1、采用通用变换函数

17、

18、其中di(t)和表示两次可微分的约束函数,表示跟踪误差,其中为参考轨迹信号,

19、步骤2.2、在优化控制的准备过程中,最初系统的状态方程可转换为:

20、

21、其中

22、

23、步骤2.3、定义误差坐标转换函数:

24、

25、其中si(i=1,2)表示误差面,以虚拟控制律α1作为滤波器输入的滤波器输出信号,表示滤波误差。

26、优选的,所述的步骤3包括以下步骤:

27、步骤3.1、基于误差变量和优化目标,设计最优代价函数:

28、

29、其中ωx表示容许控制的输入集合,表示使最小化的最优虚拟控制器,si(t)表示误差变量,αi(si)表示虚拟控制信号;

30、步骤3.2、推导出如下哈密顿-雅可比-贝尔曼方程:

31、

32、步骤3.3、根据bellman的最优性原理,通过解决可得最优虚拟控制信号为

33、

34、将最优虚拟控制信号带入哈密顿函数,可得哈密顿-雅可比-贝尔曼方程,采用基于神经网络架构的自适应动态规划方法近似求解最优控制器对所述单臂机械手模型进行控制,

35、

36、其中ki表示设计参数,

37、步骤3.4、将最优梯度函数分解为如下形式:

38、

39、其中

40、步骤3.5、采用径向基神经网络对和分别进行逼近处理,其中和wi*为理想权值向量,和为基函数,εsi和为逼近误差,满足关系式为任意小的正常数,采用具有执行-评价结构的强化学习策略,得到近似最优梯度函数和近似最优虚拟控制器:

41、

42、

43、其中和分别表示wi*,和的估计值;

44、步骤3.6、设计识别-执行-评价网络估计权值更新律为:

45、

46、

47、

48、其中λai,λci为正设计参数满足

49、优选的,所述的步骤4包括以下步骤:

50、步骤4.1、设计如下非线性滤波器:

51、

52、其中表示的导数,α1为近似最优虚拟控制器,ι2表示任意小的正常数,同时,和表示ζ2的估计值和估计误差,其中ζ2表示的上界;

53、步骤4.2、设计如下更新律来补偿滤波误差的影响:

54、

55、其中κ为设计参数。

56、优选的,所述的步骤5包括以下步骤:

57、步骤5.1、构造完整的李雅普诺夫函数:

58、

59、并对其求时间导数进行稳定性分析可得证明机械臂系统实现闭环稳定,其中是参数估计误差,为正常数;

60、根据李雅普诺夫稳定性定理,通过调节参数可以实现对单臂机械手的最优控制。

61、本发明的有益效果是:本强化学习约束控制方法为了满足不对称全状态时变约束需求,采用通用变换函数和误差变换来消除相关约束问题引起的可行性条件。本方案构建了一种涉及自适应参数的非线性滤波器来克服反步法中存在的计算爆炸问题,并将不对称全状态时变约束特性纳入最优框架中来保障单臂机械手模型的最优性。本方案解决了现有单臂机械手模型因工作环境复杂性受到外部环境等影响而导致的控制性能不佳的问题,实现了全状态时变约束和降低控制代价的目的。

技术特征:

1.一种基于单臂机械手的强化学习约束控制方法,其特征在于:包括如下步骤:

2.根据权利要求1所述的一种基于单臂机械手的强化学习约束控制方法,其特征在于:所述的步骤1包括以下步骤:

3.根据权利要求1所述的一种基于单臂机械手的强化学习约束控制方法,其特征在于:所述的步骤2包括以下步骤:

4.根据权利要求1所述的一种基于单臂机械手的强化学习约束控制方法,其特征在于:所述的步骤3包括以下步骤:

5.根据权利要求1所述的一种基于单臂机械手的强化学习约束控制方法,其特征在于:所述的步骤4包括以下步骤:

6.根据权利要求1所述的一种基于单臂机械手的强化学习约束控制方法,其特征在于:所述的步骤5包括以下步骤:

技术总结

本发明提供一种基于单臂机械手的强化学习约束控制方法,本强化学习约束控制方法为了满足不对称全状态时变约束需求,采用通用变换函数和误差变换来消除相关约束问题引起的可行性条件。本方案构建了一种涉及自适应参数的非线性滤波器来克服反步法中存在的计算爆炸问题,并将不对称全状态时变约束特性纳入最优框架中来保障单臂机械手模型的最优性。本方案解决了现有单臂机械手模型因工作环境复杂性受到外部环境等影响而导致的控制性能不佳的问题,实现了全状态时变约束和降低控制代价的目的。

技术研发人员:尚亚博,史恒亮,贾得顺,曲雅婷,王澎斌,孙鹏

受保护的技术使用者:洛阳职业技术学院

技术研发日:

技术公布日:2024/3/12

- 还没有人留言评论。精彩留言会获得点赞!