基于强化学习的列车ATO控制方法、设备及存储介质与流程

基于强化学习的列车ato控制方法、设备及存储介质

技术领域

1.本技术涉及轨道交通技术领域,尤其涉及一种基于强化学习的列车ato控制方法、设备及存储介质。

背景技术:

2.城市轨道交通已经广泛应用列车ato(automatic train operation,自动驾驶)系统,传统的列车ato控制算法以采用pid(proportional-integral-derivative,比例-积分-微分)控制器为主,在调节控制器参数时主要以满足运营需求中的停车精度为主,较少考虑列车运行能耗、车辆性能变化、运行环境变化等因素,导致ato系统需要针对特定线路、特定环境、特定车辆设计开发不同的代码版本,设置不同的配置参数。开发周期长,调试成本高,控制性能差。

技术实现要素:

3.为了解决上述技术缺陷之一,本技术提供了一种基于强化学习的列车ato控制方法、设备及存储介质。

4.本技术第一个方面,提供了一种基于强化学习的列车ato控制方法,所述方法包括:

5.每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量;其中,列车自动驾驶控制算法基于强化学习训练环境训练,所述强化学习训练环境基于被控列车的动力学特性和被控列车的运行控制系统功能搭建;

6.将所述期望控制量下发给所述被控列车,以使所述被控列车根据所述期望控制量,通过所述被控车辆的控制系统得出施加的牵引力/制动力,控制所述被控列车运行。

7.可选地,所述每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量之前,还包括:

8.对被控列车的动力学特性进行建模;

9.基于建立的模型,结合所述被控列车的运行控制系统功能搭建强化学习训练环境;

10.确定基于强化学习的列车自动驾驶控制算法架构;

11.基于架构和所述强化学习训练环境,对列车自动驾驶控制算法进行训练,得到训练好的列车自动驾驶控制算法。

12.可选地,所述对被控列车的动力学特性进行建模,包括:

13.提取被控列车的数据,所述数据包括:自动驾驶通控数据中的控制指令以及列车实际的加速度;

14.通过所述数据辨识出系统增益k和时间常数τ;

15.采用惯性环节对被控列车制动延时建立如下模型:

16.其中,a为表示被控列车的实际加速度,a

des

表示被控列车的期望加速度。

17.可选地,所述强化学习训练环境,根据所述被控列车在n周期时刻施加的动作指令an,得到执行所述动作指令的状态转移:s

n+1

←

sn(an);

18.其中,s

n+1

为所述被控列车n+1周期时刻的状态,sn表示列车n周期的状态。

19.可选地,所述动作指令为加速指令,或者,减速指令,或者惰行指令。

20.可选地,所述状态为如下的一种或多种:速度,加速度,位置。

21.可选地,所述基于架构和所述强化学习训练环境,对列车自动驾驶控制算法进行训练,得到训练好的列车自动驾驶控制算法,包括:

22.基于架构和所述强化学习训练环境,得到状态空间动作空间折扣率γ,学习率α;

23.随机初始化q表q(s,a),其中,s为状态空间中的状态标识,a为动作标识,且对于任意状态s和动作a,

24.初始化起始状态s;

25.选择动作a=π(s);

26.执行动作a,得到环境反馈的即时奖励r和新状态s

′

;

27.更新q(s,a)

←

q(s,a)+α(r+γmaxa′

q(s

′

,a

′

)-q(s,a)),其中,a

′

为新动作;

28.更新状态s

←s′

;

29.重复初始化起始状态s的步骤及后续步骤,直至s为终止状态;

30.重复初始化起始状态s的步骤及后续步骤,直至q表q(s,a)收敛;

31.得到训练好的列车自动驾驶控制算法

32.可选地,所述将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量之前,还包括:

33.将预先训练好的列车自动驾驶控制算法集成至所述被控列车的自动驾驶模块。

34.本技术第二个方面,提供了一种电子设备,包括:

35.存储器;

36.处理器;以及

37.计算机程序;

38.其中,所述计算机程序存储在所述存储器中,并被配置为由所述处理器执行以实现如上述第一个方面所述的方法。

39.本技术第三个方面,提供了一种计算机可读存储介质,其上存储有计算机程序;所述计算机程序被处理器执行以实现如上述第一个方面所述的方法。

40.本技术提供基于强化学习的列车ato控制方法、设备、存储介质,其中方法包括:每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量;其中,列车自动驾驶控制算法基于强化学习训练环境训练,所述强化学习训练环境基于被控列车的动力学特性和被控列车的运行控制系统功能搭建;将期望控制量下发给被控列车,以使被控列车根据期望控制量,通过被控车辆的控

制系统得出施加的牵引力/制动力,控制被控列车运行。

41.本技术提供的方法实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制,增强列车自动驾驶控制算法自适应和泛化能力,适配多种运行场景的参数自适应,提升控制算法的鲁棒性。

42.另外,在一种实现中,对被控列车的动力学特性进行建模,进而搭建强化学习训练环境,确定基于强化学习的列车自动驾驶控制算法架构后,基于架构和所述强化学习训练环境,对列车自动驾驶控制算法进行训练,保证了训练好的列车自动驾驶控制算法的准确性,进而实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

43.另外,在一种实现中,通过被控列车的数据对被控列车的动力学特性进行建模,保证了训练环境的质量,进而保证了训练好的列车自动驾驶控制算法的准确性,实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

44.另外,在一种实现中,强化学习训练环境可以根据所述被控列车在周期时刻施加的动作指令,得到执行所述动作指令的状态转移,进而通过强化学习训练环境可以模拟实际列车运行过程,进而实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

45.另外,在一种实现中,明确了动作指令,保证了强化学习训练环境可以模拟实际列车运行过程,进而实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

46.另外,在一种实现中,明确了状态,保证了强化学习训练环境可以模拟实际列车运行过程,进而实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

47.另外,在一种实现中,明确了基于架构和所述强化学习训练环境,对列车自动驾驶控制算法进行训练的过程,保证了训练好的列车自动驾驶控制算法的准确性,实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

48.另外,在一种实现中,通过将预先训练好的列车自动驾驶控制算法集成至所述被控列车的自动驾驶模块,保证了期望控制量的高效、准确确定,实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

49.本技术提供的电子设备,其上计算机程序被处理器执行以实现列车运行安全、准时、节能、舒适、精确停车的多目标优化控制,增强列车自动驾驶控制算法自适应和泛化能力,适配多种运行场景的参数自适应,提升控制算法的鲁棒性。

50.本技术提供的计算机可读存储介质,其上的计算机程序被处理器执行以实现列车运行安全、准时、节能、舒适、精确停车的多目标优化控制,增强列车自动驾驶控制算法自适应和泛化能力,适配多种运行场景的参数自适应,提升控制算法的鲁棒性。

附图说明

51.此处所说明的附图用来提供对本技术的进一步理解,构成本技术的一部分,本技术的示意性实施例及其说明用于解释本技术,并不构成对本技术的不当限定。在附图中:

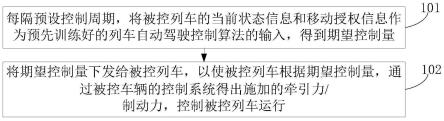

52.图1为本技术实施例提供的一种基于强化学习的列车ato控制方法的流程示意图;

53.图2为本技术实施例提供的一种强化学习示意图;

54.图3为本技术实施例提供的一种基于q-learning的ato算法框架图;

55.图4为本技术实施例提供的一种q-learning算法流程图。

具体实施方式

56.为了使本技术实施例中的技术方案及优点更加清楚明白,以下结合附图对本技术的示例性实施例进行进一步详细的说明,显然,所描述的实施例仅是本技术的一部分实施例,而不是所有实施例的穷举。需要说明的是,在不冲突的情况下,本技术中的实施例及实施例中的特征可以相互组合。

57.在实现本技术的过程中,发明人发现,城市轨道交通已经广泛应用列车ato系统,传统的列车ato控制算法以采用pid控制器为主,在调节控制器参数时主要以满足运营需求中的停车精度为主,较少考虑列车运行能耗、车辆性能变化、运行环境变化等因素,导致ato系统需要针对特定线路、特定环境、特定车辆设计开发不同的代码版本,设置不同的配置参数。开发周期长,调试成本高,控制性能差。

58.针对上述问题,本技术实施例中提供了一种基于强化学习的列车ato控制方法、设备、存储介质,其中方法包括:每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量;将期望控制量下发给被控列车,以使被控列车根据期望控制量,通过被控车辆的控制系统得出施加的牵引力/制动力,控制被控列车运行。本技术提供的方法实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制,增强列车自动驾驶控制算法自适应和泛化能力,适配多种运行场景的参数自适应,提升控制算法的鲁棒性。

59.参见图1,本实施例提供一种基于强化学习的列车ato控制方法,其实现流程如下:

60.101,每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量。

61.本步骤的期望控制量是基于预先训练好的列车自动驾驶控制算法得到的,因此在执行步骤101之前会训练好的列车自动驾驶控制算法,其中,列车自动驾驶控制算法基于强化学习训练环境训练,所述强化学习训练环境基于被控列车的动力学特性和被控列车的运行控制系统功能搭建。

62.具体的训练过程为:

63.201,对被控列车的动力学特性进行建模。

64.在步骤201中,对被控对象列车进行动力学特性建模。列车的动力学模型是搭建强化学习“环境”的基础,如图2所示。可以选择参数辨识、机器学习等等建模方法,对列车的动力学特性进行仿真建模,作为强化学习中智能体即列车执行动作(加速/减速)之后状态转移的重要依据。

65.本步骤示例性的提供一种理想的列车动力学模型,并根据历史数据进行参数辨识,采用惯性环节对列车制动延时建立模型。具体的,

66.1、提取被控列车的数据。

67.其中,数据包括:自动驾驶通控数据中的控制指令以及列车实际的加速度。

68.2、通过数据辨识出系统增益k和时间常数τ。

69.3、采用惯性环节对被控列车制动延时建立如下模型:

70.其中,a为表示被控列车的实际加速度,a

des

表示被控列车的期望加速度。

71.通过提取车载ato通控数据中的控制指令以及实际列车的加速度等数据信息,通

过数据筛选剔除无效数据,采用数据辨识的方法辨识出模型中的系统增益和时间常数。其中关于基本阻力和坡道阻力的建模可以采用经验值对其建模,在控制器设计完之后作为干扰补偿控制列车运行。

72.202,基于建立的模型,结合被控列车的运行控制系统功能搭建强化学习训练环境。

73.列车运行控制系统式基于计算机、通信及控制等现代信息技术应用,实现全过程实时控制列车运行的复杂自动控制系统。为了模拟实际列车运行过程,需要基于步骤201的基础上实现列车动力学模块的仿真。为了简化实现,选择只实现关键模块逻辑,包括电子地图数据生成、防护速度计算等功能。

74.当强化学习ato模块输出列车的动作(加速、减速和惰行)指令时,环境能够根据智能体输出的动作指令,输出在该状态下执行该动作的状态转移。

75.即,强化学习训练环境可以根据被控列车在n周期时刻施加的动作指令an,得到执行动作指令的状态转移:s

n+1

←

sn(an)。

76.其中,s

n+1

为被控列车n+1周期时刻的状态,sn表示列车n周期的状态。

77.动作指令an为加速指令,或者,减速指令,或者惰行指令。

78.状态为如下的一种或多种:速度,加速度,位置。

79.203,确定基于强化学习的列车自动驾驶(ato)控制算法架构。

80.同时,还会设计强化学习算法的奖励函数。

81.常用的强化学习算法有q-learning、dqn、a2c、a3c等。根据实际的硬件条件和功能需求,本步骤可以采用其中一种算法作为列车ato控制算法的架构。

82.例如,基于q-learning的强化学习ato控制算法,其算法框架图如图3所示,q-learning的算法流程图如图4所示。

83.列车自动驾驶控制过程是一个多目标的控制过程,通过量化运行控制过程中评价指标,其中包括但不限于安全性(不超过atp限速)、节能性、停车精度(

±

30cm)、准时性和舒适性(冲击率)等,不同评价指标根据需求设置不同的权重来区分不同评价指标之间的重要程度,可通过加权平均的方式作为强化学习的奖励函数。

84.204,基于架构和强化学习训练环境,对列车自动驾驶(ato)控制算法进行训练,得到训练好的列车自动驾驶控制算法。

85.根据步骤203选取的强化学习算法架构结合步骤202建立的训练环境,对基于强化学习的ato控制算法进行离线训练。

86.本步骤采用如下的训练流程:

87.基于架构和强化学习训练环境,得到状态空间动作空间折扣率γ,学习率α。将状态空间动作空间折扣率γ,学习率α作为训练的输入。

88.1、随机初始化q表q(s,a),

89.其中,s为状态空间中的状态标识,a为动作标识,且对于任意状态s和动作a,

90.2、初始化起始状态s。

91.3、在状态s,选择动作a=π(s)。

92.4、执行动作a,得到环境反馈的即时奖励r和新状态s

′

。

93.5、更新q(s,a)

←

q(s,a)+α(r+γmaxa′

q(s

′

,a

′

)-q(s,a)),其中,a

′

为新动作。

94.6、更新状态s

←s′

。

95.7、重复初始化起始状态s的步骤及后续步骤,直至s为终止状态。

96.即重复步骤2-7直至s为终止状态。

97.8、重复初始化起始状态s的步骤及后续步骤,直至q表q(s,a)收敛。

98.即重复步骤2-8直至q表q(s,a)收敛。

99.得到训练好的列车自动驾驶控制算法即输出为策略

100.102,将期望控制量下发给被控列车,以使被控列车根据期望控制量,通过被控车辆的控制系统得出施加的牵引力/制动力,控制被控列车运行。

101.1、将预先训练好的列车自动驾驶控制算法集成至被控列车的自动驾驶(ato)模块。

102.2、根据传感器采集的列车状态信息和移动授权信息作为强化学习的列车ato控制算法的输入,输出列车的期望控制量。

103.3、将2所得列车控制量下发给被控列车,被控列车根据列车控制量通过车辆控制系统得出其应施加的牵引力/制动力,控制列车运行。

104.待到下一个控制周期,重复步骤101和步骤102的内容,从而完成了基于强化学习的智能列车自动驾驶控车运行。

105.本实施例提供的方法针对传统列车ato控制算法自适应能力弱,控制效果不理想等问题,提出一种基于强化学习的列车智能控制算法,实现列车运行安全、准时、节能、舒适、精确停车的多目标优化控制。

106.另外,本实施例提供的方法基于历史数据对被控对象进行数学建模,基于被控对象模型和强化学习算法架构设计基于强化学习的列车智能ato控制算法,对列车进行智能自动驾驶控车运行。

107.此外,本实施例提供的方法,在学习优秀司机驾驶操纵模式、泛化对未知状态的适应能力等方面具有很大的优势,有较大潜力实现城市轨道交通列车车载的智能控制,全面提升列车驾驶控制的灵活性、准点、舒适及节能等性能。

108.本实施例提供基于强化学习的列车ato控制方法,每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量;其中,列车自动驾驶控制算法基于强化学习训练环境训练,所述强化学习训练环境基于被控列车的动力学特性和被控列车的运行控制系统功能搭建;将期望控制量下发给被控列车,以使被控列车根据期望控制量,通过被控车辆的控制系统得出施加的牵引力/制动力,控制被控列车运行,实现了列车运行安全、准时、节能、舒适、精确停车的多目标优化控制,增强列车自动驾驶控制算法自适应和泛化能力,适配多种运行场景的参数自适应,提升控制算法的鲁棒性。

109.基于基于强化学习的列车ato控制方法的同一发明构思,本实施例提供一种电子设备,该电子设备包括:存储器,处理器,以及计算机程序。

110.其中,计算机程序存储在存储器中,并被配置为由处理器执行以实现上述基于强化学习的列车ato控制方法。

111.具体的,

112.每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量。其中,列车自动驾驶控制算法基于强化学习训练环境训练,所述强化学习训练环境基于被控列车的动力学特性和被控列车的运行控制系统功能搭建。

113.将期望控制量下发给被控列车,以使被控列车根据期望控制量,通过被控车辆的控制系统得出施加的牵引力/制动力,控制被控列车运行。

114.可选地,每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量之前,还包括:

115.对被控列车的动力学特性进行建模。

116.基于建立的模型,结合被控列车的运行控制系统功能搭建强化学习训练环境。

117.确定基于强化学习的列车自动驾驶控制算法架构。

118.基于架构和强化学习训练环境,对列车自动驾驶控制算法进行训练,得到训练好的列车自动驾驶控制算法。

119.可选地,对被控列车的动力学特性进行建模,包括:

120.提取被控列车的数据,数据包括:自动驾驶通控数据中的控制指令以及列车实际的加速度。

121.通过数据辨识出系统增益k和时间常数τ。

122.采用惯性环节对被控列车制动延时建立如下模型:

123.其中,a为表示被控列车的实际加速度,a

des

表示被控列车的期望加速度。

124.可选地,强化学习训练环境,根据被控列车在n周期时刻施加的动作指令an,得到执行动作指令的状态转移:s

n+1

←

sn(an)。

125.其中,s

n+1

为被控列车n+1周期时刻的状态,sn表示列车n周期的状态。

126.可选地,动作指令为加速指令,或者,减速指令,或者惰行指令。

127.可选地,状态为如下的一种或多种:速度,加速度,位置。

128.可选地,基于架构和强化学习训练环境,对列车自动驾驶控制算法进行训练,得到训练好的列车自动驾驶控制算法,包括:

129.基于架构和强化学习训练环境,得到状态空间动作空间折扣率γ,学习率α。

130.随机初始化q表q(s,a),其中,s为状态空间中的状态标识,a为动作标识,且对于任意状态s和动作a,

131.初始化起始状态s。

132.选择动作a=π(s)。

133.执行动作a,得到环境反馈的即时奖励r和新状态s

′

。

134.更新q(s,a)

←

q(s,a)+α(r+γmaxa′

q(s

′

,a

′

)-q(s,a)),其中,a

′

为新动作。

135.更新状态s

←s′

。

136.重复初始化起始状态s的步骤及后续步骤,直至s为终止状态。

137.重复初始化起始状态s的步骤及后续步骤,直至q表q(s,a)收敛。

138.得到训练好的列车自动驾驶控制算法

139.可选地,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量之前,还包括:

140.将预先训练好的列车自动驾驶控制算法集成至被控列车的自动驾驶模块。

141.本实施例提供的电子设备,其上计算机程序被处理器执行以实现列车运行安全、准时、节能、舒适、精确停车的多目标优化控制,增强列车自动驾驶控制算法自适应和泛化能力,适配多种运行场景的参数自适应,提升控制算法的鲁棒性。

142.基于基于强化学习的列车ato控制方法的同一发明构思,本实施例提供一种计算机可其上存储有计算机程序。计算机程序被处理器执行以实现上述基于强化学习的列车ato控制方法。

143.具体的,

144.每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量。其中,列车自动驾驶控制算法基于强化学习训练环境训练,所述强化学习训练环境基于被控列车的动力学特性和被控列车的运行控制系统功能搭建。

145.将期望控制量下发给被控列车,以使被控列车根据期望控制量,通过被控车辆的控制系统得出施加的牵引力/制动力,控制被控列车运行。

146.可选地,每隔预设控制周期,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量之前,还包括:

147.对被控列车的动力学特性进行建模。

148.基于建立的模型,结合被控列车的运行控制系统功能搭建强化学习训练环境。

149.确定基于强化学习的列车自动驾驶控制算法架构。

150.基于架构和强化学习训练环境,对列车自动驾驶控制算法进行训练,得到训练好的列车自动驾驶控制算法。

151.可选地,对被控列车的动力学特性进行建模,包括:

152.提取被控列车的数据,数据包括:自动驾驶通控数据中的控制指令以及列车实际的加速度。

153.通过数据辨识出系统增益k和时间常数τ。

154.采用惯性环节对被控列车制动延时建立如下模型:

155.其中,a为表示被控列车的实际加速度,a

des

表示被控列车的期望加速度。

156.可选地,强化学习训练环境,根据被控列车在n周期时刻施加的动作指令an,得到执行动作指令的状态转移:s

n+1

←

sn(an)。

157.其中,s

n+1

为被控列车n+1周期时刻的状态,sn表示列车n周期的状态。

158.可选地,动作指令为加速指令,或者,减速指令,或者惰行指令。

159.可选地,状态为如下的一种或多种:速度,加速度,位置。

160.可选地,基于架构和强化学习训练环境,对列车自动驾驶控制算法进行训练,得到训练好的列车自动驾驶控制算法,包括:

161.基于架构和强化学习训练环境,得到状态空间动作空间折扣率γ,学习率α。

162.随机初始化q表q(s,a),其中,s为状态空间中的状态标识,a为动作标识,且对于任意状态s和动作a,

163.初始化起始状态s。

164.选择动作a=π(s)。

165.执行动作a,得到环境反馈的即时奖励r和新状态s

′

。

166.更新q(s,a)

←

q(s,a)+α(r+γmaxa′

q(s

′

,a

′

)-q(s,a)),其中,a

′

为新动作。

167.更新状态s

←s′

。

168.重复初始化起始状态s的步骤及后续步骤,直至s为终止状态。

169.重复初始化起始状态s的步骤及后续步骤,直至q表q(s,a)收敛。

170.得到训练好的列车自动驾驶控制算法

171.可选地,将被控列车的当前状态信息和移动授权信息作为预先训练好的列车自动驾驶控制算法的输入,得到期望控制量之前,还包括:

172.将预先训练好的列车自动驾驶控制算法集成至被控列车的自动驾驶模块。

173.本实施例提供的计算机可读存储介质,其上的计算机程序被处理器执行以实现列车运行安全、准时、节能、舒适、精确停车的多目标优化控制,增强列车自动驾驶控制算法自适应和泛化能力,适配多种运行场景的参数自适应,提升控制算法的鲁棒性。

174.本领域内的技术人员应明白,本技术的实施例可提供为方法、系统、或计算机程序产品。因此,本技术可采用完全硬件实施例、完全软件实施例、或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质(包括但不限于磁盘存储器、cd-rom、光学存储器等)上实施的计算机程序产品的形式。本技术实施例中的方案可以采用各种计算机语言实现,例如,面向对象的程序设计语言java和直译式脚本语言javascript等。

175.本技术是参照根据本技术实施例的方法、设备(系统)、和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框、以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

176.这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

177.这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或

其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

178.尽管已描述了本技术的优选实施例,但本领域内的技术人员一旦得知了基本创造性概念,则可对这些实施例作出另外的变更和修改。所以,所附权利要求意欲解释为包括优选实施例以及落入本技术范围的所有变更和修改。

179.显然,本领域的技术人员可以对本技术进行各种改动和变型而不脱离本技术的精神和范围。这样,倘若本技术的这些修改和变型属于本技术权利要求及其等同技术的范围之内,则本技术也意图包含这些改动和变型在内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1