一种边缘辅助的雷视融合的无人机目标检测方法与系统

本发明涉及无人机应用,尤其涉及一种边缘辅助的雷视融合的无人机目标检测方法与系统。

背景技术:

1、由于无人机具有体积小、成本低、高机动性、高自主性、可搭载丰富的传感器、可提供通信与处理能力和广阔的“鸟瞰图”等优点,使得无人机正成为一个重要的传感平台。尤其是目标检测能力,支持许多重要的应用,如搜索救援、农田偷盗者检测和非法车辆检测等。

2、目前,随着深度学习的成功,基于视觉的无人机视角目标检测工作取得了不错的效果。但是在雾天、光照不足等恶劣条件下,它们的性能会严重下降。毫米波雷达作为一种新兴的自主感知模式,可以克服这些恶劣条件,在自动驾驶和智能交通中得到了广泛应用。由于毫米波雷达点云的稀疏和噪声特点,将毫米波雷达和相机融合已成为恶劣条件下进行鲁棒目标检测的一个趋势。

3、本发明聚焦于在无人机上实现毫米波雷达与相机融合的目标检测。然而,将毫米波雷达与相机融合的技术应用在无人机的目标检测上实现起来具有以下困难:(1)无人机通常具有“移动性+斜视角”的特点,加剧了雷达点云的稀疏性和噪声;(2)现有融合方法要么涉及的传感器较多,要么设备比较笨重和昂贵,阻碍了无人机的广泛应用;(3)一些先进的融合方法需要密集的计算,难以在无人机上实时运行。因此,现有技术难以在移动的无人机上实现一个低成本、实时、鲁棒的目标检测。

技术实现思路

1、本发明的目的是提供一种边缘辅助的雷视融合的无人机目标检测方法及系统,解决恶劣环境下在无人机上融合毫米波雷达与相机进行目标检测所面临的低鲁棒性和高时延的问题。

2、为了实现上述目的,本发明提供如下技术方案:

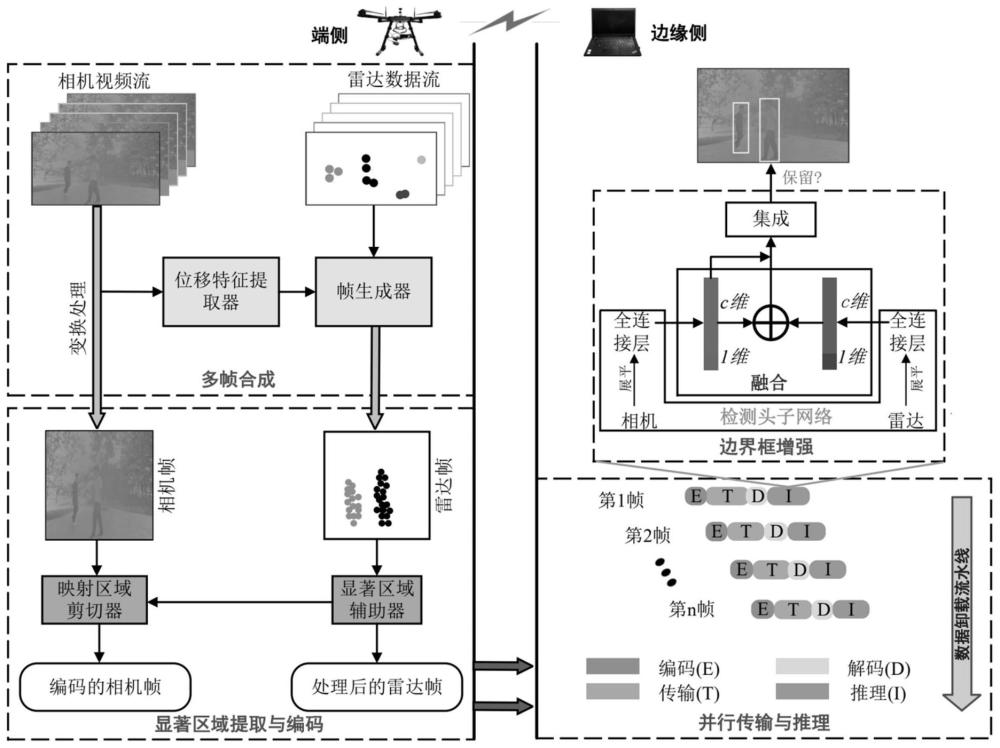

3、一方面,本发明提供了一种边缘辅助的雷视融合的无人机目标检测方法,包括以下步骤:

4、s1、多帧合成:使用摄像头获取相机视频流,相机视频流经过变换处理得到相机帧;使用毫米波雷达获得雷达数据流,相机视频流通过位移特征提取器获得摄影机帧间位移向量,摄影机帧间位移向量和雷达数据流通过帧生成器生成雷达点云帧;

5、s2、显著区域提取与编码:雷达点云帧通过显著区域辅助器形成处理后的雷达帧,相机帧和处理后的雷达帧通过映射区域剪切器生成编码的相机帧;

6、s3、并行传输与推理:将处理后的雷达帧和编码的相机帧的编码、传输、解码和推理并行执行,同时在推理过程中执行边界框增强方法。

7、进一步地,步骤s1中位移特征提取方法为:首先使用轻量级光流方法提取相机分支中两个相邻帧i与i+1的背景中相对应的兴趣点对(pi,pi+1);然后分别计算每一对兴趣点对(pi,j,pi+1,j)之间的位移向量di,j;之后对位移向量执行聚类,并选取最密集簇中的位移向量的平均值作为这两帧之间的位移向量d′i;最后进行坐标系转换,获得帧i与帧i+1之间的在世界坐标系中的相机位移向量di。

8、进一步地,步骤s1雷达点云帧生成方法为:在获得帧间位移向量di后,从对应的雷达点云帧fi中减去位移向量di,生成偏移后的对应帧f′i;随后,对连续5帧(f′i-4,…,f′i)进行叠加,生成叠加后的雷达点云帧f′i;最后对生成的f′i进行聚类处理,生成最终的雷达点云帧fi。

9、进一步地,步骤s2对显著区域相应的图像分支进行低质量的压缩,将图像分支的其它区域不进行压缩,同时在传输过程中,雷达点云以点集合的形式传输。

10、进一步地,步骤s2对显著区域提取方法为:

11、首先,根据多帧合成模块输出的合成点云帧fi及其聚类信息,确定第k个聚类的边界范围{(xk,min,yk,min),(xk,max,yk,max)},具体计算公式如下:

12、xk,min=min{x1,x2,…,xn},[x1,x2,…,xn]∈fi,k

13、yk,min=min{y1,y2,…,yn},[y1,y2,…,yn]∈fi,k

14、xk,max=max{x1,x2,…,xn},[x1,x2,…,xn]∈fi,k

15、yk,max=max{y1,y2,…,yn},[y1,y2,…,yn]∈fi,k

16、其中,(xn,yn)是合成点云帧fi中第k个聚类的第n个点的坐标;

17、然后,根据该边界范围绘制第k个聚类对应的显著区域sk,公式如下:

18、sk=[(xk,min,yk,min),(xk,max,yk,max)],

19、最后生成合成点云帧fi对应的显著区域集合{sk}。

20、进一步地,步骤s2对显著区域进行编码的方法为:

21、首先,对显著区域进行扩展,扩展的公式如下:

22、s′k=[(xk,min-xpadding,yk,min-ypadding),(xk,max+xpadding,yk,max+ypadding)]

23、然后,根据实际数据启发式地确定x与y方向的填充值m,然后将两个显著区域之间的距离d与填充值m进行对比;当d>2m时,两个显著区域分别扩展并提取,否则将这两个显著区域合并为一个后扩展并提取;对当前帧中的所有显著区域进行上述扩展操作,生成扩展后的显著区域集合{s′k};

24、最后,通过对显著区域进行编码并对其它部分不进行压缩,形成编码后的图像帧。

25、进一步地,步骤s3边界框增强方法为:采用检测头子网络获得来自图像分支与来自毫米波雷达分支的检测结果和置信度分数,并采用两个传感器的感知模式对两个检测分支输出的检测结果与置信分数进行融合,输出输出具有相同的维数的向量,采用深度神经网络对两个向量进行集成并执行边界框增强。

26、进一步地,检测头子网络首先将特征图展平,然后使用512维的全连接层,然后采用两个兄弟全连接层,分别用于边界框回归和分类,输出为一个四维向量和一个c+1维向量,其中c为类别的数量。

27、进一步地,深度神经网络的第一个全连接层合并来自每个类的两个输入的信息,第二个全连接层捕获类之间的全局相关性,最后的激活函数层输出一个2维矢量,同时设置了一个阈值来确定是否保留边界框。

28、另一方面,本发明还提供了一种边缘辅助的雷视融合的无人机目标检测系统,用于实现上述任一项的方法,包括以下模块:

29、多帧合成模块,用于将摄像头获得的相机视频流和毫米波雷达获得的雷达数据流转换为相机帧和雷达点云帧,多帧合成模块包括位移特征提取器和帧生成器,其中,位移特征提取器用于获得摄影机帧间位移向量,帧生成器用于将摄影机帧间位移向量和雷达数据流通生成雷达点云帧;

30、显著区域提取与编码模块,包括显著区域辅助器和映射区域剪切器,其中,雷达点云帧通过显著区域辅助器形成处理后的雷达帧,相机帧和处理后的雷达帧通过映射区域剪切器生成编码的相机帧;

31、并行传输与推理模块,将处理后的雷达帧和编码的相机帧的编码、传输、解码和推理并行执行,同时在推理过程中执行边界框增强方法;并行传输与推理模块包括检测头子网络、融合模块和集成模块,其中,检测头子网络首先将特征图展平,然后使用512维的全连接层,然后是两个兄弟全连接层,用于边界框回归和分类;融合模块使用中间卷积层来获得置信分数,然后将来自两个分支的置信度分数相加,并发送到激活函数层以获得融合分数;集成模块基于深度神经网络,第一个全连接层合并来自每个类的两个输入的信息,第二个全连接层捕获类之间的全局相关性,最后的激活函数层输出一个2维矢量。

32、与现有技术相比,本发明的有益效果为:

33、本发明提出的边缘辅助的雷视融合的无人机目标检测方法及系统,对无人机采集的毫米波雷达点云和视频数据进行预处理,利用相机分支协助毫米波雷达分支进行多帧合成来解决无人机移动下毫米波雷达点云的稀疏性和噪声加剧的问题;利用多帧合成方法输出的雷达点云帧辅助相机分支进行目标显著区域提取与编码,以此减少传输的数据量和相应的卸载延迟;将毫米波雷达和相机数据的编码、传输、解码和推理并行化,以进一步减少卸载延迟;同时,在推理过程中采用边界框增强方案来确保准确率-延迟之间的平衡,最终达到实时、鲁棒的目标检测目的。本发明可以应用到各种需要无人机进行目标检测的任务中,可以高效率完成恶劣条件下对相关区域的巡检。

- 还没有人留言评论。精彩留言会获得点赞!