一种基于单目视觉深度估计的车辆测距方法

本发明属于自动驾驶,具体涉及一种基于单目视觉深度估计的车辆测距方法。

背景技术:

1、自动驾驶车辆在提高行车的安全性与节约能源等方面具有显著优势。而现阶段常用的环境感知传感器是基于视觉的传感器,由于单目视觉相机本身不能提供深度信息,因此需要对单目视觉的深度信息进行估计,具有十分重要的研究意义和价值。

2、单目视觉深度估计的方法主要分为两类,第一类是基于传统方法的单目视觉深度估计包括几何法、等距映射以及拟合法。

3、基于几何法的单目视觉深度估计,通常会利用车辆在成像模型中的几何位置关系来推导图像坐标系和世界坐标系之间的对应关系。例如,鲁威威在论文《基于单目视觉的前方车辆检测与测距方法研究》中根据小孔成像模型,将单目视觉系统简化为摄像机投影模型,并利用几何关系,推导出路面坐标与图像坐标之间的对应关系。该方法需要进行复杂的相机标定并且深度估计精度不高;并且没有考虑车辆姿态改变的问题,当车辆行驶过程中发生姿态改变,基于几何法的单目视觉深度估计精度下降。

4、meng chaochao在论文《visual meterstick: preceding vehicle rangingusing mon-ocular vision based on the fitting method》中运用了拟合的方法,通过摄像头获取车辆前方的图像,并进行车辆检测,依据车辆边界框获得对应的像素值,最后根据边界框的像素值将拟合法用于车载单目相机进行测距。该方法需要车辆边界框对应的像素值,因此车辆姿态改变时,同一车距下,车辆目标在图像中的位置改变,车辆边界框对应的像素值容易改变,导致深度估计精度下降。

5、cn114659489a公布了一种基于凸透镜成像原理的前车距离检测方法和装置。所述方法包括:通过相机采集图像,获取图像中车牌宽度、车牌左下角坐标和车道线的函数方程,计算车道线宽度;基于凸透镜成像原理计算世界坐标系下的车道宽度,然后计算前车车距。该方法需要进行复杂的相机标定,并且忽视了车辆姿态改变的影响。由于需要检测图像中车牌宽度和车牌左下角坐标点,当车辆姿态改变,检测图像所获取的数据会改变,导致深度估计精度下降。

6、基于等距映射的单目视觉深度估计,需要进行等间距点测量及标定。例如,王战古在论文《大型客车环境感知系统设计及前方障碍物检测方法研究》中,进行了等间距点测量并标记;通过相机采集实验图像,并对图像中测量点所在的像素行进行标定。该方法需要进行复杂的相机标定,确保相机纵向对称面与水平地面垂直,并没有考虑到车辆姿态改变的影响;等距映射方法还需要控制间距的大小,过大或者偏小都会导致估计精度下降。

7、基于传统方法的单目视觉深度估计并没有考虑到车辆行驶过程中,若遇到障碍物,车辆姿态会发生改变的问题,当车辆姿态改变时,容易导致深度估计的精度下降。并且传统的方法需要进行复杂的相机标定,若标定不准,容易降低深度估计精度。

8、第二类是基于深度学习的单目视觉深度估计方法,该方法需要大量的图像以及对应的深度图,通过深度学习的方式处理大量数据,例如mohammadm.haji-esmaeili在论文《large-scale monocular depth estimation in the wild》中,fu junwei在论文《monocular depth estimation based on multi-scale graph convolution networks》中,需要通过大量的图像以及深度图来训练复杂模型,而获取大量的深度图比较困难,成本较高,目前只能利用已有的大型数据集训练深度估计模型,对计算力的需求非常高,实时性不高。并未考虑车辆姿态改变的问题。专利cn110414674a公开了一种单目视觉深度估计的方法,所述方法包括:获取深度估计原始图像及对应的已知深度的深度估计标签图像,将所有原始图像及其对应的深度估计标签图像构成训练集;构建神经网络模型;将训练集输入到神经网络模型进行训练,获得神经网络模型,实现单目图像深度估计。由于很难获取带有真实深度的数据集,现有方式大多依靠已有的数据集,训练复杂的模型,对算力要求较高,实时性不高。

9、cn116152323a公开了一种深度估计方法,所述方法包括:获取目标场景的多个视角的样本图像、对应图像的gt深度图和目标场景的几何约束;将图像作为训练数据,图像的gt深度图和几何约束作为监督信息,迭代训练初始单目视觉深度估计模型,得到单目视觉深度估计模型。该方法需要获取图像样本以及各所述图像样本对应的实际深度图,比较困难,并且复杂的模型对算力的要求较高,实时性不高。

10、cn110322499a公开了一种基于多层特征的单目图像深度估计方法,所述方法包括:选取原始单目视觉深度估计图像以及其对应已知的深度估计标签图并构成训练集,构建神经网络,将训练集输入到神经网络模型中进行训练,不断迭代训练,完成神经网络模型的训练。该方法没有考虑车辆姿态改变的影响,并且获取深度估计标签图比较困难,复杂的深度估计模型对算力要求高,实时性不高。

11、基于深度学习的方式需要处理大量的图像以及深度图,实时性不高;而且对算力的要求高,这意味着它需要在性能较强的硬件上运行,而不能在小型芯片上运行。实际中获取这些深度图,会用到较为昂贵的传感器,增加了成本。特别是在不考虑车辆姿态改变的情况下,深度估计的精度很容易降低。

12、针对现有的技术问题,本发明考虑到车辆姿态对深度估计的影响,提出一种单目视觉深度估计方法。第一,本发明将车辆姿态的信息加入车辆深度估计中,进一步提升车辆深度估计的精度;第二,本发明提出基于数据驱动的单目视觉深度估计方法,将多变量的复杂机理建模问题转化为数据驱动的回归问题,不仅提升了深度估计的精度,而且减少了计算资源消耗,降低成本,提高实时性。

技术实现思路

1、为了解决现有技术的不足,本发明提供了一种基于单目视觉深度估计的车辆测距方法,设计合理,解决了现有技术的不足,具有良好的效果。

2、本发明采用如下技术方案:

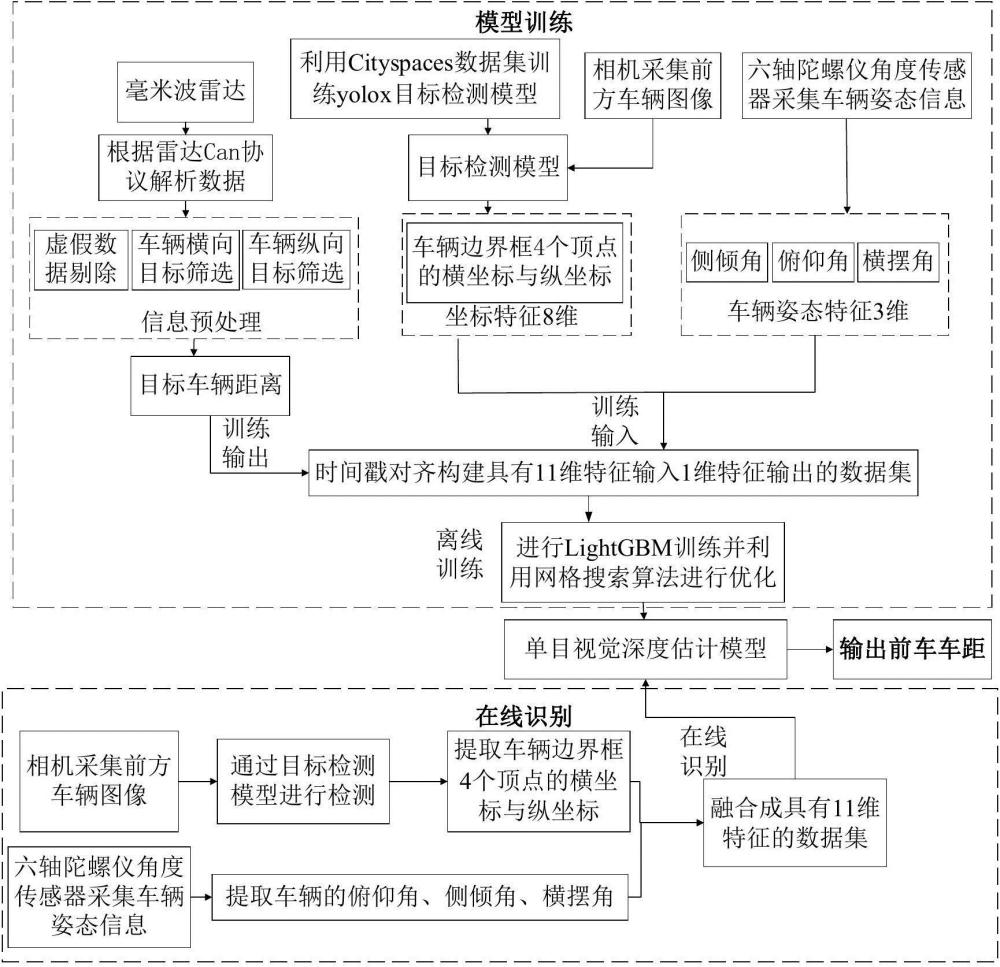

3、一种基于单目视觉深度估计的车辆测距方法,包括以下步骤:

4、s1、采集公路场景下的实验数据,通过安装有相机、毫米波雷达和六轴陀螺仪角度传感器的测距车辆进行数据采集,构建数据集;

5、s2、将数据集进行lightgbm训练,并采用网络搜索算法进行优化,生成单目视觉深度估计模型;

6、s3、在车辆实际行驶过程中,由安装在测距车辆上的相机和六轴陀螺仪角度传感器进行实时采集数据,并输入到s2中的单目视觉深度估计模型进行在线识别。

7、进一步地,所述s1中,包括以下子步骤:

8、s1.1、在数据采集前,设置时间戳,使相机、毫米波雷达和六轴陀螺仪角度传感器用相同的时间基准;

9、s1.2、通过相机采集前方图像进行目标车辆检测,获取目标车辆边界框4个顶点的坐标;

10、s1.3、利用毫米波雷达确定前方图像中目标车辆与测距车辆的真实车距;

11、s1.4、通过六轴陀螺仪角度传感器获取测距车辆的姿态;

12、s1.5、进行时间戳对齐,根据测距车辆的姿态、目标车辆边界框4个顶点的坐标以及真实车距,构建具有11维特征输入、1维特征输出的数据集。

13、进一步地,所述s1.2中,包括以下子步骤:

14、s1.2.1、采用相机采集前方车辆图像;

15、s1.2.2、利用cityscapes数据集训练yolox目标检测模型,得到训练好的yolox目标检测模型;

16、s1.2.3、将s1.2.1中前方车辆图像输入s1.2.2中训练好的目标检测模型中,通过目标检测获取图像中车辆边界框;

17、s1.2.4、提取目标车辆边界框4个顶点的横坐标和纵坐标。

18、进一步地,所述s1.3中,包括以下子步骤:

19、s1.3.1、根据雷达can协议解析毫米波雷达采集的数据;

20、s1.3.2、对解析后的数据进行预处理,先采用生命周期算法剔除虚假算法,再通过设置横向距离的阈值为±4.92米,只保留测距车辆位于的车道与相邻车道的目标车辆数据,最后通过设置纵向距离的阈值,只保留测距车辆前方100米内的目标车辆数据;

21、s1.3.3、根据时间戳,确定不同图像中的目标车辆相对于测距车辆的车距。

22、进一步地,所述s1.4中,包括以下子步骤:

23、s1.4.1、根据六轴陀螺仪角度传感器采集测距车辆的姿态;

24、s1.4.2、根据时间戳,提取各时刻测距车辆的侧倾角、俯仰角和横摆角。

25、进一步地,所述s2中,包括以下子步骤:

26、s2.1、将数据集导入,并利用lightgbm 训练;

27、s2.2、采用网络搜索算法对lightgbm模型参数进行优化,参数包括最大深度、随机性参数、随机特征参数、l1正则化参数、l2正则化参数,提高深度估计的精度,并生成最终的单目视觉深度估计模型。

28、进一步地,所述s3中,包括以下子步骤:

29、s3.1、获取前方车辆图像,并进行目标检测,提取前方图像中目标车辆边界框4个顶点的横坐标和纵坐标;

30、s3.2、提取测距车辆姿态,包括侧倾角、俯仰角和横摆角;

31、s3.3、将测距车辆姿态角与目标车辆边界框4个顶点的横坐标与纵坐标作为模型输入,在线识别,输出车距。

32、有益技术效果:

33、本发明将车辆姿态的信息加入车辆深度估计中,进一步提升车辆深度估计的精度;提出基于数据驱动的单目视觉深度估计方法,将多变量的复杂机理建模问题转化为数据驱动的回归问题,不仅提升了深度估计的精度,而且减少了计算资源消耗,降低成本,提高实时性。

- 还没有人留言评论。精彩留言会获得点赞!