一种多智能体多场景数据集训练的自动驾驶方法

1.本发明涉及自动驾驶技术领域,更具体地,涉及一种多智能体多场景数据集训练的自动驾驶方法。

背景技术:

2.随着社会生产力的提高,人们对于高品质生活的追求也越来越高,完全的自动驾驶技术无疑能使人们在通勤路上享受更改品质的生活,因此自动驾驶技术就是未来。目前市面已经上市或者还未上市的自动驾驶技术,普遍都是基于单智能体的各种路径规划、避障算法和多传感器融合的组合下实现的。但是,由于现实场景实在太过于复杂,基于单智能体算法穷尽所有现实场景基本不可能,这从近年来不论是特斯拉还是其他运用自动驾驶技术厂商出事的新闻来看就证实了这一技术瓶颈,不论是刚开始一片叶子飞来,然后被不聪明的算法认为是障碍物,然后紧急停车;还是在白雪茫茫的雪地,传感器几乎认不出障碍物。虽然这些问题,目前都解决了,但是这意味着需要无穷无尽的算法更新。导致自动驾驶过程中数据处理不够快速、高效。

技术实现要素:

3.本发明为克服上述现有技术所述的自动驾驶过程中数据处理不够快速、高效缺陷,提供一种多智能体多场景数据集训练的自动驾驶方法。

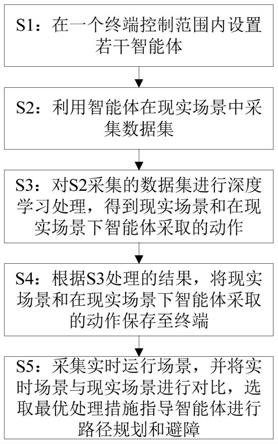

4.所述方法包括以下步骤:

5.s1:在一个终端控制范围内设置若干智能体;

6.s2:利用智能体在现实场景中采集数据集;

7.s3:对s2采集的数据集进行深度学习处理,得到现实场景和在现实场景下智能体采取的动作;

8.s4:根据s3处理的结果,将现实场景和在现实场景下智能体采取的动作保存至终端;

9.s5:智能体采集实时运行场景,并将实时运行场景转换为数据发送至终端;终端将实时运行场景与终端保存的现实场景进行对比,当达到预设相似度值后,终端选取最优处理措施指导智能体进行路径规划和避障。

10.优选地,s3具体包括以下步骤:

11.s3.1:初始化存放自动驾驶智能体所采集数据的容器,以及初始化该容器的大小;确定该容器可容纳的数据条数n;

12.s3.2:初始化q函数,并根据智能体采集到的数据对q函数进行更新,得到最高评分状态下的q函数;

13.s3.3:利用最高评分状态下的q函数对显示场景进行处理,并将处理后得出的动作;

14.s3.4:将现实场景和s3.3得到的动作存储至终端。

15.优选地,s3.2包括以下步骤:

16.s3.2.1:设φ

t

为智能体采集到的第t个数据,r

t

为第t个分数;令t=1;

17.其中,r1为初始分数值,根据工程经验进行人为设置;

18.s3.2.2:将φ

t

和r

t

输入q函数,得到一个q值;

19.s3.2.3:按以下两种方式之一选择一个动作;

20.(1)任意选择一个动作;(2)根据q值选择一个动作;

21.s3.2.4:s3.4:智能体开始在仿真器中执行s3.3中所选择的操作;得到分数r

t+1

,并根据q函数的损失函数来更新θ;

22.s3.2.5:判断t>n是否成立,若成立则结束操作,并输出评分最高状态下的θ,然后利用更新后的θ对q函数进行更新;

23.若不成立,则将得到的r

t+1

、更新后的θ、φ

t+1

存储至容器,且令t=t+1,并返回s3.2.2。

24.优选地,s3.2.3中选择动作的方法具体为:

25.构建动作函数;

26.以任意选择一个动作的概率为ε,根据q值选择一个动作的概率为1

‑

ε,

27.如果没有发生根据q值选择一个动作的情况,则选择当前动作函数值最大的动作。

28.优选地,如果没有发生根据q值选择一个动作的情况,则根据贪婪策略选择当前选择动作函数值最大的动作。

29.优选地,动作函数为:a

t

=argmaxq(s,a,θ)

30.其中,q(s,a,θ)为q函数。

31.优选地,q函数的损失函数为:

32.δθ=e[(r

t

+γmaxq(s',a',θ)

‑

q(s,a,θ)]

[0033]

其中,γ为衰减因子,γ∈(0,1),q(s',a',θ)为q(s,a,θ)的倒数,e[

·

]表示求均值。

[0034]

优选地,及更新θ的公式为:θ=θ+δθ。

[0035]

优选地,s5中终端通过融合a

‑

star算法(全局路径规划算法)和teb算法(局部路径规划算法)选取最优处理措施指导智能体进行路径规划和避障。

[0036]

优选地,通过融合a

‑

star算法和teb算法选取最优处理措施指导智能体进行路径规划和避障的具体操作为:

[0037]

首先通过全局路径规划算法进行路线规划,在智能体行驶的过程中判断是否遇到动态路障,若没有遇到路障则按规划的路线进行行驶,若遇到路障,则通过局部路径规划算法进行避障,在避障过程中根据s3所处理得出的动作进行避障。

[0038]

与现有技术相比,本发明技术方案的有益效果是:

[0039]

本发明能自动采集各种现实复杂场景,进行深度强化学习从而抽象出具体处理方式,然后保存在某一终端,然后通过无线通信将该处理方式发送到各个智能体,指导各个智能体的运动,可以减少每个智能体部分终端硬件组成,更大的效果在于,由于收集到的数据够大,所以,智能体能处理几乎所有场景,同时,由于结合了深度强化学习,使得终端在处理收集到的这些数据更加快速、高效。

附图说明

[0040]

图1为实施例1所述多智能体多场景数据集训练的自动驾驶方法流程图。

具体实施方式

[0041]

附图仅用于示例性说明,不能理解为对本专利的限制;

[0042]

为了更好说明本实施例,附图某些部件会有省略、放大或缩小,并不代表实际产品的尺寸;

[0043]

对于本领域技术人员来说,附图中某些公知结构及其说明可能省略是可以理解的。

[0044]

下面结合附图和实施例对本发明的技术方案做进一步的说明。

[0045]

实施例1

[0046]

本实施例提供一种多智能体多场景数据集训练的自动驾驶方法,如图1所示,所述方法包括以下步骤:

[0047]

s1:在一个终端控制范围内设置若干智能体;

[0048]

s2:利用智能体在现实场景中采集数据集;

[0049]

s3:对s2采集的数据集进行深度学习处理,得到现实场景和在现实场景下智能体采取的动作;

[0050]

s4:根据s3处理的结果,将现实场景和在现实场景下智能体采取的动作保存至终端;

[0051]

s5:智能体采集实时运行场景,并将实时运行场景转换为数据发送至终端;终端将实时运行场景与终端保存的现实场景进行对比,当达到预设相似度值后,终端选取最优处理措施指导智能体进行路径规划和避障。

[0052]

在其中一个实施例中,s3具体包括以下步骤:

[0053]

s3.1:初始化存放自动驾驶智能体所采集数据的容器,以及初始化该容器的大小;确定该容器可容纳的数据条数n;

[0054]

s3.2:初始化q函数,并根据智能体采集到的数据对q函数进行更新,得到最高评分状态下的q函数;

[0055]

s3.3:利用最高评分状态下的q函数对显示场景进行处理,并将处理后得出的动作;

[0056]

s3.4:将现实场景和s3.3得到的动作存储至终端。

[0057]

在其中一个实施例中,s3.2包括以下步骤:

[0058]

s3.2.1:设φ

t

为智能体采集到的第t个数据,r

t

为第t个分数;令t=1;

[0059]

其中,r1为初始分数值,根据工程经验进行人为设置;

[0060]

s3.2.2:将φ

t

和r

t

输入q函数,得到一个q值;

[0061]

s3.2.3:按以下两种方式之一选择一个动作;

[0062]

(1)任意选择一个动作;(2)根据q值选择一个动作;

[0063]

s3.2.4:s3.4:智能体开始在仿真器中执行s3.3中所选择的操作;得到分数r

t+1

,并根据q函数的损失函数来更新θ;

[0064]

s3.2.5:判断t>n是否成立,若成立则结束操作,并输出评分最高状态下的θ,然后

利用更新后的θ对q函数进行更新;

[0065]

若不成立,则将得到的r

t+1

、更新后的θ、φ

t+1

存储至容器,且令t=t+1,并返回s3.2.2。

[0066]

在其中一个实施例中,s3.2.3中选择动作的方法具体为:

[0067]

构建动作函数;

[0068]

以任意选择一个动作的概率为ε,根据q值选择一个动作的概率为1

‑

ε,

[0069]

如果没有发生根据q值选择一个动作的情况,则选择当前动作函数值最大的动作。

[0070]

在其中一个实施例中,如果没有发生根据q值选择一个动作的情况,则根据贪婪策略选择当前选择动作函数值最大的动作。

[0071]

在其中一个实施例中,动作函数为:a

t

=argmaxq(s,a,θ)

[0072]

其中,q(s,a,θ)为q函数。

[0073]

在其中一个实施例中,q函数的损失函数为:

[0074]

δθ=e[(r

t

+γmaxq(s',a',θ)

‑

q(s,a,θ)]

[0075]

其中,γ为衰减因子,γ∈(0,1),q(s',a',θ)为q(s,a,θ)的倒数,e[

·

]表示求均值。

[0076]

在其中一个实施例中,及更新θ的公式为:θ=θ+δθ。

[0077]

在其中一个实施例中,s5中终端通过融合a

‑

star算法(全局路径规划算法)和teb算法(局部路径规划算法)选取最优处理措施指导智能体进行路径规划和避障。

[0078]

在其中一个实施例中,通过融合a

‑

star算法和teb算法选取最优处理措施指导智能体进行路径规划和避障的具体操作为:

[0079]

首先通过全局路径规划算法进行路线规划,在智能体行驶的过程中判断是否遇到动态路障,若没有遇到路障则按规划的路线进行行驶,若遇到路障,则通过局部路径规划算法进行避障,在避障过程中根据s3所处理得出的动作进行避障。

[0080]

附图中描述位置关系的用语仅用于示例性说明,不能理解为对本专利的限制;

[0081]

显然,本发明的上述实施例仅仅是为清楚地说明本发明所作的举例,而并非是对本发明的实施方式的限定。对于所属领域的普通技术人员来说,在上述说明的基础上还可以做出其它不同形式的变化或变动。这里无需也无法对所有的实施方式予以穷举。凡在本发明的精神和原则之内所作的任何修改、等同替换和改进等,均应包含在本发明权利要求的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1