一种基于强化学习的农林用车辆的导航控制方法

1.本发明涉及农林用车辆导航技术领域,具体为一种基于强化学习的农林用车辆的导航控制方法。

背景技术:

2.随着导航定位技术、传感器技术的发展,车辆的路径跟踪技术也得到了快速发展。目前,路径跟踪控制算法主要有:传统pid算法、模糊控制算法、滑模控制法、纯跟踪控制法等。传统pid算法不依赖于精确的数学模型,应用广泛,但其自适应能力较差,控制参数的调整较为困难,需要一定经验和大量实验。模糊控制算法同样不需要建立车辆模型,但需要专家的经验制定规则库,且数据稳定性差,易随着运动环境的变化而变化。滑模控制法抗干扰能力强,响应快,但其缺点是容易发生抖振现象。导航定位技术对路径跟踪也极为重要,近些年,gnss、激光雷达、机器视觉和多传感器融合技术被广泛应用于环境感知定位领域。

3.农林业环境比较复杂,路面不平整、不规则、泥泞易滑,会导致车轮打滑、偏移,与参考路径形成较大的距离误差。因此,使农机能够准确地进行路径跟踪相对较难。专利号cn110007667b公开了一种履带拖拉机及其路径跟踪控制方法和系统的专利,通过定位系统得到拖拉机的位置偏差和移动速度,利用主驱动轮的半径及转速测出拖拉机的理论速度,同时结合履带的滑移率得到拖拉机的航向变化率表达式,根据航向变化率表达式和采样周期计算出航向变化预估值,进而控制拖拉机的舵机角度,使拖拉机跟踪期望路径。专利号cn105867377b公开了一种农业机械自动导航控制方法的专利,通过 gps测得农业机械当前的运动状态,与预定义路径数据对比,计算出横向偏差与航向偏差,综合模糊控制算法和改进型纯跟踪算法得出前轮转角,实现路径跟踪。但是这两件专利的路径跟踪控制算法主要存在以下问题:依赖于精确的车辆模型或环境模型,使得控制系统的设计更加困难;需要大量的试验及专业的经验,不能适时地随环境的改变调整控制参数;自适应性和自学能力不强。

技术实现要素:

[0004][0005]

本发明的目的在于提供一种基于强化学习的农林用车辆的导航控制方法,以解决上述背景技术中提出的问题。

[0006]

为实现上述目的,本发明提供如下技术方案:一种基于强化学习的农林用车辆的导航控制方法,包括如下步骤:

[0007]

1)将车辆的路径跟踪系统描述成马尔科夫决策过程(mdp);

[0008]

2)建立状态空间及动作空间;

[0009]

3)以神经网络的q-learning算法作为车辆的路径跟踪及避障控制器,通过对控制器进行示教训练,实现车辆的精准路径跟踪。

[0010]

进一步优选,所述建立状态空间的步骤如下:

[0011]

a1)通过gnss获取车辆的位置坐标及航向信息;

[0012]

a2)将参考路径等间隔的分成n段,在每两段的节点处取点,获取参考路径上距离车辆最近点的坐标和该点的切线方向,计算车辆与参考路径的距离误差e

dt

和航向误差e

θt

;

[0013]

a3)将上一个状态的车辆与参考路径的距离误差e

dt-1

加入进状态空间;

[0014]

a4)探测车辆前方是否有障碍物,并计算出车辆与障碍物之间的距离d

t

,则t时刻的状态空间表示为:s

t

=[e

dt

,e

θt

,e

dt-1

,d

t

]。

[0015]

进一步优选,所述建立动作空间的步骤如下:

[0016]

b1)将车辆的速度设置成固定值;

[0017]

b2)将车辆的转角设置在[-30,30]度之间,且转角取整数,则动作空间表示为:a

t

=[e

t

]。

[0018]

进一步优选,所述控制器的示教训练过程如下:

[0019]

c1)初始化神经网络的参数,即q值;

[0020]

c2)将车辆置于初始状态s,判断车辆是否到达最终状态;

[0021]

c3)若未达到,则执行以下步骤:将当前状态信息输入神经网络,计算得到相应的q值,选取最大q值对应的动作a,根据选定的动作a,得到下一个状态s’以及一个奖励值;

[0022]

c4)重复上述训练过程c1)、c2)和c3),通过对环境进行探索,并得到相应的奖励值,不断更新神经网络的权值,实现车辆进行路径跟踪。

[0023]

进一步优选,根据所述奖励值建立奖励函数,将奖励函数设置成分段形式。

[0024]

进一步优选,对所述奖励函数设置一个阈值,当车辆与参考路径的距离误差e

dt

小于阈值,则为正奖励;当车辆与参考路径的距离误差e

dt

大于阈值,则为负奖励。

[0025]

进一步优选,所述航向误差e

θt

的奖励值的确定方法,包含如下步骤:

[0026]

d1)确定农林用车辆相对于参考路径的位置;

[0027]

d2)当不存在距离误差e

dt

时,则航向误差e

θt

越小,奖励越高;

[0028]

d3)当存在距离误差e

dt

,同时存在航向误差e

θt

,但航向误差e

θt

致使车辆朝着参考路径靠近,则给其一个正奖励;

[0029]

d4)当航向误差e

θt

致使车辆愈加远离参考路径,则应给其一个负奖励,以使车辆及时调整车轮转角,向参考路径的方向行进;

[0030]

d5)当车辆撞上障碍物时,应给其一个负奖励,以避免车辆再次碰撞车辆。

[0031]

进一步优选,所述车辆上安装有激光雷达,所述控制器为rl控制器。

[0032]

有益效果:本发明的基于强化学习的农林用车辆的导航控制方法,将强化学习应用到车辆的路径跟踪控制中,将车辆路径跟踪建模成马尔科夫决策过程,无需建立精确的车辆运动模型,通过对控制器进行示教训练,实现车辆的精准路径跟踪,避免车辆与障碍物的碰撞,自适应性和自学能力强;可减少车辆在农林业环境中由于路面泥泞打滑,不平整等因素造成的路径跟踪误差,提高路径跟踪的精确度;此设计较为简单,避免了精准车辆模型的建立及大量的人工参数整定工作,可行性强。

附图说明

[0033]

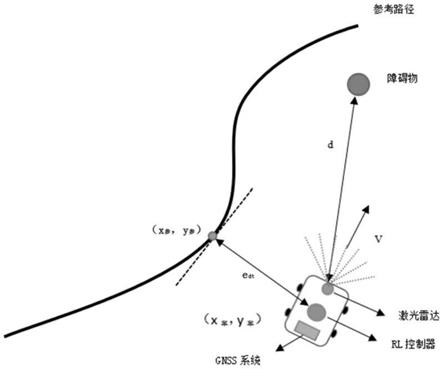

图1为农林用车辆的导航控制方法示意图;

[0034]

图2为仿真示教训练示意图;

[0035]

图3为实地示教训练及路径跟踪控制示意图;

[0036]

图4为农林用车辆轨迹跟踪控制框图。

具体实施方式

[0037]

以下是本发明的具体实施例并结合附图,对本发明的技术方案作进一步的描述,但本发明并不限于这些实施例。

[0038]

如图1-4所示,一种基于强化学习的农林用车辆的导航控制方法,包括如下步骤:

[0039]

1)将车辆的路径跟踪系统描述成马尔科夫决策过程(mdp);

[0040]

2)建立状态空间:

[0041]

a1)通过gnss获取车辆的位置坐标及航向信息;

[0042]

a2)将参考路径等间隔的分成n段,在每两段的节点处取点,获取参考路径上距离车辆最近点的坐标和该点的切线方向,计算车辆与参考路径的距离误差e

dt

和航向误差e

θt

;

[0043]

a3)将上一个状态的车辆与参考路径的距离误差e

dt-1

加入进状态空间,通过比较当前状态与上一个状态的距离误差,判断车辆是否向着误差减小的方向行进,以提高跟踪效果;

[0044]

a4)在车辆前方安装激光雷达,探测车辆前方是否有障碍物,并计算出车辆与障碍物之间的距离d

t

,则t时刻的状态空间表示为:s

t

=[e

dt

,e

θt

,e

dt-1

, d

t

];

[0045]

建立动作空间:

[0046]

b1)将车辆的速度设置成固定值;

[0047]

b2)因为动作空间只有车辆的车轮转角一个动作值,考虑过大转角容易造成车辆不平稳、发生侧翻等危险,因此将车辆的转角设置在[-30,30]度之间,且转角只取整数,则动作空间表示为:a

t

=[e

t

];

[0048]

3)以神经网络的q-learning算法作为控制器,通过对控制器进行示教训练,实现车辆的精准路径跟踪,控制器的示教训练过程如下:

[0049]

c1)初始化神经网络的参数,即q值;

[0050]

c2)将车辆置于初始状态s,判断车辆是否到达最终状态;

[0051]

c3)若未达到,则执行以下步骤:将当前状态信息输入神经网络,计算得到相应的q值,选取最大q值对应的动作a,根据选定的动作a,得到下一个状态s’以及一个奖励值;

[0052]

c4)重复上述训练过程c1)、c2)和c3),通过对环境进行探索,并得到相应的奖励值,不断更新神经网络的权值,实现车辆进行路径跟踪;

[0053]

本技术中,根据奖励值建立奖励函数,将奖励函数设置成分段形式,车辆与参考路径的距离误差e

dt

越小,则奖励越高。对奖励函数设置一个阈值,当车辆与参考路径的距离误差e

dt

小于阈值,则为正奖励;当车辆与参考路径的距离误差e

dt

大于阈值,则为负奖励。对航向误差e

θt

的奖励值需进行确定,其确定方法包含如下步骤:

[0054]

d1)确定农林用车辆相对于参考路径的位置;

[0055]

d2)当不存在距离误差e

dt

时,则航向误差e

θt

越小,奖励越高;

[0056]

d3)当存在距离误差e

dt

,同时存在航向误差e

θt

,但航向误差e

θt

致使车辆朝着参考路径靠近,则给其一个正奖励;

[0057]

d4)当航向误差e

θt

致使车辆愈加远离参考路径,则应给其一个大的负奖励,以使车

辆及时调整车轮转角,向参考路径的方向行进;

[0058]

d5)当车辆撞上障碍物时,应给其一个更大的负奖励,以避免车辆再次碰撞车辆。

[0059]

本技术中,该导航控制方法将强化学习应用到车辆的路径跟踪控制中,将车辆路径跟踪建模成马尔科夫决策过程,不需要建立精确的车辆运动模型,无需大量的人工参数整定工作。强化学习作为一种自适应最优控制方法,且具有一定的自学习能力,能够更好的适应复杂的农林业环境。在设计状态空间时加入了上一个状态时的距离误差e

dt

,可借此判断车辆是否朝着误差减小的方向行进,并通过奖励使车辆快速向参考路径靠近。在奖励函数的设计过程中,特别地对航向误差e

θt

进行判断,对不同情况下的航向误差e

θt

给出了不同的奖励值,采用传感器测量障碍物与车辆之间的距离,并将该距离加入状态空间;同时设置一个阈值,使车辆与障碍物间的距离始终大于该阈值,避免车辆与障碍物相撞。当障碍物与参考路径间距较小时,靠近路径与远离障碍物两个要求会发生冲突,此时,与障碍物保持适当距离应更为重要,通过设置不同的奖励值可对其实现有效控制。

[0060]

本技术中,该导航控制方法主要通过车辆、激光雷达、gnss系统、控制器实现,其中,控制器为rl控制器,为该导航控制的核心,该控制器对输入的各种状态信息进行分析,输出相应的动作,控制车辆运动;gnss系统对车辆进行定位,获取车辆的位置信息及航向信息,与已经规划好的参考路径的信息结合,作为控制器的输入;激光雷达采用思岚a1二维激光传感器,获取周围环境障碍物信息及车辆与障碍物之间的距离,为车辆避障提供依据。假设车辆位于农林业环境中,车上搭载的gnss测得车辆的坐标及航向,与参考路径最近点的坐标及该点切线方向比较,计算出航向误差e

θt

及距离误差e

dt

,同时激光雷达不断对周围环境进行扫描检测,判断有无障碍物及其与车辆间的距离,gnss前后测得的航向误差e

θt

、距离误差e

dt

一起组成状态空间,作为控制器的输入,控制器输出动作指令,经由车轮转向执行器控制车轮转向至合适角度,以实现精确的路径跟踪,避免车辆与障碍物的碰撞。

[0061]

最后应说明的是:以上所述仅为本发明的优选实施例而已,并不用于限制本发明,尽管参照前述实施例对本发明进行了详细的说明,对于本领域的技术人员来说,其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换。凡在本发明的精神和原则之内,所作的任何修改、等同替换、改进等,均应包含在本发明性的保护范围之内的发明内容。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1