一种动态障碍物环境下无人机无风险协同航迹规划方法与流程

1.本技术涉及无人机航迹规划和协同控制领域,具体是指一种动态障碍物环境下无人机无风险协同航迹规划方法。

背景技术:

2.近年来,无人机自主控制技术发展迅速,成为航空航天领域的热点研究问题。无人机具有高灵活性和高可控性等优点,被广泛的应用于多种任务场景中。在军事领域中,无人机在侦察、打击以及通信干扰等场景中得到深入的发展,大大提高了国防能力。在民用领域中,无人机的身影也广泛的出现在消防救援、航空摄影等场景中。无人机控制技术的提高有助于充分发挥无人机自身的优势特性,对于无人机技术的研究有着充分的意义。

3.无人机协同航迹规划是无人机自主控制领域的核心技术之一。优良的航迹规划系统是无人机完成任务的重要保障,其可以确保无人机在目标区域活动,减少无人机的各项损耗,进而完成其他任务需求。多无人机协作执行任务可以充分的提高任务完成效率,可以满足特殊任务需求。无人机协同航迹规划问题与其它学科技术的研究紧密相关,十分具备研究意义。

4.无人机协同航迹规划问题主要包含航迹搜索和协同控制两方面内容。传统航迹规划算法对于环境信息的依赖度高,无法满足未知环境下的任务场景,并且已有算法不同时具备全局航迹规划能力和局部航迹规划能力,缺乏环境自适应能力,可用性不强,因此应该对具有环境自适应能力的无风险无人机协同航迹规划算法进行研究。

5.申请内容

6.基于以上技术问题,本技术提供了一种动态障碍物环境下无人机无风险协同航迹规划方法,本技术解决了经典q-learning方法训练成本大、所规划航迹风险高,缺乏动态避障能力的问题。

7.为解决以上技术问题,本技术采用的技术方案如下:

8.一种动态障碍物环境下无人机无风险协同航迹规划方法,包括如下步骤:

9.s1、建立q-learning算法训练空间;

10.s2、改进q-learning算法的反馈策略,为无人机的训练过程中加入引导信息和风险意识;

11.s3、结合动态窗口算法为航迹规划系统增加局部航迹规划能力,获取动态环境下自适应能力;

12.s4、基于reynolds蜂拥模型,设计无人机集群航迹调整规则,实现多无人机无风险协同航迹规划。

13.进一步的,步骤s1中的q-learning算法训练空间包括无人机的起点位置、终点坐标、静态障碍物以及地图边界。

14.进一步的,步骤s2的具体步骤包括:

15.s21、在算法训练过程中,改进环境奖励反馈,以无人机与目标点的实时距离作为

过程奖励;

16.s22、在无人机通过交互行为获取环境信息的过程中,将获得过惩罚值的位置点标记为风险区域;

17.s23、重复步骤s21~步骤s22,完成无人机的无风险航迹计算。

18.进一步的,步骤s3的具体步骤为:

19.s31、获取离散全局航迹节点;

20.s32、将离散航迹节点设置为区域节点,作为动态窗口算法的目标终点;

21.s33、在无人机的速度和角速度组成的二维空间中采样,计算时间步长内对应航迹;

22.s34、航迹评估,获取最优航迹;

23.s35、重复步骤s31~步骤s34,更新区域节点,直至无人机到达全图目标位置。

24.进一步的,步骤s4的具体步骤为:

25.s41、获取在所规划航迹上无人机的实时位置、速度与加速度;

26.s42、将s41步骤中获取的信息作为reynolds蜂拥模型的虚拟领航者信息;

27.s43、根据斥力排斥规则,调整无人机集群个体的加速度,驱动集群与障碍物保持安全距离;

28.s44、重复步骤s41~步骤s43,直至集群到达全局目标位置。

29.与现有技术相比,本技术的有益效果是:

30.(1)本发明对于q-learning算法的反馈策略进行了调整,加入了先验信息,以无人机位置与目标位置的实时距离做参考,设计奖励反馈函数。在无人机的训练过程中,加入了风险信息的获取,对于受过惩罚反馈的位置坐标标记为风险位置,从中获取二次反馈惩罚。解决了无人机训练前期的盲目探索问题,减少了算法训练量,并且航迹点与障碍物保持安全距离,保证无人机安全性。

31.(2)本发明对动态窗口算法进行应用,增加航迹规划系统的局部航迹规划能力。由于q-learning算法仅具备全局航迹规划能力,并且在环境发生改变时需要付出额外训练成本适应环境变化,因此对于算法的环境自适应能力提出了一定要求。本发明应用动态窗口算法,可以对航迹进行局部的动态调整,保证航迹的可用性。

32.(3)本发明针对航迹规划算法多应用于单无人机问题,结合reynolds蜂拥模型设计协同规则,将单机航迹规划问题扩展至多机协同航迹规划问题,增加了算法的可用性。由于无人机集群规模的提升,随之增大的集群半径会为无人机带来较大的飞行风险,因此本发明设计了排斥规则调整无人机的加速度,保证集群个体与障碍物保持安全距离,降低飞行风险。

附图说明

33.此处所说明的附图用来提供对本技术的进一步理解,构成本技术的一部分,本技术的示意性实施例及其说明用于解释本技术,并不构成对本技术的不当限定。其中:

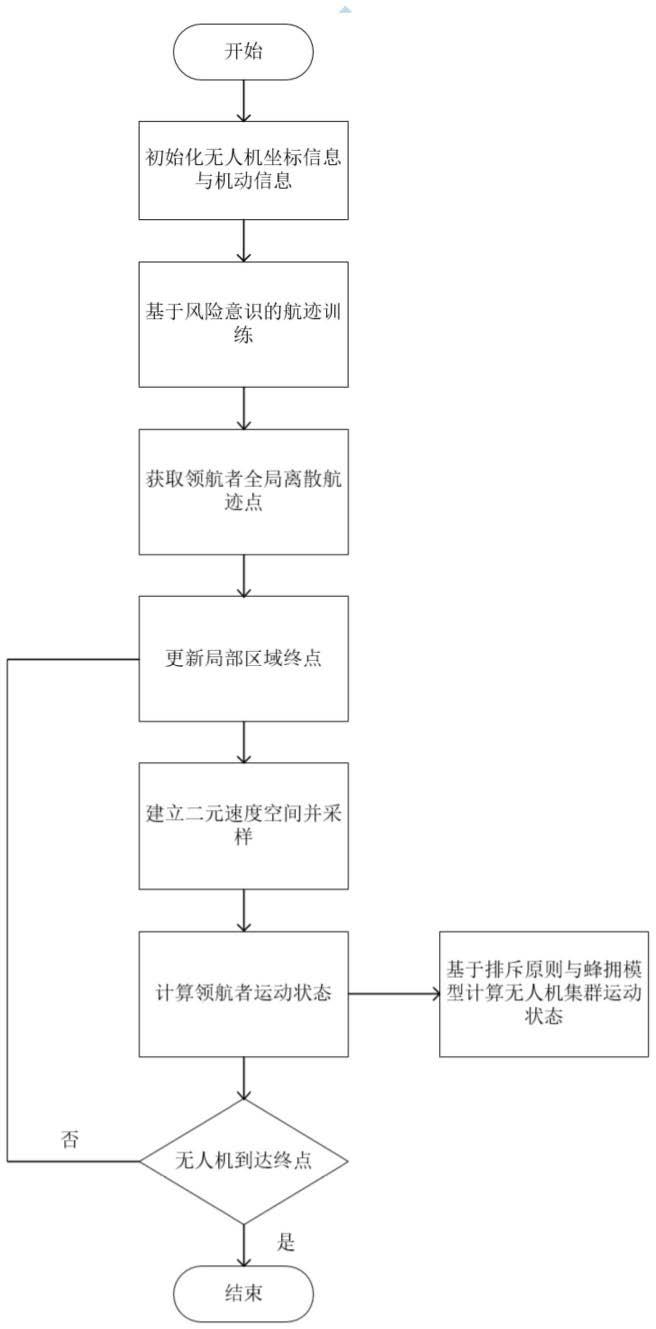

34.图1为动态障碍物环境下无人机无风险协同航迹规划方法的步骤流程图。

35.图2为经典q-learning(standard q-learning,sql)算法的航迹结果图。

36.图3为无风险q-learning(risk-free q-learning,rfql)算法的航迹结果图。

37.图4为性能指标为rfql算法仿真结果的训练次数-反馈值关系图。

38.图5为性能指标为rfql算法仿真结果的训练次数-迭代步长关系图。

39.图6为动态窗口算法的航迹结果图。

40.图7为静态环境下动态窗口算法融合rfql算法的航迹结果图。

41.图8为动态环境下动态窗口算法融合rfql算法的航迹结果图。

42.图9为静态环境下自适应无风险协同(coordinated adaptive risk-free q-learning,carfql)算法航迹计算结果图,排斥因子β设置为0。

43.图10为动态环境下自适应无风险协同(coordinated adaptive risk-free q-learning,carfql)算法航迹计算结果图,排斥因子β设置为0。

44.图11为动态环境下自适应无风险协同(coordinated adaptive risk-free q-learning,carfql)算法航迹计算结果图,排斥因子β设置为0.5。

具体实施方式

45.为使本公开实施例的目的、技术方案和优点更加清楚,下面将结合本公开实施例的附图,对本公开实施例的技术方案进行清楚、完整地描述。显然,所描述的实施例是本公开的一部分实施例,而不是全部的实施例。基于所描述的本公开的实施例,本领域普通技术人员在无需创造性劳动的前提下所获得的所有其他实施例,都属于本公开保护的范围。

46.应当理解,本说明书中所使用的“系统”、“装置”、“单元”和/或“模组”是用于区分不同级别的不同组件、元件、部件、部分或装配的一种方法。然而,如果其他词语可实现相同的目的,则可通过其他表达来替换所述词语。

47.如本说明书和权利要求书中所示,除非上下文明确提示例外情形,“一”、“一个”、“一种”和/或“该”等词并非特指单数,也可包括复数。一般说来,术语“包括”与“包含”仅提示包括已明确标识的步骤和元素,而这些步骤和元素不构成一个排它性的罗列,方法或者设备也可能包含其它的步骤或元素。

48.本说明书中使用了流程图用来说明根据本说明书的实施例的系统所执行的操作。应当理解的是,前面或后面操作不一定按照顺序来精确地执行。相反,可以按照倒序或同时处理各个步骤。同时,也可以将其他操作添加到这些过程中,或从这些过程移除某一步或数步操作。

49.参阅图1,在一些实施例中,一种动态障碍物环境下无人机无风险协同航迹规划方法,假设无人机的飞行空间为二维平面,在个体速度、角速度等机动性能和环境约束下,进行无人机协同航迹规划。包括如下步骤:

50.s1、建立q-learning算法训练空间;

51.s2、改进q-learning算法的反馈策略,为无人机的训练过程中加入引导信息和风险意识;

52.s3、结合动态窗口算法为航迹规划系统增加局部航迹规划能力,获取动态环境下自适应能力。

53.s4、基于reynolds蜂拥模型,设计无人机集群航迹调整规则,实现多无人机无风险协同航迹规划;

54.优选的,步骤s1中的q-learning算法训练空间包括无人机的起点位置、终点坐标、

静态障碍物以及地图边界。

55.优选的,步骤s2的具体步骤包括:

56.s21、在算法训练过程中,改进环境奖励反馈,以无人机与目标点的实时距离作为过程奖励;

57.s22、在无人机通过交互行为获取环境信息的过程中,将获得过惩罚值的位置点标记为风险区域;

58.s23、重复步骤s21~步骤s22,完成无人机的无风险航迹计算。

59.优选的,步骤s3的具体步骤为:

60.s31、获取离散全局航迹节点;

61.s32、将离散航迹节点设置为区域节点,作为动态窗口算法的目标终点;

62.s33、在无人机的速度和角速度组成的二维空间中采样,计算时间步长内对应航迹;

63.s34、航迹评估,获取最优航迹;

64.s35、重复步骤s31~步骤s34,更新区域节点,直至无人机到达全图目标位置。

65.优选的,步骤s4的具体步骤为:

66.s41、获取在所规划航迹上无人机的实时位置、速度与加速度;

67.s42、将s41步骤中获取的信息作为reynolds蜂拥模型的虚拟领航者信息;

68.s43、根据斥力排斥规则,调整无人机集群个体的加速度,驱动集群与障碍物保持安全距离;

69.s44、重复步骤s41~步骤s43,直至集群到达全局目标位置。

70.本实施例中,如图1所示,为本发明动态障碍物环境下无人机无风险协同航迹规划方法的流程图,包括如下步骤:

71.s1、建立q-learning算法训练空间。

72.由于q-learning算法基于马尔科夫思想进行状态转移,所以其适用于离散的地图空间与动作空间。因此本发明基于栅格法建立环境地图,地图大小为20*30。包含起始点位置、终点位置、障碍物位置和环境边界。

73.s2、改进q-learning算法的反馈策略,为无人机的训练过程中加入引导信息和风险意识。

74.经典q-learning算法的训练计算量大,所需内存空间高,尤其在无人机地图空间中会拥有盲目探索和无效探索问题,并且其规划航迹风险高,没有考虑无人机的飞行安全性,因此对其反馈策略进行改进。

75.1)启发式反馈

76.将已知的起点位置和终点位置作为先验信息,加入q-learning算法的反馈函数中,避免训练前期的盲目探索情况,使无人机的训练范围更集中在航迹区域附近。改进的反馈函数如下。

77.其他

78.其中r

t

为无人机在t时刻所获取的环境反馈。x

t

和y

t

为无人机的坐标位置。定义x

tar

和y

tar

为目标终点坐标。s

t+1

为t+1时刻无人机所处的环境状态。

79.2)风险意识

80.无人机的实际飞行过程中应考虑与障碍物保证一定的安全距离,因此将曾获取过惩罚反馈的环境状态标记为风险位置,并设计风险反馈函数,计算无人机做出动作后获取的风险反馈。

[0081][0082]

其中r

ris

为无人机获取的风险反馈,λ为风险系数,系数越大越有利于保证无人机飞行安全。

[0083]

3)值函数

[0084]

经典q-learning算法的值函数如下所示。

[0085]

q(s

t

,a

t

)=q(s

t

,a

t

)+α[r+γ*maxq(s

t+1

,a

t+1

)-q(s

t

,a

t

)]

[0086]

其中q(s

t

,a

t

)表示在t时刻的环境状态s

t

下做出动作a

t

后对应的q值,q值可以衡量当前决策的正确性。α为学习率,其余算法的收敛速度成正比,与航迹最优概率成反比。γ为折扣因子,值越小,代表未来的反馈信息越重要,r为做出动作后从环境中获取到的反馈值。改进后的q-learning算法的反馈值为:

[0087]

r=r

ris

+r

t

[0088]

因此,具有风险意识的q-learning算法的值函数可表示为:

[0089]

q(s

t

,a

t

)=q(s

t

,a

t

)+α[r

ris

+r

t

+γ*maxq(s

t+1

,a

t+1

)-q(s

t

,a

t

)]

[0090]

s3、结合了动态窗口算法,为航迹规划系统增加局部航迹规划能力,获取动态环境下自适应能力。

[0091]

经过s2步骤中后可以得到全局离散航迹节点,通过离散航迹点可以将地图空间划分为若干子区域,

[0092]

节点可作为该区域的局部目标终点,此时利用动态窗口算法可以得到局部连续航迹。由于动态窗口算法具备较好的动态航迹规划能力,因此可以使无人机具备较强的环境自适应能力,应对动态环境。

[0093]

根据无人机的飞行速度和角速度可以建立二元速度空间(v,ω),该二元空间需要根据无人机机动特性进行约束:

[0094]vm

={(v,ω)|v

min

≤v≤v

max

,ω

min

≤ω≤ω

max

}

[0095]vm

表示对于速度范围约束。v

min

与v

max

分别表示最小和最大飞行速度。ω

min

和ω

max

分别表示无人机最小和最大转向速度。考虑无人机加速度限制,再次根据加速度对速度空间进行限制:

[0096][0097]

其中vc和ωc分别表示无人机线速度和角速度,和分别表示无人机线速度和角速度的最大减速度,和分别表示无人机线速度和角速度的最大加速度。对于无人机的避障行为,其需要在发生碰撞前将速度减为0,因此需要当前无人机与障碍物的距离对速度空间进一步约束:

[0098][0099]

dis(v,ω)表示无人机距离障碍物的最短距离。最终生成的无人机二元速度空间v为:

[0100]

v=vm∩vd∩va[0101]

对速度空间(v,ω)进行采样后,根据如下函数可计算出无人机在时间间隔

△

t内的运动航迹。

[0102][0103]

x和y为无人机下一时刻飞行坐标,ψ是无人机当前的转向角。v和ω为所采样的飞行速度和角速度。不同的采样结果会产生不同的航迹段,需要对航迹进行评估得到最理想航迹。评估函数如下:

[0104]

h(v,ω)=α

·

ang(v,ω)+β

·

vel(v,ω)+γ

·

dis(v,ω)

[0105]

ang(v,ω)为角度评估得分,航迹方向与目标方向的角度偏差越小得分越高。vel(v,ω)代表速度评估得分,速度越快分数越高。dis(v,ω)定义为距离评估得分,保持与障碍物较大的距离可以得到较高的距离得分。

[0106]

s4.基于reynolds蜂拥模型,设计无人机集群航迹调整规则,实现多无人机无风险协同航迹规划。

[0107]

完成s2和s3步骤后,可以计算出单架无人机在目标航迹上的飞行状态。利用其飞行信息可以作为无人机集群的领航者,带领无人机协同飞行。无人机集群个体的控制可如下表示:

[0108][0109]

使用q(t)和p(t)分别表示无人机的位置向量和速度向量,和莨示第i架无人机的更新状态。ui(t)表示对第i架无人机的控制量,其包含分禹控制项、速度控制项以领航者控制项。

[0110]

1)di采用下式进行计算:

[0111][0112]

ni(t)表示i号无人机在t时刻感应范围内的无人机。||

·

||

σ

代表σ范数,用下式计算:

[0113][0114]

ε是范数常量。在上式中φ

σ

(z)代表势场函数,如下式计算:

[0115][0116]

r和d分别代表无人机最大感知距离和实际距离。r

σ

和d

σ

代表距离范数。上式的ph(z)与φ(z)可用下列函数计算:

[0117][0118][0119][0120]

h是平滑函数ph(z)的控制参数,较大的h值使无人机的分离动作更加迅速。a代表势场φ(z)的力度,较大的b值帮助无人机所受斥力快速增长,即拥有一定的势场敏感性。

[0121]

2)vi采用下列函数计算:

[0122][0123][0124]

3)li采用下列函数计算:

[0125]

li=c1(q

γ-qi)+c2(p

γ-pi)

[0126]

其中c1和c2分别无人机领航者对集群内个体的位置影响权重和速度影响权重,q

γ

和p

γ

分别代表领导者的位置和速度。综上可以得到最终的控制量ui(t)为:

[0127]

ui(t)=di+υi+li[0128]

通过控制量ui(t)可以得到无人机个体的运动情况,为进一步提高无人机协同安全性,采用排斥原则来进一步调整无人机的运动状态。

[0129]ai

=ai+βdi[0130]ai

为i号无人机的加速度,β为斥力因子,控制无人机对障碍物的排斥程度,di为无人机与障碍物的距离。

[0131]

最后可计算飞行风险ζ来衡量不同的β因子下集群的飞行安全程度。风险ζ计算式如下:

[0132][0133]rs

为无人机感知半径,n是无人机数量,n是区域内障碍物数量.rc定义为碰撞半径。总体来看,一个与无人机群相匹配的β因子可以有效地提高集群的抗风险能力。

[0134]

实施例:

[0135]

设置30

×

20的栅格地图模型,并在地图环境中设置静态障碍物以及动态出现的障碍物。考虑五架无人机在该环境中的航迹规划问题,并通过仿真实验进行算法对比分析,得到图2~11的实验结果图:

[0136]

s1、建立q-learning算法训练空间;

[0137]

s2、改进q-learning算法的反馈策略,为无人机的训练过程中加入引导信息和风险意识;

[0138]

s3、结合动态窗口算法为航迹规划系统增加局部航迹规划能力,获取动态环境下自适应能力;

[0139]

s4、基于reynolds蜂拥模型,设计无人机集群航迹调整规则,实现多无人机无风险协同航迹规划。

[0140]

其中,图2~3为q-learning算法改进前后的航迹结果图,图4~5为rfql算法的性能指标计算结果,图6为动态窗口算法航迹结果图,图7~8为两种环境下融合rfql算法与动态窗口算法的航迹结果图。图9~10为carfql算法两种环境下,在排斥因子β设置为0时的不同航迹结果图。图11为动态环境下排斥因子β设置为0.5时carfql算法的航迹结果图。

[0141]

仿真结果表明,rfql算法相对经典q-learning算法具有更好的收敛效果和低风险性。carfql算法不仅可以在静态障碍环境下进行协同避障,在动态环境中也可以计算出理想的航迹效果。不同的排斥因子β下的无人机避碰距离有所不同,在实际应用中,与无人机特性相匹配的β因子可以保证无人机具有很强的低风险飞行能力。

[0142]

本发明说明书中未作详细描述的内容属本领域技术人员的公知技术。

[0143]

如上即为本技术的实施例。上述实施例以及实施例中的具体参数仅是为了清楚表述申请的验证过程,并非用以限制本技术的专利保护范围,本技术的专利保护范围仍然以其权利要求书为准,凡是运用本技术的说明书及附图内容所作的等同结构变化,同理均应包含在本技术的保护范围内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1