一种巡飞弹的饱和攻击方法、装置及存储介质

本发明涉及一种巡飞弹的饱和攻击方法、装置及存储介质,属于巡飞弹。

背景技术:

1、当下,日益复杂的作战任务与战场环境决定了巡飞弹系统必须具备很高的自主性。“自主性”要求系统要在极其不确定的条件下,能够完全排除外界干扰,即使在没有通信或通信不畅的情况下,仍能弥补系统故障所带来的问题,并确保系统长时间良好运行。为实现自主性,系统需要能够针对态势做出基于决策的响应。而机动决策作为自主决策的基础,可以根据当前态势自主选择机动行为,实现避险或迎敌,从而完成任务。目前基于群体智能算法的巡飞弹机动决策方法已取得较大进展,如粒子群算法,狼群算法,和蚁群算法等,但是这些方法有着计算时间长、灵活性不足、智能化程度低的缺点,无法很好满足巡飞弹集群对于无中心化、自主化、自治化的要求。

2、但因战场的复杂多变,巡飞弹集群的饱和攻击场景往往面临通信拒止环境,且需要面对由高射炮(anti-aircraft artilleries,aaa)、地对空导弹(surface-to-air,sam)、探测/跟踪雷达(detection/tracking radars)在内的防御诸要素所组成的敌网络化防空体系。因此,巡飞弹集群实施自主饱和攻击面临以下问题:

3、1)局部的感知能力。机载传感器观测范围有限,单架巡飞弹仅能观测到有限的态势信息。2)有限的通信网络带宽。巡飞弹与地面指控台站基本无法通信,且巡飞弹有限地访问集群内部网络。3)复杂的机动环境。将敌网络化防空体系表示为禁飞区(no-fly-zones,nfzs),巡飞弹集群的战略打击目标受其拱卫。

技术实现思路

1、本发明的目的在于克服现有技术中的不足,提供一种巡飞弹的饱和攻击方法、装置及存储介质,解决了战场通信带宽受限环境中的巡飞弹集群自主饱和攻击问题,训练后的巡飞弹能够在少量通信的条件下有效地执行自杀式饱和攻击任务。

2、为达到上述目的,本发明是采用下述技术方案实现的:

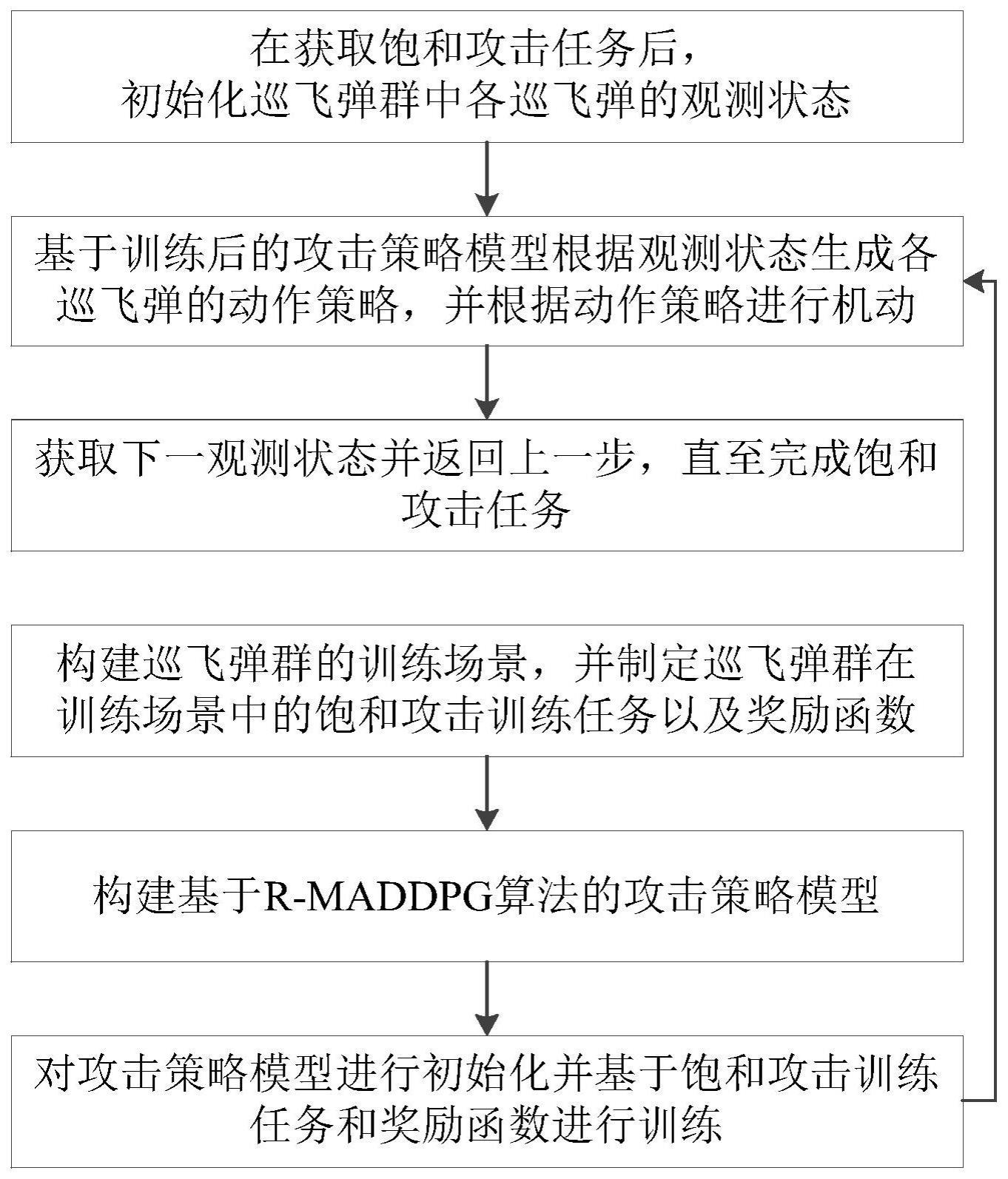

3、第一方面,本发明提供了一种巡飞弹的饱和攻击方法,包括:

4、在获取饱和攻击任务后,初始化巡飞弹群中各巡飞弹的观测状态;

5、基于训练后的攻击策略模型根据观测状态生成各巡飞弹的动作策略,并根据动作策略进行机动;

6、获取下一观测状态并返回上一步,直至完成饱和攻击任务;

7、其中,所述攻击策略模型的训练包括:

8、构建巡飞弹群的训练场景,并制定巡飞弹群在训练场景中的饱和攻击训练任务以及奖励函数;

9、构建基于r-maddpg算法的攻击策略模型;

10、对攻击策略模型进行初始化并基于饱和攻击训练任务和奖励函数进行训练。

11、可选的,所述饱和攻击训练任务为在训练场景中设置攻击目标、巡飞弹群以及禁飞区,巡飞弹群中每个巡飞弹起始位置飞行至攻击目标位置,同时避免进入禁飞区或触碰其他巡飞弹。

12、可选的,所述奖励函数r为:

13、r=rdist+rdiff

14、式中,rdist=knfzrnfz+kstprstp+ktrt+kcarca;

15、rnfz、rstp、rt、rca分别为未进入禁飞区、仿真步数限制、到达攻击目标位置、未触碰其他巡飞弹的奖励;knfz、kstp、kt、kca分别为未进入禁飞区、仿真步数限制、到达攻击目标位置、未触碰其他巡飞弹的奖励的权重系数;

16、

17、rsa、分别为同时攻击的实际奖励和估计奖励;ksa、分别为同时攻击的实际奖励和估计奖励的权重系数;

18、

19、

20、

21、

22、

23、

24、式中,d、rnfz分别为巡飞弹距离禁飞区中心的距离以及禁飞区的半径,nstp、分别为巡飞弹每个回合的仿真步数和仿真步数最大阈值,dit为巡飞弹距离攻击目标位置的距离,dij、dsafe分别为巡飞弹i、j的间距和巡飞弹的安全间距,tgap是攻击目标位置的防空间隙,δtmax为巡飞弹群中巡飞弹的最大攻击时间误差,为巡飞弹在每个仿真步数上最大的估计攻击时间误差,rt为攻击目标的半径。

25、可选的,所述对攻击策略模型进行初始化并基于饱和攻击训练任务和奖励函数进行训练包括:

26、初始化攻击策略模型,包括对攻击策略模型的策略网络和价值网络;

27、通过在训练场景中基于策略网络执行饱和攻击训练任务构建各巡飞弹的经验池;

28、从各巡飞弹的经验池中随机抽取同一仿真步数的数据组成状态转移数据集,基于状态转移数据集更新策略网络和价值网络的权重参数;

29、将更新后的攻击策略模型替换初始化攻击策略模型带入上述步骤进行迭代,直至达到预设的最大迭代次数。

30、可选的,所述策略网络和价值网络的结构相同,均包括依次连接的输入层、隐藏层以及输出层,所述输入层包括64个一一对应连接的全连接层和relu层,所述隐藏层包括64个lstm神经元。

31、可选的,所述构建各巡飞弹的经验池包括:

32、对于每个巡飞弹,获取巡飞弹i在仿真步数t的观测状态oi(t);

33、基于策略网络根据观测状态oi(t)生成动作策略ai(t);

34、根据动作策略ai(t)驱动巡飞弹i在训练场景中机动并获取其在仿真步数t+1的观测状态oi(t+1);

35、根据奖励函数获取动作策略ai(t)的奖励值ri(t);

36、将观测状态oi(t)、观测状态oi(t+1)、动作策略ai(t)、奖励值ri(t)以及策略网络的lstm神经元在巡飞弹i机动前后的控制参数保存为经验数组,记为<oi(t)、oi(t+1)、ai(t)、ri(t)、>;

37、将经验数组存入预构建的经验池中,并重复上述步骤直至经验池中经验数组达到预设数量。

38、可选的,所述基于状态转移数据集更新策略网络和价值网络的权重参数包括:

39、状态转移数据集记为<x(t),x(t+1),a(t),ri(t),>,其中:

40、x(t)=o1(t),o2(t),…,on(t)

41、x(t+1)=o1(t+1),o2(t+1),…,on(t+1)

42、a(t)=a1(t),a2(t),…,an(t)

43、通过状态转移数据集,以最小化价值网络的损失值为目标,更新价值网络的权重参数;

44、通过状态转移数据集,以最大化价值网络的q值为目标,通过梯度下降调整策略网络的权重参数;

45、所述价值网络的损失值为:

46、

47、

48、式中,eu(d)为期望奖励值,为策略网络输出的q值,γ为折扣因子;

49、所述梯度下降为:

50、

51、可选的,所述观测状态oi(t)为:

52、oi(t)=[pi(t),pt(t),mi(t),bi(t)]

53、式中,pi(t)、pt(t)为巡飞弹i在仿真步数t的自身位置状态和打击目标位置状态,mi(t)为巡飞弹i在仿真步数t获取的其他巡飞弹的通信信息,bi(t)为巡飞弹i在仿真步数t的全局通信预算;若bi(t)≠0,则巡飞弹i发送的通信信息为自身位置状态,若bi(t)=0,则巡飞弹i发送的通信信息为空消息;

54、所述动作策略ai(t)为:

55、ai(t)=[ui(t),ωi(t)]t

56、式中,ui(t)、ωi(t)为巡飞弹i在仿真步数t的前向加速度和转向加速度。

57、第二方面,本发明提供了一种巡飞弹的饱和攻击装置,包括处理器及存储介质;

58、所述存储介质用于存储指令;

59、所述处理器用于根据所述指令进行操作以执行根据上述方法的步骤。

60、第三方面,本发明提供了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现上述方法的步骤。

61、与现有技术相比,本发明所达到的有益效果:

62、本发明提供的一种巡飞弹的饱和攻击方法、装置及存储介质,通过制定巡飞弹群在训练场景中的饱和攻击训练任务以及奖励函数对攻击策略模型进行训练,在机间避碰、避开nfzs和同时打击几个指标上的有着较好表现,同时够在少量通信的条件下有效地执行自杀式饱和攻击任务。

- 还没有人留言评论。精彩留言会获得点赞!